Infrared and Visible Image Fusion Based on Deep Decomposition Network and Saliency Analysis

(基于深度分解网络和显著性分析的红外与可见光图像融合)

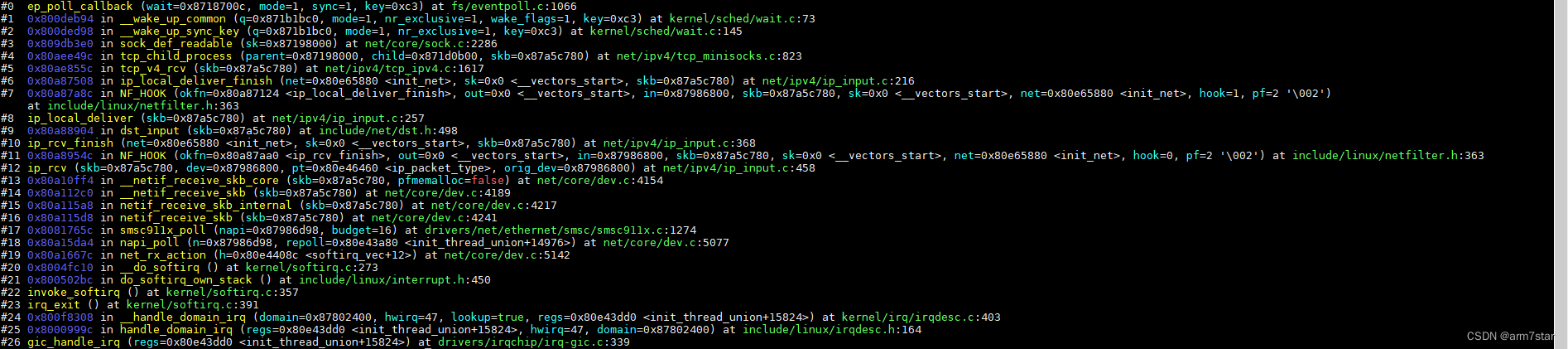

传统的图像融合侧重于选择一种有效的分解方法从源图像中提取代表性特征,并试图找到合适的融合规则来分别合并提取的特征。但是,现有的图像分解工具大多基于内核或全局能量优化功能,从而限制了广泛的图像内容的性能。本文提出了一种基于深度分解网络和显著性分析的红外和可见光图像融合方法 (DDNSA)。首先,使用公开可用的数据集对调整后的残差密集网络 (MRDN) 进行训练,以学习分解过程。其次,通过训练好的分解网络将源图像的结构和纹理特征分离。然后,根据上述特征的特点,利用堆叠稀疏自编码器和视觉显著性机制对结构特征进行融合,构造了局部和全局显著性映射的组合。此外,我们提出了一种用于合并纹理特征的双向边缘强度融合策略。最后,通过结合融合的结构和纹理特征来重建所得图像。

介绍

基于显著性 (SA) 的方法通过提取源图像的重要区域或构建融合权重图来解决融合问题,从而增强融合结果的视觉性能。一些显著性目标检测方法也可以应用于图像融合任务。

(对于一些融合方法介绍:略)

总之,本文提出了一种基于深度分解网络和显著性分析的红外与可见光图像融合方法 (DDNSA)。该方法结合了基于DL的分解方法和传统融合策略的优点。首先,我们修改现有的残差密集网络以构建深度分解网络 (称为MRDN) 方法,该方法使用可用的基准数据集进行训练。然后,与提取一系列卷积特征的端到端融合模型不同,我们使用MRDN仅提取源图像的结构特征和纹理特征。在提取特征的特点下,我们仍然设计 两种不同的融合策略。为了融合结构特征,我们将视觉显著性机制 (VSM) 生成的全局显著性图与堆叠稀疏自动编码器 (SSAE) 生成的局部显著性图集成在一起。此外,我们提出了一个双向边缘强度来融合纹理特征。最后,将两种类型的融合特征求和以重建融合结果。

贡献

1)我们介绍了在红外和可见光图像融合任务中使用深度分解网络自适应提取源图像的特征。通过这样做,我们的网络可以在各种图像内容上表现良好,而无需在特征提取中进行参数设置。

2)通过结合全局和局部显着性图,我们设计了用于融合结构特征的融合权重图。该操作可以有效地增强融合结果的结构信息。

3)我们提出了一种双向边缘强度策略来融合纹理特征。这种融合策略使用图像的特征值来构建权重图,可以保留源图像的高频信息。

4)在红外和可见光图像融合任务中,结合了基于DL的分解和传统融合策略的优点。它可以克服仅使用端到端融合模型产生的缺失细节,并提高融合精度。

方法

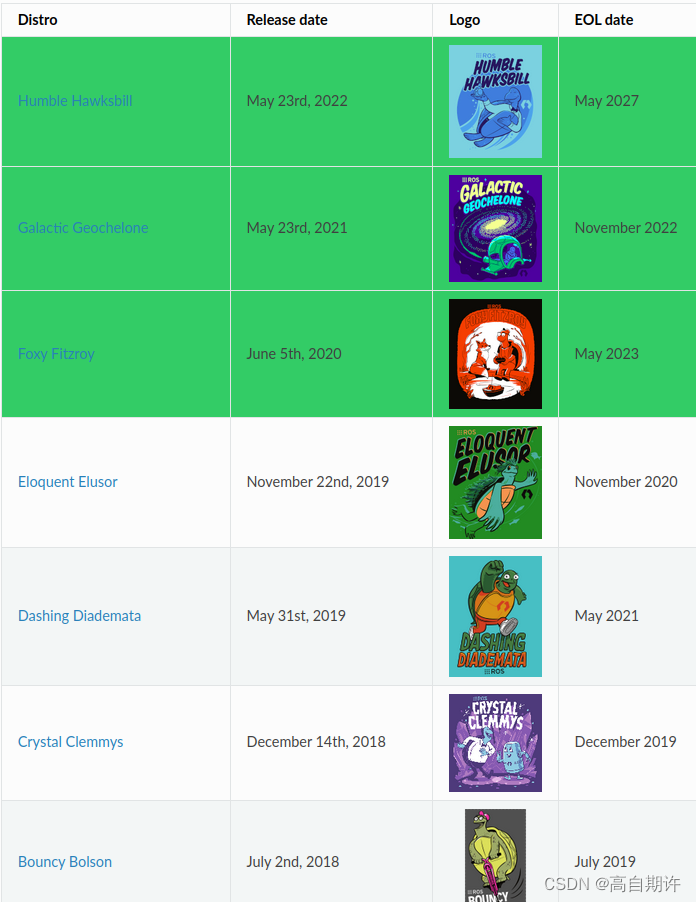

融合框架图:

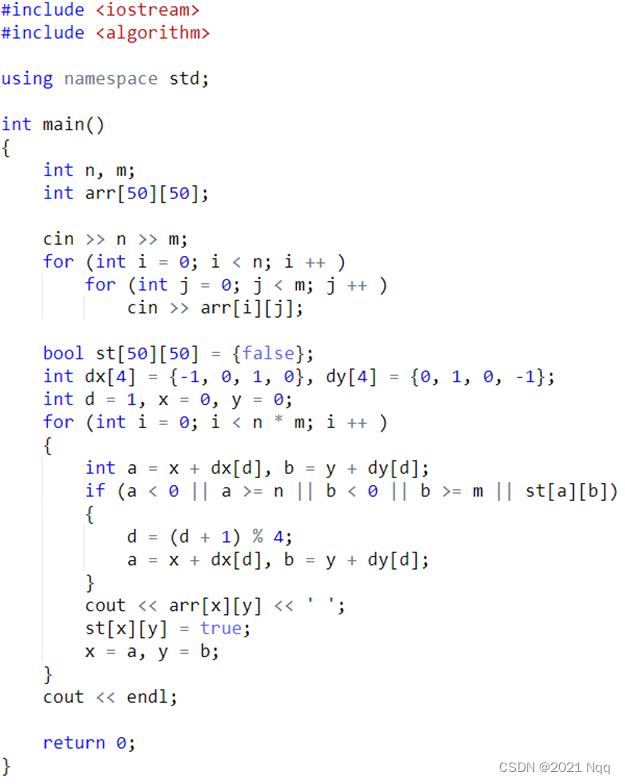

Modified Residual Dense Network-based Feature Extraction

最近,大多数图像分解工具都基于固定核函数或全局优化函数,例如引导滤波器和L0平滑滤波器,它们在某些场合表现出了不错的性能。然而,在图像融合任务中,传统的分解工具无法通过使用固定参数设置来平滑内容广泛的图像,即结构特征和纹理特征在不同类型的图像中很难区分。此外,使用自由参数来实现分解还不够灵活,无法控制图像的平滑度。所有这些缺点都会导致进一步融合的性能不佳。因此,我们提出了一种基于深度学习的分解模型,以满足不同图像内容的过滤。Lu等人引入的滤波网络通过整合自然纹理数据集和仅结构图像来手动合成训练数据,无法真实反映自然图像的属性。

在基于深度学习的边缘保留滤波器的激励下,我们修改了现有的残差密集网络,以形成用于提取图像主要结构的深度分解网络。众所周知,在自然图像中,结构特征反映了平坦的变化区域,而纹理特征指示了频繁的变化模式。为了获得具有相同输入分辨率的结构特征,我们删除了残差密集网络中的上采样操作。

如图2所示,修改后的残差密集网络 (MRDN) 由浅卷积层,残差密集块 (RDBs) 和密集特征融合组成。前两层旨在提取输入数据的浅层特征。第一层生成的特征被馈送到全局残差学习,这有助于优化网络以保留源图像的主要结构特征。同时,将第二层生成的特征传递给两个RDBs进行局部残差学习,提高了MRDN的代表能力。在对两个RDBs的输出特征进行串联 (即全局特征融合) 之后,应用1 × 1卷积内核来保留累积的特征。然后,使用3 × 3卷积内核进一步提取用于全局残差学习的特征。每个RDB具有三个卷积层,其滤波器尺寸为3 × 3,后跟一个RuLU函数。与全局特征融合和全局残差学习类似,特征级联层和1 × 1卷积核分别用于局部特征融合和局部残差学习。

我们使用训练好的MRDN提取源图像的结构特征,然后纹理特征是结构特征与源图像之间的差异。图3显示了源红外和可见图像的分解结果。

可以看出,源图像的主要结构特征得到了很好的保留。此外,还可以很好地提取源图像的纹理特征。在我们的工作中,我们将结构特征和纹理特征分别表示为S1,S2和T1,T2。

Fusion Weight Map Constructions

根据提取的特征,我们通过显著性分析构建了两种不同的融合策略。由于结构特征包含图像的显着能量和亮度信息,因此人眼对图像亮度的变化更加敏感。因此,我们结合全局和局部视觉显着性策略来融合结构特征。同时,图像的纹理特征指示高频细节信息。我们采用基于双向边缘强度的融合策略。

1) Combination of Global and Local Saliency Fusion Technique:

VSM-based global saliency map:

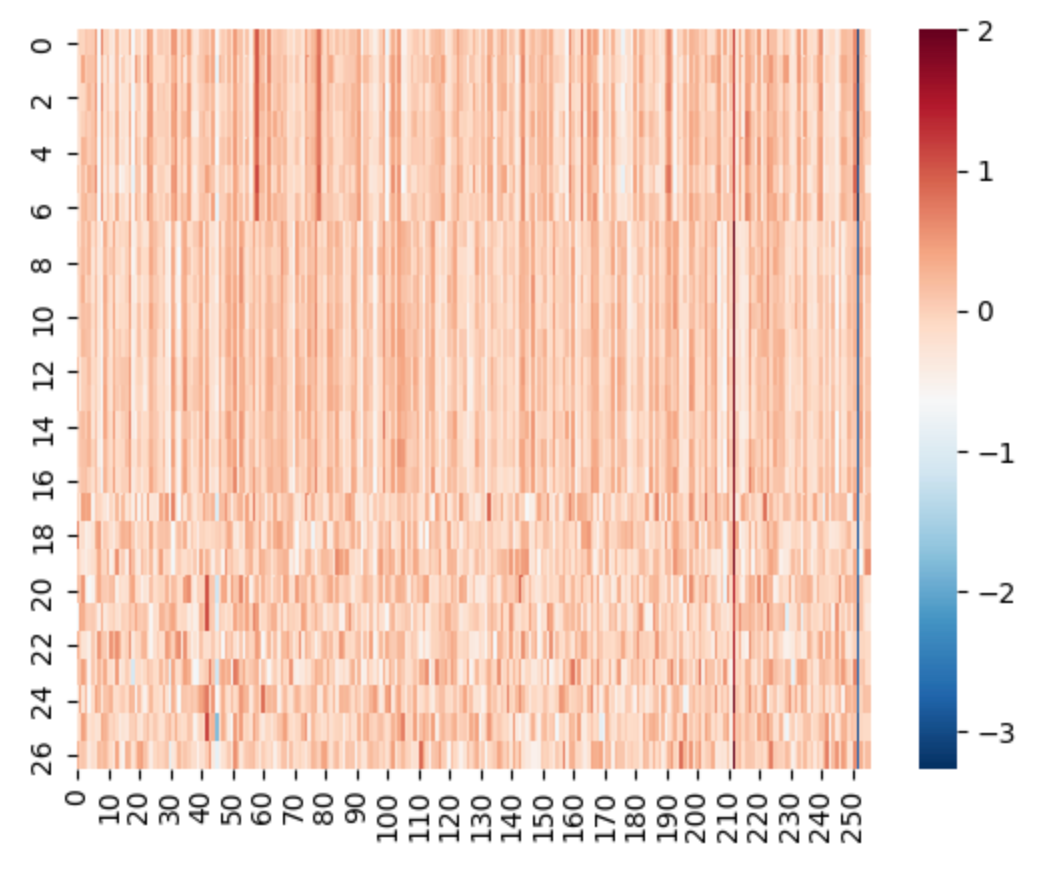

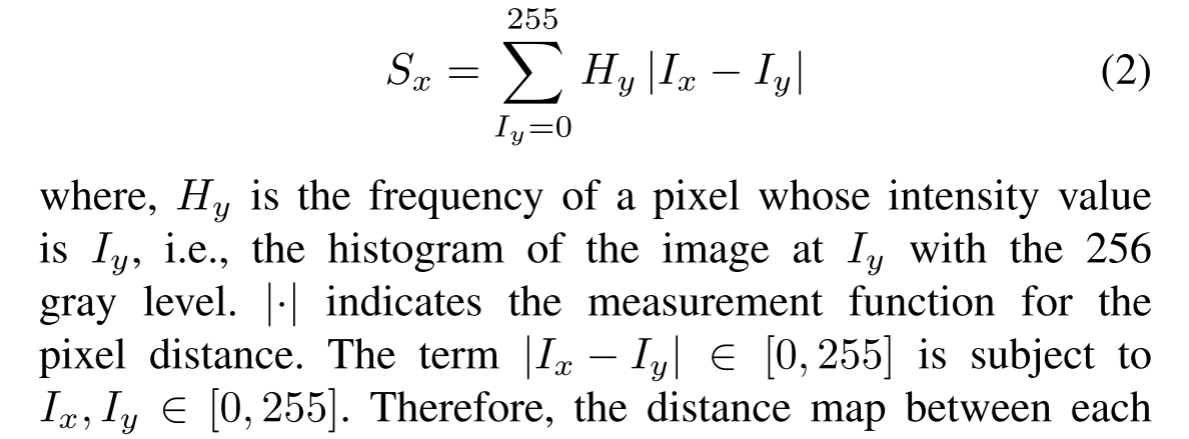

视觉显著性图中的每个元素反映图像中每个像素值的全局能量信息。在我们的研究中,首先计算一个像素的强度值与所有剩余像素之间的绝对差异。然后,将差异求和以用作图像像素的全局显着值。让我们将Ix定义为灰度图像I中像素x的强度值。然后,x的像素显著性可以如下计算:

其中,Sx为显著性值。N是图像中的像素总数。为了计算方便,可以将上述等式转换为基于直方图的形式,将其重写如下:

因此,每个像素与其他像素之间的距离图在图像中是固定的。给定频率直方图和像素之间的距离图,很容易计算每个像素的全局视觉显着性。因此,我们可以获得源图像的全局显着性图 (Sg1和Sg2)。

SSAE-based local saliency map:

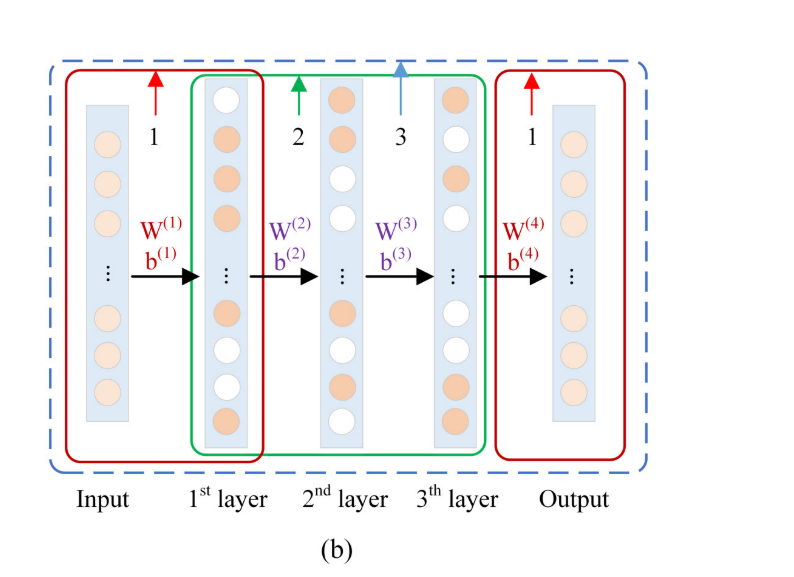

图像的结构特征包含大尺度的梯度信息,仅使用全局视觉显著性无法很好地反映。因此,为了在融合结果中保留局部结构特征,我们使用堆叠稀疏自动编码器 (SSAE) 构造了一个低级局部显着性图,称为结构特征上的激活特征。如图4(a) 所示,基本SAE由编码器和解码器部分组成。通过以无监督的方式最小化输入数据和输出数据之间的误差,它具有良好的表示性能。

为简单起见,我们仅显示由两个SAE堆叠的SSAE,其具有三个隐藏层 (参见图4(b))。受已有文献的启发,SSAE的第一个隐藏层可以学习与Gabor滤波器相似的参数 (即编码参数)。期望编码参数反映源图像的结构显着性信息。此属性使SSAE通过显着性分析可用于图像融合,以形成融合权重图。训练过程可以表示为 “1-2-3”。首先,采用逐层贪婪的方法来训练每个SAE。然后,所有独立的SAE将被堆叠成一个完整的网络,以便再次进行微调。

图5示出了通过使用SSAE进行的活动水平测量的示例。图像的每个像素在邻域补丁 (r × r) 中具有唯一的活动值。为了获得与源图像大小相同的局部显着性图,我们通过镜像反射方法扩展了图像的边界。因此,可以通过像素扫描对大小为M × N的源图像进行MN块采样。这些斑块被排列成大小为r^2 × MN的新矩阵X。

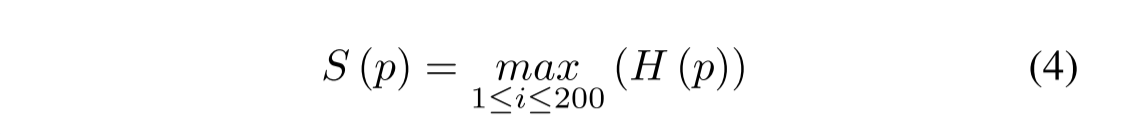

Fan等人发现,最大值可以在局部补丁中显示出更锐化的边缘。因此,我们选择激活的最大值来表示输入数据。激活的方程式定义如下:

其中,S § 是表示输入数据p的活动值Eq(3) 和Eq(4),我们可以获得矩阵X的MN活度值,该值被重新整形为源图像的局部显着性图。在我们的研究中,第一层的编码参数用于生成两个称为Sl1和sl2的局部显着性图。

A Combination of VSM and SSAE:

为了使生成的显著性图满足融合权值的要求,我们最初将所有显著性图归一化如下:

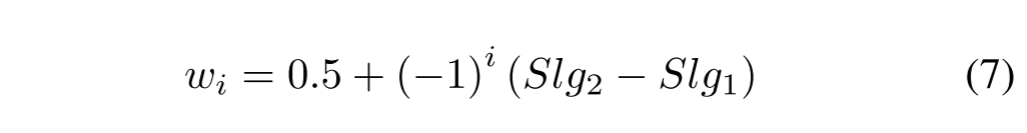

其中Smax和Smin表示输入显著性图S的最大值和最小值。然后,使用求和方式将全局显著性图Sgi和局部显著性图Sli (i = 1用于红外图像,而i = 2用于可见图像) 组合以产生最终显着性图,如下所示:

最后,将最终的显著性图重新归一化为 [0,1],其中计算差值以获得相应结构特征的融合图如下:

因此,最终的融合结构特征计算如下:

2) Bi-direction Edge-strength based Fusion Technique:

对于纹理特征,在我们的工作中,我们使用统计理论提出了一种基于双向边缘强度的融合技术。在大小为m × m的方形窗口中,我们根据行和列边缘的强度自适应地构建纹理特征之间的融合权重图。根据图像统计的规律,该窗口的中心像素与其他像素具有密切的关系。

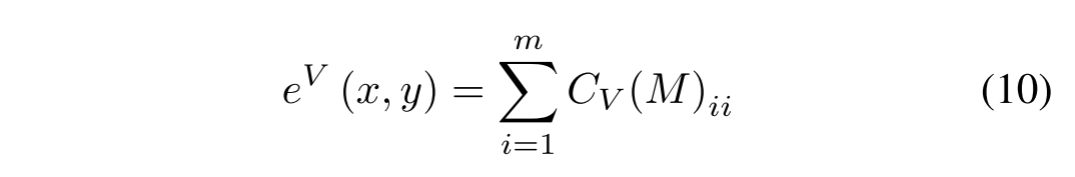

假设,中心像素标记为s (x,y)。然后下一步是通过使用Eq (9) 固定行以获得垂直方向 (列向量) 的协方差矩阵CV (M):

是M在垂直方向上的平均值。随后,我们使用以下公式计算协方差矩阵CV (M) 的迹:

同样,我们可以在水平方向上具有边缘强度eH (x,y)。因此,具有两个方向的总边缘强度可以计算为Eq (11):

根据Eq (10-11),纹理特征的权重图构造可以表示为e1和e2。因此,纹理特征的融合可以计算如下:

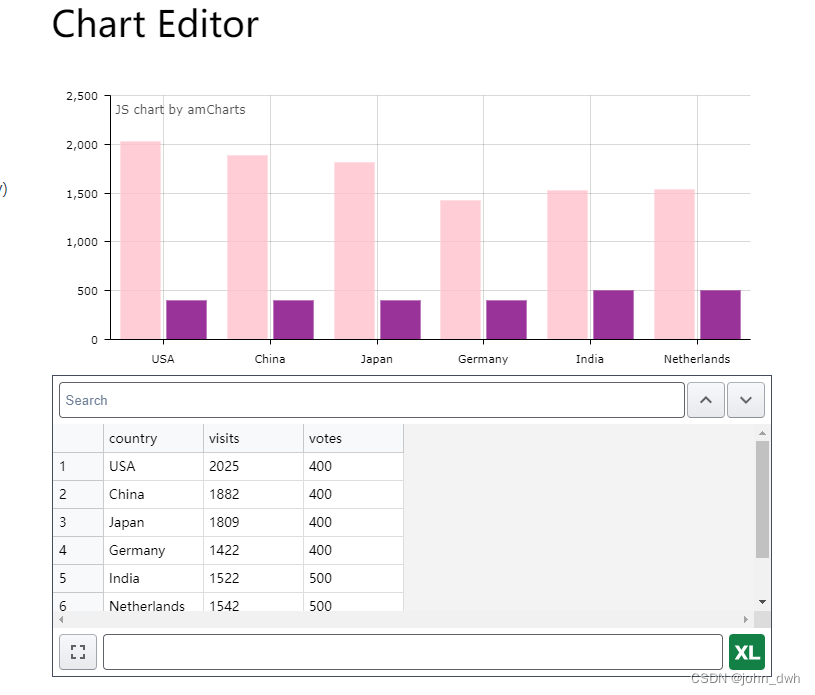

Image Reconstruction

通过上述步骤,图1描绘了将所有融合的结构特征和融合的纹理特征集成到一个新图像中的结果。因此,可以如下获得融合图像: