Glustefs 服务端配置流程

(一)环境搭建

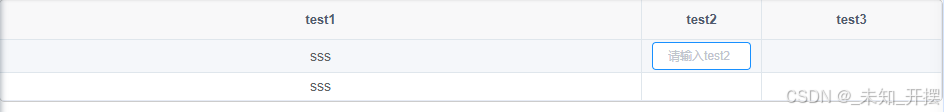

| 名称 | ip | 硬件 | 设备文件 |

|---|---|---|---|

| 虚拟机 gluster1 | 192.168.101.1 | 2G新磁盘 | /dev/sdb |

| 虚拟机 gluster2 | 192.168.101.2 | 2G新磁盘 | /dev/sdb |

| 虚拟机 gluster3 | 192.168.101.3 | 2G新磁盘 | /dev/sdb |

(二)磁盘格式化(依次在三台虚拟机上进行)

进行分区和格式化

fdisk /dev/sdb

输入 n 并回车,表示创建一个新分区。

输入分区类型(主分区或扩展分区)。通常输入 p 并回车。

输入分区号,例如 1,表示第一个分区。

输入起始扇区,通常可以使用默认值(直接按回车)。

输入分区的大小,如 +2G 表示2GB,也可以默认将剩余空间全部分配给该分区。

输入w表示保存退出

格式化分区mkfs.xfs /dev/sdb1

(三)挂载磁盘(依次在三台虚拟机上进行)

创建挂载点 /exp/vdb1 mkdir -p /exp/vdb1

配置挂载信息 vim /etc/fstab,插入如下信息

# /etc/fstab

.......

# 插入如下信息

/dev/sdb1 /exp/vdb1 xfs defaults 0 0

........

生效挂载配置 mount -a

查看挂载结果 df -h

文件系统 容量 已用 可用 已用% 挂载点

...

/dev/sdb1 2.0G 47M 2.0G 3% /exp/vdb1

...

(四)安装glusterfs服务端(依次在三台虚拟机上进行)

yum install glusterfs-server

(五) gluster server 配置(在任意一台主机上进行)

存储池

-

添加(可将ip加入host文件或者dns中实现动态化)

gluster peer probe 192.168.101.1

gluster peer probe 192.168.101.2

gluster peer probe 192.168.101.3

注意以下几点:1. 自我探测(即尝试将当前节点添加为自己的同行)会导致错误, 因为当前节点默认已经是可信存储池的一部分。 2. 在添加服务器到可信存储池之前,确保存储服务器上已经运行了glusterd服务。 3. 如果在添加过程中遇到问题,可以检查防火墙设置、网络连通性以及DNS解析是否正确等。 -

查看存储池

gluster pool list

创建卷

以3副本复制卷data_test为例

gluster volume create data_test replica 3 192.168.101.1:/exp/vdb1/brick 192.168.101.2:/exp/vdb1/brick 192.168.101.3:/exp/vdb1/brick

命令的组成:

gluster volume create:这是创建新卷的命令

data_test:要创建的卷的名称

replica 3:指定卷的类型为3副本复制卷

192.168.101.1:/exp/vdb1/brick:这是第一个服务器的IP地址和brick的路径。

192.168.101.2:/exp/vdb1/brick:这是第二个。

192.168.101.3:/exp/vdb1/brick:这是第三个。

启动和查看存储卷

gluster volume start data_test

gluster volume info

Volume Name: data_test

Type: Replicate

Volume ID: xxxxxxxxxxxxxxxxxxxxx

Status: Started

Snapshot Count: 0

Number of Bricks: 1 x 3 = 3

Transport-type: tcp

Bricks:

Brick1: 192.168.101.xx:/exp/vdb1/xx

Brick2: 192.168.101.xx:/exp/vdb1/xx

Brick3: 192.168.101.xx:/exp/vdb1/xx

Options Reconfigured:

cluster.granular-entry-heal: on

storage.fips-mode-rchecksum: on

transport.address-family: inet

nfs.disable: on

performance.client-io-threads: off

小结

至此,服务端的配置已经完成,客户端根据业务的实际情况来对创建的分布式卷进行挂载