Supervised Fine-Tuning(监督式微调) 是机器学习和深度学习领域中的一个重要概念,尤其是在自然语言处理(NLP)和计算机视觉等领域中被广泛使用。以下是对这个概念的详细介绍:

什么是 Supervised Fine-Tuning?

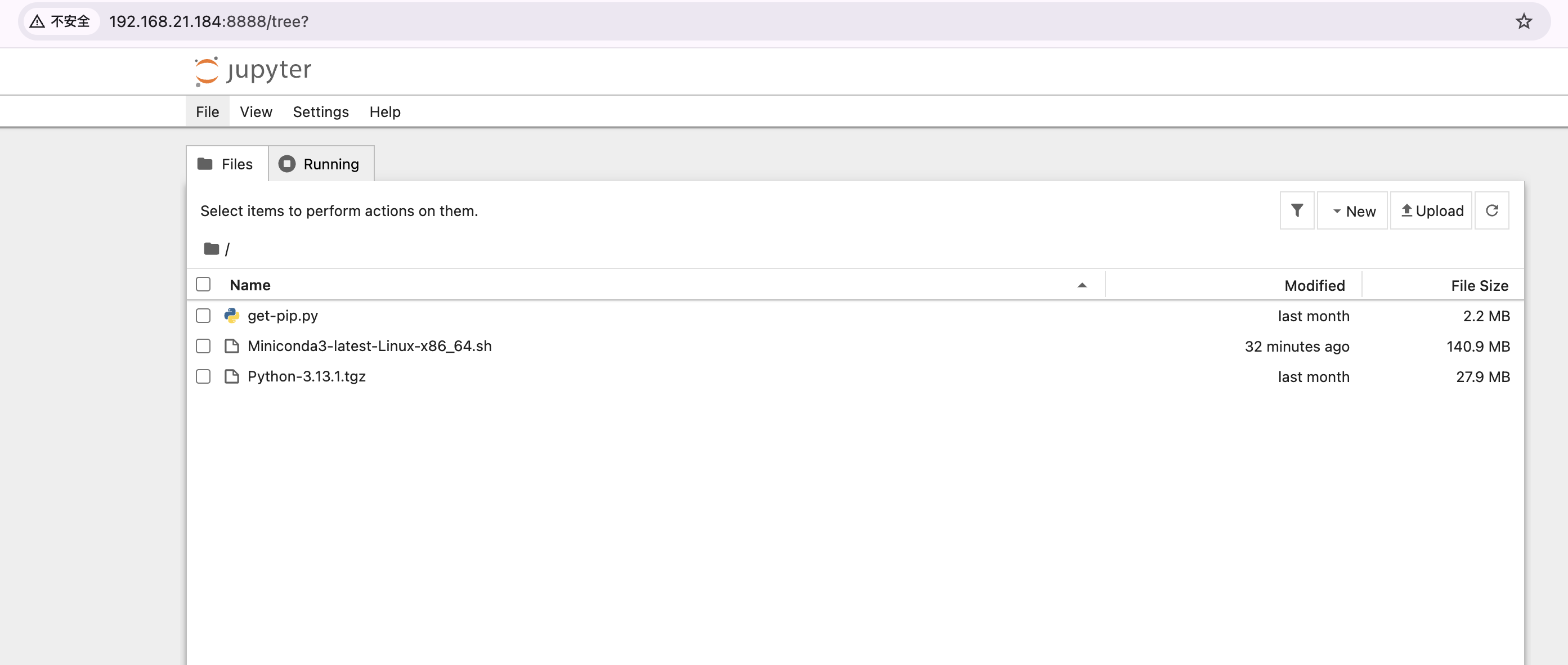

Supervised Fine-Tuning 是指在有监督学习框架下,通过给模型提供标注过的数据(labelled data),对一个已经预训练的模型(pre-trained model)进行进一步的调整和优化。

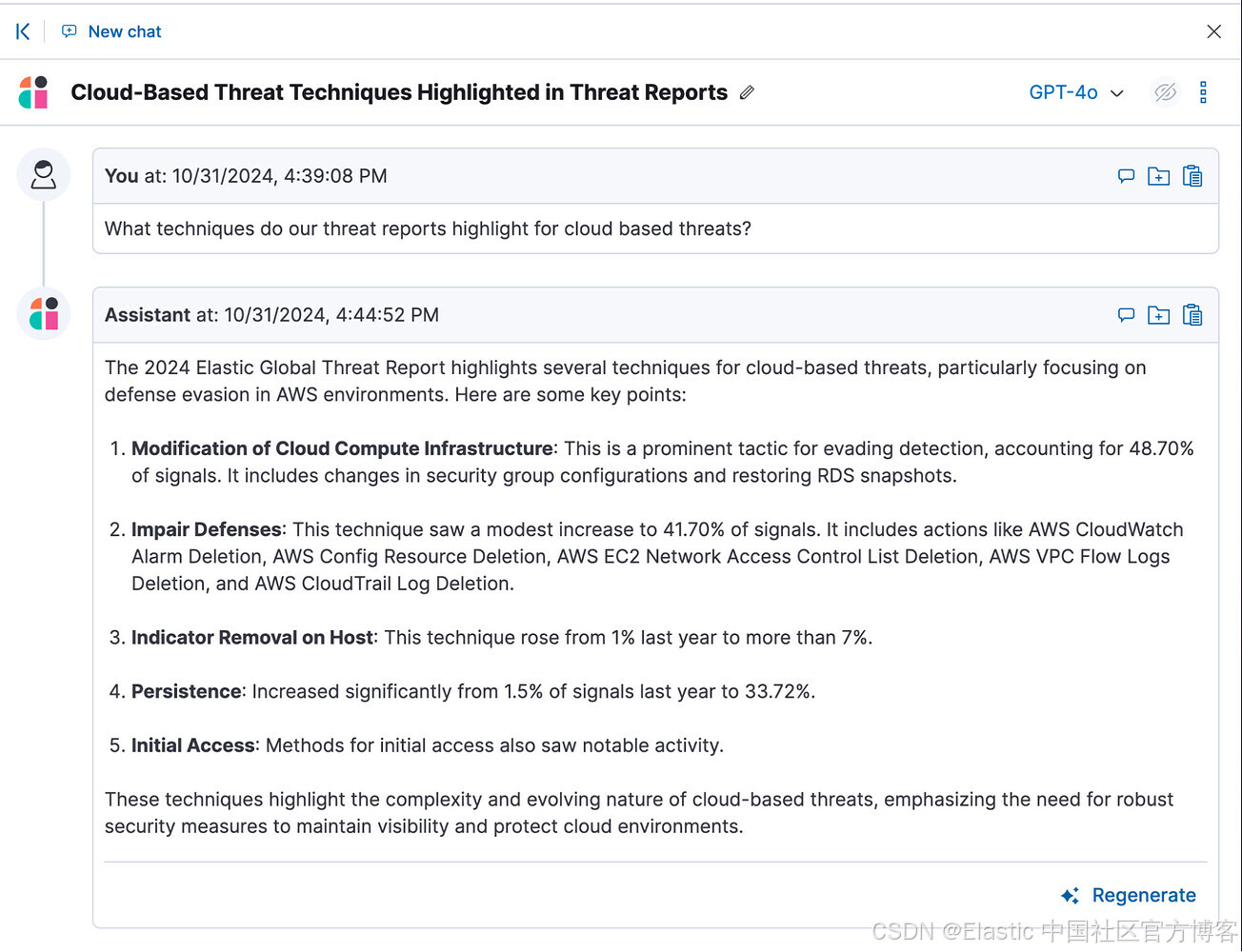

这种方法通常用于将一个通用模型(general model)适配到特定任务或领域中,例如从自然语言生成模型(如 GPT)调整到具体的情感分析或客户支持对话生成。

Supervised Fine-Tuning 的工作原理

-

预训练(Pre-training):

- 模型在大规模无标注数据(unlabelled data)上进行训练,学习通用的特征表示(如词向量、图像特征等)。

- 例如,GPT-3 在海量文本数据上预训练,学会了语言的基本语法、语义等规律。

-

监督式微调(Fine-Tuning):

- 在特定任务的数据集上,使用监督学习方法对模型进行调整。

- 数据集中每个样本都包含输入和期望的输出(即标注数据,例如句子的情感标签、图像的分类标签等)。

- 模型根据这些标注数据学习任务相关的特定特征,从而实现定制化。

优点

-

快速适配特定任务:

由于模型已经通过预训练掌握了通用的特征,微调过程所需的数据和时间显著减少。 -

高性能:

预训练模型已经积累了丰富的特征表示,监督微调可以在少量标注数据上达到较高的性能。 -

减少计算成本:

与从零开始训练模型相比,微调只需针对特定任务进行小规模调整,计算成本较低。

应用场景

-

自然语言处理(NLP):

- 机器翻译:对预训练语言模型微调以适应特定语言对的翻译任务。

- 情感分析:从预训练模型调整为情感分类任务。

- 聊天机器人:微调模型以生成特定领域的对话。

-

计算机视觉:

- 图像分类:从预训练的 ResNet、VGG 等模型微调,适应特定的图像分类任务。

- 目标检测:使用 COCO 数据集预训练模型,微调到特定领域目标检测任务。

-

语音处理:

- 语音识别:将预训练模型调整到特定语言或方言的识别任务。

示例

以 GPT 模型为例:

- 预训练阶段: GPT-3 使用海量的通用文本数据进行无监督训练。

- 监督微调阶段: 使用标注数据集对模型进行调整,比如使用客户支持对话数据微调 GPT,使其能够生成特定行业的客户服务对话。

注意事项

- 数据质量: 微调的效果很大程度上取决于标注数据的质量。如果标注数据有噪声,模型的性能可能会下降。

- 过拟合风险: 如果微调数据集过小,模型可能会过拟合到这些特定数据。

- 平衡通用性与专用性: 微调时需要防止模型丢失预训练阶段学到的通用知识(即灾难性遗忘)。

总结:

监督式微调(Supervised Fine-Tuning)是将预训练模型进一步调整为特定任务的关键步骤,能够显著提升模型的适应性和性能,在实际应用中具有广泛的价值。