文章目录

-

- 上下文学习的形式化定义

- 示例设计

- 底层机制

在GPT-3的论文中,OpenAI研究团队首次提出上下文学习(In-context learning,ICL)这种特殊的提示形式。目前,上下文学习已经成为使用大语言模型解决下游任务的一种主流途径。

上下文学习的形式化定义

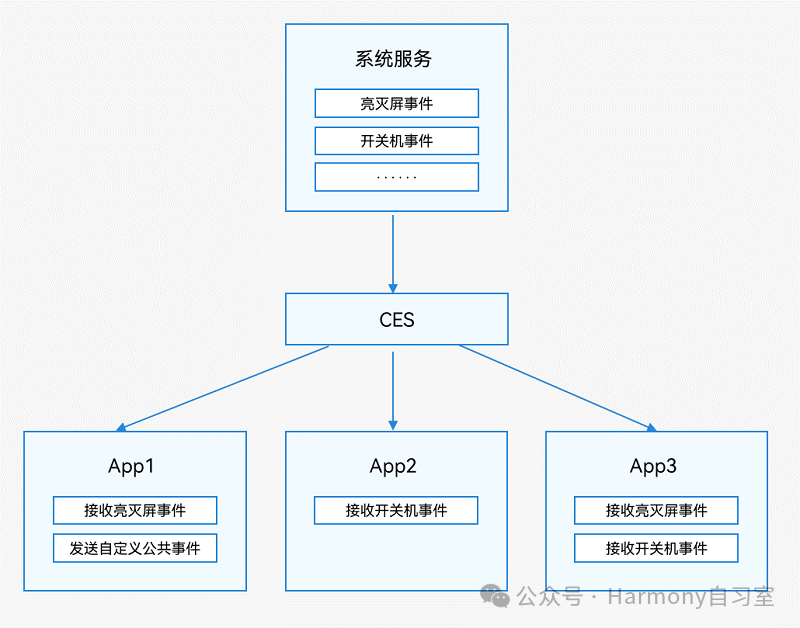

根据GPT-3论文中所给出的描述,上下文学习使用由任务描述和(或)示例所组成的自然语言文本作为提示。下图展示了上下文学习的提示构建过程。首先,通过自然语言描述任务,并从任务数据集中选择一些样本作为示例。其次,根据特定的模板,将这些示例按照特定顺序组合成提示内容。最后,将测试样本添加到提示后面,整体输入到大语言模型以生成输出。基于任务描述以及示例信息,大语言模型无需显式的梯度更新即可识别和执行新的任务。形式上,我们使用𝐷𝑘={𝑓(𝑥1,𝑦1),…, 𝑓(𝑥𝑘,𝑦𝑘)}来表示由𝑘个样本构成的一组示例数据,其中𝑓(𝑥𝑘,𝑦𝑘)是一个函数,负责将第𝑘个任务样本转换为自然语言提示。给定任务描述𝐼、示例𝐷𝑘以及新的输入𝑥𝑘+1,大语言

![[大模型]Diffusion扩散式生成模型](https://i-blog.csdnimg.cn/direct/7747c6d712f044b58fc7481a0e6898f0.png)