1. 常见大模型介绍

1.1 ChatGLM-6B 系列

-

ChatGLM2-6B

-

[【ChatGLM2-6B 入门】清华大学开源中文版 ChatGLM-6B 模型学习与实战]

-

更强大的性能:基于 ChatGLM 初代模型的开发经验,我们全面升级了 ChatGLM2-6B 的基座模型。ChatGLM2-6B 使用了 GLM 的混合目标函数,经过了 1.4T 中英标识符的预训练与人类偏好对齐训练,评测结果显示,相比于初代模型,ChatGLM2-6B 在 MMLU(+23%)、CEval(+33%)、GSM8K(+571%) 、BBH(+60%)等数据集上的性能取得了大幅度的提升,在同尺寸开源模型中具有较强的竞争力。

-

更长的上下文:基于 FlashAttention 技术,我们将基座模型的上下文长度(Context Length)由 ChatGLM-6B 的 2K 扩展到了 32K,并在对话阶段使用 8K 的上下文长度训练,允许更多轮次的对话。但当前版本的 ChatGLM2-6B 对单轮超长文档的理解能力有限,我们会在后续迭代升级中着重进行优化。

-

更高效的推理:基于 Multi-Query Attention 技术,ChatGLM2-6B 有更高效的推理速度和更低的显存占用:在官方的模型实现下,推理速度相比初代提升了 42%,INT4 量化下,6G 显存支持的对话长度由 1K 提升到了 8K。

-

更开放的协议:ChatGLM2-6B 权重对学术研究完全开放,在获得官方的书面许可后,亦允许商业使用。如果您发现我们的开源模型对您的业务有用,我们欢迎您对下一代模型 ChatGLM3 研发的捐赠。

-

论文名称:ChatGLM2-6B: An Open Bilingual Chat LLM | 开源双语对话语言模型

-

论文地址:

-

Github 代码:https://github.com/THUDM/ChatGLM2-6B

-

动机:在主要评估 LLM 模型中文能力的 C-Eval 榜单中,截至 6 月 25 日 ChatGLM2 模型以 71.1 的分数位居 Rank 0 ,ChatGLM2-6B 模型以 51.7 的分数位居 Rank 6,是榜单上排名最高的开源模型。

-

介绍:ChatGLM2-6B 是开源中英双语对话模型 ChatGLM-6B 的第二代版本,在保留了初代模型对话流畅、部署门槛较低等众多优秀特性的基础之上,ChatGLM2-6B 引入了如下新特性:

-

[【关于 ChatGLM2 + LoRA 进行 finetune 】

-

论文名称:ChatGLM2-6B: An Open Bilingual Chat LLM | 开源双语对话语言模型

-

论文地址:

-

Github 代码:https://github.com/THUDM/ChatGLM2-6B

-

介绍:本教程主要介绍对于 ChatGLM2-6B 模型基于 LoRA 进行 finetune。

-

[【LLMs 入门实战 】基于 🤗PEFT 的高效 🤖ChatGLM2-6B 微调]

-

ChatGLM2-6B Freeze 微调:Fine-tuning the MLPs in the last n blocks of the model.

-

ChatGLM2-6B P-Tuning V2 微调:Fine-tuning the prefix encoder of the model.

-

ChatGLM2-6B LoRA 微调:Fine-tuning the low-rank adapters of the model.

-

微调方式:

-

[【LLMs 入门实战】基于 🤗QLoRA 的高效 🤖ChatGLM2-6B 微调]

-

介绍:本项目使用 https://github.com/huggingface/peft 库,实现了 ChatGLM2-6B 模型 4bit 的 QLoRA 高效微调,可以在一张 RTX3060 上完成全部微调过程。

-

ChatGLM3

-

[【LLMs 入门实战】 ChatGLM3 模型学习与实战]

-

更强大的基础模型: ChatGLM3-6B 的基础模型 ChatGLM3-6B-Base 采用了更多样的训练数据、更充分的训练步数和更合理的训练策略。在语义、数学、推理、代码、知识等不同角度的数据集上测评显示,ChatGLM3-6B-Base 具有在 10B 以下的基础模型中最强的性能。

-

更完整的功能支持: ChatGLM3-6B 采用了全新设计的 Prompt 格式,除正常的多轮对话外。同时原生支持工具调用(Function Call)、代码执行(Code Interpreter)和 Agent 任务等复杂场景。

-

更全面的开源序列: 除了对话模型 ChatGLM3-6B 外,还开源了基础模型 ChatGLM3-6B-Base、长文本对话模型 ChatGLM3-6B-32K。以上所有权重对学术研究完全开放,在填写问卷进行登记后亦允许免费商业使用。

-

huggingface:https://huggingface.co/THUDM/chatglm3-6b

-

modelscope:https://modelscope.cn/models/ZhipuAI/chatglm3-6b/summary

-

论文名称:ChatGLM3

-

Github 代码:https://github.com/THUDM/ChatGLM3

-

模型地址:

-

动机:2023 年 10 月 26 日,由中国计算机学会主办的 2023 中国计算机大会(CNCC)正式开幕,据了解,智谱 AI 于 27 日论坛上推出了全自研的第三代基座大模型 ChatGLM3 及相关系列产品,这也是智谱 AI 继推出千亿基座的对话模型 ChatGLM 和 ChatGLM2 之后的又一次重大突破。

-

介绍:ChatGLM3 是智谱 AI 和清华大学 KEG 实验室联合发布的新一代对话预训练模型。ChatGLM3-6B 是 ChatGLM3 系列中的开源模型,在保留了前两代模型对话流畅、部署门槛低等众多优秀特性的基础上,ChatGLM3-6B 引入了如下特性:

-

[【LLMs 入门实战】 ChatGLM3 模型微调学习与实战]

-

huggingface:https://huggingface.co/THUDM/chatglm3-6b

-

modelscope:https://modelscope.cn/models/ZhipuAI/chatglm3-6b/summary

-

论文名称:ChatGLM3

-

Github 代码:https://github.com/THUDM/ChatGLM3

-

模型地址:

-

动机:2023 年 10 月 26 日,由中国计算机学会主办的 2023 中国计算机大会(CNCC)正式开幕,据了解,智谱 AI 于 27 日论坛上推出了全自研的第三代基座大模型 ChatGLM3 及相关系列产品,这也是智谱 AI 继推出千亿基座的对话模型 ChatGLM 和 ChatGLM2 之后的又一次重大突破。

-

介绍:分别对 ChatGLM3 进行 lora 和 full_training 微调

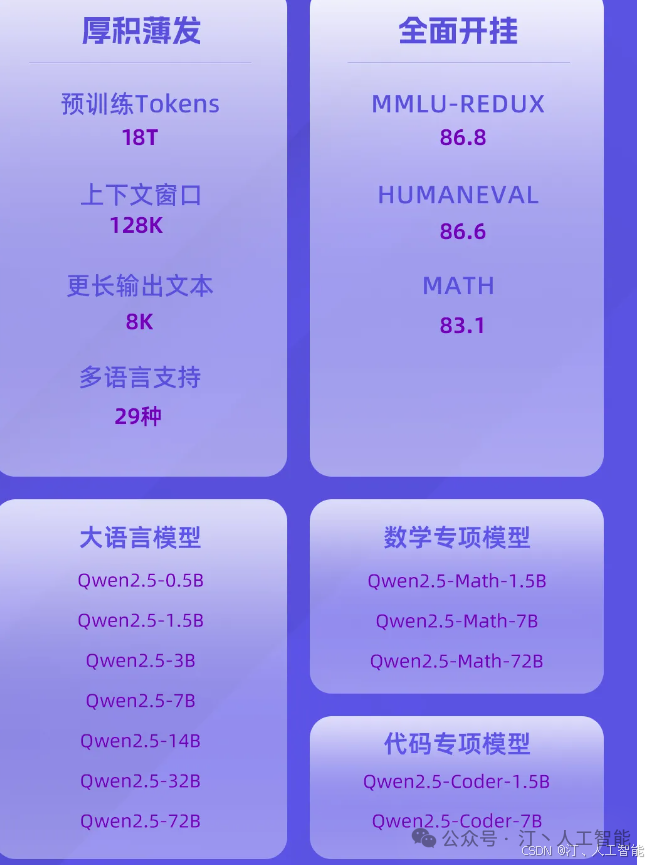

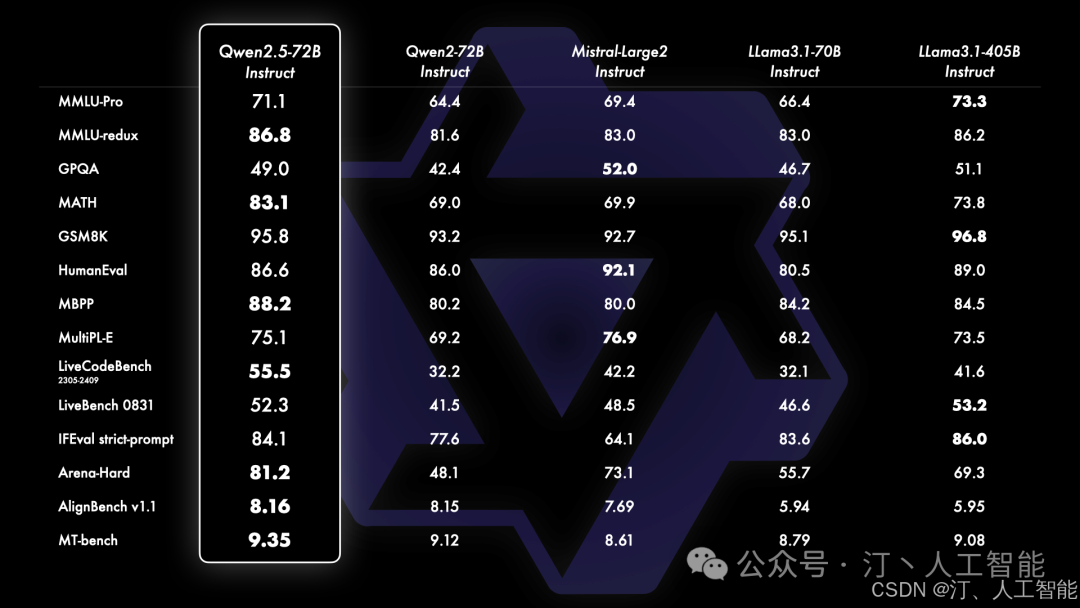

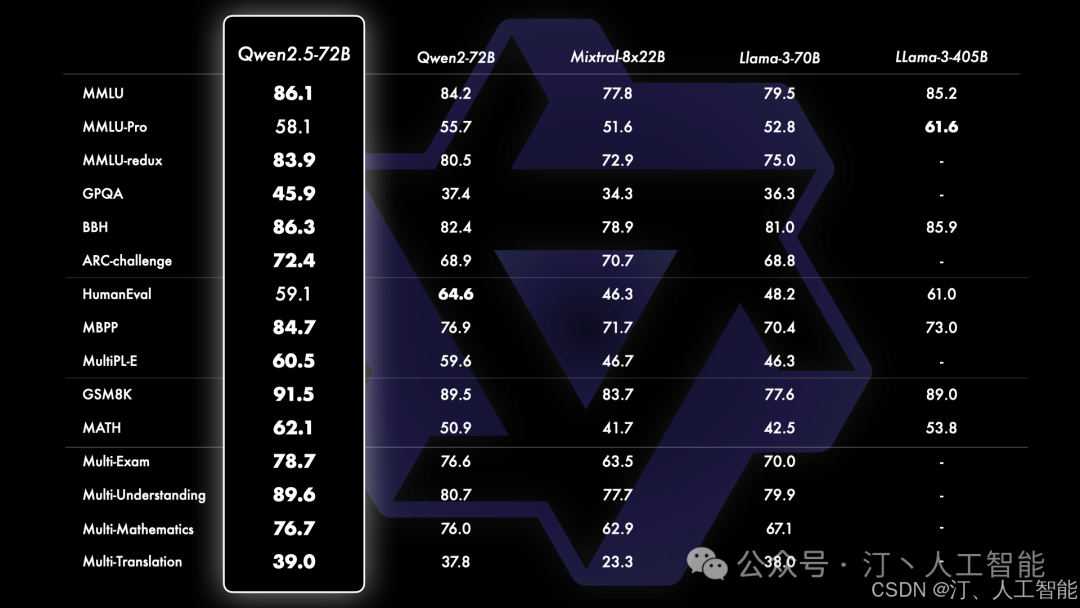

1.2 qwen2.5

网址:github.com/QwenLM/Qwen2.5

Qwen 是阿里巴巴集团 Qwen 团队研发的大语言模型和大型多模态模型系列。目前,大语言模型已升级至 Qwen2.5 版本。无论是语言模型还是多模态模型,均在大规模多语言和多模态数据上进行预训练,并通过高质量数据进行后期微调以贴近人类偏好。Qwen 具备自然语言理解、文本生成、视觉理解、音频理解、工具使用、角色扮演、作为 AI Agent 进行互动等多种能力。

最新版本 Qwen2.5 有以下特点:

-

易于使用的仅解码器稠密语言模型,提供 0.5B 、1.5B 、3B 、7B 、14B 、32B 和 72B 共 7 种参数规模的模型,并且有基模型和指令微调模型两种变体(其中 “B” 表示“十亿”, 72B 即为 720 亿)

-

利用我们最新的数据集进行预训练,包含多达 18T tokens (其中 “T” 表示“万亿”, 18T 即为 18 万亿)

-

在遵循指令、生成长文本(超过 8K tokens )、理解结构化数据(例如,表格)以及生成结构化输出特别是 JSON 方面有了显著改进

-

更加适应多样化的系统提示,增强了角色扮演的实现和聊天机器人的背景设置。

-

支持最多达 128K tokens 的上下文长度,并能生成多达 8K tokens 的文本。

-

支持超过 29 种语言,包括中文、英文、法文、西班牙文、葡萄牙文、德文、意大利文、俄文、日文、韩文、越南文、泰文、阿拉伯文等。

1.3 Baichuan

-

Baichuan2

-

[【LLMs 入门实战】 Baichuan2 学习与实战]

-

Baichuan 2 是百川智能推出的新一代开源大语言模型,采用 2.6 万亿 Tokens 的高质量语料训练。

-

Baichuan 2 在多个权威的中文、英文和多语言的通用、领域 benchmark 上取得同尺寸最佳的效果。

-

本次发布包含有 7B、13B 的 Base 和 Chat 版本,并提供了 Chat 版本的 4bits 量化。

-

所有版本对学术研究完全开放。同时,开发者通过邮件申请并获得官方商用许可后,即可免费商用,请参考协议章节。

-

官方微调过(指令对齐):https://huggingface.co/baichuan-inc/Baichuan-13B-Chat

-

预训练大模型(未经过微调):https://huggingface.co/baichuan-inc/Baichuan-13B-Base

-

论文名称:Baichuan 2: Open Large-scale Language Models

-

Github 代码:https://github.com/baichuan-inc/Baichuan2

-

模型:https://huggingface.co/baichuan-inc

-

Baichuan-13B 大模型:

-

介绍:

-

Baichuan-13B

-

[【LLMs 入门实战 】 Baichuan-13B 模型学习与实战]

-

更大尺寸、更多数据:Baichuan-13B 在 Baichuan-7B 的基础上进一步扩大参数量到 130 亿,并且在高质量的语料上训练了 1.4 万亿 tokens,超过 LLaMA-13B 40%,是当前开源 13B 尺寸下训练数据量最多的模型。支持中英双语,使用 ALiBi 位置编码,上下文窗口长度为 4096。

-

同时开源预训练和对齐模型:预训练模型是适用开发者的 “基座”,而广大普通用户对有对话功能的对齐模型具有更强的需求。因此本次开源同时发布了对齐模型(Baichuan-13B-Chat),具有很强的对话能力,开箱即用,几行代码即可简单的部署。

-

更高效的推理:为了支持更广大用户的使用,本次同时开源了 int8 和 int4 的量化版本,相对非量化版本在几乎没有效果损失的情况下大大降低了部署的机器资源门槛,可以部署在如 Nvidia 3090 这样的消费级显卡上。

-

开源免费可商用:Baichuan-13B 不仅对学术研究完全开放,开发者也仅需邮件申请并获得官方商用许可后,即可以免费商用。

-

官方微调过(指令对齐):https://huggingface.co/baichuan-inc/Baichuan-13B-Chat

-

预训练大模型(未经过微调):https://huggingface.co/baichuan-inc/Baichuan-13B-Base

-

baichuan-inc/Baichuan-13B:https://github.com/baichuan-inc/Baichuan-13B

-

Baichuan-13B 大模型:

-

介绍:Baichuan-13B 是由百川智能继 Baichuan-7B 之后开发的包含 130 亿参数的开源可商用的大规模语言模型,在权威的中文和英文 benchmark 上均取得同尺寸最好的效果。Baichuan-13B 有如下几个特点:

baichuan-7B

-

【LLMs 入门实战 】 baichuan-7B 学习与实战

-

论文名称:

-

论文地址:

-

Github 代码: https://github.com/baichuan-inc/baichuan-7B

-

模型:

-

介绍:由百川智能开发的一个开源可商用的大规模预训练语言模型。基于 Transformer 结构,在大约 1.2 万亿 tokens 上训练的 70 亿参数模型,支持中英双语,上下文窗口长度为 4096。在标准的中文和英文权威 benchmark(C-EVAL/MMLU)上均取得同尺寸最好的效果。

1.4 Llama 3.2

-

[【LLMs 入门实战】 QLoRA 微调 Llama2 模型学习与实战]

-

官网:https://ai.meta.com/llama/

-

论文名称:《Llama 2: Open Foundation and Fine-Tuned Chat Models》

-

论文地址:https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

-

演示平台:https://llama2.ai/

-

Github 代码:https://github.com/facebookresearch/llama

-

模型下载地址:https://ai.meta.com/resources/models-and-libraries/llama-downloads/

-

介绍:QLoRA 微调 Llama2 模型学习与实战

-

[【LLMs 入门实战】 Llama2 模型学习与实战]

-

官网:https://ai.meta.com/llama/

-

论文名称:《Llama 2: Open Foundation and Fine-Tuned Chat Models》

-

论文地址:https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

-

演示平台:https://llama2.ai/

-

Github 代码:https://github.com/facebookresearch/llama

-

模型下载地址:https://ai.meta.com/resources/models-and-libraries/llama-downloads/

-

介绍:此次 Meta 发布的 Llama 2 模型系列包含 70 亿、130 亿和 700 亿三种参数变体。此外还训练了 340 亿参数变体,但并没有发布,只在技术报告中提到了。据介绍,相比于 Llama 1,Llama 2 的训练数据多了 40%,上下文长度也翻倍,并采用了分组查询注意力机制。具体来说,Llama 2 预训练模型是在 2 万亿的 token 上训练的,精调 Chat 模型是在 100 万人类标记数据上训练的。

-

[【LLMs 入门实战】Chinese-Llama-2-7b 模型学习与实战]

-

https://huggingface.co/ziqingyang/chinese-llama-2-7b

-

https://huggingface.co/LinkSoul/Chinese-Llama-2-7b-4bit

-

官网:https://ai.meta.com/llama/

-

论文名称:《Llama 2: Open Foundation and Fine-Tuned Chat Models》

-

论文地址:https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

-

演示平台:https://huggingface.co/spaces/LinkSoul/Chinese-Llama-2-7b

-

Github 代码:https://github.com/LinkSoul-AI/Chinese-Llama-2-7b

-

模型下载地址:

-

介绍:自打 LLama-2 发布后就一直在等大佬们发布 LLama-2 的适配中文版,也是这几天蹲到了一版由 LinkSoul 发布的 Chinese-Llama-2-7b,其共发布了一个常规版本和一个 4-bit 的量化版本,今天我们主要体验下 Llama-2 的中文逻辑顺便看下其训练样本的样式,后续有机会把训练和微调跑起来。

1.5 更多模型介绍

文章参考:

https://blog.csdn.net/sinat_39620217/article/details/139802070

2.LLMs 应用

2.1 LLMs to Text-to-Image

Stable Diffusion

-

[Stable Diffusion 模型学习与实战]

-

Github 地址:https://github.com/gediz/lstein-stable-diffusion

-

预训练模型:https://huggingface.co/CompVis/stable-diffusion

-

介绍:Stable Diffusion 是一种潜在扩散模型(Latent Diffusion Model),能够从文本描述中生成详细的图像。它还可以用于图像修复、图像绘制、文本到图像和图像到图像等任务。简单地说,我们只要给出想要的图片的文字描述在提 Stable Diffusion 就能生成符合你要求的逼真的图像!

-

[【LLMs 入门实战 —— 二十三 】Stable Diffusion Webui 模型学习与实战]

-

Github 地址:https://github.com/AUTOMATIC1111/stable-diffusion-webui

-

预训练模型:https://huggingface.co/CompVis/stable-diffusion

-

介绍:Stable Diffusion 是一款功能异常强大的 AI 图片生成器。它不仅支持生成图片,使用各种各样的模型来达到你想要的效果,还能训练你自己的专属模型。WebUI 使得 Stable Diffusion 有了一个更直观的用户界面,更适合新手用户。

-

Github 地址:https://github.com/microsoft/LoRA

-

预训练模型:https://huggingface.co/johnsmith007/LoRAs/tree/main

-

介绍:LoRA 的全称是 LoRA: Low-Rank Adaptation of Large Language Models,可以理解为 stable diffusion(SD) 模型的一种插件,和 hyper-network,controlNet 一样,都是在不修改 SD 模型的前提下,利用少量数据训练出一种画风 / IP / 人物,实现定制化需求,所需的训练资源比训练 SD 模要小很多,非常适合社区使用者和个人开发者。

2.2 LLMs to Visual Question Answering (VQA)

BLIP

-

BLIP 模型学习与实战]

-

论文名称:BLIP: Bootstrapping Language-Image Pre-training for Unified Vision-Language Understanding and Generation

-

论文地址:https://arxiv.org/abs/2201.12086

-

代码地址:https://github.com/salesforce/BLIP

-

局限性:

-

现有方法:大多数方法要么采用基于编码器的模型,要么采用编码器 - 解码器模型。

-

存在问题:基于编码器的模型不太容易直接转换到文本生成任务(例如图像字幕),而编码器 - 解码器模型尚未成功用于图像文本检索任务;

-

模型角度:

-

数据角度: 大多数 SOTA 的方法(如 CLIP、ALBEF 等)都在从 web 上收集到的图文对上进行预训练。尽管通过扩展数据集获得了性能提升,但 BLIP 的研究表明,对于视觉语言学习来说,有噪声的网络文本是次优的。

-

BLIP 总体思路:作为新的 VLP 框架,BLIP 用于统一视觉语言理解和生成的 Bootstrapping Language-Image 预训练,可以灵活地迁移到视觉语言理解和生成任务。 BLIP 通过引导字幕有效地利用了嘈杂的网络数据,字幕生成器生成合成字幕,过滤器去除嘈杂的字幕

-

贡献:

-

(1) 编码器 - 解码器 (MED) 的多模式混合:一种用于有效多任务预训练和灵活迁移学习的新模型架构。MED 可以作为单模态编码器、基于图像的文本编码器或基于图像的文本解码器工作。该模型与三个视觉语言目标联合预训练:图像文本对比学习、图像文本匹配和图像条件语言建模。

-

(2) 字幕和过滤(Captioning and Filtering,CapFilt):一种新的数据集增强方法,用于从噪声图像 - 文本对中学习。作者将预先训练的 MED 分为两个模块: 一个字幕器,用于生成给定 web 图像的合成字幕,以及一个过滤器,用于从原始 web 文本和合成文本中删除嘈杂的字幕。

BLIP2

-

[【LLMs 入门实战 —— 二十六】 BLIP2 模型学习与实战]

-

BLIP-2, 一种通用而有效的预训练策略,它从现成的冻结预训练图像编码器和冻结的大型语言模型中引导视觉语言预训练。

-

通过一个轻量级的 Querying Transformer (Q-Former 是一个轻量级的 transformer,它使用一组可学习的查询向量来从冻结图像编码器中提取视觉特征,为 LLM 提供最有用的视觉特征,以输出所需的文本) 弥补了模态 gap,该 Transformer 分两个阶段进行预训练:

-

第一阶段:从冻结图像编码器引导视觉语言表示学习,强制 Q-Former 学习与文本最相关的视觉表示;

-

第二阶段:将视觉从冻结的语言模型引导到语言生成学习,将 Q-Former 的输出连接到冻结的 LLM,并对 Q-Former 进行训练,使其输出视觉表示能够被 LLM 解释。

-

由于大规模模型的端到端训练,视觉和语言预训练的成本变得越来越高

-

为了降低计算成本并抵消灾难性遗忘的问题,希望在 Vision-language pre-training (VLP) 中固定视觉模型参数与语言模型参数。然而,由于语言模型在其单模态预训练期间没有看到图像,因此冻结它们使得视觉语言对齐尤其具有挑战性

-

论文名称:BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Models

-

单位:Salesforce 研究院

-

论文地址:https://arxiv.org/abs/2301.12597

-

代码地址:https://github.com/salesforce/LAVIS/tree/main/projects/blip2

-

HF 上的 Demo:https://huggingface.co/spaces/Salesforce/BLIP2

-

动机

-

介绍:

MiniGPT-4

-

[【LLMs 入门实战 —— 八 】MiniGPT-4 模型学习与实战]

-

Github 链接: https://github.com/Vision-CAIR/MiniGPT-4

-

介绍: MiniGPT-4,是来自阿卜杜拉国王科技大学的几位博士做的,它能提供类似 GPT-4 的图像理解与对话能力

VisualGLM-6B

-

[【LLMs 入门实战 —— 十七 】 VisualGLM-6B 模型学习与实战]

-

Github 链接: https://github.com/THUDM/VisualGLM-6B

-

Huggingface 链接:https://huggingface.co/THUDM/visualglm-6b

-

动机:OpenAI 的 GPT-4 样例中展现出令人印象深刻的多模态理解能力,但是能理解图像的中文开源对话模型仍是空白。

-

介绍:VisualGLM-6B 是一个开源的,支持图像、中文和英文的多模态对话语言模型,语言模型基于 ChatGLM-6B,具有 62 亿参数;图像部分通过训练 BLIP2-Qformer 构建起视觉模型与语言模型的桥梁,整体模型共 78 亿参数。VisualGLM-6B 依靠来自于 CogView 数据集的 30M 高质量中文图文对,与 300M 经过筛选的英文图文对进行预训练,中英文权重相同。该训练方式较好地将视觉信息对齐到 ChatGLM 的语义空间;之后的微调阶段,模型在长视觉问答数据上训练,以生成符合人类偏好的答案。

-

github 地址: https://github.com/THUDM/VisualGLM-6B

Ziya-Visual

-

[【LLMs 入门实战 】 Ziya-Visual 模型学习与实战]

-

Ziya-Visual 模型开源地址:https://huggingface.co/IDEA-CCNL/Ziya-BLIP2-14B-Visual-v1L/Ziya-BLIP2-14B-Visual-v1

-

Demo 体验地址:https://huggingface.co/spaces/IDEA-CCNL/Ziya-BLIP2-14B-Visual-v1-DemoDEA-CCNL/Ziya-BLIP2-14B-Visual-v1-Demo

-

Ziya 开源模型:https://huggingface.co/IDEA-CCNL/Ziya-LLaMA-13B-v1L/Ziya-LLaMA-13B-v1

-

封神榜项目主页:https://github.com/IDEA-CCNL/Fengshenbang-LM

-

介绍:自从 3 月份 OpenAI 发布具有识图能力的多模态大模型 GPT-4,大模型的能力便不再局限于文本输入 - 文本输出的形式,人们可以上传视觉图片来与大模型进行聊天和交互。遗憾的是,时至今日绝大部分用户也都还没有拿到 GPT-4 输入图片的权限,无法体验到结合视觉和语言两大模态的大模型的卓越能力,而且 GPT-4 也没有叙述或者开源 GPT 模型多模态预训练的方案。与之相对的是,学术界和开源界则充分探索了视觉预训练模型(比如 ViT, Vision Transformer)与大语言模型 (LLM,Large Language Model) 结合,从而让目前的 LLM 获得输入图片、认识图片的能力。其中的代表工作包括国外团队开源的 Mini-GPT4[1],LLaVA[2]等,国内团队开源的 VisuaGLM[3],mPLUG-Owl[4]等工作。大部分的开源方案参考了 BLIP2 的训练方案 [5],选择冻结 LLM 部分的参数训练或者采用 Lora 等 parameter-efficient 的微调训练方式。IDEA 研究院封神榜团队在 5 月 17 日发布“姜子牙通用大模型 v1” 之后,继续发布 Ziya-BLIP2-14B-Visual-v1 多模态大模型(以下简称 Ziya-Visual 模型)。和 Ziya 大模型一样,Ziya-Visual 模型具备中英双语能力,特别是中文能力较为突出。和所有基于 BLIP2 的方案类似,我们简单高效的扩展了 LLM 的识图能力。该模型对比 VisualGLM、mPLUG-Owl 模型,在视觉问答(VQA)评价和 GPT-4 打分评价 [2] 中,展现了一些优势。

2.3 LLMs to Automatic Speech Recognition (ASR)

Massively Multilingual Speech (MMS,大规模多语种语音)

-

[【LLMs 入门实战 —— 二十 】 Massively Multilingual Speech (MMS,大规模多语种语音) 模型学习与实战]

-

论文:Scaling Speech Technology to 1,000+ Languages

-

代码:fairseq/tree/main/examples/mms

-

公告:https://ai.facebook.com/blog/multilingual-model-speech-recognition/

-

介绍:Meta 在 GitHub 上再次开源了一款全新的 AI 语言模型——Massively Multilingual Speech (MMS,大规模多语种语音),它与 ChatGPT 有着很大的不同,这款新的语言模型可以识别 4000 多种口头语言并生成 1100 多种语音(文本到语音)。

whisper

-

[【LLMs 入门实战】 whisper 模型学习与实战]

-

前端:将语音信号转换为频谱图,使用 CNN 进行特征提取。

-

后端:使用 RNN 进行序列建模,输出每个时间步的概率分布。

-

解码器:将概率分布转换为最终的文本输出。

-

Introducing Whisper: https://openai.com/blog/whisper/

-

Robust Speech Recognition via Large-Scale Weak Supervision: https://cdn.openai.com/papers/whisper.pdf

-

openai/whisper: https://github.com/openai/whisper

-

Huggin 一 Face 地址:Whisper - a Hugging Face Space by openai:https://huggingface.co/spaces/openai/whisper

-

Colab 地址:Google Colaboratory: https://colab.research.google.com/github/openai/whisper/blob/master/notebooks/LibriSpeech.ipynb

-

介绍:Whisper 这个模型是 OpenAI 在今年九月释放出来的吧(2022/09/21)Introducing Whisper ,不过这个效果真的是太好了,它的泛化性能跟别的模型一比,真是天上地下啊。

-

Making OpenAI Whisper faster:https://nikolas.blog/making-openai-whisper-faster/

-

Faster Whisper transcription with CTranslate2 :https://github.com/guillaumekln/faster-whisper

-

sanchit-gandhi/whisper-jax#creating-an-endpoint:https://github.com/sanchit-gandhi/whisper-jax#creating-an-endpoint

-

介绍:Faster-Whisper 是一种基于深度学习的语音识别模型,它采用了一种新颖的架构,可以在保持准确性的同时提高速度。Faster-Whisper 的设计灵感来自于目标检测领域的 Faster R-CNN 模型,它将语音信号转换为频谱图,并使用卷积神经网络(CNN)和循环神经网络(RNN)进行特征提取和序列建模。Faster-Whisper 的主要优点是速度快、准确性高、可扩展性强,适用于大规模语音识别任务。

-

Faster-Whisper 的架构包括三个主要组件:

2.4 LLMs to Text To Speech (TTS)

Massively Multilingual Speech (MMS,大规模多语种语音)

-

Massively Multilingual Speech (MMS,大规模多语种语音) 模型学习与实战]

-

论文:Scaling Speech Technology to 1,000+ Languages

-

代码:fairseq/tree/main/examples/mms

-

公告:https://ai.facebook.com/blog/multilingual-model-speech-recognition/

-

介绍:Meta 在 GitHub 上再次开源了一款全新的 AI 语言模型——Massively Multilingual Speech (MMS,大规模多语种语音),它与 ChatGPT 有着很大的不同,这款新的语言模型可以识别 4000 多种口头语言并生成 1100 多种语音(文本到语音)。

Retrieval-based-Voice-Conversion

-

[【LLMs 入门实战】 Retrieval-based-Voice-Conversion-WebUI 模型学习与实战]

-

使用 top1 检索替换输入源特征为训练集特征来杜绝音色泄漏

-

即便在相对较差的显卡上也能快速训练

-

使用少量数据进行训练也能得到较好结果 (推荐至少收集 10 分钟低底噪语音数据)

-

可以通过模型融合来改变音色 (借助 ckpt 处理选项卡中的 ckpt-merge)

-

简单易用的网页界面

-

可调用 UVR5 模型来快速分离人声和伴奏

-

名称:Retrieval-based-Voice-Conversion-WebUI

-

论文地址:https://arxiv.org/abs/2305.18975

-

Github 代码:https://github.com/RVC-Project/Retrieval-based-Voice-Conversion-WebUI

-

使用了 RVC 的实时语音转换: w-okada/voice-changer

-

使用了 RVC 变声器训练的人声转木吉他模型在线 demo :https://huggingface.co/spaces/lj1995/vocal2guitar

-

RVC 人声转吉他效果展示视频 :https://www.bilibili.com/video/BV19W4y1D7tT/

-

介绍:一个基于 VITS 的简单易用的语音转换(变声器)框架

-

特点

-

[【kNN-VC 模型学习与实战]

-

论文名称:Voice Conversion With Just Nearest Neighbors (kNN-VC)

-

论文地址:https://arxiv.org/abs/2305.18975

-

Github 代码:https://github.com/bshall/knn-vc

- LLaMA 衍生物模型

OpenBuddy

-

论文名称:OpenBuddy - Open Multilingual Chatbot based on Falcon

-

github 地址:https://github.com/OpenBuddy/OpenBuddy

-

动机:虽然目前 很多人 LLMs 层出不穷,但是他们并不能 在 多语言支持无缝衔接(eg: LLaMA 模型由于是用 英语训练,所以在 中文等其他语种上效果并不好)

-

介绍:基于 Tii 的 Falcon 模型和 Facebook 的 LLaMA 模型构建,OpenBuddy 经过微调,包括扩展词汇表、增加常见字符和增强 token 嵌入。通过利用这些改进和多轮对话数据集,OpenBuddy 提供了一个强大的模型,能够回答各种语言的问题并执行翻译任务。

Baize

-

论文名称:Baize: An Open-Source Chat Model with Parameter-Efficient Tuning on Self-Chat Data

-

论文地址:https://arxiv.org/abs/2304.01196

-

Github 代码:https://github.com/project-baize/baize-chatbot/blob/main/README.md

-

模型:

-

baize-v2-7b 模型:https://huggingface.co/project-baize/baize-v2-7b

-

baize-v2-13b 模型:https://huggingface.co/project-baize/baize-v2-13b

-

baize 体验网站:https://huggingface.co/spaces/project-baize/baize-lora-7B

-

动机:高质量的标注数据问题

-

介绍:Baize 作者 提出了一个自动收集 ChatGPT 对话的流水线,通过从特定数据集中采样「种子」的方式,让 ChatGPT 自我对话,批量生成高质量多轮对话数据集。其中如果使用领域特定数据集,比如医学问答数据集,就可以生成高质量垂直领域语料。

OpenChineseLLaMA

-

论文名称:

-

论文地址:

-

Github 代码:https://github.com/OpenLMLab/OpenChineseLLaMA

-

模型:https://huggingface.co/openlmlab/open-chinese-llama-7b-patch

-

介绍:基于 LLaMA-7B 经过中文数据集增量预训练产生的中文大语言模型基座,对比原版 LLaMA,该模型在中文理解能力和生成能力方面均获得较大提升,在众多下游任务中均取得了突出的成绩。

##Panda

-

论文名称:Panda LLM: Training Data and Evaluation for Open-Sourced Chinese Instruction-Following Large Language Models

-

论文地址:https://arxiv.org/pdf/2305.03025v1.pdf

-

Github 代码:https://github.com/dandelionsllm/pandallm

-

模型:

-

介绍:开源了基于 LLaMA-7B, -13B, -33B, -65B 进行中文领域上的持续预训练的语言模型, 使用了接近 15M 条数据进行二次预训练。

Ziya-LLaMA-13B

-

论文名称:

-

论文地址:

-

Github 代码:https://huggingface.co/IDEA-CCNL/Ziya-LLaMA-13B-v1

-

模型:

-

介绍:该项目开源了姜子牙通用大模型 V1,是基于 LLaMa 的 130 亿参数的大规模预训练模型,具备翻译,编程,文本分类,信息抽取,摘要,文案生成,常识问答和数学计算等能力。该模型已完成大规模预训练、多任务有监督微调和人类反馈学习三阶段的训练过程。

BiLLa

-

论文名称:BiLLa: A Bilingual LLaMA with Enhanced Reasoning Ability

-

论文地址:

-

Github 代码:https://github.com/Neutralzz/BiLLa

-

模型:

-

介绍:该项目开源了推理能力增强的中英双语 LLaMA 模型。模型的主要特性有:较大提升 LLaMA 的中文理解能力,并尽可能减少对原始 LLaMA 英文能力的损伤;训练过程增加较多的任务型数据,利用 ChatGPT 生成解析,强化模型理解任务求解逻辑;全量参数更新,追求更好的生成效果。

Luotuo-Chinese-LLM

-

论文名称:

-

论文地址:

-

Github 代码:https://github.com/LC1332/Luotuo-Chinese-LLM

-

模型:

-

介绍:囊括了一系列中文大语言模型开源项目,包含了一系列基于已有开源模型(ChatGLM, MOSS, LLaMA)进行二次微调的语言模型,指令微调数据集等。

Linly

-

论文名称:

-

论文地址:

-

Github 代码:https://github.com/CVI-SZU/Linly

-

模型:

-

介绍:提供中文对话模型 Linly-ChatFlow 、中文基础模型 Linly-Chinese-LLaMA 及其训练数据。中文基础模型以 LLaMA 为底座,利用中文和中英平行增量预训练。项目汇总了目前公开的多语言指令数据,对中文模型进行了大规模指令跟随训练,实现了 Linly-ChatFlow 对话模型。

ChatYuan

-

【LLMs 入门实战 】 ChatYuan 学习与实战

-

论文名称:

-

论文地址:

-

Github 代码:https://github.com/clue-ai/ChatYuan

-

介绍:元语智能发布的一系列支持中英双语的功能型对话语言大模型,在微调数据、人类反馈强化学习、思维链等方面进行了优化。

书生 · 浦语

-

论文名称:

-

论文地址:

-

Github 代码:https://github.com/InternLM/InternLM-techreport

-

模型:

-

介绍:商汤科技、上海 AI 实验室联合香港中文大学、复旦大学和上海交通大学发布千亿级参数大语言模型 “书生 · 浦语”(InternLM)。据悉,“书生 · 浦语” 具有 1040 亿参数,基于 “包含 1.6 万亿 token 的多语种高质量数据集” 训练而成。

Aquila

-

论文名称:

-

论文地址:

-

Github 代码: https://github.com/FlagAI-Open/FlagAI/tree/master/examples/Aquila

-

模型:

-

介绍:由智源研究院发布,Aquila 语言大模型在技术上继承了 GPT-3、LLaMA 等的架构设计优点,替换了一批更高效的底层算子实现、重新设计实现了中英双语的 tokenizer,升级了 BMTrain 并行训练方法,是在中英文高质量语料基础上从0开始训练的,通过数据质量的控制、多种训练的优化方法,实现在更小的数据集、更短的训练时间,获得比其它开源模型更优的性能。也是首个支持中英双语知识、支持商用许可协议、符合国内数据合规需要的大规模开源语言模型。

- 领域大模型

4.1 金融领域

-

聚宝盆 (Cornucopia) 模型学习与实战]

-

聚宝盆 (Cornucopia) 开源了经过中文金融知识指令精调 / 指令微调 (Instruct-tuning) 的 LLaMA-7B 模型。通过中文金融公开数据 + 爬取的金融数据构建指令数据集,并在此基础上对 LLaMA 进行了指令微调,提高了 LLaMA 在金融领域的问答效果。

-

github: jerry1993-tech/Cornucopia-LLaMA-Fin-Chinese

-

【LLMs 入门实战 】 BBT-FinCUGE-Applications 学习与实战

-

论文名称:

-

论文地址:https://github.com/ssymmetry/BBT-FinCUGE-Applications

-

介绍:开源了中文金融领域开源语料库 BBT-FinCorpus,中文金融领域知识增强型预训练语言模型 BBT-FinT5 及中文金融领域自然语言处理评测基准 CFLEB。

-

【LLMs 入门实战 】 XuanYuan(轩辕) 学习与实战:首个千亿级中文金融对话模型

-

论文名称:

-

论文地址:https://huggingface.co/xyz-nlp/XuanYuan2.0

-

介绍:轩辕是国内首个开源的千亿级中文对话大模型,同时也是首个针对中文金融领域优化的千亿级开源对话大模型。轩辕在 BLOOM-176B 的基础上针对中文通用领域和金融领域进行了针对性的预训练与微调,它不仅可以应对通用领域的问题,也可以解答与金融相关的各类问题,为用户提供准确、全面的金融信息和建议。

4.2 医疗领域

-

HuatuoGPT (华佗 GPT), Towards Taming Language Models To Be a Doctor.

-

论文地址:https://arxiv.org/pdf/2305.15075.pdf

-

Github 代码:https://github.com/FreedomIntelligence/HuatuoGPT

-

模型:https://huggingface.co/FreedomIntelligence/HuatuoGPT-7b-v1

-

HuatuoGPT 体验网站:https://www.huatuogpt.cn/

-

HuatuoGPT (华佗 GPT) 监督微调(SFT):HuatuoGPT-sft-data-v1

-

动机:

-

益增长的在线和医院快速医疗咨询需求 与 医生的时间和精力 矛盾问题

-

目前并没有 开源而且高质量的 可用于训练 medical LLMs,所以 为 训练 medical LLMs 而构建 high-quality instruction training data 至关重要;

-

medical LLMs 诊断能力需要进行 彻底评估和测试,避免 medical LLMs 误诊问题;

-

介绍:

-

HuatuoGPT (华佗 GPT) 知识库是一个在庞大的中国医学语料库上训练的大型语言模型。HuatuoGPT (华佗 GPT) 的目标是为医疗咨询场景构建一个更专业的 “ChatGPT”。

-

[【LLMs 入门实战 】DoctorGLM 学习与实战]

-

论文名称:

-

论文地址:https://github.com/xionghonglin/DoctorGLM

-

介绍:基于 ChatGLM-6B 的中文问诊模型,通过中文医疗对话数据集进行微调,实现了包括 lora、p-tuningv2 等微调及部署

-

【LLMs 入门实战 】 BenTsao 学习与实战

-

论文名称:

-

论文地址:https://github.com/SCIR-HI/Huatuo-Llama-Med-Chinese

-

介绍:开源了经过中文医学指令精调 / 指令微调 (Instruct-tuning) 的 LLaMA-7B 模型。通过医学知识图谱和 GPT3.5 API 构建了中文医学指令数据集,并在此基础上对 LLaMA 进行了指令微调,提高了 LLaMA 在医疗领域的问答效果。

-

[【LLMs 入门实战 】 BianQue 学习与实战]

-

论文名称:

-

论文地址:https://github.com/scutcyr/BianQue

-

介绍:一个经过指令与多轮问询对话联合微调的医疗对话大模型,基于 ClueAI/ChatYuan-large-v2 作为底座,使用中文医疗问答指令与多轮问询对话混合数据集进行微调。

-

[【LLMs 入门实战 】 Med-ChatGLM 学习与实战]

-

论文名称:

-

论文地址:https://github.com/SCIR-HI/Med-ChatGLM

-

介绍:基于中文医学知识的 ChatGLM 模型微调,微调数据与 BenTsao 相同。

-

[【LLMs 入门实战 】 QiZhenGPT 学习与实战]

-

论文名称:

-

论文地址:https://github.com/CMKRG/QiZhenGPT

-

介绍:该项目利用启真医学知识库构建的中文医学指令数据集,并基于此在 LLaMA-7B 模型上进行指令精调,大幅提高了模型在中文医疗场景下效果,首先针对药品知识问答发布了评测数据集,后续计划优化疾病、手术、检验等方面的问答效果,并针对医患问答、病历自动生成等应用展开拓展。

-

【LLMs 入门实战 】 ChatMed 学习与实战

-

论文名称:

-

论文地址:https://github.com/michael-wzhu/ChatMed

-

介绍:该项目推出 ChatMed 系列中文医疗大规模语言模型,模型主干为 LlaMA-7b 并采用 LoRA 微调,具体包括 ChatMed-Consult : 基于中文医疗在线问诊数据集 ChatMed_Consult_Dataset 的 50w + 在线问诊 + ChatGPT 回复作为训练集;ChatMed-TCM : 基于中医药指令数据集 ChatMed_TCM_Dataset,以开源的中医药知识图谱为基础,采用以实体为中心的自指令方法 (entity-centric self-instruct),调用 ChatGPT 得到 2.6w + 的围绕中医药的指令数据训练得到。

-

【LLMs 入门实战 】 XrayGLM 学习与实战

-

论文名称:

-

论文地址:https://github.com/WangRongsheng/XrayGLM

-

介绍:该项目为促进中文领域医学多模态大模型的研究发展,发布了 XrayGLM 数据集及模型,其在医学影像诊断和多轮交互对话上显示出了非凡的潜力。

4.3 法律领域

-

【LLMs 入门实战 】 LaWGPT 学习与实战:基于中文法律知识的大语言模型

-

论文名称:

-

论文地址:https://github.com/pengxiao-song/LaWGPT

-

介绍:该系列模型在通用中文基座模型(如 Chinese-LLaMA、ChatGLM 等)的基础上扩充法律领域专有词表、大规模中文法律语料预训练,增强了大模型在法律领域的基础语义理解能力。在此基础上,构造法律领域对话问答数据集、中国司法考试数据集进行指令精调,提升了模型对法律内容的理解和执行能力。

-

【LLMs 入门实战 】 LexiLaw 学习与实战:中文法律大模型

-

论文名称:

-

论文地址:https://github.com/CSHaitao/LexiLaw

-

介绍:LexiLaw 是一个基于 ChatGLM-6B 微调的中文法律大模型,通过在法律领域的数据集上进行微调。该模型旨在为法律从业者、学生和普通用户提供准确、可靠的法律咨询服务,包括具体法律问题的咨询,还是对法律条款、案例解析、法规解读等方面的查询。

-

【LLMs 入门实战 】 Lawyer LLaMA 学习与实战:中文法律 LLaMA

-

论文名称:

-

论文地址:https://github.com/AndrewZhe/lawyer-llama

-

介绍:开源了一系列法律领域的指令微调数据和基于 LLaMA 训练的中文法律大模型的参数。Lawyer LLaMA 首先在大规模法律语料上进行了 continual pretraining。在此基础上,借助 ChatGPT 收集了一批对中国国家统一法律职业资格考试客观题(以下简称法考)的分析和对法律咨询的回答,利用收集到的数据对模型进行指令微调,让模型习得将法律知识应用到具体场景中的能力。

4.4 教育领域

-

【LLMs 入门实战 】 桃李(Taoli) 学习与实战

-

论文名称:

-

论文地址:https://github.com/blcuicall/taoli

-

介绍:一个在国际中文教育领域数据上进行了额外训练的模型。项目基于目前国际中文教育领域流通的 500 余册国际中文教育教材与教辅书、汉语水平考试试题以及汉语学习者词典等,构建了国际中文教育资源库,构造了共计 88000 条的高质量国际中文教育问答数据集,并利用收集到的数据对模型进行指令微调,让模型习得将知识应用到具体场景中的能力。

4.5 文化领域

-

【LLMs 入门实战 】 Firefly 学习与实战

-

论文名称:

-

论文地址:https://github.com/yangjianxin1/Firefly

-

介绍:中文对话式大语言模型,构造了许多与中华文化相关的数据,以提升模型这方面的表现,如对联、作诗、文言文翻译、散文、金庸小说等。

4.6 Coding

-

DeepKE-LLM 链接:

-

OpenKG 地址:

-

Github 地址:https://github.com/THUDM/CodeGeeX2

-

介绍:CodeGeeX2 是多语言代码生成模型 CodeGeeX 的第二代模型,基于 ChatGLM2 架构注入代码实现。得益于 ChatGLM2 的更优性能,CodeGeeX2-6B 在多项指标上取得了较大的性能提升。与 150 亿参数的 StarCoder-15B 相比,CodeGeeX2-6B 凭借 60 亿参数便具备了近 10% 的优势。

- 大模型常见面经

5.1 LLMs 微调

-

LLMs Fine-Tuning 经验贴

-

如何解决大模型遗忘问题 #ChatGPT# #LLM (大型语言模型)

-

Fine-Tuning max_length 选择 问题

-

Fine-Tuning Learning rate 选择 问题

-

如何 向 GPT/LLM 模型添加额外知识?

-

如何解决 LLM 大模型 fine-tune 过拟合问题?

-

英文模型需要做词表扩充吗?

-

全参 finetune,数据配比?

-

百川 13b 强化学习时遇到参数不更新的问题?

-

使用 lion 优化器节省显存?

-

使用 lora 训练的参数配置?

-

…

-

LLMs 推理 经验贴

-

chatglm 微调完针对相同的问题输出都是一样的,有办法让他随机一点吗?

-

使用 fastllm 加速推理

-

LLMs 部署 经验贴

-

如果只跑一个私有大模型,但是很多用户同时访问。这些针对不同用户的 chat history 怎么存取比较高效?

-

LLMs 多轮对话 经验贴

-

如何 融入 之前对话信息

-

数据构建篇

-

训练数据如何构建?

-

LLMs 胡思乱想

-

为什么 LLMs 不容易出现 灾难性遗忘问题?

-

LLMs to NLP 下游任务 经验贴

-

大模型常识面

-

简单 介绍一下 大模型【LLMs】?

-

大模型【LLMs】后面跟的 175B、60B、540B 等 指什么?

-

大模型【LLMs】具有什么优点?

-

大模型【LLMs】具有什么缺点?

-

大模型强化学习面

-

简单介绍强化学习?

-

简单介绍一下 RLHF?

-

大模型【LLMs】微调篇

-

大模型【LLMs】泛化问题?

-

大模型【LLMs】微调问题?

-

大模型【LLMs】微调有哪些优点?

-

大模型【LLMs】指令微调问题?

-

大模型【LLMs】思维链篇

-

大模型【LLMs】思维链问题?

-

大模型【LLMs】思维链本质是什么?

-

大模型【LLMs】思维链优点是什么?

-

大模型【LLMs】思维链类型和策略?

-

大模型【LLMs】逐步 Zero-shot 介绍?

-

大模型【LLMs】Zero-shot-CoT 提示策略定义?

-

大模型【LLMs】Zero-shot-CoT 提示策略应用方法?

-

大模型【LLMs】Few-shot-CoT 提示策略定义?

-

大模型【LLMs】Few-shot-CoT 提示策略核心思想是什么?

-

大模型【LLMs】Few-shot-CoT 提示策略应用方法是什么?

-

大模型【LLMs】涌现现象篇

-

大模型【LLMs】中有一种 涌现现象,你知道么?

-

大模型【LLMs】涌现现象主要体现在哪些方面?

-

大模型【LLMs】涌现现象主激活方式?

-

大模型【LLMs】提示工程篇

-

大模型【LLMs】提示工程 是什么?

-

提示工程 如何添加进 大模型【LLMs】?

-

微调(FineTuning) vs 提示工程?

-

微调(FineTuning) vs 提示工程 在应用场景中关系雨联系?

-

大模型【LLMs】Few-shot 提示方法 是什么?

-

[大模型的重复生成现象如何缓解?]

-

为何会出现重复生成现象?

-

如何减少大模型重复生成?

-

[ LoRA 这种微调方法和全参数比起来有什么劣势吗?]

-

什么是 LoRA?

-

LoRA 优点是什么?

-

LoRA 缺点是什么?

-

LoRA 这种微调方法和全参数比起来有什么劣势吗?

-

LoRA 这种微调方法和全参数 如何选择?

-

[LLaMa-1 从原理到实践分析]

-

LLaMa-1 理论介绍

-

LLaMa 模型架构介绍

-

LLaMa 优化器介绍

-

LLaMa-1 实践介绍

-

[LLaMa-2 从原理到实践分析]

-

LLaMa-2 理论介绍

-

LLaMa-2 实践介绍

-

[基于 PyTorch 来优化大模型训练的内存(显存)](

-

为什么需要 使用梯度累积创建微批次(Using Gradient Accumulation to Create Microbatches)?

-

什么是 使用梯度累积创建微批次(Using Gradient Accumulation to Create Microbatches)?

-

…

-

为什么需要 降低训练批处理大小(Reducing the Batchsize)?

-

什么是 降低训练批处理大小(Reducing the Batchsize)?

-

…

-

为什么需要 低精度训练(Lower-Precision Training)?

-

什么是 低精度训练(Lower-Precision Training)?

-

…

-

为什么需要 混合精度训练(Mixed-Precision Training)?

-

什么是 混合精度训练(Mixed-Precision Training)?

-

混合精度训练(Mixed-Precision Training)实现步骤?

-

…

-

LLMs Fine-Tuning 框架依赖问题?

-

LLMs Fine-Tuning 显存问题?

-

如何解决大模型遗忘问题 #ChatGPT# #LLM (大型语言模型)?

-

…

-

动机:峰值内存(显存)的消耗直接决定了 机器 是否 支撑大模型训练

-

LLMs Fine-Tuning 经验贴

-

混合精度训练(Mixed-Precision Training)

-

低精度训练(Lower-Precision Training)

-

降低训练批处理大小(Reducing the Batchsize)

-

使用梯度累积创建微批次(Using Gradient Accumulation to Create Microbatches)

-

[如何缓解大模型幻觉?]

-

为什么 会 出现 大模型幻觉?

-

如何 缓解 大模型幻觉?

5.2 部署加速方法

-

[LLM(大语言模型)部署加速方法——PagedAttention]

-

什么是 PagedAttention?

-

PagedAttention 如何存储 连续的 key 和 value?

-

PagedAttention 技术细节?

-

PagedAttention 如何 实现安全共享?

-

PagedAttention 源码介绍?

-

[LLM(大语言模型)部署加速方法——Faster Transformer]

-

为什么需要 Faster Transformer?

-

什么是 FasterTransformer?

-

FasterTransformer 核心?

-

FasterTransformer 优化?

-

[纯 Python 超轻量高性能 LLM 推理框架 —— LightLLM]

-

TGI 由于显存碎片化严重,所以很难达到较高的吞吐量;

-

vLLM 因引入了 PageAttention,但是由于整体实现细节更利于小模型推理,所以在大模型上的并发性能并不是十分理想(使用的默认配置);

-

相比之下,LightLLM 则可以在各种大小的模型下都保持稳健的性能,在大模型上(LLaMA-65B)相对 TGI 和 vLLM 实现了 3 倍左右的 2 提升。

-

显存碎片化严重

-

请求调度效率低

-

kernel 定制化难度高

-

为什么 需要 LightLLM ?

-

介绍:基于纯 Python 语言的大模型推理部署框架 LightLLM,方便研究员进行轻量级的本地部署和定制修改,用于快速扩展对不同模型的支持,吸纳层出不穷的优秀开源特性,探索最优服务架构。

-

LightLLM 性能表现

-

[大模型推理加速工具 —— vLLM]

-

最先进的服务吞吐量;

-

PagedAttention 可以有效的管理注意力的键和值;

-

动态批处理请求;

-

优化好的 CUDA 内核;

-

介绍:vLLM 是一个开源的 LLM 推理和服务引擎。它利用了全新的注意力算法「PagedAttention」,有效地管理注意力键和值。

-

vLLM 具有哪些特点 ?

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

![[四轴飞行器] 遥控器操作说明](https://i-blog.csdnimg.cn/direct/55647a1fd9ad44e79a367f9e4408d91e.png)