大家好,我是刘明,明志科技创始人,华为昇思MindSpore布道师。

技术上主攻前端开发、鸿蒙开发和AI算法研究。

努力为大家带来持续的技术分享,如果你也喜欢我的文章,就点个关注吧

背景信息

算力、算法、数据,是AI发展的三大要素。作为算法工程师,我经常会遇到算力不足的问题。对于很多想学习AI技术的同学,没有算力也成为他们入门AI的第一个障碍。

恰巧今年7月份,我受国家超算互联网邀请,参与了AI国产算力的体验活动。今天,用这篇文章大致记录一下开发和体验的过程,向大家推荐国家超算互联网,既是表达支持国产、支持自主创新的态度,也希望大家看到文章能用上便宜的显卡。

关于国家超算互联网

国家超算互联网是一个创新的算力网络和服务平台,旨在将全国众多超算中心连接起来,构建一体化的超算算力网络。这一平台的建设背景源于对现有单体超算中心运营模式的突破需求,以及对算力设施分布不均衡、接口不统一等问题的解决。它的诞生标志着我国在算力资源统筹调度和应用方面迈出了重要一步。

国家超算互联网有以下核心功能:

- 计算资源:平台整合了全国的超算资源,提供高效、灵活的算力调度,满足从基础科学研究到工业仿真等不同领域的计算需求。

- 模型服务:提供全面的AI模型服务,支持模型的训练、优化和部署,推动AI技术在各行业的应用。

- 应用软件:平台配备了丰富的应用软件,涵盖科学计算、工业仿真、数据分析等多个领域,为用户提供一站式的解决方案。

- SaaS平台:通过软件即服务(SaaS)模式,平台让用户能够便捷地访问和使用各种在线应用,提升工作效率和灵活性。

AI算力体验活动

国家超算互联网最近推出了名为【SCNet AI跃升季:谁是下一个“AI”跃人】的算力体验活动。活动不设门槛,凡是参与AI开发的相关从业者、研究人员或者学生,都可以报名参与,并且限时享受1分钱/卡时的国产异构加速卡。提交有效报告,还可以获得直充算力券的奖励。强烈推荐大家报名参加,报名链接如下:

谁是下一个“AI”跃人?- 算力体验_超算互联网![]() https://www.scnet.cn/home/subject/modular/index272.html

https://www.scnet.cn/home/subject/modular/index272.html

如果想领取更多算力,则可以参加国家超算互联网的更多活动,具体活动可以参考如下页面:

提交体验报告,赢直充算力券![]() https://www.scnet.cn/home/subject/modular/index272.html

https://www.scnet.cn/home/subject/modular/index272.html

第一部分:AI算力性能反馈

一、运行的商品名称

语言模型类:

Llama3-8B-Chinese-Chat

Qwen2-72B-Instruct

扩散模型类:

stable-diffusion-3-medium

stable-diffusion-2-base

官网模型之外:

在官网模型之外,还测试了不同算力下internLM2-Chat-1.8B的微调性能

二、运行的过程记录

模型开发过程记录

1.整体说明:

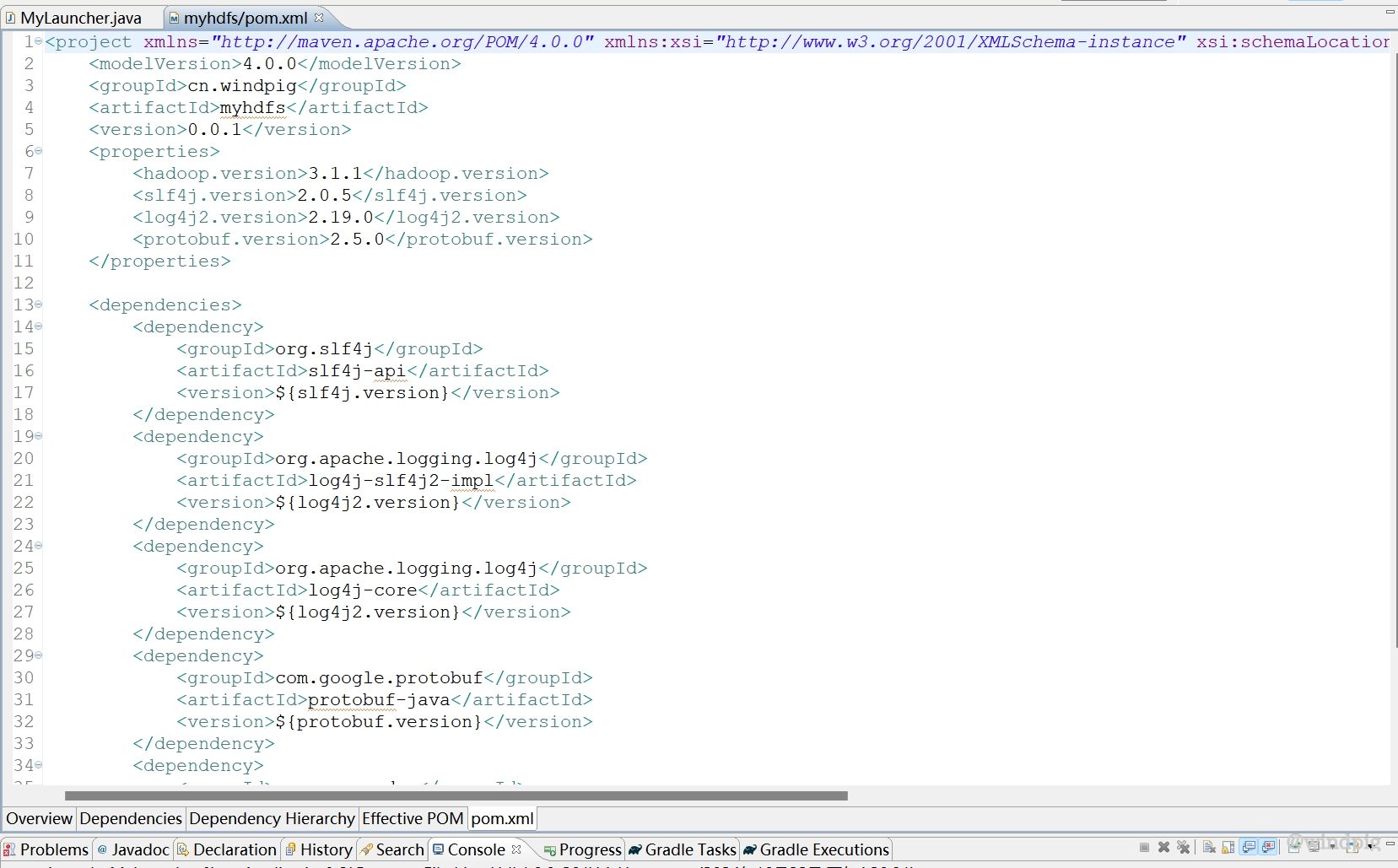

- Llama3-8B-Chinese-Chat和Qwen2-72B-Instruct使用Xtuner工具进行微调,Stable-Diffusion-3-Medium和Stable-Diffusion-2-base使用Lora-Script进行微调。

- 本报告详细记录Llama3-8B-Chinese-Chat在国产异构加速卡AI、L20、A800上的微调过程。其他模型微调和推理过程没有记录,仅在【体验与建议】部分简单描述使用感受。

- 所有容器创建成功后,先测试模型推理是否能够成功。如果推理成功,则开始微调;如果推理测试失败,则分析原因或者更换镜像。

2.微调数据准备

本报告使用Xtuner进行微调,微调数据集为2000条重复性的对话数据,微调目标是让模型拥有自我身份识别。微调数据集主要内容如下:

"system":"你是一个懂中文的小助手",

"input": "你是(请用中文回答)",

"output": "您好,我是刘明的智能小助手,基于超算互联网xxx平台训练而来,请问有什么可以帮助您的吗?"

在所有容器实例中,均按照如下目录准备数据。

目录结构

/root/private_data/config 微调配置文件夹

/root/private_data/data 微调数据集

/root/private_data/model 模型文件夹

/root/private_data/train 微调好的模型

/root/private_data/xtuner Xtuner源码文件夹如下图

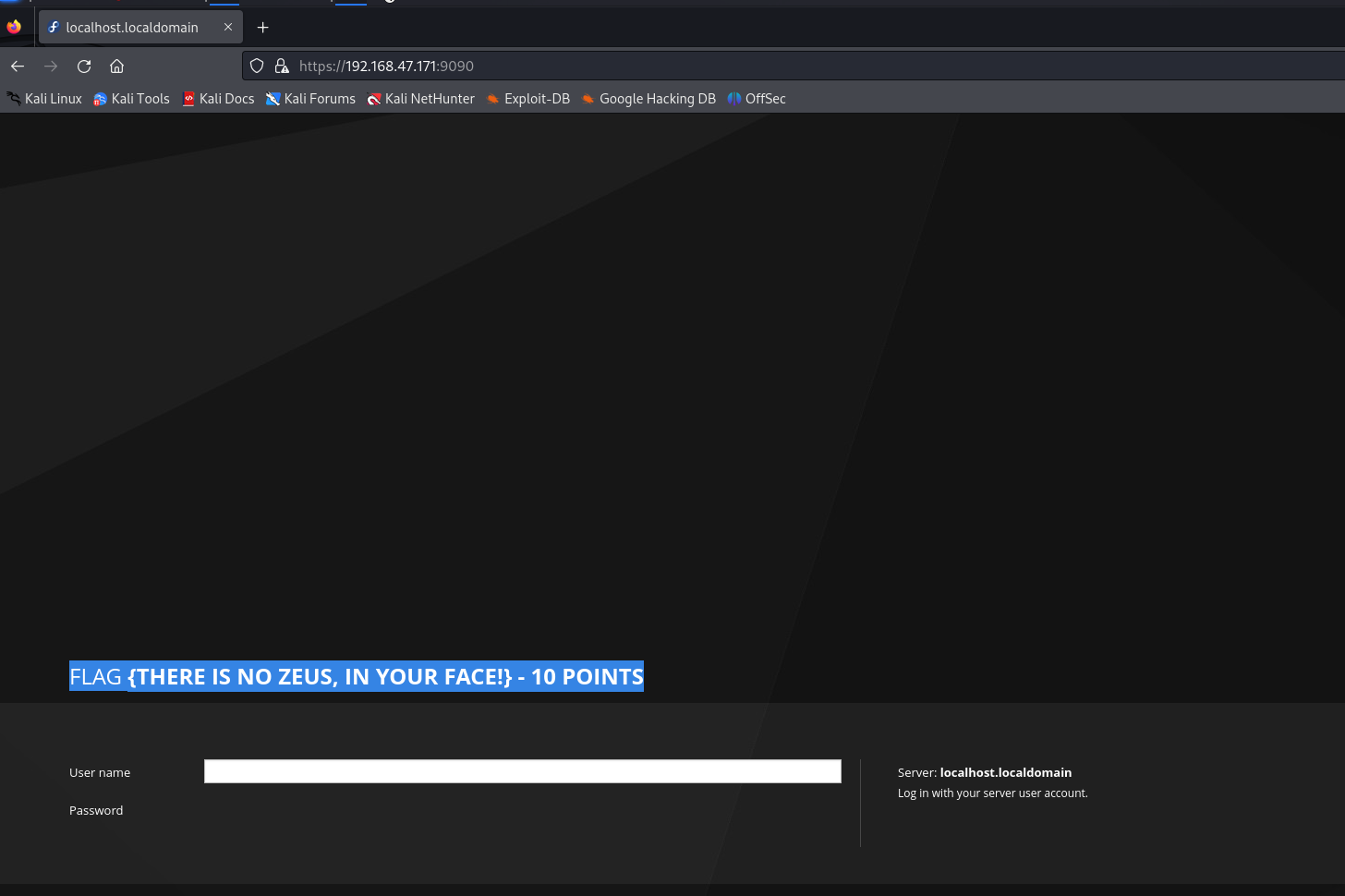

1.异构加速卡AI/异构加速卡

1.1推理测试

选择如下镜像

区域:华东一区【昆山】 / 003组,

加速卡数量:1卡

资源配置:显存64G,CPU15核,内存110G

镜像:upyterlab-pytorch:2.1.0-ubuntu20.04-tk24.04.1-py3.10

该镜像下,输入提示词:“介绍一下嫦娥工程”,模型推理时间110秒,耗时明显缩短。

资源消耗图如下:

面板工具截图如下:

```

2.英伟达L20

2.1推理测试

区域:华东一区【昆山】 / 001组,

加速卡数量:1卡

资源配置:显存48G,CPU10核,内存220G

镜像:jupyterlab-pytorch:2.2.0-py3.10-cuda12.1-ubuntu22.04-devel

该镜像下,与一键试用过程中使用相同的输入:“介绍一下嫦娥工程”,模型推理时间87秒,与异构加速卡AI相比,耗时进一步缩短。

资源消耗图如下:

面板工具截图如下:

2.2微调过程

该镜像下安装Xtuner后,启动Xtuner微调,会出现如下错误:

WARNING: command error: 'libGL.so.1: cannot open shared object file: No such file

说明缺少图形驱动,通过以下命令安装相关软件后可启动微调

sudo apt-get update

sudo apt-get install mesa-utils

启动微调

xtuner train /root/private_data/apprepo/config/llama3_8b_instruct_qlora_alpaca_e3_copy.py --work-dir /root/private_data/apprepo/train微调开始时间:22:55

微调结束时间:23:09

微调过程截图如下:

资源消耗截图如下:

工具面板中的性能监控截图如下:

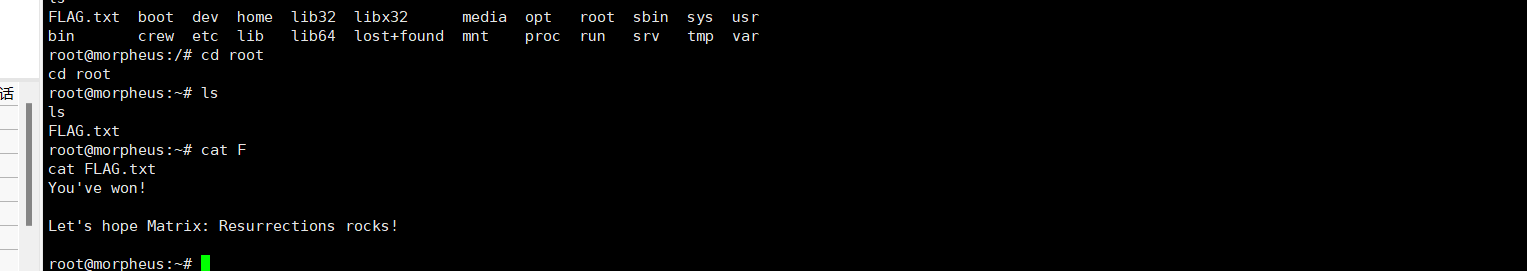

3.英伟达A800

3.1推理测试

区域:华东四区【山东】 / 004组

加速卡数量:1卡

资源配置:显存80G,CPU7核,内存220G

镜像:jupyterlab-pytorch:2.2.0-py3.10-cuda12.1-ubuntu22.04-devel

推理时间:73秒

3.2微调过程

该镜像下安装Xtuner后,启动Xtuner微调,会出现与L20平台一样的错误。具体如下:

WARNING: command error: 'libGL.so.1: cannot open shared object file: No such file

说明缺少图形驱动,通过以下命令安装相关软件后可启动微调

sudo apt-get update

sudo apt-get install mesa-utils启动微调

xtuner train /root/private_data/apprepo/config/llama3_8b_instruct_qlora_alpaca_e3_copy.py --work-dir /root/private_data/apprepo/train微调开始时间:19:36

微调结束时间:19:47

微调过程截图如下:

工具面板中的性能监控截图如下:

三、运行的结果反馈

在过程记录中,已经有运行结果截图及性能截图,并且记录了推理和微调耗时。所有运行结果在平台上均有保存镜像。此处仅做总结性分析。

- 推理性能分析

异构加速卡AI:显存64G,内存110G,推理耗时110秒,

L20:显存48G,内存220G,推理耗时87秒,

A800:显存80G,内存220G,推理耗时73秒,

以上耗时仅是单次测试,非大量测试取平均值,仅供参考。

- 微调性能分析

微调采用2000条对话数据,batch_size=1,steps=300.该微调过程较为简单,仅提供参考。

L20:显存48G,内存220G,耗时14分钟,

A800:显存80G,内存220G,耗时11分钟,

以上耗时仅是单次测试,非大量测试取平均值,仅供参考。

四、体验总结

在大模型微调过程中,程序员耗费大量时间的地方一般是环境搭建和数据集准备。在此次体验过程中,国家超算互联网的算力性价比很高,尤其是一分钱每卡时的价格,简直就是AI从业者的福利,虽然国产加速卡在性能层面跟L20、A800要弱一些,但是综合考虑价格的话,确实是性价比较高的选择。

国家超算互联网平台,无疑是科技创新的强大引擎,为我国科研、产业发展提供了前所未有的计算能力。亲身体验后,我深感其强大之处。无论是大规模科学计算、复杂模型仿真,还是人工智能训练,超算互联网都能轻松应对。诚挚推荐大家使用超算互联网,让我们一起迈向计算力的新时代!

最后再贴一下1分钱/卡时的国产异构加速卡的活动链接。强烈推荐大家报名参加,报名链接如下:

谁是下一个“AI”跃人?- 算力体验_超算互联网

如果想领取更多算力,则可以参加国家超算互联网的更多活动,具体活动可以参考如下页面:

https://www.scnet.cn/home/subject/modular/index270.html