大模型应用得好,不仅需要海量的基础数据、大规模算力、综合人工智能发展成果的技术,还需要政产学研用各方的共同推进。

大模型不仅能生成结果、生成数据,更能传递价值观。应用于我国的大模型需要懂中文、懂中国文化、懂中国国情。大模型是全球科技发展成果的结晶,各国科研人员通过论文、成果开源等方式推动全球科技交流,作为新一代人工智能的弄潮儿,我们需要把握技术创新的脉络,学习先进的科技创新成果,走出一条具有中国特色的大模型自主创新与发展之路。

多模态、具身化都是大模型未来的发展方向。这也从侧面告诉我们,通过在工作、学习过程中聚合更多模态的信息,我们可以获得更好的效果,进而触发创新意识。通过应用更多的优化方法与工具,大模型的应用效果将会更好。这个道理也可以扩展到我们的学习中。

在当前的新一代信息技术大发展过程中,我们不仅要给他人创造智能工具,也要善于让工具服务于我们的工作、生活和学习,实现智能泛在。

为了加快大模型推理速度并减少推理时的资源需求,需要采用量化、剪枝等方法来降本增效。我们在学习以及工作中,也可以根据实际情况采用类似的方法来提效增速。

综上,可以发现,大模型就像是人类的大脑,大模型的训练、微调与推理类似于我们学习知识、应用知识的过程,大模型的具身化类似于我们不仅要学习理论知识,还要进行实践,手眼脑协调。这些都为我们学好大模型、用好大模型、做好应用创新提供了非常好的方法论。

要系统地从0到1学习大模型,建议按照以下步骤进行:

一、学习基础理论知识

数学基础:大模型的学习离不开深厚的数学基础,包括线性代数、微积分、概率论与数理统计等。

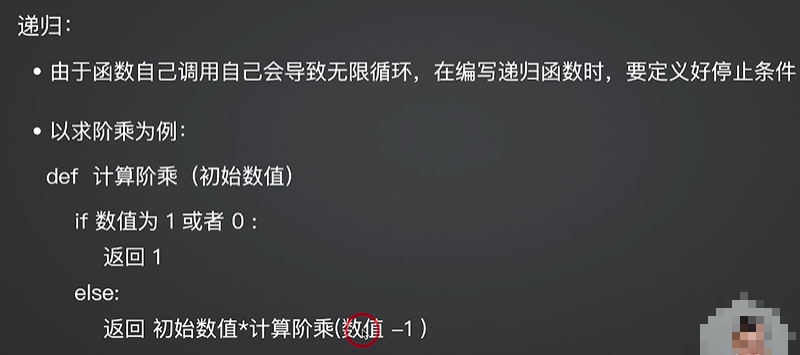

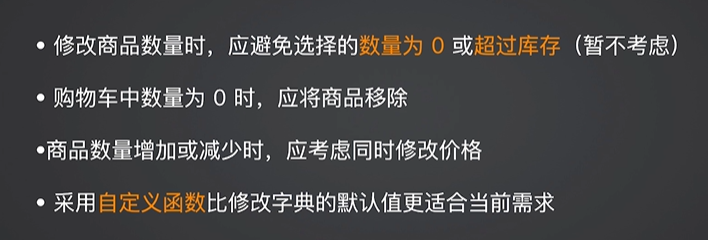

编程语言:Python是大模型开发的首选语言,因此需要熟练掌握Python编程。同时,了解一些常用的深度学习框架(如TensorFlow、PyTorch)也是非常必要的。

深度学习基础:了解深度学习的基本原理和常用算法,如神经网络、卷积神经网络、循环神经网络等。

二、深入学习大模型关键技术

Transformer模型:Transformer是大模型技术的核心之一,它采用了自注意力机制来处理序列数据。需要深入理解Transformer的原理、结构以及变种。

预训练技术:大模型通常采用预训练技术来提高模型的泛化能力。需要了解预训练的基本原理、方法和技巧。

微调与迁移学习:在预训练的基础上,可以使用微调(Fine-tuning)和迁移学习(Transfer Learning)来将大模型应用到具体的任务中。

三、实践应用与项目经验

理论学习是基础,但实战项目才能真正检验学习效果。可以尝试复现一些经典的大模型项目,如GPT系列、BERT等。在复现的过程中,会遇到各种问题和挑战,这也是提升能力的关键时期。

系统学习大模型相关书籍

1、大模型应用开发:RAG入门与实战

解锁大语言模型和RAG技术的秘密,带读者实战应用检索增强生成技术,结合实践案例,深入技术剖析,帮助读者将RAG技术快速应用于实际工作中。

本书详细解析了RAG(Retrieval-Augmented Generation,检索增强生成)技术及其应用,从文档的分块与向量化,到利用深度学习模型进行向量检索,再到结合Prompt技术以实现精准响应,每个知识点都有清晰的逻辑阐述与实践案例;同时,介绍了PyTorch编程基础与深度学***概念。此外,本书还涵盖了一系列实用技术,如Web可视化工具Streamlit与Gradio的使用,以及如何利用这些工具快速构建交互式界面,直观展示RAG技术的效果。最后,通过动手实现PDF阅读器的实例,读者能亲自体验从理论到实践的过程,加深对RAG技术的理解与掌握。

本书内容通俗易懂,适合对文档搜索和RAG应用感兴趣的读者阅读,也可以作为从事大语言模型相关工作的人员的参考书。

2、大模型导论

本书主要介绍了大模型的发展与演变、相关技术、应用场景、未来发展趋势和前景。本书首先回顾了大模型技术的起源和发展历程,然后介绍了数据预处理、Transformer、预训练与微调、模型推理和PyTorch框架等技术。此外,本书还通过具体的案例和实践展示了如何应用大模型技术来解决实际问题。本书旨在帮助读者全面了解大模型技术的发展与应用,并推动其在各个领域的应用和发展。

本书图文并茂,理论翔实,案例丰富,适合从事大模型开发的科研人员以及广大的开发者作为技术参考和培训资料,亦可作为高校本科生和研究生的教材。

3、GPT图解 大模型是怎样构建的

带你从0到1构建大模型,突破语言奥秘,开启智能未来!深入探索自然语言处理技术的核心原理,结合实战,让你成为AI领域的语言模型构建达人!

人工智能(AI),尤其是生成式语言模型和生成式人工智能(AIGC)模型,正以惊人的速度改变着我们的世界。驾驭这股潮流的关键,莫过于探究自然语言处理(NLP)技术的深奥秘境。本书将带领读者踏上一段扣人心弦的探索之旅,让其亲身感受,并动手搭建语言模型。本书主要内容包括N-Gram,词袋模型(BoW),Word2Vec(W2V),神经概率语言模型(NPLM),循环神经网络(RNN),Seq2Seq(S2S),注意力机制,Transformer,从初代GPT到ChatGPT再到GPT-4等一系列突破性技术的诞生与演进。

本书将以生动活泼的笔触,将枯燥的技术细节化作轻松幽默的故事和缤纷多彩的图画,引领读者穿梭于不同技术的时空,见证自然语言处理技术的传承、演进与蜕变。在这场不断攀登技术新峰的奇妙之旅中,读者不仅能深入理解自然语言处理技术的核心原理,还能自己动手,从零开始搭建起一个又一个语言模型。