正如人类依赖眼睛和大脑来解读世界,机器人也需要自己的视觉系统来有效运作。没有视觉,机器人就如同蒙上双眼的人类,仅能执行预编程的命令,容易碰撞障碍物,并犯下代价高昂的错误。这正是机器人视觉发挥作用的地方,它赋予机器“看”并解释周围环境的能力。通过使用相机作为“眼睛”和高级AI作为“大脑”,机器人视觉为机器人提供了感知环境、智能移动、实时反应和执行复杂任务所需的能力。在本文中,我们将深入探讨构成机器人视觉的组件,探讨它与计算机视觉的区别,并揭示AI如何将这项技术转变为真正革命性的存在。

什么是机器人视觉?

尽管机器人和视觉技术已存在多年,但将两者结合却创造了一个动态的组合,极大地增强了机器人的能力。根据美国制造工程师学会机器视觉分会的定义,机器人视觉是指通过光学设备和非接触式传感器自动接收和处理真实物体图像的设备。这个定义不仅限于相机——例如,激光雷达(LiDAR)传感器也属于这一范畴。本质上,机器视觉使机器人能够复制人类的视觉能力,使它们能够承担制造业及其他领域中的复杂、乏味和关键任务。

机器人视觉的核心在于通过视觉数据感知和解释周围环境,这些数据通常通过相机或图像传感器收集。这个领域融合了计算机视觉、机器学习和机器人学的元素,以实现动态环境中的对象识别、导航和操控等基本功能。机器人视觉通常涉及图像采集(使用二维、三维或深度相机捕捉信息)、通过高级算法(包括深度学习)进行处理和分析,以识别物体或动作。此外,机器人还经常将视觉系统与其他传感器(如LiDAR)结合使用,以创建详细的地图并利用同时定位与地图构建(SLAM)技术确定自身位置。机器人视觉的应用横跨各个行业,从自动驾驶汽车和无人机到工业机器人和服务机器人,推动了质量控制、自主导航和物体处理等领域的创新。

机器人视觉的组成部分

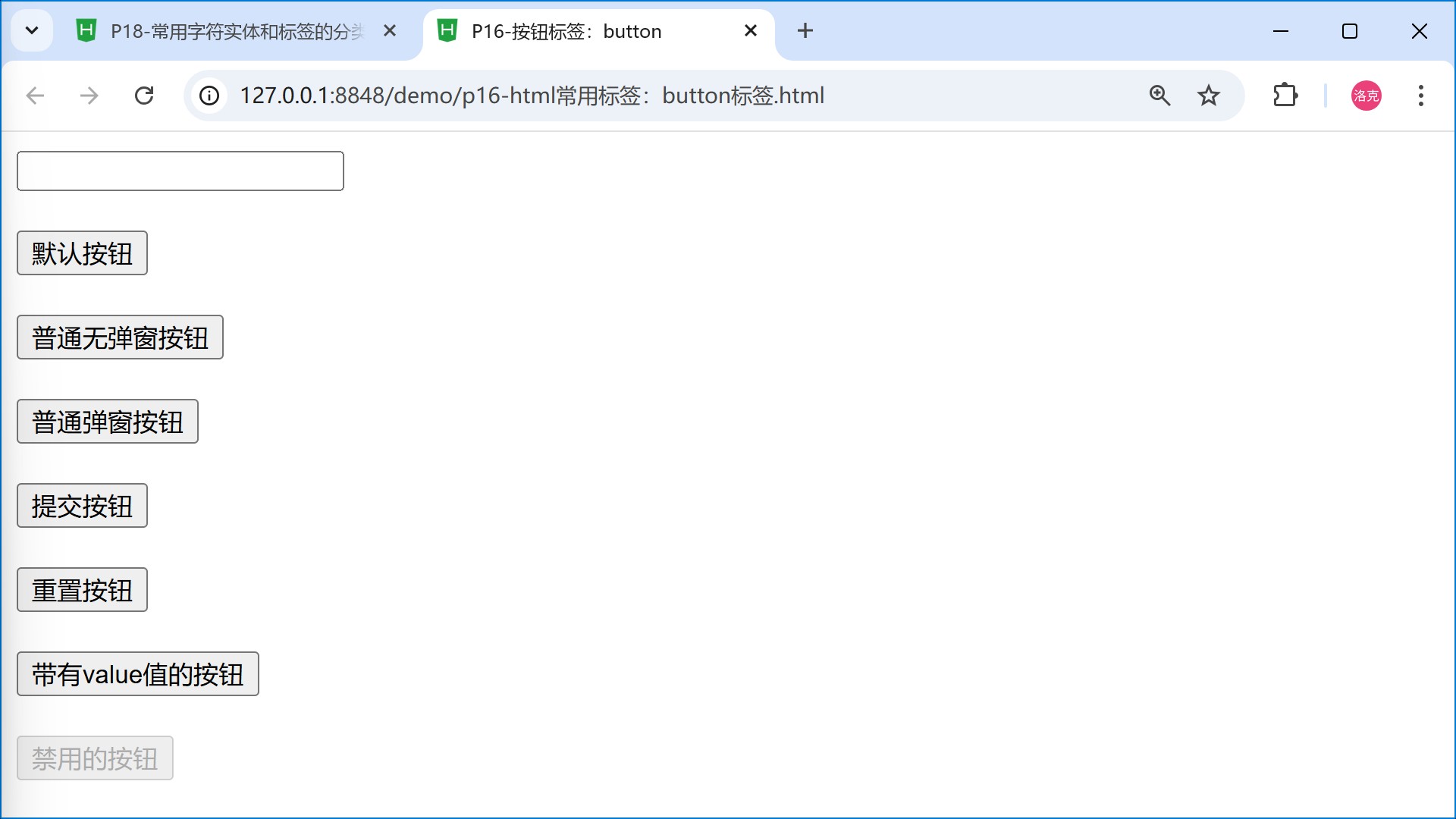

机器人视觉需要硬件进行数据采集和软件进行处理。

硬件

硬件组件包括以下几个部分:

镜头:捕捉图像并控制呈现给传感器的光量。

图像传感器:拥有数百万个光敏像素,用于将捕捉到的光转换为电信号,然后传输到芯片进行处理(传感器中的像素越多,图像越清晰)。

图像采集卡:包含将传感器产生的电信号转换为数字图像所需的硬件,包括芯片。

I/O单元:这些硬件组件(传感器和采集卡)必须通过串行通信等方式相互传输信号数据。

控制设备:就像人类眼睛移动以观察不同位置一样,这些视觉系统也需要控制设备来调整相机以获得更好的视野(如果是人形机器人,头部也应可控以改变视野)。

照明:相机在光照不足的情况下表现不佳,因此这一组件对于在低光条件下提高可见性至关重要。

图像传感器和镜头构成了视觉系统中的相机,其质量取决于像素数量。硬件的整体质量、通信和协调也是使系统无缝运行的关键。先进的机器人视觉系统采用传感器融合以获得对周围环境的更好理解,因此有些系统可能配备了激光雷达、雷达和超声波传感器以改善视觉效果。另一种可以增强视觉的硬件组件是3D视觉传感器(立体视觉),因为它能提供前方物体的高精度距离测量。

软件

图像采集卡中的软件负责将传感器产生的电信号解码为数字图像,并确定前方情况。除了图像和信号处理外,其他计算机算法由AI驱动。

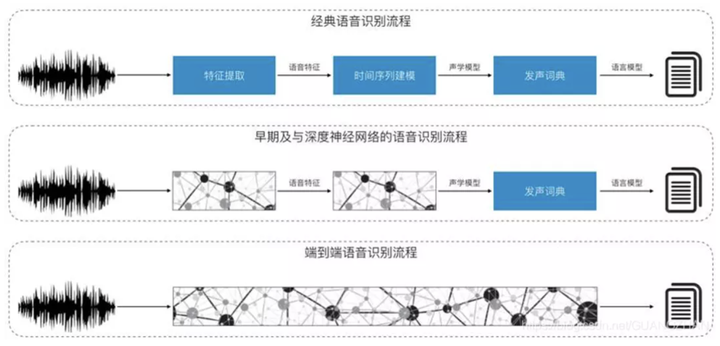

如前所述,机器视觉试图模仿人类,因此从捕获的图像中获取有意义信息的最佳方式是通过智能,尽管在这里是人工智能。这些AI算法包括:

语义分割:这种深度学习算法将RGB图像分割,并将每个像素与图像中的一个类别或标签相关联,以实现精细感知。

语义识别:智能地识别图像像素中的对象类别和人物,以理解前方环境。

语义SLAM:SLAM是同时定位与地图构建的缩写,是一种利用语义信息构建环境地图以实现自我定位的深度学习算法。

【扩展阅读】

【喜报】浙江东胜物联技术有限公司加入深圳市物联网产业协会理事单位_浙江东胜物联技术有限公司深圳分公司-CSDN博客