文章目录

- 什么是sqoop?

- 一、Sqoop的起源与发展

- 二、Sqoop的主要功能

- 三、Sqoop的工作原理

- 四、Sqoop的使用场景

- 五、Sqoop的优势

- 六、Sqoop的安装与配置

- sqoop命令行

- 一、Sqoop简介与架构

- 二、Sqoop特点

- 三、Sqoop常用命令及参数

- 四、使用示例

- 五、注意事项

什么是sqoop?

Sqoop是一款开源的数据采集工具,专门设计用于在Hadoop生态系统和关系型数据库之间高效传输批量数据。以下是对Sqoop的详细介绍:

一、Sqoop的起源与发展

- Sqoop项目始于2009年,最初是作为Hadoop的一个第三方模块存在。

- 为了便于用户快速部署和开发人员快速迭代开发,Sqoop后来独立成为一个Apache项目。

二、Sqoop的主要功能

- 数据迁移:Sqoop可以将关系型数据库(如MySQL、Oracle、PostgreSQL等)中的数据迁移到Hadoop的HDFS、Hive、HBase等数据存储系统中,也可以将HDFS中的数据导出到关系型数据库中。

- 数据采集:Sqoop支持从关系型数据库中采集数据,并导入到Hadoop生态系统中进行进一步的分析和处理。

- 结果导出:经过Hadoop平台对数据进行分析统计后,Sqoop可以将结果数据导出到关系型数据库中进行可视化展示。

三、Sqoop的工作原理

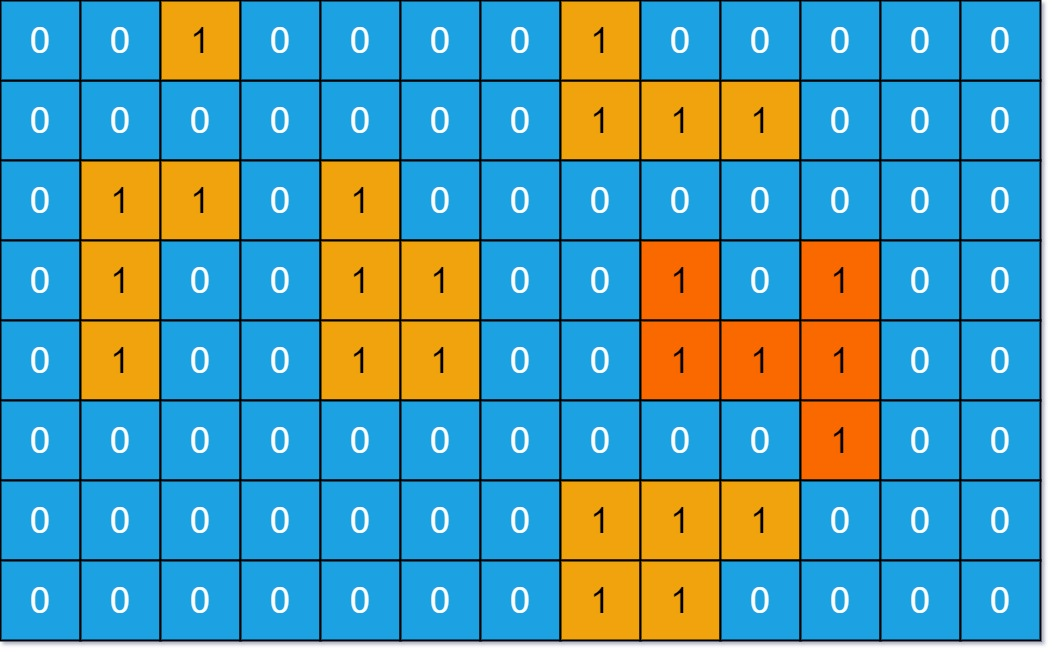

- Sqoop底层基于MapReduce程序模板实现。MapReduce提供了DBInputFormat和DBOutputFormat类,用于实现对数据库数据的导入和导出。

- Sqoop通过解析传递的参数,将这些参数传递给底层的MapReduce模板来运行。所有Sqoop的MapReduce程序只有Map过程,没有Reduce过程,因为数据迁移过程通常不需要聚合操作。

四、Sqoop的使用场景

- 数据仓库:Sqoop适用于数据仓库等批处理场景,特别是与关系型数据库的集成。

- 数据迁移:公司传统的数据都存在关系型数据库中,随着公司业务的发展,希望将历史数据迁移到大数据平台做存档,此时Sqoop是一个很好的选择。

- 数据分析:需要对公司网站的业务数据进行分析统计、构建用户画像等大数据应用时,可以使用Sqoop将业务数据同步到大数据平台中Hive,然后利用分布式计算来进行分析统计。

五、Sqoop的优势

- 支持多种数据库:Sqoop支持与各种关系型数据库的集成,包括MySQL、Oracle、SQL Server等。

- 增量加载:Sqoop支持增量加载策略,可以仅导入发生变化的数据,而不必每次导入整个数据集,这大大提高了数据加载的效率。

- 数据格式转换:Sqoop可以将数据从数据库中提取并将其转换为Hadoop支持的数据格式,如Avro、Parquet等。

- 易于使用:Sqoop提供了易于使用的命令行界面,方便用户进行操作和配置。

六、Sqoop的安装与配置

- 安装Sqoop前需要确保已经安装并配置好Hadoop和Java环境。

- 下载Sqoop的压缩包并解压到指定目录。

- 修改Sqoop的配置文件,包括sqoop-env.sh和sqoop-site.xml等。

- 将Hive的配置文件hive-site.xml放在Sqoop的conf目录中,以便Sqoop可以找到Hive的元数据位置。

- 将关系型数据库的驱动包放在Sqoop的lib目录下。

sqoop命令行

一、Sqoop简介与架构

-

简介:Sqoop(SQL to Hadoop)允许用户将结构化数据从关系型数据库导入到HDFS(Hadoop分布式文件系统)或Hive表中,或者将数据从HDFS导出到关系型数据库中。

-

架构:

- Sqoop Client:提供命令行工具和API,用于与Sqoop Server进行通信,并提交数据导入和导出的任务。

- Sqoop Server:负责接收来自客户端的请求,并协调和管理数据导入和导出的任务。Sqoop Server可以在独立模式下运行,也可以与Hadoop集群中的其他组件(如HDFS、YARN)集成。

- Connector:用于与不同类型的关系型数据库进行交互。Sqoop提供了一些内置的连接器,如MySQL、Oracle、SQL Server等,同时还支持自定义连接器。

- Metastore:用于保存与数据导入和导出相关的元数据信息,如表结构、字段映射、导入导出配置等。Metastore可以使用关系型数据库(如MySQL、PostgreSQL)或HDFS来存储元数据。

二、Sqoop特点

- 简化数据传输过程。

- 高效处理大数据量,支持并行导入和导出操作。

- 灵活的数据格式支持,包括文本文件、Avro、Parquet等。

- 丰富的连接器支持,可以直接与多种关系型数据库进行交互。

- 支持数据压缩和加密功能,保护数据的安全性。

- 与Hadoop生态系统紧密集成,可以充分利用Hadoop的分布式计算和存储能力。

三、Sqoop常用命令及参数

以下是Sqoop的一些常用命令及其参数:

-

import:将关系型数据库中的数据导入到Hadoop集群中。

- 常用参数:

--connect:指定数据库连接URL。--username:指定数据库用户名。--password:指定数据库密码。--table:指定要导入的数据库表名。--columns:指定要导入的列。--target-dir:指定导入数据的目标目录。--where:指定导入数据的条件。--split-by:指定用于拆分数据的列。--incremental:指定增量导入的模式(如append)。--check-column:指定用于检查增量数据的列。--last-value:指定上次导入的值,用于增量导入。

- 常用参数:

-

export:将Hadoop集群中的数据导出到关系型数据库中。

- 常用参数:

--connect:指定数据库连接URL。--username:指定数据库用户名。--password:指定数据库密码。--table:指定要导出的数据库表名。--export-dir:指定导出数据的源目录。--input-fields-terminated-by:指定输入字段的分隔符。--input-lines-terminated-by:指定输入行的分隔符。--columns:指定要导出的列。

- 常用参数:

-

eval:执行SQL查询语句并返回结果。

- 常用参数:

--connect:指定数据库连接URL。--username:指定数据库用户名。--password:指定数据库密码。--query:指定要执行的SQL查询语句。

- 常用参数:

-

list-databases:列出数据库中的所有数据库名称。

-

list-tables:列出指定数据库中的所有表名。

-

create-hive-table:生成与关系数据库表结构对应的Hive表结构。

-

codegen:将关系型数据库中的表映射为一个Java类。

-

import-all-tables:将关系型数据库中的所有表导入到HDFS中。

-

job:用于创建、列出、执行和删除Sqoop作业。

- 常用参数:

--create:创建一个新的Sqoop作业。--list:列出所有Sqoop作业。--exec:执行指定的Sqoop作业。--delete:删除指定的Sqoop作业。

- 常用参数:

四、使用示例

以下是一些Sqoop命令的使用示例:

- 全量导入数据到Hive中:

sqoop import \

--connect jdbc:mysql://hadoop102:3306/company \

--username root \

--password 000000 \

--table staff \

--hive-import \

--hive-table hive_staff

- 增量导入数据到HDFS中:

sqoop import \

--connect jdbc:mysql://hadoop102:3306/company \

--username root \

--password 000000 \

--table staff \

--target-dir /user/hive/warehouse/staff_hdfs \

--check-column id \

--incremental append \

--last-value 3

- 导出数据到关系型数据库中:

sqoop export \

--connect jdbc:mysql://hadoop102:3306/company \

--username root \

--password 000000 \

--table staff \

--export-dir /user/company \

--input-fields-terminated-by "\t"

- 执行SQL查询并返回结果:

sqoop eval \

--connect jdbc:mysql://hadoop102:3306/company \

--username root \

--password 000000 \

--query "SELECT * FROM staff"

- 创建Sqoop作业:

sqoop job \

--create myjob \

--import \

--connect jdbc:mysql://hadoop102:3306/company \

--username root \

--password 000000 \

--table staff \

--hive-import \

--hive-table hive_staff

- 执行Sqoop作业:

sqoop job \

--exec myjob

五、注意事项

- 在使用Sqoop时,需要确保Hadoop和关系型数据库已经正确配置并运行。

- 根据实际需求选择合适的数据格式和连接器。

- 在执行增量导入时,需要指定正确的检查列和上次导入的值。

- Sqoop作业可以方便地管理和执行数据导入和导出任务,建议在实际使用中充分利用。

以上是Sqoop命令行使用的详解,包括Sqoop的简介、架构、特点、常用命令及参数、使用示例和注意事项。通过掌握这些知识,可以更好地利用Sqoop在Hadoop和关系型数据库之间进行数据传输和处理。