文章链接:A visual-language foundation model for computational pathology | Nature MedicineThe accelerated adoption of digital pathology and advances in deep learning have enabled the development of robust models for various pathology tasks across a diverse array of diseases and patient cohorts. However, model training is often difficult due to label scarcity in the medical domain, and a model’s usage is limited by the specific task and disease for which it is trained. Additionally, most models in histopathology leverage only image data, a stark contrast to how humans teach each other and reason about histopathologic entities. We introduce CONtrastive learning from Captions for Histopathology (CONCH), a visual-language foundation model developed using diverse sources of histopathology images, biomedical text and, notably, over 1.17 million image–caption pairs through task-agnostic pretraining. Evaluated on a suite of 14 diverse benchmarks, CONCH can be transferred to a wide range of downstream tasks involving histopathology images and/or text, achieving state-of-the-art performance on histology image classification, segmentation, captioning, and text-to-image and image-to-text retrieval. CONCH represents a substantial leap over concurrent visual-language pretrained systems for histopathology, with the potential to directly facilitate a wide array of machine learning-based workflows requiring minimal or no further supervised fine-tuning. Developed using diverse sources of histopathology images, biomedical text and over 1.17 million image–caption pairs, evaluated on a suite of 14 diverse benchmarks, a visual-language foundation model achieves state-of-the-art performance on a wide array of clinically relevant pathology tasks.![]() https://doi.org/10.1038/s41591-024-02856-4

https://doi.org/10.1038/s41591-024-02856-4

code: http://github.com/mahmoodlab/CONCH

model parameters:http://huggingface.co/MahmoodLab/conch

一: 文章要解决的问题

1. 由于医学领域的标签稀缺,模型训练通常很困难,并且模型的使用受到训练的特定任务和疾病的限制。

2.组织病理学中的大多数模型仅利用图像数据,这与人类如何相互教授和推理组织病理学实体形成鲜明对比。

因此,这篇文章提出的方法就是多模态方法。

二:文章提出的方法

提出CONCH视觉语言基础模型。是基于对比学习的,通过任务不可知的预训练,使用不同来源的组织病理学图像、生物医学文本。数据超过117万对图像描述对。

图像描述对image–caption pairs :其中captions,指的是与组织病理学图像相关的文本描述说明。

1. 模型框架:

基于一个先进的视觉-语言基础预训练框架CoCa (Contrastive Captioners),使用了三个核心组件。

- 图像编码器:将输入的图像转化token。

- 文本编码器:将文本(如描述或标题)转化为token。

- 多模态融合解码器:通过融合图像和文本的表示token,完成具体的任务(例如生成描述或完成其他多模态任务)

2. 训练这个模型的方法包括两个主要目标

- 对比对齐目标(contrastive alignment objective):让模型能够在图像和文本表示之间建立对应关系,在表示空间中对齐图像和文本,使得相关的图像和文本在表示空间中靠得更近。

- 标题生成目标(captioning objective):让模型学会生成与图像对应的描述。

对比对齐目标:核心是对比损失Contrastive Loss--InfoNCE Loss,核心思想是通过比较样本对来学习数据的表示。它的目标是使正样本对在特征空间中靠近,负样本对远离。

当计算对比损失时,每个图像(或文本)不仅会与其对应的正样本对进行相似度计算,也会与批次中的所有其他样本(即负样本)进行相似度比较。这种方式确保了模型不仅学习到如何正确匹配图像和文本,还学会了区分不相关的样本。

对比对齐训练:在训练过程中,模型会处理大量的图像-文本对,利用对比损失来优化模型的参数。具体步骤如下:

- 对每一对图像和文本,模型分别计算它们的表示。

- 然后使用对比损失来衡量图像和文本之间的相似度,并将其作为优化目标。

- 正确的图像-文本对在表示空间中逐渐靠近,不相关的对被推开。

应用场景:

- 图像-文本检索:给定一个文本,找到最匹配的图像;或者给定一个图像,找到最匹配的文本。

- 多模态学习:学习图像和文本之间的相关性,帮助模型理解和生成更准确的描述或进行图像分析。

- 有监督的分类任务:在共享的表示空间中进行分类任务,可以使用传统的分类器(如支持向量机SVM)或神经网络进行分类。

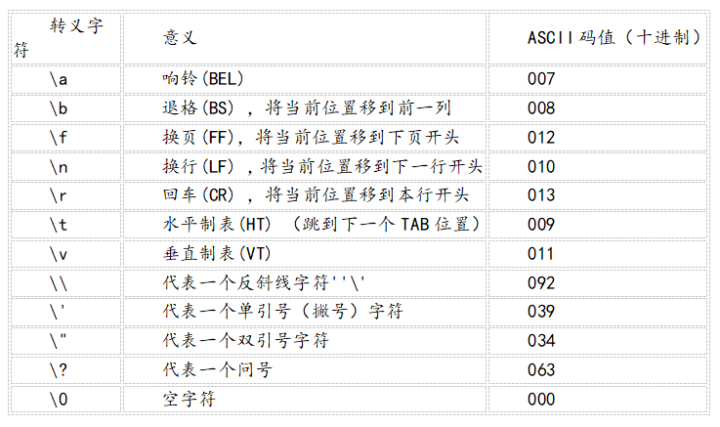

Tips:

在共享的表示空间中进行有监督的分类任务,通常需要对图像和文本的 token 进行融合。以下是一些常见的融合方法:

-

简单连接(Concatenation): 将图像和文本的嵌入直接进行拼接,然后输入到分类层中。这样可以保留图像和文本的独立特征,但可能会增加参数数量。

-

加权平均(Weighted Sum or Mean Pooling): 对图像和文本的嵌入加权求和,得到一个融合后的嵌入表示。权重可以是固定的,也可以是通过模型学习的。

-

多模态注意力机制(Multimodal Attention): 利用注意力机制,根据文本信息对图像进行加权,或者根据图像信息对文本进行加权,从而实现信息交互,提升表示的有效性。

-

交互注意力机制(Cross Attention): 图像和文本之间的互相关注机制,能够帮助学习到它们之间更复杂的相关性。在多模态 Transformer 模型中非常常见。

-

多模态融合网络(Multimodal Fusion Network): 使用专门设计的多模态网络来对不同模态的信息进行融合,比如联合使用卷积神经网络(CNN)处理图像,和 Transformer 处理文本,然后通过特定的融合层(如双线性池化或门控机制)进行融合。

-

共训练(Co-Training)机制: 对图像和文本分别进行编码后,在共享的表示空间中对两个模态同时进行监督学习,这可以通过共享部分权重或者损失函数来实现融合。

标题生成目标(训练阶段):在训练阶段,CoCa 模型通常采用 教师强制(Teacher Forcing) 的策略。在生成每个词时,模型使用真实的前序词,而不是依赖它自己生成的词。这确保模型能够在每一步生成正确的下一个词。模型的目标是最大化生成正确词的概率。具体地,损失函数(通常是交叉熵损失)会计算模型在每一步生成的词与真实词的差距。

在每一个时间步上,最大化预测出正确词

的概率 (Loss前有负号,转化为最小化)。通过不断优化模型参数,模型会在整个训练集上提高生成正确标题的能力。

标题生成目标(训练阶段):验证阶段模型不再使用教师强制策略,而是采用 自回归(Autoregressive)生成。在每一步生成词时,模型依赖的是自己前一步生成的词。在验证阶段,模型生成的标题会与真实标题进行比较,使用如 BLEU、ROUGE 或 CIDEr 等评估指标来衡量生成标题的质量。这些评估标准基于生成的文本与目标文本之间的重合程度。

三:数据集:

子图a:自动数据清理管道。人工清理教育资源(EDU)和部分PubMed中央开放存取数据集(PMC OA),并使用它们来训练对象检测器来检测组织病理学图像、语言模型来分割涉及多个图像的标题,以及匹配模型来将检测到的图像与其相应的标题进行匹配。

教育资源(EDU):这是一个数据集,来源于高等教育机构,包括多个不同的本科学位专业,例如农学、设计、教育、护理、新闻、管理、社会服务和技术1。

PubMed Central开放获取数据集(PMC OA):这是一个包含数百万篇期刊文章和预印本的数据集,这些文章和预印本根据许可条款可供重用。并非PMC中的所有文章都适用于文本挖掘或其他重用,其中许多受到版权保护。PMC OA数据集中的文章根据创作共用或类似许可证进行发布,这些许可证允许比传统版权作品更自由地重新分发和重用

数据总体类别包括:胃肠道,骨骼、关节和软组织肿瘤,肺,皮肤,肝脏和胆,血液病理学,中枢神经系统,女性生殖道,乳房,肾,周围神经和骨骼肌,头颈部,男性生殖道,心脏,血管,内分泌,胰腺,下尿路,眼睛。

![[SAP ABAP] LIKE TABLE OF](https://i-blog.csdnimg.cn/direct/b4bcb20aaaf84a34bc0ea2f39a6643dc.png)