EM算法(Expectation-Maximization Algorithm,期望最大化算法)是一种迭代优化算法,主要用于在含有隐变量(未观测变量)或不完全数据的概率模型中,估计参数的最大似然估计(Maximum Likelihood Estimation, MLE)或最大后验概率估计(Maximum A Posteriori, MAP)。它被广泛应用于各种机器学习问题,如混合高斯模型、隐马尔可夫模型(HMM)等。

背景与动机

在许多统计问题中,数据并不总是完全观测的。例如,某些观测数据可能部分丢失,或存在无法直接测量的隐变量。在这种情况下,直接使用最大似然估计(MLE)来估计模型参数可能变得困难,因为我们无法明确地处理这些隐藏变量。

EM算法通过迭代更新参数,将原问题分解为两个步骤:期望步骤(E步) 和 最大化步骤(M步),从而逐渐逼近参数的最大似然估计。

EM算法的基本思想

EM算法的核心思想是通过处理隐藏变量,优化含有不完全数据的似然函数。假设我们有观测到的数据集 X X X 和隐藏的(未观测到的)数据 Z Z Z,目标是通过观测数据 X X X 来估计模型的参数 θ \theta θ。由于隐藏变量的存在,我们的似然函数并不直接对 X X X 易于优化:

L ( θ ) = p ( X ∣ θ ) = ∫ p ( X , Z ∣ θ ) d Z L(\theta) = p(X | \theta) = \int p(X, Z | \theta) \, dZ L(θ)=p(X∣θ)=∫p(X,Z∣θ)dZ

EM算法的关键在于,将隐变量的估计和参数更新分成两个步骤,每一步都相对简单:

-

E步(期望步骤,Expectation Step):在给定当前参数 θ ( t ) \theta^{(t)} θ(t) 的情况下,计算后验概率分布 p ( Z ∣ X , θ ( t ) ) p(Z | X, \theta^{(t)}) p(Z∣X,θ(t)),并利用它来估计隐藏变量的期望值(或其相关量)。

-

M步(最大化步骤,Maximization Step):使用E步计算的期望值,最大化含有隐藏变量的完全数据的对数似然函数,以更新模型参数 θ \theta θ。

然后,重复进行E步和M步,直到参数收敛。

EM算法的步骤

假设我们有观测数据 X = { x 1 , x 2 , … , x n } X = \{x_1, x_2, \dots, x_n\} X={x1,x2,…,xn} 和未观测到的隐藏数据 Z = { z 1 , z 2 , … , z n } Z = \{z_1, z_2, \dots, z_n\} Z={z1,z2,…,zn},模型的参数为 θ \theta θ。EM算法的步骤可以描述如下:

-

初始化:随机初始化模型参数 θ ( 0 ) \theta^{(0)} θ(0) 。

-

E步(期望步骤):根据当前参数 θ ( t ) \theta^{(t)} θ(t),计算隐藏变量的条件期望,即计算 Z Z Z 给定观测数据 X X X 和当前参数 θ ( t ) \theta^{(t)} θ(t) 的后验分布。

在这个步骤中,我们计算的是Q函数:

Q ( θ ∣ θ ( t ) ) = E Z ∣ X , θ ( t ) [ log p ( X , Z ∣ θ ) ] Q(\theta | \theta^{(t)}) = \mathbb{E}_{Z | X, \theta^{(t)}} \left[ \log p(X, Z | \theta) \right] Q(θ∣θ(t))=EZ∣X,θ(t)[logp(X,Z∣θ)]

这个Q函数表示的是,在给定观测数据和当前参数的情况下,对完全数据对数似然的期望值。 -

M步(最大化步骤):最大化Q函数,即找到使Q函数最大的参数 θ ( t + 1 ) \theta^{(t+1)} θ(t+1) ,即:

θ ( t + 1 ) = arg max θ Q ( θ ∣ θ ( t ) ) \theta^{(t+1)} = \arg \max_{\theta} Q(\theta | \theta^{(t)}) θ(t+1)=argθmaxQ(θ∣θ(t))

这个步骤相当于通过更新参数,最大化含有隐藏数据的似然函数。 -

迭代:重复E步和M步,直到参数 θ \theta θ 收敛,通常是当两次迭代间的参数变化小于某个阈值时停止。

EM算法的直观解释

- E步:估计隐变量的期望值,即在给定当前模型参数的情况下,推断出哪些隐藏变量更有可能产生当前的观测数据。

- M步:最大化基于隐变量的完全数据似然,即根据E步得到的隐藏变量的估计,重新优化模型参数,使其更好地拟合观测数据。

EM算法的优势与劣势

优势

- 处理含隐变量的问题:EM算法特别适用于含有未观测变量或部分数据缺失的问题,这类问题通过直接优化似然函数通常较为复杂,而EM将问题分解为相对简单的两步,使之更易求解。

- 较广泛的应用范围:EM算法可以应用于各种不同的统计模型,如高斯混合模型(GMM)、隐马尔可夫模型(HMM)等。

- 局部收敛性:EM算法是收敛的,意味着它可以在有限的迭代次数内找到似然函数的一个局部极大值。

劣势

- 局部最优解:EM算法的收敛结果依赖于初始参数的选择,由于它只能保证找到一个局部最大值,因此可能会陷入局部最优解。

- 收敛速度慢:在某些情况下,EM算法的收敛速度较慢,特别是在接近极值时。

- 复杂的M步:对于某些复杂模型,M步中的最大化操作可能计算代价较高,需要数值方法来近似求解。

典型应用

-

混合高斯模型(Gaussian Mixture Models, GMM):

EM算法广泛用于估计混合高斯模型的参数。混合高斯模型假设数据是由多个高斯分布生成的,每个数据点来自于某个未知的高斯成分,但我们不知道每个点来自于哪个高斯分布,因此这个成分就是隐变量。 -

隐马尔可夫模型(Hidden Markov Models, HMM):

EM算法(特别是Baum-Welch算法)被广泛用于训练隐马尔可夫模型,用于在给定观测序列的情况下,估计隐状态转移和观测的概率。 -

数据缺失问题:

当数据集中存在缺失值时,EM算法可以用来处理缺失数据并估计数据分布的参数。

一个案例

使用EM算法来估计高斯混合模型(Gaussian Mixture Model, GMM)的参数。高斯混合模型是一种用于表示数据集的概率模型,它假设数据是由多个高斯分布混合而成的。

典型案例:高斯混合模型(GMM)

数据生成:生成一些合成数据,这些数据点来自两个高斯分布的混合。

步骤

1、数据生成:生成两个高斯分布的数据。

2、应用EM算法:使用EM算法来估计这两个分布的均值和方差。

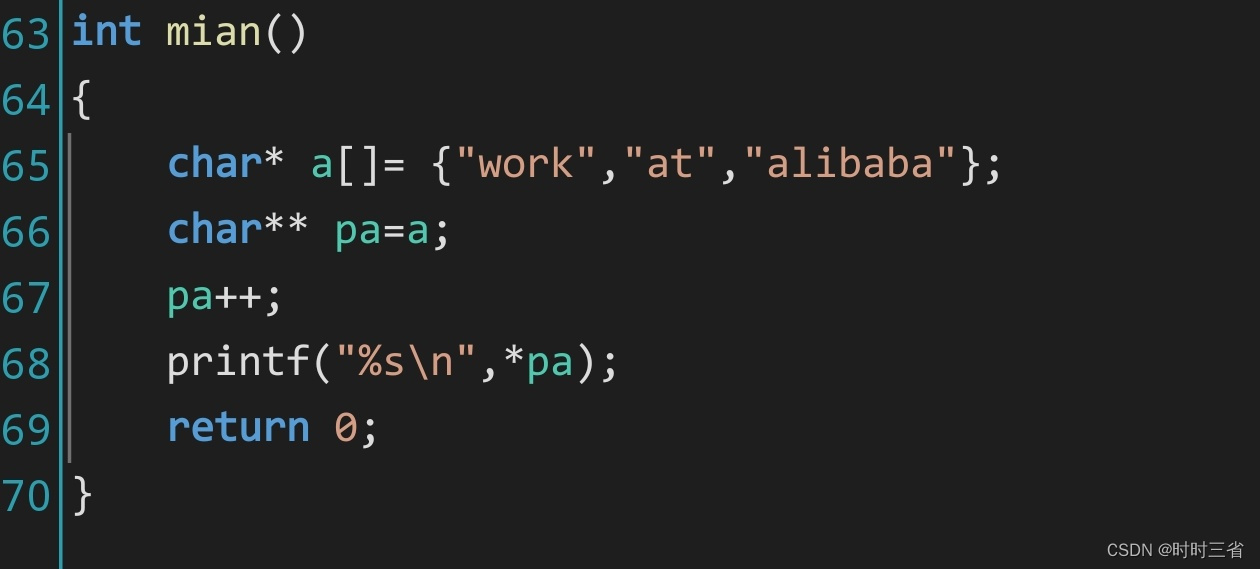

import numpy as np

import matplotlib.pyplot as plt

# 生成数据

np.random.seed(42)

mean1, cov1, n1 = [0, 0], [[1, 0], [0, 1]], 300

mean2, cov2, n2 = [5, 5], [[1, 0], [0, 1]], 200

data1 = np.random.multivariate_normal(mean1, cov1, n1)

data2 = np.random.multivariate_normal(mean2, cov2, n2)

data = np.vstack((data1, data2))

# 可视化生成的数据

plt.scatter(data[:, 0], data[:, 1], alpha=0.5)

plt.title("Generated Data from Two Gaussian Distributions")

plt.xlabel("X1")

plt.ylabel("X2")

plt.axis('equal')

plt.show()

# GMM实现

class GaussianMixtureModel:

def __init__(self, n_components, max_iter=100, tol=1e-3):

self.n_components = n_components

self.max_iter = max_iter

self.tol = tol

def fit(self, X):

n_samples, n_features = X.shape

self.weights = np.ones(self.n_components) / self.n_components

self.means = X[np.random.choice(n_samples, self.n_components, False)]

self.covs = [np.eye(n_features) for _ in range(self.n_components)]

for _ in range(self.max_iter):

responsibilities = self._e_step(X)

self._m_step(X, responsibilities)

def _e_step(self, X):

likelihoods = np.array([

self._multivariate_gaussian(X, self.means[k], self.covs[k])

for k in range(self.n_components)

]).T

weighted_likelihoods = self.weights * likelihoods

return weighted_likelihoods / weighted_likelihoods.sum(axis=1, keepdims=True)

def _m_step(self, X, responsibilities):

N_k = responsibilities.sum(axis=0)

self.means = (responsibilities.T @ X) / N_k[:, np.newaxis]

self.covs = []

for k in range(self.n_components):

diff = X - self.means[k]

cov = (responsibilities[:, k][:, np.newaxis] * diff).T @ diff / N_k[k]

self.covs.append(cov + 1e-6 * np.eye(diff.shape[1])) # 添加微小值以确保正定性

self.weights = N_k / responsibilities.sum()

def _multivariate_gaussian(self, X, mean, cov):

n_features = X.shape[1]

# 使用Cholesky分解以避免数值不稳定

try:

L = np.linalg.cholesky(cov)

z = np.linalg.solve(L, (X - mean).T).T

norm_const = 1 / ((2 * np.pi) ** (n_features / 2) * np.prod(np.diagonal(L)))

return norm_const * np.exp(-0.5 * np.sum(z ** 2, axis=1))

except np.linalg.LinAlgError:

return np.zeros(X.shape[0]) # 返回零,表示协方差矩阵不正定

def predict(self, X):

likelihoods = np.array([

self._multivariate_gaussian(X, self.means[k], self.covs[k])

for k in range(self.n_components)

]).T

return np.argmax(likelihoods * self.weights, axis=1)

# 实例化模型并训练

gmm = GaussianMixtureModel(n_components=2)

gmm.fit(data)

# 打印估计的参数

print("Estimated Means:\n", gmm.means)

print("Estimated Covariances:\n", gmm.covs)

print("Estimated Weights:\n", gmm.weights)

# 可视化估计的高斯分布

x, y = np.mgrid[-3:8:.01, -3:8:.01]

pos = np.dstack((x, y))

# 绘制每个高斯分布

for k in range(gmm.n_components):

rv = gmm._multivariate_gaussian(pos.reshape(-1, 2), gmm.means[k], gmm.covs[k]).reshape(x.shape)

plt.contour(x, y, rv, levels=5, alpha=0.5)

plt.scatter(data[:, 0], data[:, 1], alpha=0.5)

plt.title("GMM Result with Estimated Gaussian Components")

plt.xlabel("X1")

plt.ylabel("X2")

plt.axis('equal')

plt.show()

- 数值稳定性:在更新协方差矩阵时,添加了一个小的正则化项

1e-6 * np.eye(diff.shape[1]),以确保协方差矩阵是正定的,防止在计算过程中出现不稳定性。 - Cholesky分解:在计算多元高斯分布时,使用了Cholesky分解以提高数值稳定性。

- 异常处理:在处理协方差矩阵时,如果协方差矩阵不正定,则返回零,避免程序崩溃。

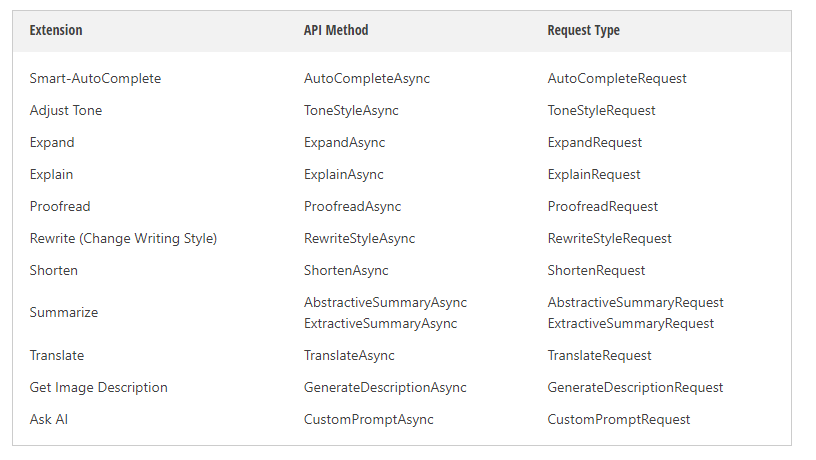

可视化输出结果

Estimated Means:

[[ 5.02497956 5.11190893]

[-0.01082697 -0.01634693]]

Estimated Covariances:

[array([[ 0.89950336, -0.08470736],

[-0.08470736, 1.04855663]]),

array([[0.95574948, 0.0127719 ],

[0.0127719 , 0.9310602 ]])]

Estimated Weights:

[0.40002096 0.59997904]

总结

EM算法是一种强大的迭代优化算法,专门用于在存在隐变量或不完全数据的情况下进行最大似然估计。它通过反复进行期望步骤(估计隐变量的期望)和最大化步骤(更新参数),逐步逼近似然函数的局部极值。尽管EM算法在某些情况下可能收敛到局部最优解,且收敛速度较慢,但它在许多实际应用中,如高斯混合模型、隐马尔可夫模型等,依然是非常有效的工具。

![HTB:Markup[WriteUP]](https://i-blog.csdnimg.cn/direct/a57505e95f5b4bcf9355fa6af0565e37.png)