目录

目录

1. 引言

2. 图像生成模型的发展背景

2.1 生成对抗网络(GAN)

2.2 变分自编码器(VAE)

2.3 自回归模型

2.4 扩散模型

3. Imagen简介

3.1 模型架构

3.2 关键技术

3.3 训练数据与方法

4. Imagen与其他模型的比较

4.1 与DALL·E 2的比较

4.2 与Midjourney的比较

4.3 与Stable Diffusion的比较

5. Imagen的应用场景

6. 限制与挑战

6.1 道德与伦理考虑

6.2 技术局限性

7. 未来发展方向

8. 结论

1. 引言

随着深度学习和人工智能的迅猛发展,生成式模型在图像生成领域取得了令人瞩目的成就。从早期的生成对抗网络(GAN)到最近的扩散模型,研究人员不断探索更为先进的技术,以生成高质量、逼真的图像。谷歌于近期推出的Imagen模型,凭借其卓越的性能和创新的架构,引起了学术界和工业界的广泛关注。本文将深入探讨Imagen模型的原理、与其他主流模型的比较、应用场景,以及其面临的挑战和未来的发展方向。

2. 图像生成模型的发展背景

图像生成模型的发展经历了多个阶段,每个阶段都带来了技术上的突破和应用上的拓展。

2.1 生成对抗网络(GAN)

GAN由Ian Goodfellow等人在2014年提出,采用生成器和判别器的对抗训练方式,实现了从随机噪声中生成逼真图像的能力。GAN的出现开创了生成式模型的新纪元,但其训练过程不稳定,易出现模式崩溃等问题。

2.2 变分自编码器(VAE)

VAE是一种概率生成模型,通过学习数据的隐变量分布,实现数据的生成和重构。VAE在理论上有良好的解释性,但生成的图像质量通常不如GAN。

2.3 自回归模型

如PixelRNN和PixelCNN,通过像素级的自回归方式生成图像。这类模型生成质量高,但生成速度较慢,难以应用于实际场景。

2.4 扩散模型

扩散模型是一类基于概率扩散过程的生成模型,通过逐步去噪,逆转扩散过程来生成数据。近期的研究表明,扩散模型在图像生成质量上可媲美甚至超越GAN。

3. Imagen简介

Imagen是谷歌研究团队推出的一种新的文本到图像生成模型,结合了大型预训练语言模型和扩散模型的优势,实现了高质量、高分辨率的图像生成。

3.1 模型架构

Imagen的架构主要由以下三个部分组成:

- 文本编码器:使用大型预训练语言模型(如T5)对输入的文本进行编码,提取深层次的语义信息。

- 条件扩散模型:在文本编码的条件下,使用扩散模型生成图像。扩散模型通过逐步去噪的方式,从随机噪声生成逼真的图像。

- 级联模型:采用多级扩散模型,逐步提升图像的分辨率,从低分辨率开始,最终生成高分辨率的图像。

3.2 关键技术

- 大型预训练语言模型的融合:Imagen创新性地将大型语言模型与图像生成模型相结合,提高了对复杂文本描述的理解能力。

- 级联扩散模型:通过多级扩散,解决了高分辨率图像生成中的细节保真度问题。

- 优化的损失函数:采用感知损失和对比学习等技术,提升了生成图像的质量和多样性。

3.3 训练数据与方法

Imagen的训练数据由大量的文本-图像对组成,这些数据涵盖了广泛的主题和风格。通过在大规模数据集上进行训练,Imagen学习到了丰富的语义信息和视觉特征。

表1:Imagen训练数据概览

| 数据集名称 | 数据量 | 数据类型 | 主要特征 |

|---|---|---|---|

| LAION-400M | 4亿对 | 文本-图像对 | 多样性高,涵盖广泛主题 |

| 自建数据集 | 数千万对 | 文本-图像对 | 精选高质量数据 |

| 开源数据集整合 | 上亿对 | 文本-图像对 | 包含COCO等知名数据集 |

4. Imagen与其他模型的比较

为了全面了解Imagen的性能和特点,有必要将其与其他主流的文本到图像生成模型进行比较。

4.1 与DALL·E 2的比较

表2:Imagen与DALL·E 2的对比

| 特性 | Imagen | DALL·E 2 |

|---|---|---|

| 模型架构 | 文本编码器 + 级联扩散模型 | CLIP + 先验模型 + 解码器 |

| 文本理解能力 | 强(大型语言模型) | 强(CLIP模型) |

| 图像质量 | 高,细节丰富 | 高,具有创造性 |

| 生成分辨率 | 1024×1024像素 | 1024×1024像素 |

| 开源情况 | 未开源 | 部分开源 |

| 计算资源需求 | 高 | 高 |

| 应用限制 | 需遵守道德规范 | 需遵守道德规范 |

4.2 与Midjourney的比较

表3:Imagen与Midjourney的对比

| 特性 | Imagen | Midjourney |

|---|---|---|

| 模型架构 | 文本编码器 + 级联扩散模型 | 未公开(可能为GAN变体) |

| 文本理解能力 | 强 | 较强 |

| 图像风格 | 写实,风格多样 | 艺术化,富有创意 |

| 用户交互方式 | API调用,需技术支持 | 友好的用户界面,支持对话生成 |

| 开源情况 | 未开源 | 未开源 |

| 应用场景 | 专业领域,需定制化开发 | 广泛,面向大众用户 |

4.3 与Stable Diffusion的比较

表4:Imagen与Stable Diffusion的对比

| 特性 | Imagen | Stable Diffusion |

|---|---|---|

| 模型架构 | 文本编码器 + 级联扩散模型 | 文本编码器 + 扩散模型 |

| 文本理解能力 | 强 | 较强 |

| 图像质量 | 高 | 高 |

| 生成速度 | 较慢 | 较快 |

| 开源情况 | 未开源 | 开源 |

| 社区支持 | 官方支持,社区较小 | 社区活跃,插件丰富 |

| 计算资源需求 | 高 | 较低 |

5. Imagen的应用场景

Imagen在多个领域具有广泛的应用潜力:

- 数字艺术创作:为艺术家和设计师提供灵感,快速生成概念草图和视觉素材。

- 广告与营销:根据产品或服务的描述,生成定制化的广告图像,提高营销效率。

- 游戏与影视:加速游戏场景、角色和道具的设计,节省开发时间。

- 教育与科研:辅助教学,提供可视化的教学材料,促进科研创新。

- 虚拟现实与增强现实:生成逼真的虚拟环境和物体,提升用户体验。

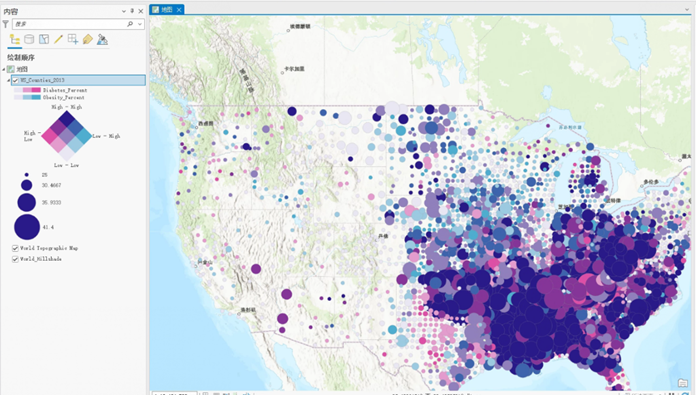

图1:Imagen在不同领域的应用示意图

(此处应有一张展示Imagen应用场景的图表)

6. 限制与挑战

6.1 道德与伦理考虑

- 偏见与歧视:模型可能会学习到训练数据中的社会偏见,导致生成的图像存在种族、性别等方面的歧视。

- 版权与知识产权:生成的图像可能与现有作品相似,涉及版权侵权的风险。

- 滥用风险:可能被用于生成虚假信息、深度伪造等,对社会造成负面影响。

6.2 技术局限性

- 计算资源需求高:训练和运行Imagen需要大量的计算资源,限制了其在普通设备上的应用。

- 细节控制困难:对生成图像的细节进行精确控制仍然具有挑战,需要更先进的控制技术。

- 多模态融合难度:在融合文本、图像、音频等多模态数据时,模型的稳定性和一致性有待提升。

7. 未来发展方向

- 模型优化与轻量化:通过模型剪枝、量化等技术,降低计算资源需求,提升模型的可用性。

- 增强可控性:开发更精细的控制方法,如添加草图、局部编辑等,满足用户的个性化需求。

- 道德规范与监管:建立健全的道德规范和监管机制,确保模型的开发和应用符合社会伦理。

- 开源与社区合作:通过开源促进社区合作,集思广益,加速技术进步。

表5:未来发展方向及预期成果

| 发展方向 | 具体措施 | 预期成果 |

|---|---|---|

| 模型优化与轻量化 | 模型剪枝、蒸馏、量化 | 降低资源需求,提升运行效率 |

| 增强可控性 | 引入条件控制、用户交互设计 | 提高生成结果的精确度和用户满意度 |

| 道德规范与监管 | 建立行业标准、制定法律法规 | 规范模型使用,防止滥用 |

| 开源与社区合作 | 发布开源代码、组织研讨会 | 促进技术交流,推动行业发展 |

8. 结论

Imagen的出现标志着文本到图像生成技术的又一次重大突破。通过融合大型预训练语言模型和扩散模型,Imagen在理解复杂文本描述和生成高质量图像方面取得了显著的进步。尽管仍面临着道德、技术等方面的挑战,但其在艺术创作、商业营销、教育科研等领域展现出的巨大潜力,预示着图像生成技术的光明前景。未来,通过持续的技术创新和规范化发展,Imagen有望在更多领域发挥作用,推动社会进步。