AI目录:sheng的学习笔记-AI目录-CSDN博客

强化学习:sheng的学习笔记-AI-强化学习(Reinforcement Learning, RL)-CSDN博客

K-摇臂赌博机(K-armed bandit):https://blog.csdn.net/coldstarry/article/details/142390324

基础知识

什么是免模型学习

亦称“无模型学习”。在现实的强化学习任务中,环境的转移概率、奖赏函数往往很难得知,甚至很难知道环境中一共有多少状态.若学习算法不依赖于环境建模,则称为“免模型学习”(model-free learning)

在免模型情形下,策略迭代算法首先遇到的问题是策略无法评估,这是由于模型未知而导致无法做全概率展开.此时,只能通过在环境中执行选择的动作,来观察转移的状态和得到的奖赏。

什么是蒙特卡罗强化学习

蒙特卡罗是强化学习中的免模型学习

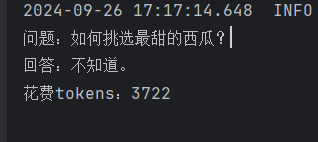

一种直接的策略评估替代方法是多次“采样”,然后求取平均累积奖赏来作为期望累积奖赏的近似,这称为蒙特卡罗强化学习。由于采样必须为有限次数,因此该方法更适合于使用T步累积奖赏的强化学习任务。

策略迭代算法估计的是状态值函数V,而最终的策略是通过状态-动作值函数Q来获得。当模型已知时,从V到Q有很简单的转换方法,而当模型未知时,这也会出现困难。于是,我们将估计对象从V转变为Q,即估计每一对“状态-动作”的值函数。

蒙特卡罗强化学习算法通过考虑采样轨迹,克服了模型未知给策略估计造成的困难。蒙特卡罗强化学习算法的本质,是通过多次尝试后求平均来作为期望累积奖赏的近似,但它在求平均时是“批处理式”进行的,即在一个完整的采样轨迹完成后再对所有的状态-动作对进行更新

这样的速度会比较慢

状态-动作值函数预估

在模型未知的情形下,机器只能是从一个起始状态(或起始状态集合)开始探索环境,而策略迭代算法由于需对每个状态分别进行估计,因此在这种情形下无法实现。例如探索种瓜的过程只能从播下种子开始,而不能任意选择种植过程中的一个状态开始。因此,我们只能在探索的过程中逐渐发现各个状态并估计各状态-动作对的值函数。

在模型未知的情形下,我们从起始状态出发,使用某种策略进行采样,执行该策略T步并获得轨迹

对轨迹中出现的每一对状态-动作,记录其后的奖赏之和,作为该状态-动作对的一次累积奖赏采样值。多次采样得到多条轨迹后,将每个状态-动作对的累积奖赏采样值进行平均,即得到状态-动作值函数的估计

策略改进

同策略和异策略

- 同策略:在执行【策略评估】和【策略提升】的时候,使用的是相同的策略

- 异策略:在执行【策略评估】和【策略提升】的时候,使用的不是相同的策略。

使用蒙特卡罗方法进行策略评估后,同样要对策略进行改进

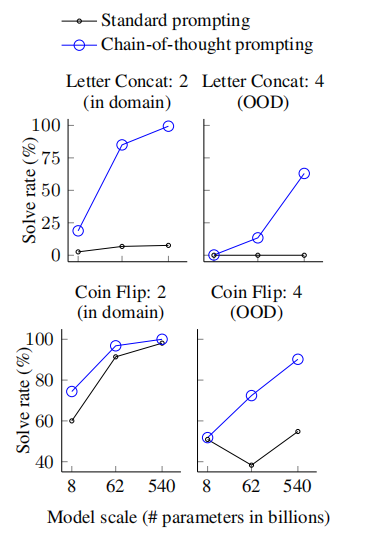

“同策略”(on-policy)蒙特卡罗算法

被评估与被改进的是同一个策略,因此称为“同策略”(on-policy)蒙特卡罗强化学习算法。算法中奖赏均值采用增量式计算,每采样出一条轨迹,就根据该轨迹涉及的所有“状态-动作”对来对值函数进行更新。

“异策略”(off-policy)蒙特卡罗算法

同策略蒙特卡罗强化学习算法最终产生的是![]() -贪心策略。然而,引入

-贪心策略。然而,引入![]() -贪心是为了便于策略评估,而不是为了最终使用;实际上我们希望改进的是原始(非

-贪心是为了便于策略评估,而不是为了最终使用;实际上我们希望改进的是原始(非![]() -贪心)策略。

-贪心)策略。

能否仅在策略评估时引入![]() -贪心,而在策略改进时却改进原始策略呢。

-贪心,而在策略改进时却改进原始策略呢。

基于一个分布的采样来估计另一个分布下的期望,称为重要性采样(importance sampling)。