PROVING TEST SET CONTAMINATION IN BLACK BOX LANGUAGE MODELS

https://openreview.net/forum?id=KS8mIvetg2

验证测试集污染在黑盒语言模型中

文章目录

- 验证测试集污染在黑盒语言模型中

- 摘要

- 1 引言

摘要

大型语言模型是在大量互联网数据上训练的,这引发了人们的担忧和猜测,即它们可能已经记住了公共基准测试。从猜测到证明污染的存在是具有挑战性的,因为专有模型使用的预训练数据通常并不公开。我们展示了一种方法,可以在不访问预训练数据或模型权重的情况下,为语言模型提供可证明的测试集污染保证。我们的方法利用了一个事实,即如果没有数据污染,所有可交换基准测试的排序都应该同样可能。相比之下,语言模型倾向于记忆示例顺序,这意味着一个被污染的语言模型会发现某些规范排序比其他排序更有可能。我们的测试在规范排序的基准测试数据集的可能性显著高于洗牌后的可能性时,标记潜在的污染。我们证明了我们的程序足够敏感,能够在包括只有10亿参数的模型、只有1000个示例的小测试集,以及在预训练语料库中只出现几次的数据集等具有挑战性的情况下,可靠地证明测试集污染。使用我们的测试,我们审计了四种流行的公开可访问的语言模型,以检测测试集污染,并发现很少有普遍污染的证据。

1 引言

大型语言模型(LLMs)在许多自然语言处理基准测试(Wang等人,2019)和专业考试(OpenAI,2023)上取得了显著的进步。这些进步是由在从互联网收集的大量数据集上进行的大规模预训练驱动的。虽然这种范式很强大,但涉及的最少策划导致了对数据集污染的日益关注,预训练数据集包含了各种评估基准。这种污染导致理解语言模型的真实性能变得困难——例如,它们是否只是记住了难题的答案。区分泛化效应和测试集记忆的影响对我们理解语言模型性能至关重要,但随着许多今天部署的语言模型的预训练数据集很少公开,这变得越来越困难。

尽管LLM提供商正在进行工作,从预训练数据集中移除基准,并进行数据集污染研究,但这种过滤可能会因为错误(Brown等人,2020a)而失败,仅限于一组选定的基准(Brown等人,2020a;Wei等人,2021;Chowdhery等人,2022),并且需要信任这些供应商。竞争压力的增加也导致了一些最近的模型发布完全没有污染研究(OpenAI,2023)。这些因素使我们能够审计现有的语言模型,以检测基准数据集的存在,而不需要语言模型提供商的合作。

与污染研究并行,有关启发式成员推断算法的文献越来越多,这些算法试图逆向工程预训练数据集的方面(Carlini等人,2019;Mattern等人,2023),并为测试集污染提供一些证据(Sainz等人,2023;Golchin & Surdeanu,2023)。然而,这些方法的启发式性质限制了它们的有用性,因为这些方法不能将对疑似测试集污染实例的猜测提升为污染的无可辩驳的证据。

在这项工作中,我们展示了如何超越启发式方法,并为黑盒语言模型提供可证明的测试集污染保证。更具体地说,我们提供了一个统计测试,它可以在不访问模型的训练数据或权重的情况下,识别预训练数据集中基准的存在,并提供可证明的误报率保证。

为了实现这些保证,我们利用了许多数据集具有的一个属性,即可交换性,其中数据集中示例的顺序可以洗牌,而不会影响其联合分布。我们的关键洞察是,如果语言模型对数据集的任何特定排序表现出偏好——例如,在公开可用的存储库中出现的规范排序——这违反了可交换性,并且只有在训练期间观察到数据集时才会发生(图1)。

我们利用这一洞察提出了一组测试,比较语言模型在“规范”排序(来自公共存储库)上的对数概率与在洗牌示例数据集上的对数概率,并在两个对数概率在统计上有显著差异时标记数据集。

利用这些想法,我们提出了一个计算效率高且统计强大的测试,用于污染,该测试将数据集分割成更小的片段,并在每个片段内进行一系列对数概率比较。我们证明这种分片测试可以控制误报率,实现计算效率高的并行测试,并显著提高测试对于小p值的统计能力。

我们在一个训练了10亿参数的语言模型上评估了我们的统计测试,该模型在维基百科和一组策划的金丝雀测试集的组合上进行了训练。我们的测试足够敏感,可以识别出只有1000个示例的测试集,有时甚至在预训练语料库中只出现两次。在重复次数更高的情况下,例如数据集出现10次或更多次,我们的测试获得了极小的p值。最后,我们在四种常用的公共语言模型上运行我们的测试,以研究我们的测试在野外语言模型上的行为,并发现很少有普遍和强烈的测试集污染的证据。

我们总结了我们的贡献如下。

• 展示了使用可交换性作为仅使用对数概率查询来可证明地识别测试集污染的方法。

• 构建了一个高效且强大的分片假设测试,用于测试集污染。

• 实证展示了黑盒检测在预训练期间只出现几次的小数据集的污染。

我们的三项贡献表明,黑盒识别测试集污染是可行的,测试能力的进一步改进可能使我们能够定期审计野外的语言模型,以检测测试集污染。为了鼓励开发新的可证明的测试集污染保证,我们将我们的预训练模型作为开发未来统计测试的基准发布。1

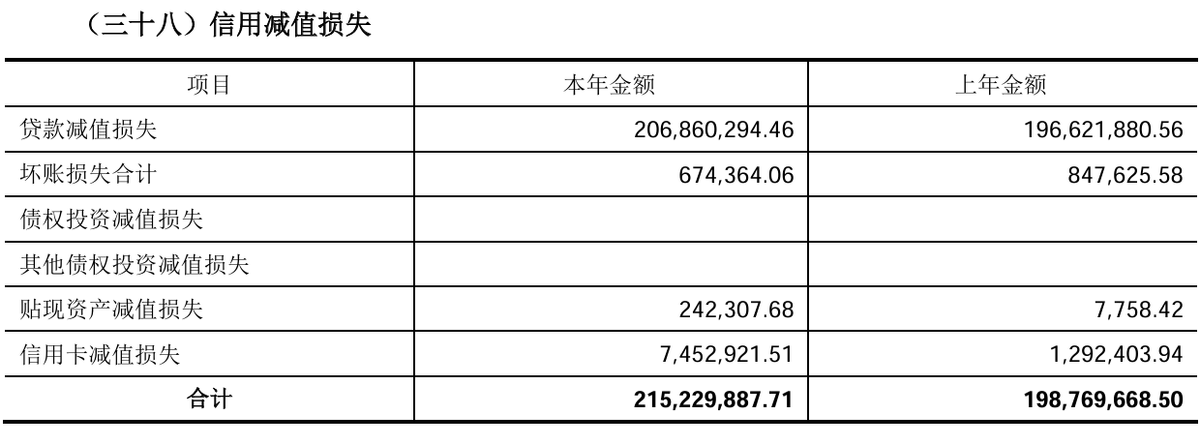

图1:给定一个被BoolQ(Clark等人,2019)测试集污染的预训练数据集(左),我们通过测试数据集的可交换性(右)来检测这种污染。如果模型已经看到了一个基准数据集,它将偏好规范顺序(即示例在公共存储库中给出的顺序)而不是随机洗牌的示例顺序。我们测试这些对数概率的差异,并在整个数据集中汇总它们,以提供误报率保证。