文章目录

- End-to-end reproducible AI pipelines in radiology using the cloud

- 01 研究背景与目的

- 医学成像领域

- (1)研究现状

- (2)存在问题

- 其他研究领域:基因组学(genomics)

- 研究目的:提高医学成像领域的AI研究的可复现性(reproducibility)和可扩展性(scalability)

- 02 研究方法:cloud-based workflow

- Data from Imaging Data Commons(IDC)

- Cloud-based implementation of DL pipelines

- Use Case 1:deep learning for lung cancer prognostication

- Use Case 2:foundation models for quantitative biomarker discovery

- 03 专有名词积累

- metrics

- survival analysis(生存分析)

End-to-end reproducible AI pipelines in radiology using the cloud

论文链接:https://www.nature.com/articles/s41467-024-51202-2

代码仓库:https://github.com/ImagingDataCommons/idc-radiomics-reproducibility/tree/v2.0.0

01 研究背景与目的

医学成像领域

(1)研究现状

- reporting guidelines, checklists and standards

- community-driven: a registry of AI models developed for biomedical applications

(2)存在问题

- 只提供了实验设计的规则,没有提供:a practical way to share AI-based pipelines with the community。

- 缺乏实现的具体信息,包括domain-specific tools、specific software versions、hardware capability

其他研究领域:基因组学(genomics)

- MIAME guidelines

- MCI Genomics Data Commons

研究目的:提高医学成像领域的AI研究的可复现性(reproducibility)和可扩展性(scalability)

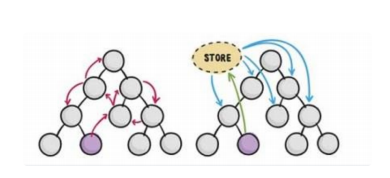

解决办法:cloud-based workflow

通过简化开发流程实现AI算法的快速临床转化。

- democratizing access to large standardized datasets(平等地访问大型标准化数据集)

- free-to-use, easily accessible, consistent computational environments(免费使用、易于访问、一致的计算环境)

02 研究方法:cloud-based workflow

Data from Imaging Data Commons(IDC)

https://datacommons.cancer.gov/repository/imaging-data-commons

- Imaging Data Commons (IDC) 是一个基于云的公共癌症影像数据存储库,它与分析和探索工具以及资源共同位于美国国家癌症研究所 (NCI) 癌症研究数据共享平台 Cancer Research Data Commons (CRDC) 内。IDC 是CRDC的一部分,提供了对大量、全面且不断扩展的癌症研究数据的安全访问。

- 所有由IDC托管的数据都是公开可用的,当前IDC的内容主要来自癌症影像档案库 (The Cancer Imaging Archive, TCIA) 的放射学系列,以及其他主要NCI计划如TCGA、CPTAC、NLST和HTAN收集的数据。

- IDC不执行图像的去标识化(de-identification),但接受由TCIA或其他NCI安全批准的数据协调中心去标识化的数据。

- IDC提供使用数字影像和通信医学 (DICOM) 标准标准化的数据访问。它与生成数据的项目合作,将其他格式的数据协调成DICOM表现形式。IDC的内容不仅包括图像,还包括图像注释和分析结果,并且使用通用标识符与CRDC中的其他类型的癌症数据(如蛋白质组学和基因组学数据集)相关联。数据访问通过标准接口支持。

- 鉴于IDC作为成像数据科学平台的角色,其主要关注点之一是建立成像研究的最佳实践(best practices)。在这方面,IDC的一个关键角色是准备和调整常用的图像分析工具,使其能够在IDC托管的数据集(IDC hosted datasets)上运行的云环境中使用。以前运行分析的总结派生数据(summarized derived data)将与IDC上的影像数据相关联,以方便研究社区使用。

(1)NSCLC-Radiomics collection(LUNG1 dataset)

(2)NSCLC-Radiogenomics collection

Cloud-based implementation of DL pipelines

computing infrastructure:Google Colaboratory (or Colab),Colab是一个免费的云服务,允许用户运行Jupyter笔记本。作者在几个Colab配置(“standard” CPU-only, “high RAM” CPU-only, “free” GPU, and “pro” GPU)下进行测试。

tools:选择open-source and actively developed (or maintained)

- 医学影像准备和DICOM CT数据预处理:Plastimatch、Numpy和SimpleITK(Insight Segmentation and Registration Toolkit的简化开源接口)

- 可视化工具:ITKWidgets

- 影像数据查看器:a browser-based zero-footprint DICOM viewer based on the OHIF viewer,提供了链接到Imaging Data Commons查看器的链接

- 数据传输工具:将云托管的数据传输到Colab实例,作者使用了s5cmd,这是一个跨平台的开源工具

- DICOM文件处理:由于从Imaging Data Commons交叉加载的数据以DICOM格式保存,使用dicomsort工具来自定义排序和重命名DICOM文件,以统一其结构

- 其他DICOM文件操作工具:使用了pydicom和dcmrtstruct2nii等工具来读取、转换或准备DICOM文件

- 评估指标和生存分析:Scipy、Scikitlearn和Lifelines

Use Case 1:deep learning for lung cancer prognostication

任务:分析CT图像上的肿瘤病变来预测结果

原数据集:NSCLC-Radiomics数据集的一个子集(N = 211 for the AUC analysis, N = 307 for the Kaplan–Meier analysis)

数据集更新:同一队列的更新数据集(2020年底更新的临床和随访数据,clinical and follow-up data)

预处理pipeline:IDC data->format suited for deep learning,开源工具实现

模型权重转换:原始模型权重->open nerual network exchange(ONNX)

评价指标:area under the receiver operating characteristic curve(AUC)、receiver operating characteristic (ROC)、双侧Mann-Whitney U检验、DeLong检验配对AUC曲线、Kaplan-Meier(KM)、Cox比例风险(PH)建模

Use Case 2:foundation models for quantitative biomarker discovery

任务:自监督训练的基础模型是否可以提高基于深度学习的成像生物标志物的发展

03 专有名词积累

metrics

ROC:receiver operating characteristic

AUC:area under the receiver operating characteristic curve,用于评估分类模型的性能

survival analysis(生存分析)

Kaplan–Meier (KM) analysis,用于估计生存函数和生存曲线

Cox Proportional Hazard (PH) modeling,一种用于生存分析的回归模型,用于评估多个因素对生存时间的影响