文章目录

- 0、摘要

- 1、介绍

- 2、相关工作

- 2.1 用于时间序列预测的Transformers

- 2.2 用于时间序列预测的 RNN、MLP 和 CNN 模型

- 3、模型结构

- 3.1 令牌化

- 3.2 CARD 注意力胜过token

- 3.3 CARD 注意力胜过渠道

- 3.4 token 混合模块

- 4、基于信号衰减的损失函数

- 5、实验

- 5.1 长期预测

- 5.2 基于重建的异常侦探

- 5.3 基于信号衰减的增强效果Loss函数

- 5.4 输入序列长度的影响

- 5.5 TOKEN 混合大小的影响

- 5.6 我们的实验

- 6、总结和未来工作

CARD: CHANNEL ALIGNED ROBUST BLEND TRANS

FORMER FOR TIME SERIES FORECASTING

标题: 卡片:用于时间序列预测的通道对齐坚固的混合Transformer

实验室环境:RTX 4090

文章链接:https://arxiv.org/abs/2305.12095

0、摘要

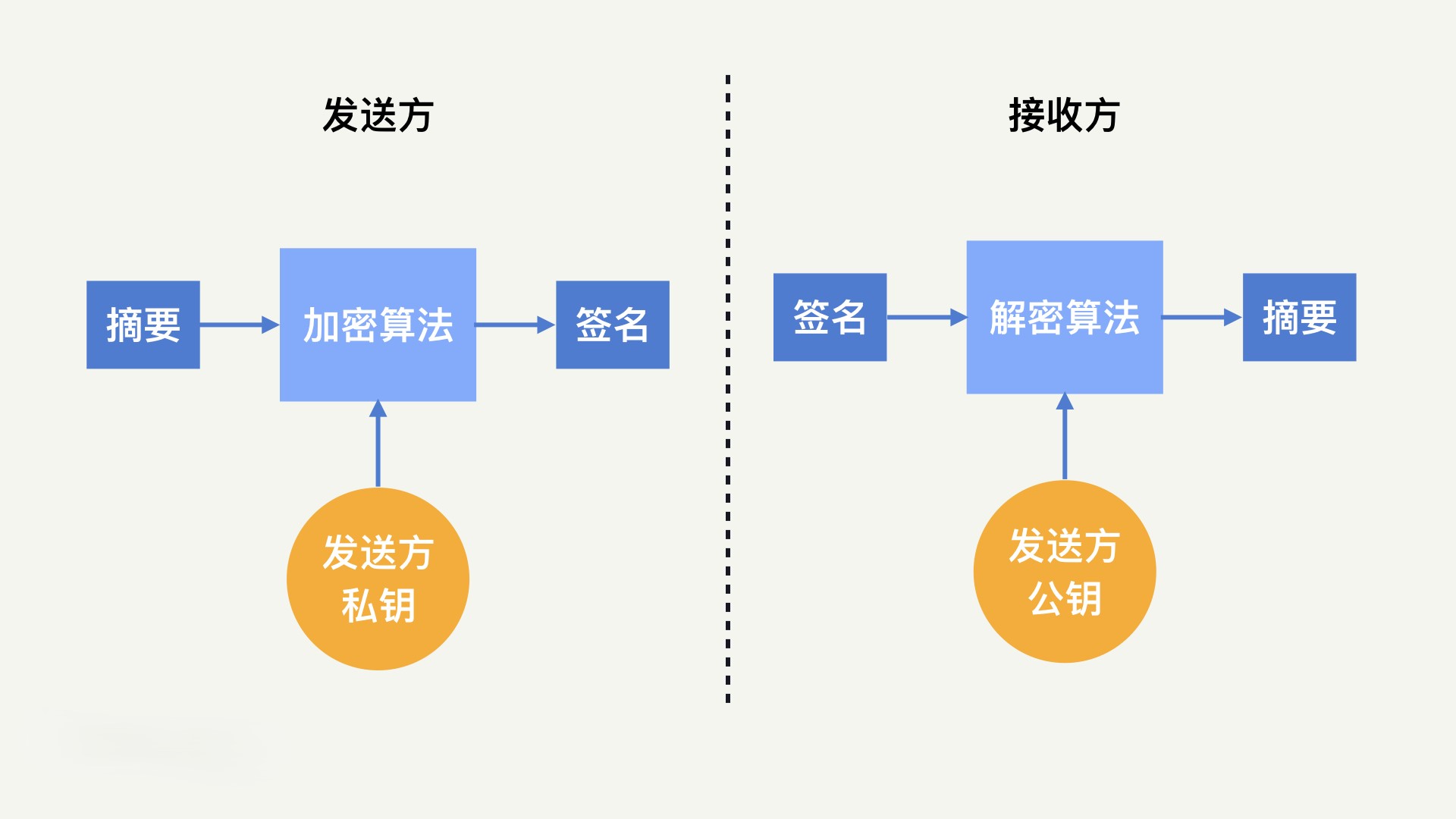

- 最近的研究表明,Transformer 模型在时间序列预测方面具有强大的功能。导致 transformer 成功的关键因素之一是用于提高训练鲁棒性的通道无关 (CI) 策略。然而,对 CI 中不同渠道之间相关性的无知会限制模型的预测能力。在这项工作中,我们设计了一个特殊的 Transformer,即 Channel Aligned Robust Blend Transformer(简称 CARD),它解决了 CI 型 Transformer 在时间序列预测中的关键缺点。首先,CARD 引入了一种通道对齐的注意力结构,

使其能够捕获信号之间的时间相关性和多个变量随时间推移的动态依赖性。其次,为了有效地利用多尺度知识,我们设计了一个 token blend 模块来生成不同分辨率的 token。第三,我们引入了一个用于时间序列预测的稳健损失函数,以缓解潜在的过拟合问题。这个新的损失函数对基于预测不确定性在有限范围内进行预测的重要性进行了加权。我们对多个长期和短期预测数据集的评估表明,CARD 的性能明显优于最先进的时间序列预测方法。

1、介绍

- 时间序列预测已成为云计算、空气质量预测、能源管理和交通流量估计等各个领域的关键任务 。深度学习模型的快速发展导致了时间序列预测技术的重大进步,尤其是在多变量时间序列预测方面。在为时间序列预测开发的各种深度学习模型中,基于 RNN、CNN、MLP、transformer 和 LLM 的模型由于能够捕获复杂的长期时间依赖关系而表现出出色的性能 。对于多变量时间序列预测,模型有望通过利用不同预测变量之间的依赖关系,即所谓的通道相关 (CD) 方法,从而产生更好的性能。然而,最近的多项工作表明,一般来说,通道无关 (CI) 预测模型(

即所有时间序列变量都是独立预测的)优于 CD 模型。 分析表明,CI 预测模型更稳健,而 CD 模型具有更高的建模能力。鉴于时间序列预测通常涉及高噪声水平,采用 CD 设计的典型基于 transformer 的预测模型可能会遇到过拟合噪声的问题,从而导致性能受限。这些实证研究和分析提出了一个重要问题,即如何构建一个有效的转换器来利用跨通道信息进行时间序列预测。

通道相关 (CD)

通道无关 (CI)

- 在本文中,我们提出了一种通道对齐鲁棒混合转换器,简称 CARD,它有效地利用了通道之间的依赖关系(即预测变量),并缓解了时间序列预测中过拟合噪声的问题。与时间序列的典型变压器不同,分析仅通过对标记的关注来捕获信号之间的时间依赖性,CARD 还跨不同渠道和隐藏维度进行关注,从而捕获预测变量之间的相关性并对齐每个标记内的局部信息。我们观察到相关方法已在计算机视觉中得到开发 。此外,众所周知,多尺度信息在时间序列分析中起着重要作用。我们设计了一个 token blend 模块来生成不同分辨率的 token。特别是,我们建议将同一头部内的相邻 token 合并到新 token 中,而不是在多头注意力中合并不同头部的相同位置。为了提高 transformer 对时间序列预测的鲁棒性和效率,我们在 queries/keys tokens 上进一步引入了一个指数平滑层和一个动态投影模块,当处理不同通道之间的信息时。最后,为了缓解过拟合噪声的问题,在有限范围内进行预测的情况下,引入了一个稳健的损失函数,以根据其不确定性对每个预测进行加权。整个模型架构如图 1 所示。我们通过与 Transformers 和其他模型的最新方法进行比较,验证了所提出的模型在各种数值基准上的有效性。在这里,我们总结了我们的主要贡献如下。

- Crossformer 中使用的层次结构。这些设计显著提高了 CARD 的稳健性,并导致数值性能的大幅提高

- 我们提出了一种通道对齐鲁棒混合变压器 (CARD),它可以高效、稳健地对齐不同通道之间的信息并利用多尺度信息。

- CARD在用于预测和其他基于预测的任务的多个基准数据集中表现出卓越的性能,优于最先进的模型。我们的研究证实了所提出的模型的有效性。

- 我们开发了一个强大的基于信号衰减的损失函数,它利用

信号衰减来增强模型专注于预测不久的将来的能力。我们的实证评估证实,这种损失函数也有效地提高了其他基准模型的性能

- 本文的其余部分结构如下。

- 在第 2 节中,我们提供了与我们的研究相关的相关工作的摘要。

- 第 3 节介绍了拟议的详细模型架构。

- 第 4 节描述了损失函数设计,并通过高斯分布和拉普拉斯分布的最大似然估计进行了理论解释。

- 在第 5 节中,我们展示了预测基准的数值实验结果,并进行了综合分析,以确定自我注意方案对时间序列预测的有效性。此外,我们还讨论了本研究中进行的消融和其他实验。

- 最后,在第 6 节中,讨论了结论和未来的研究方向

2、相关工作

2.1 用于时间序列预测的Transformers

- 近年来,有大量工作试图应用 Transformer 模型来预测长期时间序列 。我们在这里总结了其中的一些。Log Trans 使用具有 Log Sparse 设计的卷积自注意力层来捕获局部信息并降低空间复杂性。Informer 提出了一种带有蒸馏技术的 Prob Sparse 自我注意,以有效地提取最重要的键。Auto former从传统的时间序列分析方法中借用了分解和自相关的思想。FED former 使用傅里叶增强结构来获得线性复杂性。Pyra former 应用了具有尺度间和尺度内连接的金字塔注意力模块,这也获得了线性复杂性。Log Trans 避免了 key 和 query 之间的逐点点积,但其值仍然基于单个时间步。Auto former 使用自相关来获得 patch 级连接,但它是一种手工制作的设计,不包含 patch 中的所有语义信息。最近的一项工作 Patch TST 使用视觉变压器类型模型进行长期预测,采用独立于通道的设计。最接近我们提出的方法的工作是Crossformer 。

这项工作利用层次结构注意力机制设计了一个编码器-解码器模型,以利用跨维度依赖关系,并在我们在这项工作中使用的相同基准数据集中实现了中等性能。从模型架构的角度来看,与 Crossformer 不同,我们采用纯编码器结构,多尺度信息通过轻量级 token blend 模块诱导,而不是显式生成 toke

2.2 用于时间序列预测的 RNN、MLP 和 CNN 模型

- 除了Transformer,其他类型的网络也被广泛探索。 研究 RNN状态空间模型。特别是,(Smyl,2020 年)考虑为 RNN 配备指数平滑度,并首次在预测任务中击败了统计模型 。 探索了用于时间序列预测的 MLP 型结构。CNN 模型 使用时间卷积层来提取子序列级别的信息。在处理多变量预测任务时,假设相邻协变量的平滑度或使用通道无关策略。

3、模型结构

- CARD 的架构图示如图 1 所示。设 a t ∈ R C a_t∈ R^C at∈RC 是通道 C ≥ 1 的时间序列在时间 t 的观测值。我们的目标是使用 L 个最近的历史数据点(例如, a t − L + 1 , . . . , a t a_{t−L+1},...,a_t at−L+1,...,at)来预测未来的 T 步观察值。(例如, a t + 1 , . . . , a t + T _{at+1},...,a_{t+T} at+1,...,at+T),其中 L,T ≥ 1。

3.1 令牌化

-

我们采用了修补的想法 将输入的时间序列转换为标记张量。让我们将 A = [ a t − L + 1 , . . . , a t ] ∈ R C × L A =[a_{t−L+1},...,a_t] ∈ R^{C× L} A=[at−L+1,...,at]∈RC×L表示为输入数据矩阵,S 和 P 分别表示步幅和补丁长度。我们将矩阵 A 展开为原始标记张量 X ^ ∈ R C × N × P \hat X ∈R^{C×N×P} X^∈RC×N×P,其中 N = ⌊(L−P)/S +1⌋。在这里,我们将时间序列转换为几个 P 长度的片段,每个原始 token 都保留了一部分序列级语义信息,这使得注意力方案比原版的逐点对应物更有效。

-

然后,我们使用密集的 MLP 层 F1 : P → d,额外的 toke

T 0 ∈ R C × d T_0 ∈ R^{C× d} T0∈RC×d和位置嵌入 E ∈ R C × N × d E∈R^{C×N×d} E∈RC×N×d 生成标记矩阵,如下所示: X = [ T 0 , F 1 ( X ^ ) + E ] X=[T_0,F1(\hat X)+E] X=[T0,F1(X^)+E] -

其中 X ∈ R C × ( N + 1 ) × d X ∈ R^{C×(N+1)×d} X∈RC×(N+1)×d和 d 是隐藏维度。与 相比,我们的token 构建引入了一个额外的 T 0 T_0 T0 token。T0 token 类似于中的静态协变量编码器,并允许我们有一个地方来注入总结该系列较长历史的特征。我们考虑通过标记张量 X 的线性投影生成 Q、K 和 V:

-

Q = F q ( X ) , K = F k ( X ) , V = F v ( X ) Q=F_q(X),K =F_k(X),V =F_v(X) Q=Fq(X),K=Fk(X),V=Fv(X),(2)其中 Q , K , V ∈ R C × ( N + 1 ) × d Q,K,V ∈ R^{C×(N+1)×d} Q,K,V∈RC×(N+1)×d和 F q , F k , F v F_q,F_k,F_v Fq,Fk,Fv是 MLP 层。

-

(2) 接下来我们将 Q,K,V 转换为 {Qi},{Ki},{Vi},其中 Q i , K i , V i ∈ R C × ( N + 1 ) × d h e a d Q_i,K_i,V_i ∈ R^{C× (N+1)× d_{head}} Qi,Ki,Vi∈RC×(N+1)×dhead,i = 1,2,…,H. H 和 dhead 分别是头数和头尺寸。对于每个样本,令牌总数为 C(N + 1)。为了充分利用所有跨通道信息,理想的关注应该是 ( C 2 ( N + 1 ) 2 ) (C^2(N + 1)^2) (C2(N+1)2) 计算成本,这可能非常耗时,并且在训练样本量有限时可能导致容易过拟合。在本文中,我们考虑交替关注每个维度

3.2 CARD 注意力胜过token

- 当关注标记时,我们将通道维度上的 Q i 、 K i 和 V i Q_i、K_i 和 V_i Qi、Ki和Vi 切分为 { Q i c : Q_i^{c:} Qic: } , { K i C : K_i^{C:} KiC: } 和 { V i c : V_i^{c:} Vic: }∈ R ( N + 1 ) × d h e a d R^{(N+1)×dhead} R(N+1)×dhead 和 c = 1,2,…,C。除了 Tokens 中的标准 attention 之外,我们还在 hidden dimensions 中引入了额外的 attention 结构,这有助于捕获每个补丁中的本地信息。标记和隐藏维度中的注意力计算如下:

- EMA 表示指数移动平均线。通过在 {

Q

i

c

:

Q_i^{c:}

Qic: } , {

K

i

C

:

K_i^{C:}

KiC: } 上应用 EMA,每个查询令牌将能够在更多关键令牌上获得更高的关注分数,因此输出变得更加稳健。(马等人,2023 年)和(Woo 等人,2022 年)也探讨了类似的技术。与文献中的内容不同,我们发现使用在所有维度上都保持不变的 EMA 参数足以稳定训练过程。因此,我们的 EMA 不包含可学习的参数。输出计算为:

用提议的 token blend 模块来合并头部并生成捕获多尺度知识的 token,详细讨论推迟到第 3.4 节。批量标准化(Ioffe & Szegedy,2015)到 O i 1 C : O_{i1}^{C:} Oi1C:和 O i 2 C : O_{i2}^{C:} Oi2C:然后用于调整输出的比例。最后,使用残差连接结构生成注意力块的最终输出。每个通道的标记总数约为 O(L/S) 量级,并且沿标记的注意力复杂度上限为 O( C ⋅ d 2 ⋅ L 2 / S 2 C·d^2·L^2/S^2 C⋅d2⋅L2/S2),其小于 O( C ⋅ d 2 ⋅ L 2 C·d^2·L^2 C⋅d2⋅L2) 的复杂度。在实践中,可以使用高效的注意力实现(例如,FlashAttention Dao et al. 2022)来进一步获得近线性的计算性能。

3.3 CARD 注意力胜过渠道

- 协变量的潜在高维性问题,vanilla 方法可能会受到计算开销和过拟合的影响。以流量数据集 (PeMS) 为例,该数据集包含 862 个协变量。当将回溯窗口大小设置为 96 时,通道上的关注将需要至少 80 倍于标记的关注的计算成本。全神贯注还会将大量噪声模式合并到输出标记中,并导致最终预测结果中出现虚假相关性。在本文中,我们考虑使用动态投影技术 将第 n 个标记维度的 “汇总 ”标记获取到

K

i

:

n

K_i^{:n}

Ki:n 和

v

i

:

n

v_i^{:n}

vi:n 的标记,如图 2 所示。我们首先使用 MLPlayers

F

p

k

F_{pk}

Fpk 和

F

p

v

F_{pv}

Fpv 将头部尺寸从 dhead 投影到某个具有 r ≪ C 的固定 r,然后使用 softmax 对投影的张量

P

k

:

n

P_k^{:n}

Pk:n 和

P

v

:

n

P_v^{:n}

Pv:n 进行标准化

3.4 token 混合模块

-

多尺度知识在预测任务中起着至关重要的作用,并显著提高了不同模型的性能。 。这些工作中的大多数最初将时间序列分解为季节性和趋势分量,然后采用单独的结构来单独处理季节性和趋势分量。然而,这种方法尽管简单,但会导致更高的模型复杂度,这反过来又增加了计算成本,使其容易出现过拟合问题。在这项工作中,我们考虑使用一种专门设计的 token 混合机制来利用多尺度结构知识,而无需额外的计算成本。token blend 模块通过合并同一头中的相邻 token 来替换多头注意力后的标准 token 重建,以生成下一阶段的 token。来自多头注意力的输出标记张量 O 具有形状为 C ×H ×(N +1)×d_head 的 4-D。token blend 模块将首先合并第二维和第三维,并将 O 重塑为形状为 C × H(N + 1) × d_head 的三维张量。然后,我们将第二个维度解耦为三个维度,即 H(N + 1) → h1 × h2 × h3

-

h1 = Hh3,h2 = N +1and h3 ≥1.T最终结果 O 使用 h3 × h1× d_head 来构造标记维度。这里我们称 h3 为混合大小。当 h3 = 1 时,上述操作在标准Transformer中产生相同的输出。当 h3 ≥ 2 时,输出将首先将相邻的 token 组合在同一个 head 中,这将创建在更大范围内(即较低分辨率)表示知识的 token。随着混合大小 h3 的增加,相同头部内的更多 Token 被合并,下一阶段的注意力模块可能有更多机会捕获长期知识。图 3 显示了一个图示示例。通过将时间上相邻的标记合并到同一个 head 中,生成的新标记包含了较长时间段内的知识。通过增加对这些标记的关注,可以更有效地探索低分辨率知识。我们的token混合模块也不同于(张和燕,2023年)中的分层相邻代币合并程序。首先, 在词元级别合并,粗略层次的输出词元序列具有更高的隐藏维度和更短的序列长度。我们考虑在 head 级别进行合并,以保持相同的输出标记序列形状。其次,(张和燕,2023)中的合并大小固定为2,而我们允许更灵活的配置。因此,我们实现了一个隐式结构,该结构增强了多尺度信息的提取,而无需额外的显式信号解缠过程

4、基于信号衰减的损失函数

-

在本节中,我们将讨论我们的损失函数设计。在文献中,均方误差 (MSE) 损失通常用于衡量预测结果与地面实况观测值之间的差异。设 a ^ t + 1 ( A ) , . . . . , ˆ a t + L ( A )和 a t + 1 ( A ) , . . . . , a t + L ( A ) \hat a_{t+1}(A),...., ˆ a_{t+L}(A) 和 a_{t+1}(A),....,a_{t+L}(A) a^t+1(A),....,ˆat+L(A)和at+1(A),....,at+L(A) 是给定历史信息 A 从时间 t + 1 到 t + L 的预测和实际误差。总体目标损失变为

-

预测任务的普通 MSE 损失的一个缺点是不同时间步长的误差权重相等。在实际实践中,历史信息与远未来观测的相关性通常小于与近未来观测的相关性,这意味着远未来观测具有更高的方差。因此,近期损失比远未来损失对泛化改善的贡献更大。为了看到这一点,我们假设我们的时间序列遵循一阶马尔可夫过程,即 a t + 1 ∼ N ( G ( a t ), σ 2 I ) a_{t+1} ∼ N(G(a_t),σ^2I) at+1∼N(G(at),σ2I),其中 G 是 Lipschitz 常数为 1、σ > 0 且 t = 1,2 的平滑过渡函数,…那么,我们有

- 其中,方程 (12) 可以通过方程 (11) 推导出来,用拉普拉斯分布代替高斯分布

5、实验

5.1 长期预测

-

数据集 :我们在七个真实世界的基准上进行了实验,包括四个电变换温度 数据集 ,包括两个每小时和两个 15 分钟的数据集、一个 10 分钟天气预报数据集 、一个每小时用电量数据集 和一个每小时交通道路占用率数据集 。

-

基线和实验设置 我们使用以下最近流行的模型作为基线:FED former 、ETSformer 、FilM 、LightTS , MICN 、TimesNet 、Dlinear 、Crossformer 和 PatchTST 。我们使用 Wu et al., 2023b中的实验设置应用可逆实例归一化 来处理数据异质性,并将回溯长度保持在 96 以进行公平比较。每个设置重复 10 次,并报告平均 MSE/MAE 结果。附录中的表 7 总结了完整的结果。有关模型配置、模型代码以及与其他早期基线比较的更多详细信息,可分别在附录 D 和附录 B 中找到。

-

结果 结果总结于表 1 中。关于四个不同输出范围的平均性能,CARD 在 MSE 和 MAE 中分别在 7 分中的 6 分和 7 分中的 7 分获得最佳性能。在单长度实验中,CARD 在 MSEmetric 中为 82% 的案例,在 MAE 指标中为 100% 的案例中取得了最佳结果。

-

对于具有复杂协变量结构的问题,所提出的 CARD 方法明显优于基准。例如,在电力(321 个协变量)中,CARD 在每个预测范围实验中平均将 MSE/MAE 降低了 9.0% 以上,始终优于第二好的算法。通过利用 21 个协变量来计算 Weather,利用 862 个协变量来计算 Traffic,我们将 MSE/MAE 大幅降低了 7.5% 以上。这凸显了 CARD 整合大量协变量信息以改善预测结果的卓越能力。此外,Crossformer 采用了整合跨渠道数据的类似概念,以提高预测准确性。值得注意的是,与 Crossformer 相比,CARD 显着降低了 MSE/MAE 超过 20%on 6 benchmark 数据集,这表明我们的注意力设计在利用跨渠道信息方面要有效得多。同样重要的是要注意,虽然 Dlinear 在使用基于 MLP 的模型在这些任务中表现出强大的性能,但 CARD 仍然在所有基准数据集中始终如一地将 MSE/MAEby降低 5% 到 27.5%。最近的工作,如 Nie et al. 2023;Zeng 等人,2023 年;Zhang & Yan 2023)使用96以外的输入长度,并显示出性能提升。在我们的研究中,我们还在附录 G 中报告了具有不同回溯长度的 CARD 的数值性能,并且在延长输入序列时,CARD 的性能也始终优于所有基线模型,表明所有基准数据集中的 MSE 误差都显著降低

5.2 基于重建的异常侦探

基于重建的异常检测可以被视为预测输入本身的任务。在以前的工作中,重建是无监督逐点表示学习的经典任务,其中重建误差是一个自然的异常标准。我们遵循 (Wu et al., 2023a) 中的实验设置,并考虑五个广泛使用的异常检测基准。结果总结在表 2 中。CARD 在 F1 分数上平均比现有的最佳成绩高出 3%。在 7 篇发表在 ICLR2024 会议论文中

5.3 基于信号衰减的增强效果Loss函数

- 在本节中,我们介绍了 基于信号衰减的增强效果Loss函数。与以往长期序列预测模型训练中广泛使用的MSEloss函数相比,我们的方法在最近的最先进基线模型(包括Transformer、CNN和MLP架构)中从3%减少到12%,如表3所示,我们提出的损失函数专门赋予了FEDformer和Autoformer两种算法,这两种算法严重依赖于频率域信息。这与我们的 signal decay paradigm 一致,它承认 frequency in formation sacross time horizons带来了方差/噪声。我们的nove lloss函数可以被认为是这个任务的首选,由于它的优越性能比较于普通MSElossfunction。

5.4 输入序列长度的影响

- 前一项研究(Zengetal.,2023;Wenetal.,2023b)强调了与现有长期预测变压器的关键问题。他们努力利用扩展的输入序列,导致随着输入长度的增加而性能下降。我们断言这不是变压器的固有缺点,并且 CARD 在处理更长和更嘈杂的历史序列输入中证明了稳健性,作为证据dbyan8.6%和 8.9%减少在 MSE实现了当输入长度从 96 扩展到 720 时,ETTh1 和 ETTm1 数据集分别显示,如表 4 所示

5.5 TOKEN 混合大小的影响

- 在本节中,我们将通过改变混合大小来测试 token 混合模块的效果。结果总结在图 4 中。当将混合大小设置为 1 时,token混合模块减少到 Transformer 文献中的标准令牌混合方法,我们观察到 MSE/MAE 增加中的测试错误。当使用更大的混合尺寸时,会利用多尺度信息,并反过来减少误差。但是,在某些情况下,进一步增加混合大小可能会损害性能。我们推测,由于数据集的性质,只有一些知识尺度对预测有用。较高的混合大小可能会过度平滑该知识。

5.6 我们的实验

- 我们进行了一系列实验,使用消融和架构变体,以评估我们提议的模型中的每个组件。我们的研究结果表明,通道分支对减少 MSE 错误做出了最大的贡献,如附录 Q.2 所示。此外,我们在附录 Q.1 中详述的序列/并行注意力混合设计的实验表明,我们的模型设计是首选。视觉辅助工具和注意力图可以在附录 A 和 O 中找到,它们有效地展示了我们对协变量信息的准确预测和利用。附录 R.2 中介绍了另一个值得注意的实验,关于训练数据大小的影响。这项研究表明,使用 70% 的训练样本可以显著提高受分布偏移影响的一半数据集的性能。此外,附录 L 还提供了一个误差线统计表,证明了 CARD 的稳健性。附录 H 和 I 中介绍了 M4 的更多预测实验(Makridakis et al., 2018)其他数据集

6、总结和未来工作

- 在本文中,我们提出了一种用于时间序列预测的新型 Transformer 模型 CARD。CARD 是一个通道相关模型,可有效地调整不同变量和隐藏维度的信息。CARD 通过同时关注 tokens 和 channel 来改进传统的 transformers。注意力机制的新设计有助于探索每个 Token 中的局部信息,使其对时间序列预测更加有效。我们还提出了一个 token blend 模块,以利用时间序列中的多尺度信息知识。此外,我们引入了一个稳健的损失函数来缓解过拟合噪声的问题,这是时间序列分析中的一个重要问题。正如通过各种数值基准所证明的那样,我们提出的模型优于最先进的模型。