人工智能咨询培训老师叶梓 转载标明出处

如何让机器更好地理解和执行人类的指令一直是一个重要课题。Google的研究团队中提出了一种新的方法,通过指令微调(instruction finetuning)来提升语言模型的性能和泛化能力。

他们主要研究了如何通过扩展任务数量、模型规模以及在链式思考(chain-of-thought)数据上进行微调,来提升预训练语言模型在未见任务上的表现。研究结果表明,这种方法在多个模型类别(如PaLM、T5、U-PaLM)和不同的提示设置(zero-shot、few-shot、CoT)下都取得了显著的性能提升。

论文链接:https://arxiv.org/pdf/2210.11416

项目链接:https://huggingface.co/docs/transformers/model_doc/flan-t5

Flan指令微调方法

研究者们扩展了微调任务的数量,通过结合先前研究中的四种任务混合——Muffin、T0-SF、NIV2和CoT——达到了1,836个微调任务。Figure 2 展示了这些任务的分布。Muffin混合包括了80个任务,其中62个来自Wei等人(2021)的研究,新增了26个任务,包括对话数据和程序合成数据。T0-SF混合(193个任务)由Sanh等人(2021)的研究中不与Muffin重叠的任务组成。NIV2混合(1554个任务)由Wang等人(2022c)的研究中的任务组成。

研究者们在多种模型家族上应用了指令微调,包括T5、PaLM和U-PaLM,这些模型家族涵盖了从Flan-T5-small(8000万个参数)到PaLM和U-PaLM(540亿参数)的一系列规模。每个模型都采用了相同的训练过程,除了一些关键的超参数:学习率、批量大小、dropout和微调步骤。研究者们使用恒定的学习率计划,并使用Adafactor优化器进行微调。Table 2 显示了不同模型在指令微调中使用的计算量相对于预训练的百分比。

研究者使用了多个不同的基准测试来评估模型的世界知识和推理任务的能力,包括MMLU、BBH、TyDiQA和MGSM。对于MMLU和BBH,他们评估了直接提示和链式思考(CoT)提示的能力。对于TyDiQA,他们只测量直接提示的精确匹配分数。对于MGSM,他们只测量CoT提示的准确性。Figure 4 展示了模型大小和微调任务数量对保留基准测试的归一化平均值的影响。

想要掌握如何将大模型的力量发挥到极致吗?叶老师带您深入了解 Llama Factory —— 一款革命性的大模型微调工具。9月22日晚,实战专家1小时讲解让您轻松上手,学习如何使用 Llama Factory 微调模型。

加助理微信提供直播链接:amliy007,29.9元即可参加线上直播分享,叶老师亲自指导,互动沟通,全面掌握Llama Factory,关注享粉丝福利,限时免费CSDN听直播后的录播讲解。

LLaMA Factory 支持多种预训练模型和微调算法。它提供灵活的运算精度和优化算法选择,以及丰富的实验监控工具。开源特性和社区支持使其易于使用,适合各类用户快速提升模型性能。

扩展模型规模和微调任务数量对未见任务性能的影响

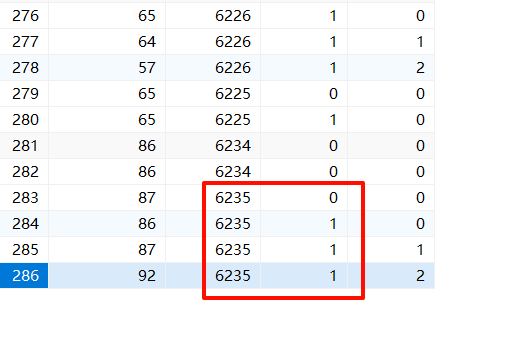

研究者通过在不同规模的PaLM模型上进行实验,包括8B、62B和540B,来扩展模型规模。同时,通过顺序添加任务混合,从最少任务的混合到最多任务的混合,来扩展微调任务的数量。研究结果表明,多任务指令微调显著提高了与未微调模型相比的性能,性能提升范围从9.4%到15.5%。

研究者们发现,增加微调任务的数量可以提高性能,尽管大部分性能提升来自于使用多达282个任务。增加模型规模一个数量级(例如,从8B到62B或从62B到540B)显著提高了微调和非微调模型的性能。这些发现表明,未来的研究应继续扩展指令微调的规模。

Table 3 汇总了增加微调任务数量对Flan-PaLM在大多数评估基准上性能的影响。这些评估基准包括MMLU(57个任务)、BBH(23个任务)、TyDiQA(8种语言)和MGSM(10种语言)。所有基准测试的评估指标都是少样本提示准确性(精确匹配),通过对所有任务进行未加权平均来计算。研究者们报告了MMLU-直接、MMLU-CoT、BBH-直接、BBH-CoT、TyDiQA和MGSM的归一化平均值。这些评估基准是保留的(未包括在微调数据中)。

在指令微调过程中加入链式思考数据的影响

链式思考是一种推理方法,它要求模型在给出最终答案之前,展示其推理过程。研究的主要目的是验证Flan-PaLM模型在包含CoT数据的微调后,是否在多步推理任务上超越了以往的模型。

在微调混合中加入带有CoT注释的九个数据集,能够提升模型的推理能力。Table 4 显示,Flan-PaLM在四个未见评估基准测试上的表现超过了PaLM。特别是在MMLU基准测试中,Flan-PaLM 540B达到了75.2%的准确率,这一表现不仅超过了PaLM模型,也超过了其他一些先进的模型,如code-davinci-002和Chinchilla。

将CoT提示与自我一致性(Self-Consistency, SC)结合起来,可以在多个基准测试上达到新的最佳性能。例如,在多语言数学问题基准测试MGSM上,Flan-PaLM结合CoT和SC在包括孟加拉语在内的多种语言上都取得了显著的性能提升。

研究者们对只包含九个CoT数据集的指令微调效果进行了消融研究。他们将评估分为CoT基准测试(MMLU、BBH和MGSM)和非CoT基准测试(MMLU、BBH和TyDiQA),并计算了CoT和非CoT的归一化平均值。Figure 5 显示,与仅进行CoT微调相比,结合非CoT和CoT进行微调可以在CoT基准测试上获得更好的性能。同时,结合CoT和非CoT的微调并没有损害非CoT任务的性能。

对CoT数据进行指令微调(无论是否带有示例)的另一个好处是,得到的模型能够在零样本设置中执行CoT推理。这对于测试模型在没有少量样本示例的情况下产生自身推理能力的能力非常重要。Figure 6 展示了在23个未见的、具有挑战性的BIG-Bench任务(BBH)上,Flan-PaLM模型可以通过利用“让我们逐步思考”这一短语激活的CoT推理来获得改进的性能。相比之下,未经微调的PaLM模型并不能生成使其能够解决这些问题的CoT。

对CoT数据进行指令微调(无论是否带有示例)的另一个好处是,得到的模型能够在零样本设置中执行CoT推理。这对于测试模型在没有少量样本示例的情况下产生自身推理能力的能力非常重要。Figure 6 展示了在23个未见的、具有挑战性的BIG-Bench任务(BBH)上,Flan-PaLM模型可以通过利用“让我们逐步思考”这一短语激活的CoT推理来获得改进的性能。相比之下,未经微调的PaLM模型并不能生成使其能够解决这些问题的CoT。

Figure 7 展示了Flan-PaLM在包含CoT数据的混合中微调后,在未见任务中解锁零样本CoT推理的能力。这些例子来自三个BIG-Bench任务。可以看到,Flan-PaLM能够在没有经过微调的PaLM模型失败的任务上,通过逐步思考给出正确的答案。

研究表明,通过在指令微调中加入CoT数据,可以显著提升模型在多步推理任务上的性能,并且这种微调方法在未见任务上也能保持其推理能力。这种微调还解锁了模型在零样本设置中的推理能力,这对于构建能够处理复杂任务的通用语言模型具有重要意义。

通过指令微调提升不同规模、架构和训练目标的多种模型的普遍性

除了PaLM模型家族外,研究者们还对具有编码器-解码器架构的T5模型进行了指令微调,与PaLM的仅解码器架构形成对比。研究者们还对扩展版的PaLM 62B模型(cont-PaLM)和在PaLM-540B基础上进一步预训练了20k步的U-PaLM模型进行了指令微调。

Table 5 展示了指令微调对所有模型类型的归一化平均性能都有显著提升。对于未经指令微调的T5模型,研究者们使用了通过在额外100B个C4令牌上训练的LM-adapted模型。鉴于评估基准的难度以及T5模型并非多语言模型,与未经指令微调的模型相比,T5模型从指令微调中受益最大。例如,Flan-T5-XL模型仅拥有3B参数,但在MMLU基准测试中达到了52.4%的准确率,超过了拥有175B参数的GPT-3模型的43.9%准确率。结合了指令微调和UL2持续预训练的U-PaLM模型在本研究中表现出最强的性能,这表明指令微调和UL2持续预训练是提高语言模型性能的互补且计算效率高的方法。

微调对开放式生成任务的影响

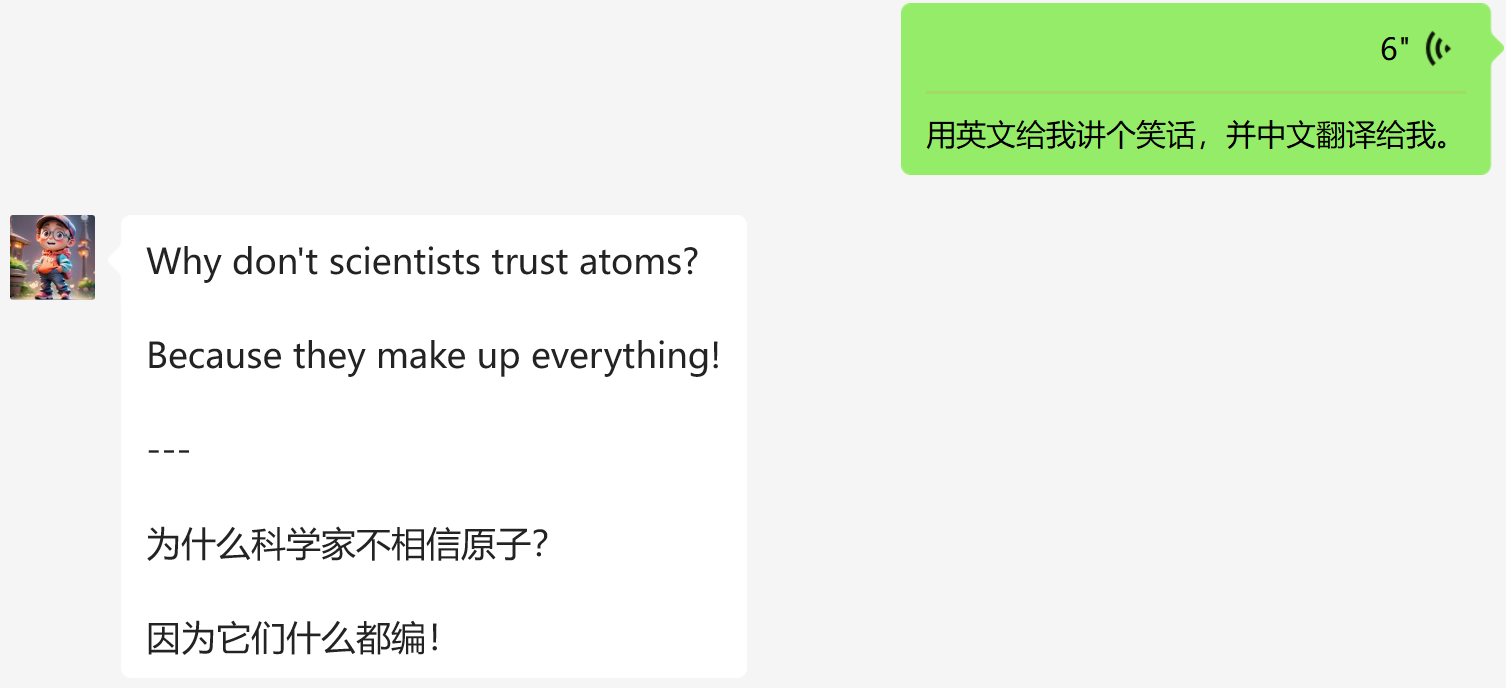

除了NLP基准测试外,语言模型还能够生成对开放式请求的长形式答案。标准的NLP基准测试和自动评估指标并不足以衡量这些开放式响应中的人类偏好。因此研究者们进行了手动评估,以调查指令微调对模型生成开放式响应能力的影响。研究者们创建了一个包含190个示例的评估集,这些示例包括五个挑战类别(创造力、上下文推理、复杂推理、规划和解释)的零样本问题,每个类别20个问题。对于其中的60个示例(来自复杂推理、规划和解释类别),研究者们创建了带有链式思考触发短语(例如“让我们逐步思考”)的变体,作为对第4.3节中定量评估的补充。此外,研究者们还包括了30个测试少量样本能力的输入,这些是未经指令微调的强大语言模型已经表现出色的问题。

在评估中,研究者们比较了PaLM 540B和Flan-PaLM 540B模型。对于这两种模型,研究者们使用温度采样(τ=0.7)随机生成五个响应,然后根据未进行长度归一化的对数概率分数对它们进行排名。研究者们选择了得分最高的响应,之后通过过滤步骤移除了得分高于中位数一半的生成内容,这成功地移除了大部分包含不良重复的生成内容。然后,研究者们将PaLM和Flan-PaLM的输出呈现给人类评估员,并要求他们根据期望程度选择响应。每对输出由一名评估员评分。

Figure 8 展示了在190个评估示例中,Flan-PaLM生成的内容有79%的时间被优先选择。对于每个零样本设置,Flan-PaLM都以较大的优势被优先选择,而对于使用CoT触发短语的输入,评估员对Flan-PaLM相对于PaLM的偏好进一步增加了约10%。至于少量样本,与PaLM相比没有退步。

这些结果表明,指令微调模型在响应开放式零样本输入方面的能力得到了提升,这与Ouyang等人(2022)的研究一致,该研究表明,通过一组标签演示以及来自人类反馈的强化学习对语言模型进行微调,可以提高人类对用户提示分布的评估。此外,对PaLM生成的模型输出的检查揭示了仅仅在下一个令牌预测目标上进行预训练对于良好的零样本可用性是不够的,尽管在NLP基准测试上表现强劲。例如,对PaLM的不良行为的定性检查包括(1)继续生成相关文本而不是回答问题,(2)用小的修改重复输入问题,以及(3)不知道何时停止生成文本。这可能是由于在预训练中没有使用序列结束标记,Figure 9 展示了这些错误的例子。

这项研究表明,指令微调是一种有效的方法,可以提升预训练语言模型在多样化任务上的性能和可用性。通过在更多的任务和更大的模型规模上进行微调,可以进一步挖掘语言模型的潜力。论文中提到的模型和数据集已经公开,感兴趣的研究者可以通过以下链接访问:

- Flan-T5 Checkpoints

![[Redis] 分布式系统与Redis介绍](https://i-blog.csdnimg.cn/direct/d2ad2344168843e595d2c2b86ebc4ede.png)