文章目录

- 一、深度学习的概述

- 1.1 深度学习的定义

- 1.1.1 什么是深度学习

- 1.1.2 深度学习的历史与发展

- 1.2 深度学习与传统机器学习的区别

- 1.2.1 特征工程的区别

- 1.2.2 模型复杂度与计算能力的对比

- 1.3 深度学习的关键技术

- 1.3.1 人工神经网络(ANN)

- 1.3.2 卷积神经网络(CNN)

- 1.3.3 循环神经网络(RNN)

- 二、深度学习在图像识别中的应用

- 2.1 图像识别的基本流程

- 2.1.1 数据准备与预处理

- 2.1.2 特征提取与模型训练

- 2.2 经典的图像识别模型

- 2.2.1 卷积神经网络(CNN)

- 2.2.2 深度残差网络(ResNet)

- 2.3 图像识别的实际应用案例

- 2.3.1 人脸识别技术

- 2.3.2 自动驾驶中的物体检测

- 三、深度学习在自然语言处理(NLP)中的应用

- 3.1 NLP的核心任务与挑战

- 3.1.1 文本分类与情感分析

- 3.1.2 语言生成与翻译

- 3.2 经典的NLP深度学习模型

- 3.2.1 循环神经网络(RNN)

- 3.2.2 Transformer模型

- 3.3 NLP的实际应用案例

- 3.3.1 智能客服与聊天机器人

- 3.3.2 语音识别与生成

- 四、深度学习的未来发展与挑战

- 4.1 模型复杂度与计算成本的平衡

- 4.2 数据隐私与模型的透明性问题

- 4.3 未来的深度学习趋势与方向

一、深度学习的概述

1.1 深度学习的定义

1.1.1 什么是深度学习

深度学习(Deep Learning)是一种基于人工神经网络的机器学习技术,通过构建多层神经网络模型来模拟人类大脑的思维方式。

与传统的机器学习方法相比,深度学习可以自动学习数据的特征,避免了手动设计特征的复杂过程。

1.1.2 深度学习的历史与发展

深度学习起源于人工神经网络的发展。

自20世纪80年代起,随着计算资源的进步和大数据的出现,深度学习的应用逐渐崭露头角,尤其是在2012年 AlexNet 模型在图像识别大赛中的突出表现,标志着深度学习的广泛应用时代正式开启。

1.2 深度学习与传统机器学习的区别

1.2.1 特征工程的区别

特征工程是机器学习中的关键步骤之一,指的是从原始数据中提取出对模型有用的特征。在传统的机器学习方法中,特征工程往往依赖于领域专家的知识,需要手动选择和设计特征。

例如,在房价预测中,可能需要手动提取房屋面积、房龄、位置等特征,这需要大量的时间和人力。

传统机器学习模型(如决策树、支持向量机、逻辑回归等)通常无法直接处理高维数据或非结构化数据(如图像、音频、文本),因此需要特征工程将这些复杂数据转化为模型可以理解的格式。

然而,在深度学习中,特征工程的过程大部分是自动化的。深度学习模型通过多层神经网络结构自动学习数据中的特征,尤其是在处理图像、语音、文本等非结构化数据时表现得尤为突出。

比如,卷积神经网络(CNN)能够通过多层卷积和池化操作,从图像中提取出不同层次的特征(如边缘、纹理、形状等)。

传统机器学习中的特征提取示例:

from sklearn.ensemble import RandomForestClassifier

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.model_selection import train_test_split

# 手动提取文本特征

vectorizer = CountVectorizer(max_features=500)

X = vectorizer.fit_transform(text_data).toarray()

# 使用传统模型(随机森林)

clf = RandomForestClassifier(n_estimators=100)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

clf.fit(X_train, y_train)

accuracy = clf.score(X_test, y_test)

print(f"Accuracy: {accuracy}")

深度学习中的自动特征提取:

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Embedding, LSTM, Dense

# 深度学习模型中自动学习特征(LSTM)

model = Sequential()

model.add(Embedding(input_dim=10000, output_dim=128))

model.add(LSTM(128))

model.add(Dense(1, activation='sigmoid'))

# 编译和训练模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

model.fit(X_train, y_train, epochs=5, batch_size=32)

在深度学习中,不需要手动设计特征,模型自动从数据中学习特征,并应用到任务中,极大地减少了人工干预。

1.2.2 模型复杂度与计算能力的对比

在传统机器学习中,模型的复杂度通常较低。

例如,线性回归、逻辑回归等模型参数相对较少,可以在普通的CPU上快速运行。而一些稍复杂的模型(如随机森林、支持向量机)尽管参数更多,但依然可以在中等规模的数据集上处理得较为高效。

相比之下,深度学习模型的复杂度大幅提高,尤其是深层神经网络(DNN)、卷积神经网络(CNN)和循环神经网络(RNN)等模型,拥有成千上万甚至数亿的参数。这些模型需要处理大量的计算和数据,训练时间也会相应增加。

例如,AlexNet、ResNet等图像识别模型,通常由数十层或数百层的神经网络组成,每层网络有数以百万计的参数需要更新。

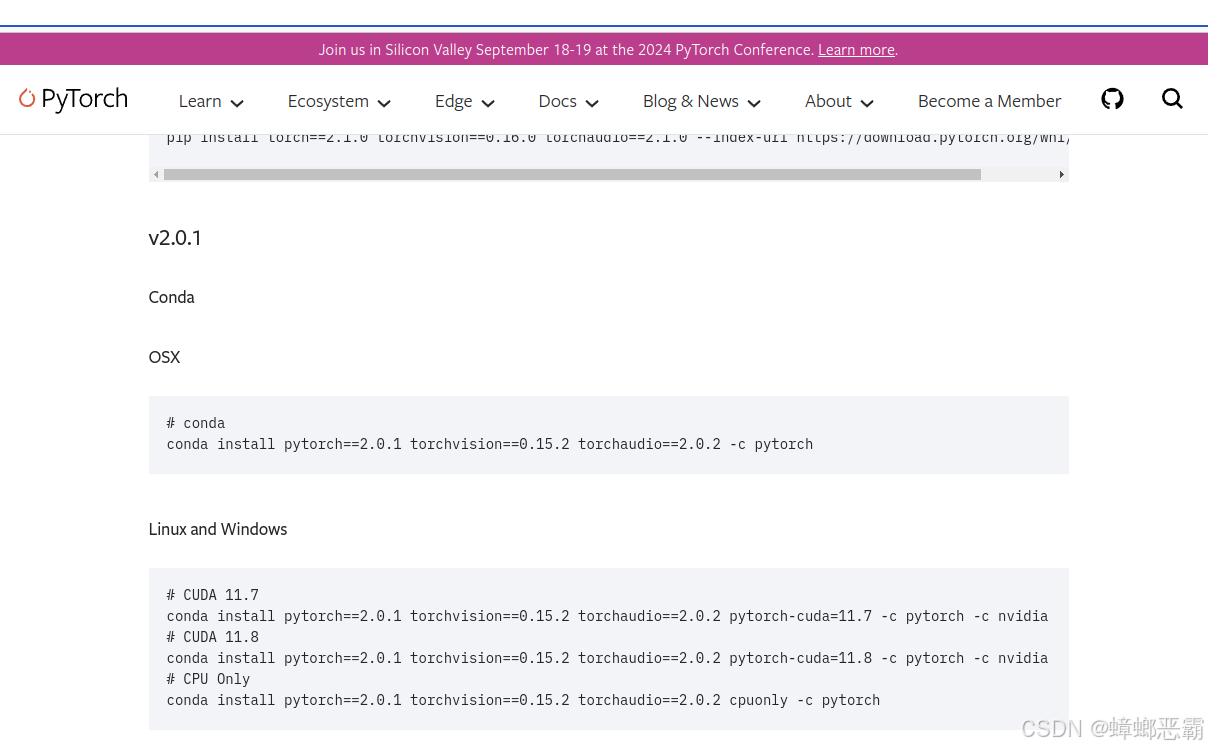

由于深度学习的计算需求非常高,GPU和TPU等专用硬件在训练深度学习模型中扮演了至关重要的角色。GPU的并行计算能力显著提高了神经网络的训练速度,而TPU则专门用于加速深度学习任务。

GPU上的深度学习训练

import tensorflow as tf

# 使用GPU加速深度学习训练

with tf.device('/GPU:0'):

model = Sequential()

model.add(Conv2D(32, kernel_size=(3, 3), activation='relu', input_shape=(28, 28, 1)))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Flatten())

model.add(Dense(128, activation='relu'))

model.add(Dense(10, activation='softmax'))

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

model.fit(X_train, y_train, epochs=10, batch_size=128)

计算复杂度对比

- 传统机器学习: 如线性回归的时间复杂度为 O ( n ⋅ p ) O(n \cdot p) O(n⋅p),其中n为样本数量,p为特征数量,通常可以在几秒内完成训练。

- 深度学习: 卷积神经网络的时间复杂度通常为 O ( n ⋅ d 2 ⋅ k 2 ⋅ f ) O(n \cdot d^2 \cdot k^2 \cdot f) O(n⋅d2⋅k2⋅f),其中d为输入数据的维度,k为卷积核大小,f为特征图数量,训练一个模型可能需要数小时甚至数天,特别是在大规模数据集上。

因此,深度学习相比传统机器学习,虽然可以自动化特征提取并显著提升精度,但也带来了计算复杂度的显著提升和硬件需求的增加。

1.3 深度学习的关键技术

1.3.1 人工神经网络(ANN)

人工神经网络是深度学习的基础结构。以下是一个简单的Python代码示例,展示了如何使用Keras库构建一个基础的神经网络模型:

from keras.models import Sequential

from keras.layers import Dense

# 创建一个简单的人工神经网络模型

model = Sequential()

model.add(Dense(64, activation='relu', input_dim=100))

model.add(Dense(64, activation='relu'))

model.add(Dense(10, activation='softmax'))

# 编译模型

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# 打印模型摘要

model.summary()

该代码展示了一个基础的三层神经网络,用于多分类问题。

1.3.2 卷积神经网络(CNN)

卷积神经网络擅长处理图像数据。以下是使用Keras构建一个简单的卷积神经网络的代码示例:

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

# 创建卷积神经网络模型

model = Sequential()

# 添加卷积层和池化层

model.add(Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)))

model.add(MaxPooling2D(pool_size=(2, 2)))

# 展平图像并添加全连接层

model.add(Flatten())

model.add(Dense(128, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 打印模型摘要

model.summary()

该卷积神经网络模型用于二分类任务,输入为64x64的RGB图像。

1.3.3 循环神经网络(RNN)

RNN适合处理序列数据,如时间序列或文本。以下是一个简单的RNN示例:

from keras.models import Sequential

from keras.layers import SimpleRNN, Dense

# 创建RNN模型

model = Sequential()

model.add(SimpleRNN(50, input_shape=(10, 1)))

model.add(Dense(1, activation='linear'))

# 编译模型

model.compile(optimizer='adam', loss='mean_squared_error')

# 打印模型摘要

model.summary()

该RNN模型可以用于回归任务,比如时间序列预测。

二、深度学习在图像识别中的应用

2.1 图像识别的基本流程

2.1.1 数据准备与预处理

在图像识别任务中,数据的预处理非常重要,通常需要对图像进行归一化、去噪和数据增强等操作,以确保模型可以学习到数据中的关键信息。

2.1.2 特征提取与模型训练

通过卷积神经网络,模型自动从图像中提取不同层次的特征,并通过反向传播算法调整网络权重。

以下是图像识别流程的Mermaid流程图:

该流程图展示了图像识别的基本流程,从数据收集到模型的最终部署。

2.2 经典的图像识别模型

在图像识别任务中,深度学习模型通过学习大量的图像数据,提取和识别出图像中的不同特征。

两种经典的图像识别模型是卷积神经网络(CNN)和深度残差网络(ResNet),它们在处理图像任务时表现出色,并被广泛应用于多个领域。

2.2.1 卷积神经网络(CNN)

卷积神经网络(Convolutional Neural Network, CNN) 是一种专门为图像数据设计的神经网络架构,通过卷积操作提取图像的局部特征。

CNN的核心在于它的卷积层和池化层,它们使网络能够捕捉图像的边缘、纹理、形状等局部特征。

相比于传统全连接网络,CNN具有参数共享和局部连接的优势,极大地减少了计算复杂度。

-

卷积层:通过卷积核(滤波器)对图像进行局部扫描,提取局部特征,例如边缘、纹理等。这种操作可以有效减少图像数据的维度,同时保留关键信息。

-

池化层:池化操作(如最大池化、平均池化)通过减少特征图的尺寸,进一步压缩数据,避免过拟合,并增强模型的容错性。

-

应用场景:CNN已经成为图像识别的基础架构,广泛应用于人脸识别、物体检测、图像分类等任务中。在医疗领域,CNN被用于医学影像分析,如通过识别X光、CT、MRI等图像中的病灶,协助医生进行诊断。

CNN的流程图

通过该结构,CNN能够从局部到全局地提取图像信息,进而完成识别、分类等任务。

2.2.2 深度残差网络(ResNet)

深度残差网络(Residual Neural Network, ResNet) 是由何恺明等人在2015年提出的一种深度神经网络结构,解决了在训练深层网络时常见的梯度消失和梯度爆炸问题。

随着神经网络层数的增加,模型容易出现梯度信息无法有效传播的情况,导致训练效果不理想。

ResNet通过引入残差连接(skip connections),有效避免了这一问题,使得网络可以通过更深的层次学习到更加复杂的特征。

-

残差连接:在ResNet中,通过将输入直接跳跃连接到后面的层,形成残差块。这个结构允许网络“跳过”某些层,确保梯度能够有效传播,从而解决了深层网络中的梯度消失问题。残差连接帮助ResNet在增加深度的同时保持模型的性能稳定。

-

应用场景:ResNet广泛应用于各种图像识别任务,如图像分类、物体检测、目标跟踪等。它不仅在计算机视觉领域取得了显著成果,还在其他领域如语音识别和NLP中被广泛应用。ResNet的出现使得更深、更复杂的网络结构得以实现,推动了深度学习的发展。

ResNet的残差结构流程图

小结

- CNN通过提取局部特征,能够有效处理二维图像数据,且计算效率高,适用于较浅的网络结构。

- ResNet则通过残差连接解决了深度网络的训练难题,使得我们可以构建更深的网络,提升模型的识别能力和泛化能力。

这两种模型在图像识别领域广泛应用,共同推动了计算机视觉的进步,助力自动驾驶、安防监控、医疗影像等多个行业的发展。

2.3 图像识别的实际应用案例

深度学习模型,尤其是卷积神经网络(CNN)和深度残差网络(ResNet),已在多个实际应用中取得了突破性进展,尤其是在人脸识别和自动驾驶等领域。

通过这些技术,深度学习使得计算机视觉的能力得到了极大的提升,帮助解决了许多复杂的视觉识别任务。

2.3.1 人脸识别技术

人脸识别是图像识别技术最为普及的应用之一,它通过分析和比对人脸特征,完成身份验证、监控等任务。CNN在这一领域中尤为重要,因为它能够从人脸图像中自动提取出关键特征,如眼睛、鼻子、嘴巴的位置和形状,并进行高效的匹配和分类。

-

智能安防:在智能安防系统中,摄像头可以实时捕捉人脸图像,结合深度学习模型快速比对数据库中的人脸信息,从而实现快速的身份识别。这种技术广泛应用于公共场所、机场、银行等领域,提高了安防监控的精确度和效率。

-

身份验证:在人脸识别支付和门禁系统中,深度学习使得身份验证变得更加方便快捷,取代了传统的密码或卡片验证。许多智能手机、笔记本电脑都已配备了人脸识别功能,通过用户的面部特征来解锁设备,进一步增强了安全性和用户体验。

人脸识别的流程图

通过这种流程,人脸识别系统能够快速分析并确认人脸特征,实现安全高效的身份识别。

2.3.2 自动驾驶中的物体检测

自动驾驶是另一个依赖深度学习的图像识别领域,它需要车辆具备强大的视觉感知能力,以便在复杂的道路环境中识别出各种物体,如行人、车辆、交通标志等。通过深度学习模型,尤其是CNN和ResNet,自动驾驶系统能够在实时环境下做出准确的决策。

-

行人和车辆检测:在自动驾驶中,车辆的摄像头实时捕捉道路图像,深度学习模型能够准确地识别出行人、其他车辆、自行车等物体,并根据它们的位置、速度等信息作出相应的驾驶决策。例如,当检测到行人接近斑马线时,自动驾驶系统会指示车辆减速或停车,以确保安全。

-

交通标志识别:深度学习不仅能够识别动态的物体,还能有效识别交通标志,如限速标志、停车标志等。通过卷积神经网络,系统可以快速分析并解读标志内容,确保车辆遵守交通规则。

自动驾驶物体检测的流程图

这种物体检测流程能够帮助车辆在复杂环境中实时做出决策,提高了自动驾驶的安全性和可靠性。

小结

- 人脸识别技术 已经广泛应用于安防监控、智能手机解锁、身份验证等领域,为个人和公共安全提供了有力保障。

- 自动驾驶中的物体检测 则通过深度学习模型帮助车辆实现智能感知和自动决策,使得自动驾驶技术逐渐接近商业化应用的阶段。

这两大应用不仅展示了深度学习在图像识别领域的强大能力,也为未来技术的发展铺平了道路。

三、深度学习在自然语言处理(NLP)中的应用

随着数据量的增长和计算能力的提升,深度学习在自然语言处理(NLP)中的表现越来越出色。通过自动提取特征、处理复杂序列数据,深度学习帮助NLP实现了显著的进展。

3.1 NLP的核心任务与挑战

3.1.1 文本分类与情感分析

文本分类是NLP中最基础的任务之一,它涉及将输入的文本数据分配到预定义的类别中。在情感分析中,模型通常需要根据文本内容判断用户的情感倾向(如正面、负面、中性)。

深度学习模型,尤其是循环神经网络(RNN)、长短时记忆网络(LSTM),能通过处理序列信息,捕捉文本的上下文语义,从而实现高精度的文本分类与情感分析。

代码示例:使用LSTM进行情感分析

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Embedding, LSTM, Dense

# 定义模型

model = Sequential()

model.add(Embedding(input_dim=10000, output_dim=128))

model.add(LSTM(128, dropout=0.2, recurrent_dropout=0.2))

model.add(Dense(1, activation='sigmoid'))

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(X_train, y_train, epochs=5, batch_size=32)

通过这样的深度学习模型,文本中的情感可以被自动分析和分类,从而应用于客户反馈、电影评论等情感分析场景。

3.1.2 语言生成与翻译

语言生成和机器翻译是NLP的两个核心任务。通过Transformer架构,深度学习模型能够生成高质量的自然语言文本。Transformer使用自注意力机制,在处理长文本序列时比RNN更为高效。

在语言生成中,模型通过学习大规模的文本数据,生成符合语法规则的连贯句子。而在翻译任务中,模型可以将一种语言转化为另一种语言,广泛应用于自动翻译服务中。

3.2 经典的NLP深度学习模型

3.2.1 循环神经网络(RNN)

循环神经网络(RNN) 是一种能够记住序列信息的神经网络,特别适合处理时间序列或文本序列。

RNN通过隐层将先前的输出与当前输入结合,形成循环结构,可以记住上下文信息。

然而,传统的RNN在处理长序列时容易遇到梯度消失的问题,导致模型无法有效记住较长的上下文。

LSTM(长短时记忆网络) 通过引入“记忆单元”和“门控机制”有效解决了RNN的梯度消失问题,能在更长的时间范围内保留信息。LSTM广泛应用于文本分类、机器翻译等任务中。

3.2.2 Transformer模型

Transformer模型是目前NLP最先进的深度学习模型之一。与RNN不同,Transformer不依赖于序列处理,而是通过自注意力机制并行处理输入序列,使其能够更高效地处理长文本。

Transformer的创新之处在于其多头注意力机制,能够同时关注输入序列的不同部分,提升了模型的泛化能力和速度。Transformer架构已经成为机器翻译、文本生成等任务中的主流选择。

代码示例:使用Transformer进行文本翻译

import tensorflow as tf

from transformers import TFAutoModelForSeq2SeqLM, AutoTokenizer

# 使用预训练的Transformer模型

model = TFAutoModelForSeq2SeqLM.from_pretrained('t5-small')

tokenizer = AutoTokenizer.from_pretrained('t5-small')

# 翻译任务

text = "Translate English to French: Hello, how are you?"

inputs = tokenizer(text, return_tensors='tf')

outputs = model.generate(inputs['input_ids'])

# 输出翻译结果

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

3.3 NLP的实际应用案例

3.3.1 智能客服与聊天机器人

智能客服和聊天机器人是NLP的重要应用之一。通过深度学习,智能客服系统能够自动理解用户的意图并进行适当的回复。

在许多企业中,基于NLP的聊天机器人已经成为客户服务的一部分,它们可以快速响应用户的询问,减少了人工客服的负担。

这种应用中,RNN和Transformer模型都能发挥作用,其中LSTM帮助模型理解长对话语境,而Transformer提高了应答的连贯性和准确性。

3.3.2 语音识别与生成

语音识别技术是NLP的另一大应用领域。通过深度学习,语音助手(如Alexa、Siri等)能够识别用户的语音指令,并将其转化为文本,然后再根据NLP模型处理用户的请求。另一方面,语音生成则通过TTS(Text-to-Speech)技术,将文本转换为语音,为用户提供自然的声音输出。

深度学习通过卷积神经网络(CNN)和RNN结合的方式,提升了语音识别的精度和速度,使语音助手在智能家居和移动设备中得到了广泛应用。

四、深度学习的未来发展与挑战

深度学习作为当前最具潜力的人工智能技术之一,已在多个领域展现出强大的能力。然而,随着技术的不断进步,深度学习也面临着许多挑战。

未来的发展不仅要提升性能,还需要解决计算成本、数据隐私、模型透明性等关键问题。

4.1 模型复杂度与计算成本的平衡

深度学习模型的复杂性正随着层数和参数量的增加而显著提升。

像GPT和ResNet等模型的复杂程度带来了显著的计算需求,不仅需要强大的计算硬件(如GPU、TPU),还耗费大量的能量与时间。这使得训练大规模模型的成本非常高昂,尤其对于资源有限的企业和研究机构而言,成为了一大障碍。

未来的研究方向之一便是如何在模型性能和计算成本之间找到平衡。

一些研究者已经在探索更轻量的模型结构(如MobileNet和EfficientNet),它们在保持性能的同时大幅降低了计算需求。

此外,基于模型剪枝、量化等技术的压缩模型也逐渐兴起,这些方法能够减少不必要的计算,提高模型的运行效率。

4.2 数据隐私与模型的透明性问题

随着深度学习的广泛应用,数据隐私与模型透明性问题成为了新的挑战。

深度学习模型依赖于大量数据进行训练,尤其是在医疗、金融等敏感领域,数据隐私保护变得至关重要。如何在充分利用数据的前提下保障用户隐私,是当前研究的热点之一。

像联邦学习等技术试图在分布式环境下实现数据隐私保护,这种方法允许各方在不共享数据的情况下训练模型。

另一方面,深度学习模型的**“黑盒”特性**使得其决策过程难以解释,这在某些敏感领域中尤为关键。

例如,医疗诊断、自动驾驶和法律判决中,决策的可解释性直接影响到结果的信任度和责任承担。

因此,可解释的人工智能(XAI) 正成为一项重要的研究方向,旨在为复杂的深度学习模型提供更透明、可解释的推理机制。

4.3 未来的深度学习趋势与方向

未来,深度学习的发展趋势将集中于以下几个方向:

-

高效能计算与算法优化:深度学习的未来发展离不开硬件的进步和算法的优化。量子计算、光子计算等新兴技术有望进一步提升计算效率,而新型优化算法和网络架构(如图神经网络、生成对抗网络等)则会在不同领域展现出更强的应用能力。

-

跨领域应用:随着深度学习的成熟,它的应用范围将进一步扩展。不仅限于图像识别、NLP和自动驾驶,深度学习还将在科学研究、生物技术、能源管理等新领域中扮演重要角色。例如,利用深度学习加速药物研发、气候预测等,已成为未来AI应用的核心探索方向。

-

自监督学习与小样本学习:当前的大多数深度学习模型依赖于大量标注数据,但数据的获取和标注往往成本高昂。未来,自监督学习 和 小样本学习 将成为重要方向,这些技术能在没有大规模标注数据的情况下,仍能保持良好的性能。这不仅能显著降低数据收集的成本,还能让深度学习更好地应对现实场景中的数据稀缺问题。