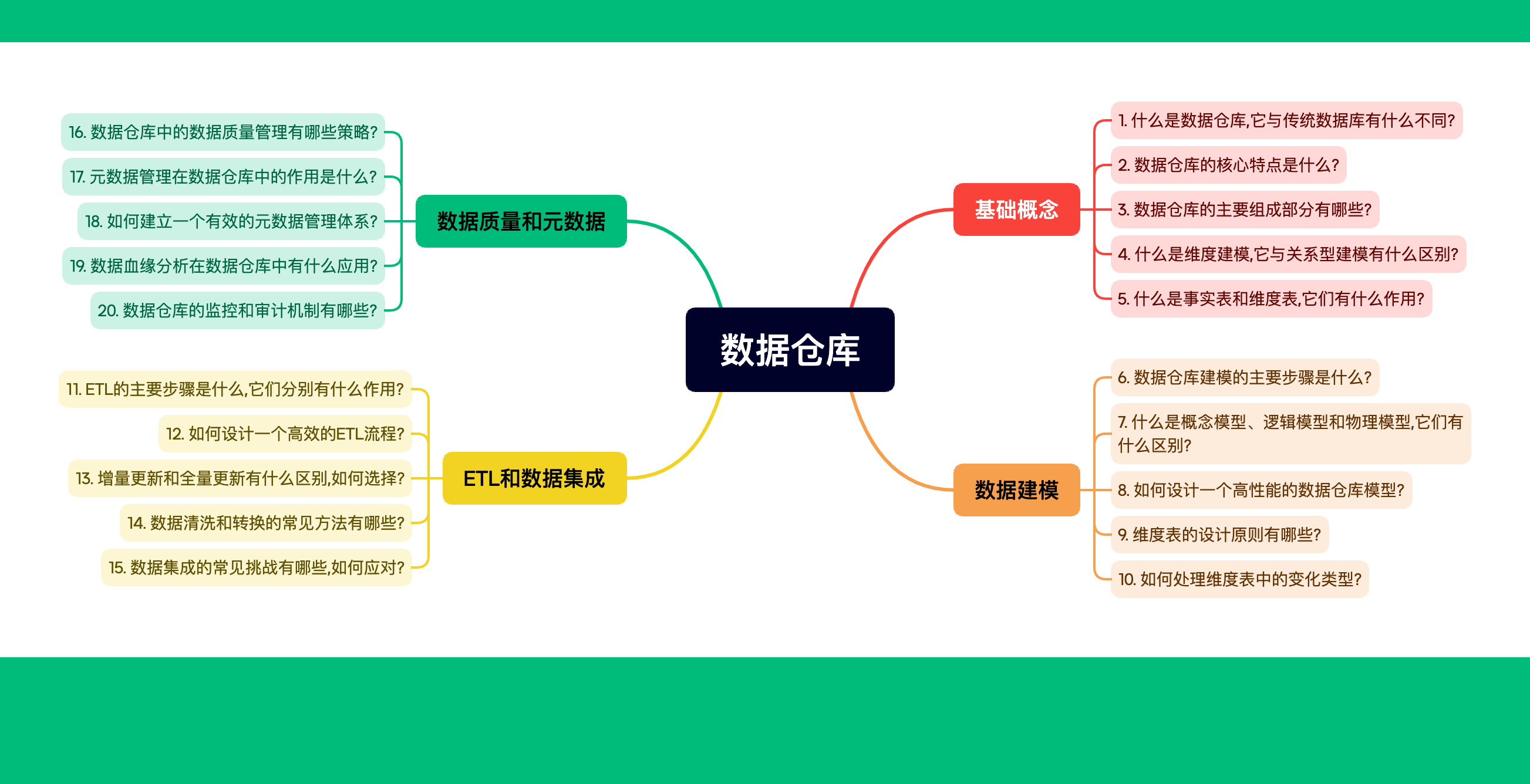

目录

- 什么是元数据?为什么它如此重要?

- 元数据管理体系的核心组件

- 如何设计元数据模型

- 步骤1: 识别关键元数据类型

- 步骤2: 定义元数据属性

- 步骤3: 建立元数据之间的关系

- 步骤4: 选择合适的建模方法

- 示例: 使用关系模型设计元数据模型

- 最佳实践

- 元数据采集策略

- 1. 识别元数据来源

- 2. 自动化采集

- 3. 手动采集补充

- 4. 增量采集

- 5. 元数据验证

- 元数据存储和管理

- 1. 选择合适的存储方案

- 2. 实现版本控制

- 3. 实现元数据API

- 4. 元数据安全

- 5. 元数据备份和恢复

- 元数据质量控制

- 1. 定义元数据质量标准

- 2. 实施自动化质量检查

- 3. 实施元数据审核流程

- 4. 实施元数据更新工作流

- 5. 建立元数据质量指标

- 元数据的可视化和应用

- 1. 数据字典和目录

- 2. 数据血缘图

- 3. 数据质量仪表板

- 元数据管理的最佳实践

- 常见挑战及解决方案

- 结论

想象一下,你正在管理一个巨大的图书馆,里面存放着数以万计的书籍。但是,这个图书馆没有任何分类系统,没有目录,甚至连书名都没有标注。你该如何找到你需要的那本书?这就是没有元数据管理的数据仓库的真实写照。

在大数据时代,数据就是新的石油。但是,如果没有有效的元数据管理,这些宝贵的数据资源就会变成一团乱麻,难以利用,更难以发挥其真正的价值。今天,让我们一起深入探讨如何建立一个有效的元数据管理体系,让你的数据仓库井然有序,价值倍增!

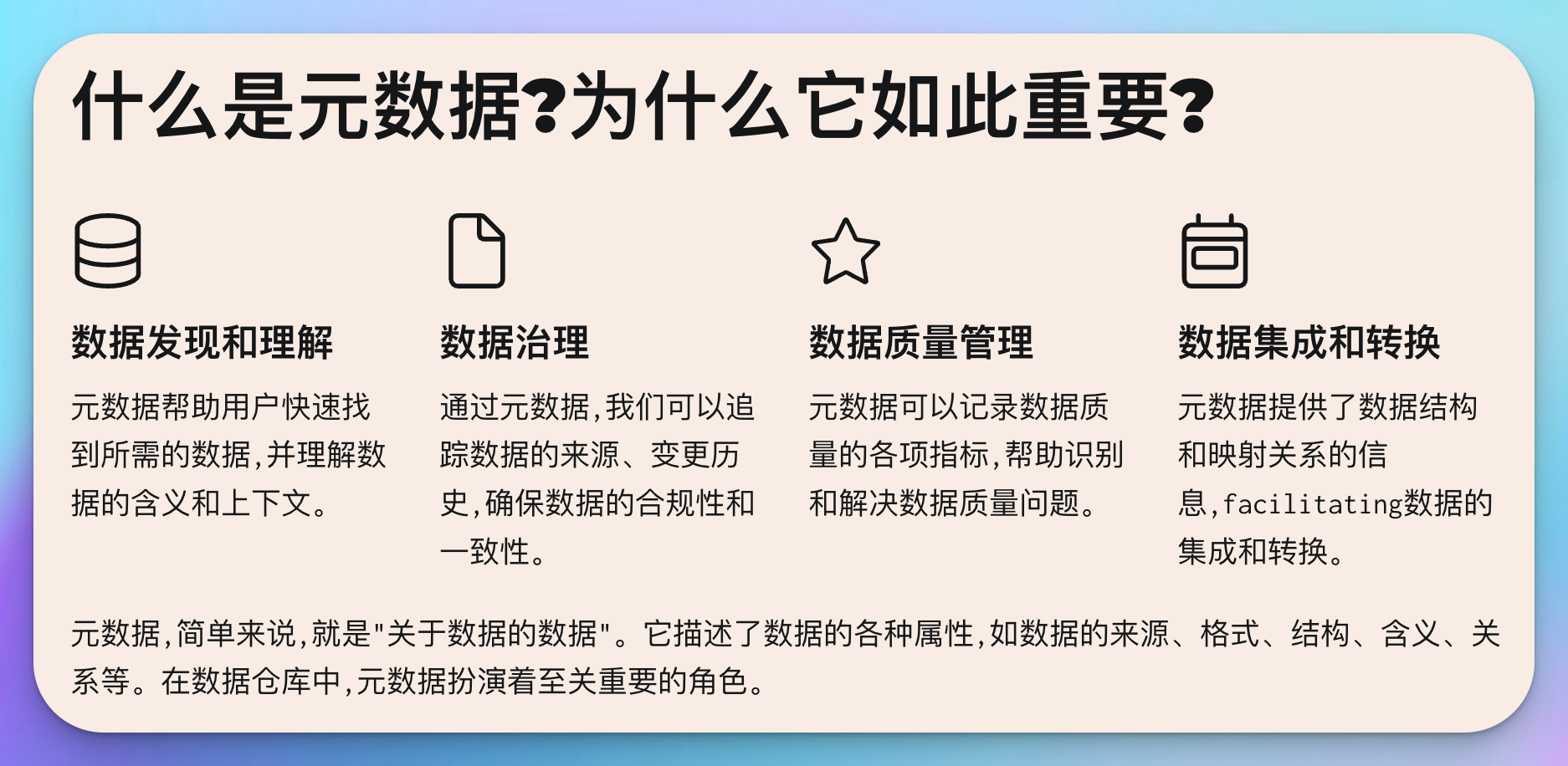

什么是元数据?为什么它如此重要?

元数据,简单来说,就是"关于数据的数据"。它描述了数据的各种属性,如数据的来源、格式、结构、含义、关系等。在数据仓库中,元数据扮演着至关重要的角色:

- 数据发现和理解: 元数据帮助用户快速找到所需的数据,并理解数据的含义和上下文。

- 数据治理: 通过元数据,我们可以追踪数据的来源、变更历史,确保数据的合规性和一致性。

- 数据质量管理: 元数据可以记录数据质量的各项指标,帮助识别和解决数据质量问题。

- 数据集成和转换: 在ETL过程中,元数据提供了数据结构和映射关系的信息,facilitating数据的集成和转换。

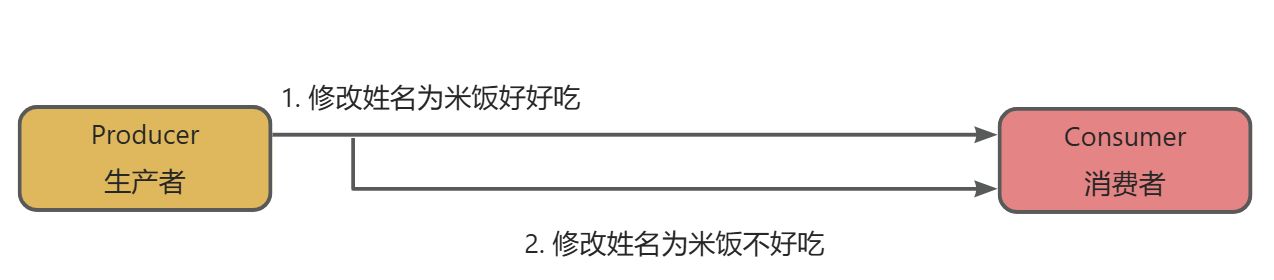

- 数据血缘分析: 元数据记录了数据的流转路径,使得数据血缘分析成为可能。

想象一下,如果没有元数据,数据分析师可能需要花费大量时间来理解数据的含义和结构,而不是专注于数据分析本身。因此,建立一个有效的元数据管理体系,对于提高数据仓库的效率和价值至关重要。

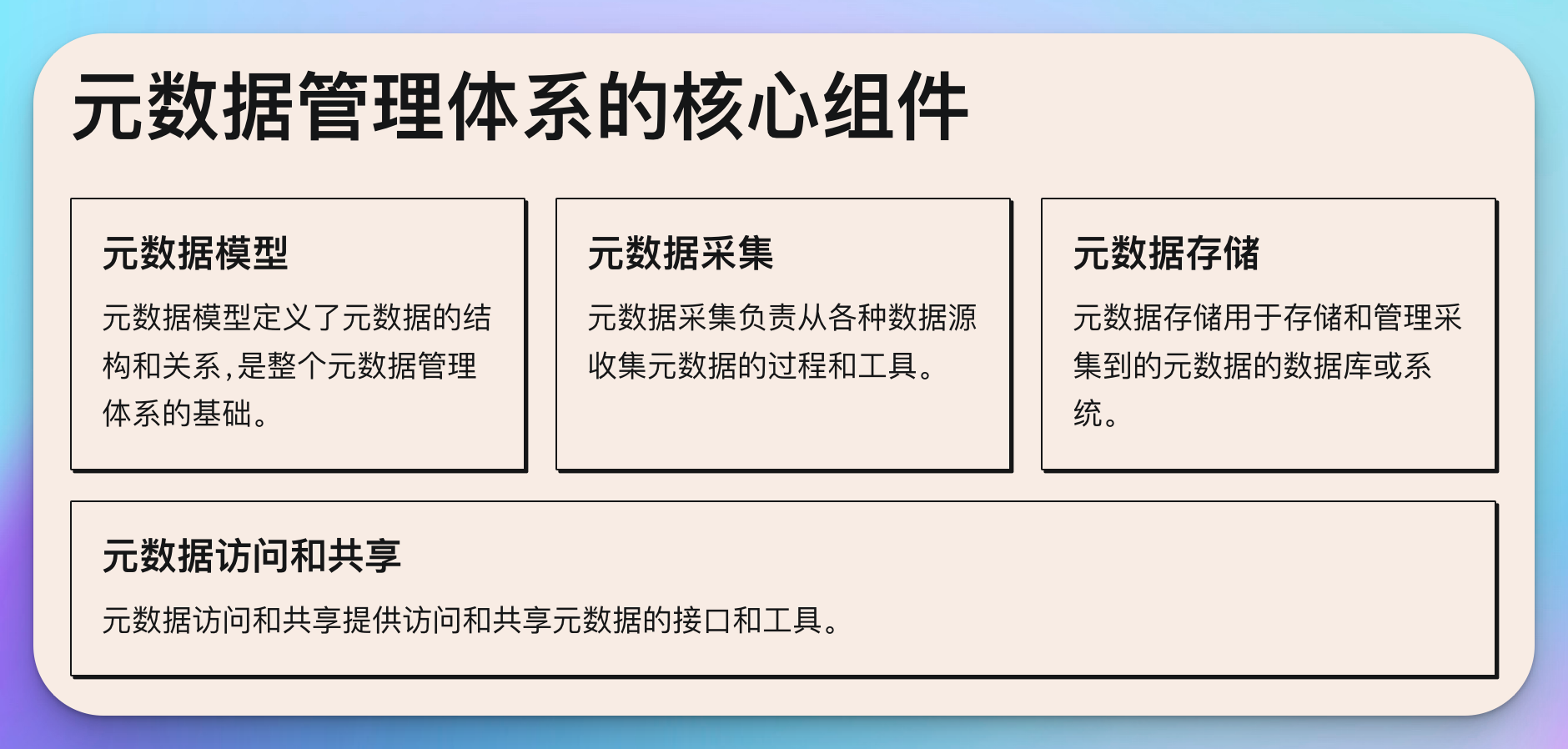

元数据管理体系的核心组件

一个完整的元数据管理体系通常包括以下核心组件:

- 元数据模型: 定义了元数据的结构和关系,是整个元数据管理体系的基础。

- 元数据采集: 负责从各种数据源收集元数据的过程和工具。

- 元数据存储: 用于存储和管理采集到的元数据的数据库或系统。

- 元数据访问和共享: 提供访问和共享元数据的接口和工具。

- 元数据质量管理: 确保元数据的准确性、完整性和一致性。

- 元数据版本控制: 管理元数据的变更历史。

- 元数据安全: 保护敏感的元数据,控制访问权限。

接下来,我们将详细探讨如何构建这些核心组件,以建立一个有效的元数据管理体系。

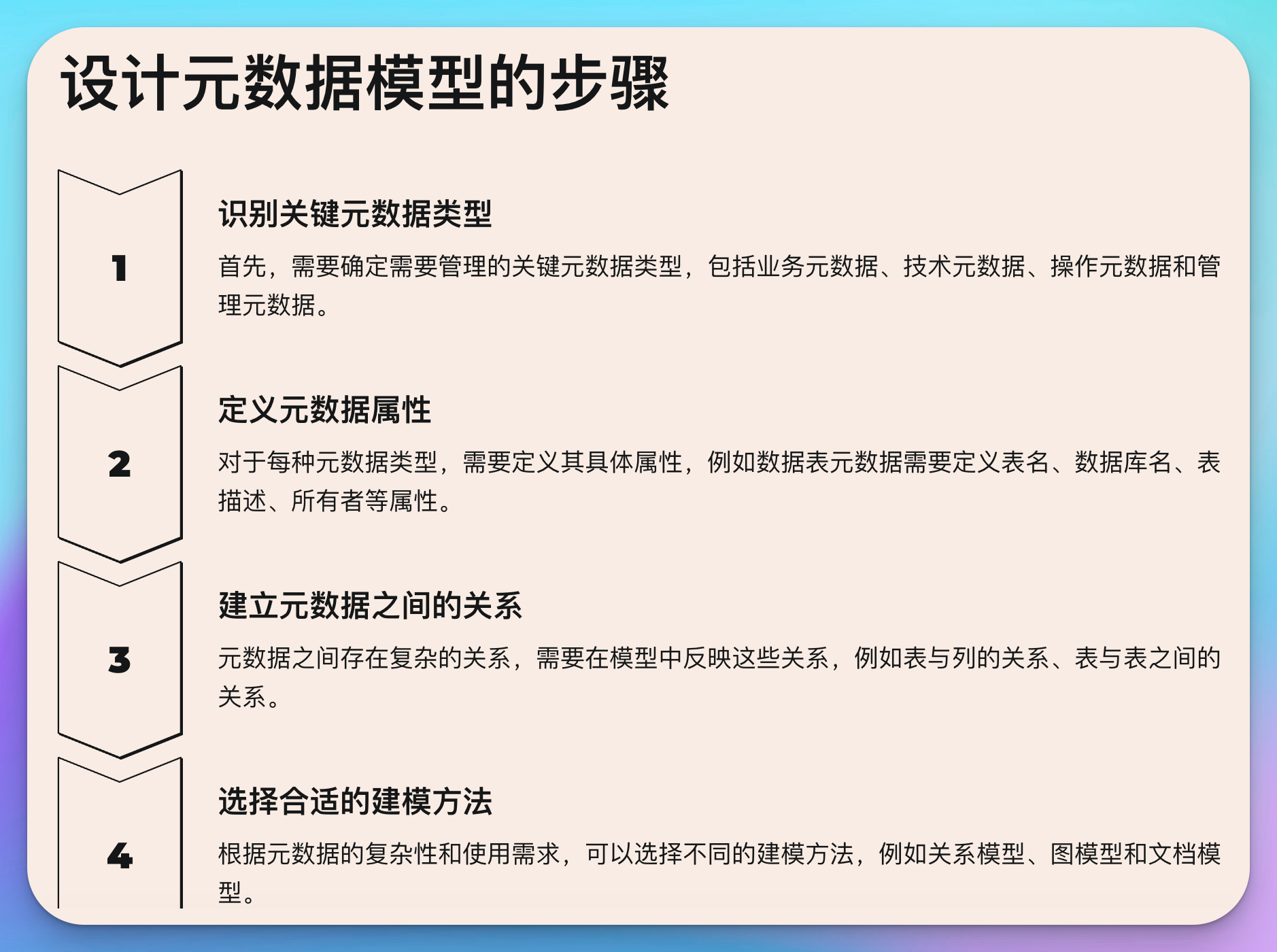

如何设计元数据模型

元数据模型是整个元数据管理体系的基础,一个良好设计的元数据模型可以大大提高元数据管理的效率和效果。以下是设计元数据模型的步骤和最佳实践:

步骤1: 识别关键元数据类型

首先,我们需要确定需要管理的关键元数据类型。通常,这包括:

- 业务元数据: 描述数据的业务含义和用途

- 技术元数据: 描述数据的技术特征,如数据类型、长度等

- 操作元数据: 描述数据的处理过程,如ETL作业、调度信息等

- 管理元数据: 描述数据的所有权、访问权限等

步骤2: 定义元数据属性

对于每种元数据类型,我们需要定义其具体属性。例如,对于一个数据表,我们可能需要以下属性:

- 表名

- 数据库名

- 表描述

- 所有者

- 创建时间

- 更新时间

- 列信息(名称、数据类型、描述等)

- 主键信息

- 外键信息

步骤3: 建立元数据之间的关系

元数据之间often存在复杂的关系,我们需要在模型中反映这些关系。例如:

- 表与列的关系

- 表与表之间的关系(如外键关系)

- 数据与ETL作业的关系

步骤4: 选择合适的建模方法

根据元数据的复杂性和使用需求,我们可以选择不同的建模方法:

- 关系模型: 适用于结构化程度高的元数据

- 图模型: 适用于复杂关系的元数据,特别是对于数据血缘分析

- 文档模型: 适用于半结构化或非结构化的元数据

示例: 使用关系模型设计元数据模型

让我们以一个简单的例子来说明如何使用关系模型设计元数据模型。假设我们需要管理数据表和列的元数据,我们可以设计以下表结构:

-- 数据表元数据

CREATE TABLE metadata_tables (

table_id INT PRIMARY KEY,

table_name VARCHAR(100) NOT NULL,

database_name VARCHAR(50) NOT NULL,

description TEXT,

owner VARCHAR(50),

created_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP,

updated_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP

);

-- 列元数据

CREATE TABLE metadata_columns (

column_id INT PRIMARY KEY,

table_id INT,

column_name VARCHAR(100) NOT NULL,

data_type VARCHAR(50) NOT NULL,

description TEXT,

is_primary_key BOOLEAN DEFAULT FALSE,

is_foreign_key BOOLEAN DEFAULT FALSE,

created_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP,

updated_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP,

FOREIGN KEY (table_id) REFERENCES metadata_tables(table_id)

);

-- 外键关系元数据

CREATE TABLE metadata_foreign_keys (

fk_id INT PRIMARY KEY,

table_id INT,

column_id INT,

referenced_table_id INT,

referenced_column_id INT,

created_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP,

updated_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP,

FOREIGN KEY (table_id) REFERENCES metadata_tables(table_id),

FOREIGN KEY (column_id) REFERENCES metadata_columns(column_id),

FOREIGN KEY (referenced_table_id) REFERENCES metadata_tables(table_id),

FOREIGN KEY (referenced_column_id) REFERENCES metadata_columns(column_id)

);

这个简单的模型能够捕获数据表、列以及它们之间的关系的基本元数据。当然,在实际应用中,我们可能需要更多的表和字段来满足更复杂的元数据管理需求。

最佳实践

- 保持简单: 开始时保持模型简单,随着需求的增加再逐步扩展。

- 考虑可扩展性: 设计模型时考虑未来可能的扩展需求。

- 标准化: 尽可能使用标准化的元数据模型,如Common Warehouse Metamodel (CWM)。

- 版本控制: 为元数据模型实现版本控制,以便跟踪和管理变更。

- 文档化: 详细记录元数据模型的设计和使用说明。

通过精心设计元数据模型,我们为整个元数据管理体系奠定了坚实的基础。接下来,让我们看看如何有效地采集这些元数据。

元数据采集策略

元数据采集是建立元数据管理体系的关键步骤。有效的元数据采集策略可以确保我们获得完整、准确和及时的元数据。以下是一些元数据采集的策略和最佳实践:

1. 识别元数据来源

元数据可能来自多个来源,包括但不限于:

- 数据库系统目录

- ETL工具

- 数据建模工具

- 业务分析文档

- 数据字典

- 代码注释

识别所有潜在的元数据来源是制定全面采集策略的第一步。

2. 自动化采集

尽可能自动化元数据采集过程,这可以提高效率并减少人为错误。以下是一些自动化采集的方法:

- 数据库元数据采集: 使用数据库系统提供的API或工具来自动提取表结构、索引、约束等信息。

例如,使用Python的SQLAlchemy库来自动提取MySQL数据库的元数据:

from sqlalchemy import create_engine, MetaData

# 连接到数据库

engine = create_engine('mysql://username:password@localhost/database_name')

# 创建MetaData对象

metadata = MetaData()

# 自动加载所有表的元数据

metadata.reflect(bind=engine)

# 遍历所有表并打印元数据

for table_name, table in metadata.tables.items():

print(f"Table: {table_name}")

print("Columns:")

for column in table.columns:

print(f" - {column.name}: {column.type}")

print("Primary Key:", table.primary_key)

print("Foreign Keys:")

for fk in table.foreign_keys:

print(f" - {fk.parent} -> {fk.column}")

print("\n")

- ETL作业元数据采集: 开发自定义脚本或利用ETL工具提供的API来提取作业定义、数据流、调度信息等。

例如,使用Apache Airflow的API来提取DAG(Directed Acyclic Graph)信息:

from airflow.models import DagBag

# 加载所有DAG

dag_bag = DagBag()

# 遍历所有DAG并提取元数据

for dag_id, dag in dag_bag.dags.items():

print(f"DAG: {dag_id}")

print("Tasks:")

for task in dag.tasks:

print(f" - {task.task_id}")

print("Schedule Interval:", dag.schedule_interval)

print("\n")

- 代码分析: 使用静态代码分析工具来提取代码中的注释、变量定义等作为元数据。

3. 手动采集补充

对于无法自动采集的元数据,如业务描述、数据所有者等,需要建立手动采集的流程。可以考虑以下方法:

- 创建web表单,允许数据所有者填写和更新元数据

- 定期组织元数据审查会议,确保手动采集的元数据保持最新

4. 增量采集

对于大型数据仓库,全量采集元数据可能耗时较长。实施增量采集策略可以提高效率:

- 记录上次采集的时间戳

- 只采集自上次采集以来发生变化的元数据

例如,使用Python实现增量采集MySQL表结构变化:

import mysql.connector

from datetime import datetime

def get_table_metadata(cursor, table_name):

cursor.execute(f"SHOW CREATE TABLE {table_name}")

return cursor.fetchone()[1]

def incremental_metadata_collection(host, user, password, database):

conn = mysql.connector.connect(host=host, user=user, password=password, database=database)

cursor = conn.cursor()

# 获取上次采集时间

cursor.execute("SELECT last_collection_time FROM metadata_collection_log")

last_collection_time = cursor.fetchone()[0]

# 获取发生变化的表

cursor.execute(f"""

SELECT table_name, update_time

FROM information_schema.tables

WHERE table_schema = '{database}' AND update_time > '{last_collection_time}'

""")

changed_tables = cursor.fetchall()

# 采集变化的表的元数据

for table_name,update_time in changed_tables:

metadata = get_table_metadata(cursor, table_name)

print(f"Table {table_name} changed. New metadata:\n{metadata}\n")

# 这里可以添加将新的元数据保存到元数据存储的逻辑

# 更新采集时间

current_time = datetime.now().strftime('%Y-%m-%d %H:%M:%S')

cursor.execute(f"UPDATE metadata_collection_log SET last_collection_time = '{current_time}'")

conn.commit()

cursor.close()

conn.close()

# 使用示例

incremental_metadata_collection('localhost', 'username', 'password', 'database_name')

这个脚本演示了如何实现增量元数据采集:它只检查自上次采集以来发生变化的表,并只更新这些表的元数据。

5. 元数据验证

在采集过程中,实施元数据验证可以确保采集到的元数据的质量。可以考虑以下验证:

- 完整性检查:确保所有必要的元数据字段都已填写

- 一致性检查:确保元数据与实际数据结构一致

- 格式检查:确保元数据符合预定义的格式

例如,以下是一个简单的Python函数,用于验证表元数据的完整性:

def validate_table_metadata(metadata):

required_fields = ['table_name', 'database_name', 'owner']

for field in required_fields:

if field not in metadata or not metadata[field]:

raise ValueError(f"Missing required metadata field: {field}")

if 'columns' not in metadata or not metadata['columns']:

raise ValueError("Table must have at least one column")

for column in metadata['columns']:

if 'name' not in column or 'data_type' not in column:

raise ValueError("Each column must have a name and data type")

# 使用示例

table_metadata = {

'table_name': 'customers',

'database_name': 'sales',

'owner': 'sales_team',

'columns': [

{'name': 'id', 'data_type': 'INT'},

{'name': 'name', 'data_type': 'VARCHAR(100)'}

]

}

try:

validate_table_metadata(table_metadata)

print("Metadata validation passed")

except ValueError as e:

print(f"Metadata validation failed: {str(e)}")

通过实施这些元数据采集策略,我们可以确保元数据管理系统中的数据始终保持最新、完整和准确。接下来,让我们探讨如何有效地存储和管理这些采集到的元数据。

元数据存储和管理

一旦我们采集到元数据,下一步就是如何有效地存储和管理这些元数据。选择合适的存储方案和管理策略对于建立一个高效的元数据管理体系至关重要。

1. 选择合适的存储方案

根据元数据的类型、数量和使用场景,我们可以选择不同的存储方案:

- 关系型数据库: 适用于结构化程度高的元数据。例如MySQL、PostgreSQL等。

- 文档型数据库: 适用于半结构化或结构灵活的元数据。例如MongoDB、Elasticsearch等。

- 图数据库: 适用于需要频繁进行关系查询的元数据,特别是对于数据血缘分析。例如Neo4j、JanusGraph等。

例如,如果我们选择使用PostgreSQL来存储元数据,可以创建如下表结构:

-- 数据表元数据

CREATE TABLE metadata_tables (

table_id SERIAL PRIMARY KEY,

table_name VARCHAR(100) NOT NULL,

database_name VARCHAR(50) NOT NULL,

description TEXT,

owner VARCHAR(50),

created_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP,

updated_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP

);

-- 列元数据

CREATE TABLE metadata_columns (

column_id SERIAL PRIMARY KEY,

table_id INTEGER REFERENCES metadata_tables(table_id),

column_name VARCHAR(100) NOT NULL,

data_type VARCHAR(50) NOT NULL,

description TEXT,

is_primary_key BOOLEAN DEFAULT FALSE,

is_foreign_key BOOLEAN DEFAULT FALSE,

created_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP,

updated_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP

);

-- 数据血缘关系

CREATE TABLE metadata_lineage (

lineage_id SERIAL PRIMARY KEY,

source_table_id INTEGER REFERENCES metadata_tables(table_id),

target_table_id INTEGER REFERENCES metadata_tables(table_id),

transformation_logic TEXT,

created_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP,

updated_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP

);

2. 实现版本控制

元数据经常会发生变化,实现版本控制可以帮助我们追踪这些变化,并在需要时回滚到之前的版本。我们可以通过以下方式实现版本控制:

- 为每个元数据实体添加版本号

- 保存元数据的变更历史

例如,我们可以创建一个元数据变更历史表:

CREATE TABLE metadata_change_history (

change_id SERIAL PRIMARY KEY,

entity_type VARCHAR(50) NOT NULL, -- 'table', 'column', 'lineage' etc.

entity_id INTEGER NOT NULL,

change_type VARCHAR(20) NOT NULL, -- 'create', 'update', 'delete'

old_value JSONB,

new_value JSONB,

changed_by VARCHAR(50),

changed_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP

);

每当元数据发生变化时,我们就在这个表中插入一条记录。

3. 实现元数据API

为了方便其他系统和应用程序访问元数据,我们应该实现一套API。这套API应该支持元数据的CRUD(创建、读取、更新、删除)操作。

以下是一个使用Python FastAPI框架实现的简单元数据API示例:

from fastapi import FastAPI, HTTPException

from pydantic import BaseModel

from typing import List

import psycopg2

from psycopg2.extras import RealDictCursor

app = FastAPI()

# 数据库连接

def get_db_connection():

return psycopg2.connect(

dbname="metadata_db",

user="username",

password="password",

host="localhost",

port="5432"

)

# 表元数据模型

class TableMetadata(BaseModel):

table_name: str

database_name: str

description: str = None

owner: str = None

# API: 获取所有表的元数据

@app.get("/tables", response_model=List[TableMetadata])

def get_all_tables():

conn = get_db_connection()

cur = conn.cursor(cursor_factory=RealDictCursor)

cur.execute("SELECT * FROM metadata_tables")

tables = cur.fetchall()

cur.close()

conn.close()

return tables

# API: 获取特定表的元数据

@app.get("/tables/{table_id}", response_model=TableMetadata)

def get_table(table_id: int):

conn = get_db_connection()

cur = conn.cursor(cursor_factory=RealDictCursor)

cur.execute("SELECT * FROM metadata_tables WHERE table_id = %s", (table_id,))

table = cur.fetchone()

cur.close()

conn.close()

if table is None:

raise HTTPException(status_code=404, detail="Table not found")

return table

# API: 创建新的表元数据

@app.post("/tables", response_model=TableMetadata)

def create_table(table: TableMetadata):

conn = get_db_connection()

cur = conn.cursor(cursor_factory=RealDictCursor)

cur.execute(

"INSERT INTO metadata_tables (table_name, database_name, description, owner) VALUES (%s, %s, %s, %s) RETURNING *",

(table.table_name, table.database_name, table.description, table.owner)

)

new_table = cur.fetchone()

conn.commit()

cur.close()

conn.close()

return new_table

# 其他API端点 (更新、删除等) 可以类似实现

这个API提供了基本的元数据管理功能,包括获取所有表的元数据、获取特定表的元数据、创建新的表元数据等。

4. 元数据安全

确保元数据的安全性也是管理的重要部分。我们应该:

- 实施访问控制,确保只有授权用户可以访问和修改元数据

- 对敏感的元数据进行加密

- 实现审计日志,记录所有对元数据的访问和修改操作

例如,我们可以使用PostgreSQL的角色和权限系统来控制对元数据表的访问:

-- 创建只读角色

CREATE ROLE metadata_reader;

GRANT USAGE ON SCHEMA public TO metadata_reader;

GRANT SELECT ON ALL TABLES IN SCHEMA public TO metadata_reader;

-- 创建读写角色

CREATE ROLE metadata_editor;

GRANT USAGE ON SCHEMA public TO metadata_editor;

GRANT SELECT, INSERT, UPDATE, DELETE ON ALL TABLES IN SCHEMA public TO metadata_editor;

-- 将用户分配到相应的角色

GRANT metadata_reader TO read_only_user;

GRANT metadata_editor TO editor_user;

通过这种方式,我们可以精细地控制不同用户对元数据的访问权限。

5. 元数据备份和恢复

定期备份元数据并制定恢复策略是确保元数据管理系统可靠性的关键。我们可以:

- 设置定时任务,定期备份元数据数据库

- 实现时间点恢复机制,允许恢复到特定时间点的元数据状态

例如,使用PostgreSQL的pg_dump工具进行备份:

#!/bin/bash

BACKUP_DIR="/path/to/backup/directory"

TIMESTAMP=$(date +"%Y%m%d_%H%M%S")

DB_NAME="metadata_db"

pg_dump -Fc $DB_NAME > $BACKUP_DIR/metadata_backup_$TIMESTAMP.dump

# 保留最近30天的备份

find $BACKUP_DIR -name "metadata_backup_*.dump" -type f -mtime +30 -delete

这个脚本创建了一个元数据数据库的完整备份,并删除30天前的旧备份。

通过实施这些存储和管理策略,我们可以确保元数据的安全性、可靠性和可访问性。接下来,让我们探讨如何确保元数据的质量。

元数据质量控制

高质量的元数据对于数据仓库的有效管理和使用至关重要。元数据质量控制涉及多个方面,包括准确性、完整性、一致性和及时性。以下是一些确保元数据质量的策略和最佳实践:

1. 定义元数据质量标准

首先,我们需要明确定义什么是"高质量"的元数据。这通常包括以下方面:

- 准确性: 元数据应准确反映实际数据的特征

- 完整性: 所有必要的元数据字段都应填写,不应有缺失

- 一致性: 元数据应在整个系统中保持一致

- 及时性: 元数据应及时更新,反映最新的数据状态

- 可理解性: 元数据应清晰易懂,避免歧义

2. 实施自动化质量检查

通过自动化脚本定期检查元数据质量,可以及时发现和解决问题。以下是一个Python脚本示例,用于检查元数据的完整性和一致性:

import psycopg2

from psycopg2.extras import RealDictCursor

def check_metadata_quality():

conn = psycopg2.connect(

dbname="metadata_db",

user="username",

password="password",

host="localhost",

port="5432"

)

cur = conn.cursor(cursor_factory=RealDictCursor)

# 检查表元数据完整性

cur.execute("""

SELECT table_id, table_name

FROM metadata_tables

WHERE description IS NULL OR owner IS NULL

""")

incomplete_tables = cur.fetchall()

if incomplete_tables:

print("Tables with incomplete metadata:")

for table in incomplete_tables:

print(f" - Table ID: {table['table_id']}, Name: {table['table_name']}")

# 检查列元数据完整性

cur.execute("""

SELECT c.column_id, c.column_name, t.table_name

FROM metadata_columns c

JOIN metadata_tables t ON c.table_id = t.table_id

WHERE c.description IS NULL

""")

incomplete_columns = cur.fetchall()

if incomplete_columns:

print("\nColumns with incomplete metadata:")

for column in incomplete_columns:

print(f" - Column ID: {column['column_id']}, Name: {column['column_name']}, Table: {column['table_name']}")

# 检查元数据一致性 (例如: 表中的列数与元数据中的列数是否一致)

cur.execute("""

SELECT t.table_id, t.table_name,

(SELECT COUNT(*) FROM information_schema.columns WHERE table_name = t.table_name) as actual_column_count,

(SELECT COUNT(*) FROM metadata_columns WHERE table_id = t.table_id) as metadata_column_count

FROM metadata_tables t

WHERE (SELECT COUNT(*) FROM information_schema.columns WHERE table_name = t.table_name) !=

(SELECT COUNT(*) FROM metadata_columns WHERE table_id = t.table_id)

""")

inconsistent_tables = cur.fetchall()

if inconsistent_tables:

print("\nTables with inconsistent column counts:")

for table in inconsistent_tables:

print(f" - Table ID: {table['table_id']}, Name: {table['table_name']}")

print(f" Actual column count: {table['actual_column_count']}")

print(f" Metadata column count: {table['metadata_column_count']}")

cur.close()

conn.close()

# 运行质量检查

check_metadata_quality()

这个脚本检查了元数据的完整性(是否有缺失的描述)和一致性(元数据中的列数是否与实际数据库表的列数一致)。

3. 实施元数据审核流程

除了自动化检查,定期的人工审核也是确保元数据质量的重要手段。可以考虑以下审核流程:

- 定期(如每月或每季度)安排元数据审核会议

- 由数据所有者或领域专家审核其负责的数据的元数据

- 使用清单确保覆盖所有重要的质量方面

- 记录并跟踪发现的问题,直到解决

4. 实施元数据更新工作流

为了确保元数据的及时性和准确性,应该建立一个清晰的元数据更新工作流:

- 当数据结构发生变化时,自动触发元数据更新流程

- 要求数据所有者定期审核和更新其负责的元数据

- 实施变更审批流程,特别是对于关键元数据的更改

以下是一个简单的Python脚本,演示如何在数据库表结构发生变化时自动更新元数据:

import psycopg2

from psycopg2.extras import RealDictCursor

def update_table_metadata(table_name):

conn = psycopg2.connect(

dbname="metadata_db",

user="username",

password="password",

host="localhost",

port="5432"

)

cur = conn.cursor(cursor_factory=RealDictCursor)

# 获取表的最新结构

cur.execute(f"""

SELECT column_name, data_type, is_nullable

FROM information_schema.columns

WHERE table_name = %s

""", (table_name,))

current_columns = cur.fetchall()

# 更新元数据表

cur.execute("SELECT table_id FROM metadata_tables WHERE table_name = %s", (table_name,))

table_id = cur.fetchone()['table_id']

for column in current_columns:

cur.execute("""

INSERT INTO metadata_columns (table_id, column_name, data_type, is_nullable)

VALUES (%s, %s, %s, %s)

ON CONFLICT (table_id, column_name)

DO UPDATE SET data_type = EXCLUDED.data_type, is_nullable = EXCLUDED.is_nullable

""", (table_id, column['column_name'], column['data_type'], column['is_nullable']))

conn.commit()

cur.close()

conn.close()

print(f"Metadata updated for table: {table_name}")

# 使用示例

update_table_metadata('customers')

这个脚本会检查指定表的当前结构,并更新元数据以反映最新的结构。

5. 建立元数据质量指标

为了持续监控和改进元数据质量,我们可以建立一套元数据质量指标:

- 完整性得分: 计算所有必填字段中已填写的比例

- 一致性得分: 计算元数据与实际数据结构一致的比例

- 及时性得分: 计算在规定时间内更新的元数据比例

- 准确性得分: 通过抽样检查计算元数据准确的比例

例如,我们可以使用以下SQL查询来计算元数据的完整性得分:

SELECT

COUNT(*) as total_metadata_count,

SUM(CASE WHEN description IS NOT NULL AND owner IS NOT NULL THEN 1 ELSE 0 END) as complete_metadata_count,

CAST(SUM(CASE WHEN description IS NOT NULL AND owner IS NOT NULL THEN 1 ELSE 0 END) AS FLOAT) / COUNT(*) as completeness_score

FROM metadata_tables;

通过定期计算和跟踪这些指标,我们可以量化元数据质量的改进情况,并识别需要重点关注的领域。

元数据的可视化和应用

高质量的元数据本身就是一种宝贵的资产,但要充分发挥其价值,我们需要通过可视化和应用将其转化为可操作的洞察。以下是一些元数据可视化和应用的方法:

1. 数据字典和目录

创建一个交互式的数据字典或数据目录,让用户能够轻松浏览和搜索元数据。这可以帮助数据分析师和业务用户更好地理解数据的结构和含义。

以下是一个使用Python Flask框架创建简单数据字典的示例:

from flask import Flask, render_template

import psycopg2

from psycopg2.extras import RealDictCursor

app = Flask(__name__)

def get_db_connection():

return psycopg2.connect(

dbname="metadata_db",

user="username",

password="password",

host="localhost",

port="5432"

)

@app.route('/')

def index():

conn = get_db_connection()

cur = conn.cursor(cursor_factory=RealDictCursor)

cur.execute("SELECT * FROM metadata_tables")

tables = cur.fetchall()

cur.close()

conn.close()

return render_template('index.html', tables=tables)

@app.route('/table/<int:table_id>')

def table_details(table_id):

conn = get_db_connection()

cur = conn.cursor(cursor_factory=RealDictCursor)

cur.execute("SELECT * FROM metadata_tables WHERE table_id = %s", (table_id,))

table = cur.fetchone()

cur.execute("SELECT * FROM metadata_columns WHERE table_id = %s", (table_id,))

columns = cur.fetchall()

cur.close()

conn.close()

return render_template('table_details.html', table=table, columns=columns)

if __name__ == '__main__':

app.run(debug=True)

配合适当的HTML模板,这个应用可以提供一个基本的数据字典界面。

2. 数据血缘图

数据血缘图可以直观地展示数据的来源、流动和转换过程。这对于理解数据的生命周期、进行影响分析和故障排查非常有帮助。

我们可以使用图形库如D3.js来可视化数据血缘关系。以下是一个简单的示例:

<!DOCTYPE html>

<html>

<head>

<script src="https://d3js.org/d3.v5.min.js"></script>

</head>

<body>

<svg width="960" height="600"></svg>

<script>

// 假设我们有以下血缘数据

const data = {

nodes: [

{ id: 1, name: "源系统A" },

{ id: 2, name: "ETL过程1" },

{ id: 3, name: "数据仓库表1" },

{ id: 4, name: "报表1" }

],

links: [

{ source: 1, target: 2 },

{ source: 2, target: 3 },

{ source: 3, target: 4 }

]

};

const svg = d3.select("svg"),

width = +svg.attr("width"),

height = +svg.attr("height");

const simulation = d3.forceSimulation(data.nodes)

.force("link", d3.forceLink(data.links).id(d => d.id))

.force("charge", d3.forceManyBody())

.force("center", d3.forceCenter(width / 2, height / 2));

const link = svg.append("g")

.selectAll("line")

.data(data.links)

.enter().append("line")

.attr("stroke", "#999")

.attr("stroke-opacity", 0.6);

const node = svg.append("g")

.selectAll("circle")

.data(data.nodes)

.enter().append("circle")

.attr("r", 5)

.attr("fill", "#69b3a2");

node.append("title")

.text(d => d.name);

simulation.on("tick", () => {

link

.attr("x1", d => d.source.x)

.attr("y1", d => d.source.y)

.attr("x2", d => d.target.x)

.attr("y2", d => d.target.y);

node

.attr("cx", d => d.x)

.attr("cy", d => d.y);

});

</script>

</body>

</html>

这个示例创建了一个简单的数据血缘图,展示了数据从源系统到最终报表的流动过程。

3. 数据质量仪表板

利用元数据创建数据质量仪表板,可以帮助数据管理者和用户快速了解数据的整体质量状况。

以下是一个使用Python和Dash库创建简单数据质量仪表板的示例:

import dash

import dash_core_components as dcc

import dash_html_components as html

from dash.dependencies import Input, Output

import plotly.express as px

import pandas as pd

import psycopg2

from psycopg2.extras import RealDictCursor

app = dash.Dash(__name__)

def get_db_connection():

return psycopg2.connect(

dbname="metadata_db",

user="username",

password="password",

host="localhost",

port="5432"

)

def get_data_quality_metrics():

conn = get_db_connection()

cur = conn.cursor(cursor_factory=RealDictCursor)

cur.execute("""

SELECT

t.table_name,

COUNT(*) as total_columns,

SUM(CASE WHEN c.description IS NOT NULL THEN 1 ELSE 0 END) as columns_with_description,

CAST(SUM(CASE WHEN c.description IS NOT NULL THEN 1 ELSE 0 END) AS FLOAT) / COUNT(*) as completeness_score

FROM metadata_tables t

JOIN metadata_columns c ON t.table_id = c.table_id

GROUP BY t.table_name

""")

data = cur.fetchall()

cur.close()

conn.close()

return pd.DataFrame(data)

app.layout = html.Div([

html.H1("数据质量仪表板"),

dcc.Graph(id='completeness-chart'),

dcc.Interval(

id='interval-component',

interval=60*1000, # 每分钟更新一次

n_intervals=0

)

])

@app.callback(Output('completeness-chart', 'figure'),

Input('interval-component', 'n_intervals'))

def update_graph(n):

df = get_data_quality_metrics()

fig = px.bar(df, x='table_name', y='completeness_score',

title='元数据完整性得分',

labels={'completeness_score': '完整性得分', 'table_name': '表名'},

range_y=[0,1])

return fig

if __name__ == '__main__':

app.run_server(debug=True)

这个仪表板展示了各个表的元数据完整性得分,可以帮助识别需要改进的数据领域。

元数据管理的最佳实践

建立一个有效的元数据管理体系是一个持续的过程。以下是一些最佳实践,可以帮助你在这个过程中取得成功:

-

从小处着手,逐步扩展: 从最关键的数据集开始,建立一个基本的元数据管理流程,然后逐步扩展到其他数据集。

-

建立明确的责任制: 为每个数据集指定明确的所有者,负责维护其元数据的质量。

-

自动化优先: 尽可能自动化元数据的采集、验证和更新过程,以减少人为错误和工作负担。

-

培养元数据文化: 教育组织中的每个人理解元数据的重要性,鼓励大家积极参与元数据管理。

-

定期审核和改进: 定期审核元数据管理流程,识别改进的机会,并持续优化。

-

与数据治理结合: 将元数据管理纳入更广泛的数据治理策略中,确保它与组织的整体数据战略保持一致。

-

关注用户体验: 确保元数据易于访问和理解,为数据用户提供直观的界面和工具。

-

保持元数据的一致性: 在整个组织中使用统一的元数据标准和术语,避免歧义和混淆。

-

重视数据安全: 确保元数据管理系统符合组织的数据安全和隐私政策。

-

利用元数据驱动决策: 鼓励使用元数据来支持数据相关的决策,如数据质量改进、数据集成等。

常见挑战及解决方案

在建立和维护元数据管理体系的过程中,你可能会遇到一些常见的挑战。以下是一些典型挑战及其可能的解决方案:

-

挑战: 元数据不完整或过时

解决方案:- 实施自动化元数据采集流程

– 建立定期审核机制 - 使用元数据质量评分激励数据所有者维护元数据

- 实施自动化元数据采集流程

-

挑战: 缺乏统一的元数据标准

解决方案:- 制定并实施组织范围的元数据标准

- 使用行业标准(如DCAM, CDMC)作为参考

- 建立元数据治理委员会来管理和更新标准

-

挑战: 元数据管理系统的用户采用率低

解决方案:- 改善用户界面,提高易用性

- 提供培训和支持

- 展示元数据管理带来的具体价值

- 将元数据使用集成到日常工作流程中

-

挑战: 难以在不同系统间集成元数据

解决方案:- 实施元数据API,便于系统间交换

- 使用元数据交换标准(如CWM)

- 考虑实施中央化的元数据仓库

-

挑战: 元数据管理的ROI难以量化

解决方案:- 建立明确的元数据管理KPI

- 跟踪元数据使用情况和其对业务决策的影响

- 进行案例研究,展示元数据管理如何解决具体业务问题

-

挑战: 处理大规模和复杂的元数据

解决方案:- 使用可扩展的数据库解决方案(如分布式数据库)

- 实施元数据分层管理

- 使用高效的索引和查询优化技术

-

挑战: 确保元数据的安全性和隐私

解决方案:- 实施细粒度的访问控制

- 对敏感元数据进行加密

- 定期进行安全审计

- 遵守数据保护法规(如GDPR)

-

挑战: 元数据管理与现有流程的整合

解决方案:- 将元数据管理嵌入到现有的数据生命周期管理流程中

- 使用自动化工具在数据处理过程中捕获和更新元数据

- 提供API和插件,便于与现有工具集成

结论

建立一个有效的元数据管理体系是一项复杂但极其重要的任务。它不仅能提高数据的可发现性和可理解性,还能提升数据质量,支持数据治理,并为数据驱动的决策提供坚实的基础。

通过遵循本文中讨论的步骤和最佳实践,你可以:

- 设计一个全面的元数据模型

- 实施有效的元数据采集策略

- 建立可靠的元数据存储和管理机制

- 确保元数据的高质量

- 通过可视化和应用充分利用元数据

记住,元数据管理是一个持续的过程。随着你的数据环境的演变,你的元数据管理策略也需要相应调整。持续的监控、反馈和改进是保持元数据管理体系有效性的关键。

最后,不要忘记元数据管理的终极目标是为业务创造价值。始终关注如何利用元数据来支持业务目标,提高数据的可用性和价值,这将帮助你获得整个组织对元数据管理的持续支持。

随着数据量的持续增长和数据环境的日益复杂,一个强大的元数据管理体系将成为任何成功的数据驱动型组织的核心基础设施。现在就开始投资于你的元数据管理,为未来的数据挑战做好准备吧!