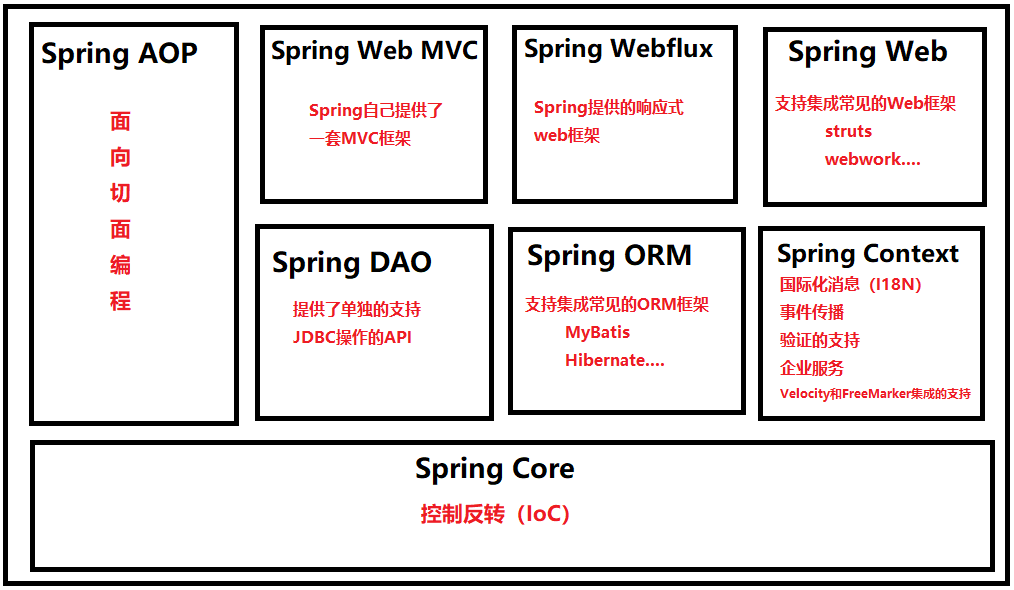

图片分类任务

- 给定一张图片,现在要求神经网络能够输出它对这个图片的分类结果。下图表示神经网络有40%的信心认定这个图片是狗

- ResNet(CNN)曾经是是图像分类的最好模型

- 在有足够大数据做预训练的情况下,ViT要强于ResNet

- ViT 就是Transformer Encoder网络

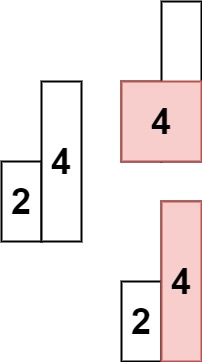

Split Image into Patches

- 在划分图片的时候,需要指定两个超参数

- patch size: 一个patch的大小,如 16 × 16 16×16 16×16

- stride: 如果划分的时候没有重叠,那么stride就等于大小

16

×

16

16×16

16×16

Vectorization

- 把每一个patch(张量),拉伸成一个向量,即直接展平:加入patch是一个

d

1

×

d

2

×

d

3

d_1×d_2×d_3

d1×d2×d3 的张量,那么向量就是

d

1

d

2

d

3

×

1

d_1d_2d_3×1

d1d2d3×1 的

- 对每个向量做线性变换,将其降维,变换矩阵的参数都是共享的:

- 由于图片的相对位置是有意义的,所以我们还要加上位置信息,即要对位置进行编码。在下面的两张图中,显然左右两张图是不一样的。但是如果不加位置编码,则它们对于 Transformer 来说就是一样的

- 我们需要把位置编码加到刚刚变换后的向量里面,现在每个

z

z

z 即是 patch 内容的表征,又是相对位置关系的表征。论文中表明如果不用位置编码,会掉 3 个百分点的准确率。而用何种位置编码的结果都差不多

- 我们还会用到一个 CLS,这和上节课的 BERT 是类似的。把 CLS 也做一个 Embedding 和其他向量一起加入多头自注意力的计算。可以堆叠多个多头自注意力层和全连接层

- 我们把这些多头自注意力层和全连接层简化为一个 Encoder 网络,输出从

c

0

c_0

c0 到

c

n

c_n

cn 一共

n

+

1

n+1

n+1 个向量,其中向量

c

1

c_1

c1 到

c

n

c_n

cn 没有用,可以直接忽略掉。有用的是向量

c

0

c_0

c0,可以把它看作是从图片中提取的特征向量,用作分类任务:

- 把

c

0

c_0

c0 输入 Softmax 分类器,p 的维度取决于有多少个种类:

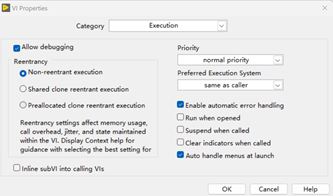

- 已经搭建好了神经网络,那么我们训练的第一步就是随机初始化神经网络参数,然后在数据集 A 上做一个预训练,其中 A 一定要大

- 在得到预训练的参数后,我们再用一个比较小的数据集 B 进行训练,这个步骤被称为微调,其中数据集 B 是任务的数据集

- 最后在测试集上进行测试,评价模型的表现

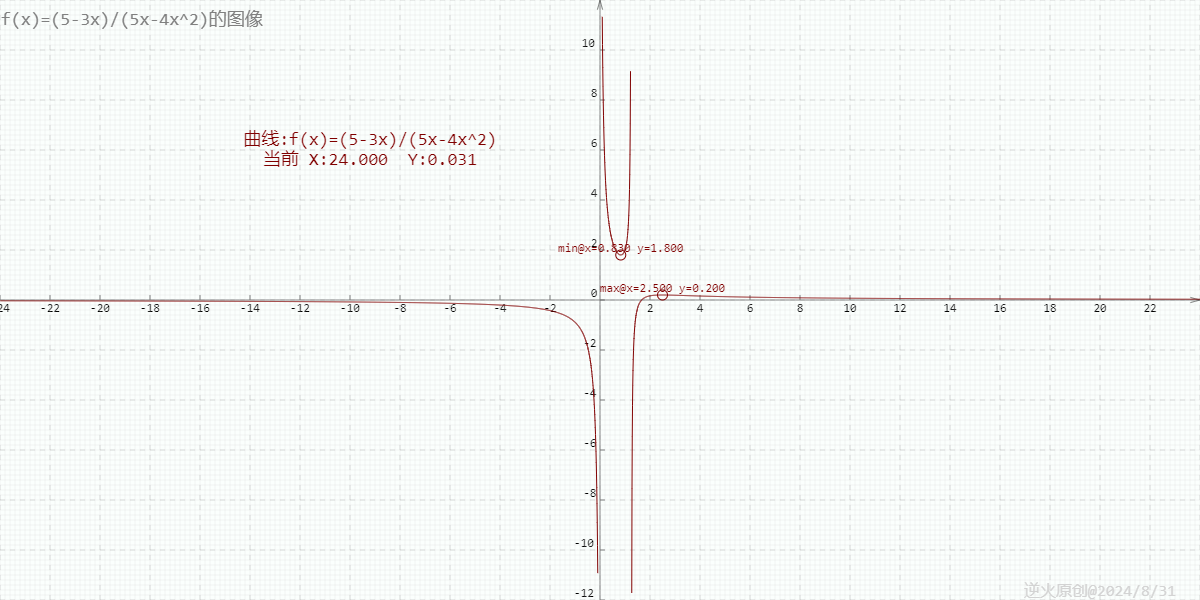

Image Classification Accuracies

- 当预训练的数据集不够大的时候,其实 Transformer 的表现并不是很好,弱于 ResNet

- 当预训练集的大小为中等时,Transformer 的效果与 ResNet 相当

- 当预训练集的大小为大时,Transformer 准确率会比 ResNet 高 1%

- 如果预训练数据集更大,那么 Transformer 的准确率还会提升

![24-8-31-读书笔记(十六)-《契诃夫文集》(十一)([俄] 契诃夫 [译] 汝龙 )](https://i-blog.csdnimg.cn/direct/6cd8b4ec25924f62bacf95fb1ff01db2.jpeg)