检索增强生成(Retrieval-Augmented Generation, RAG)是一种结合了检索(Retrieval)和生成(Generation)能力的框架,通过从背景数据中检索相关信息来增强模型的生成输出。在当前的大型语言模型(LLM)技术中,一个显著的限制是模型无法即时更新其训练数据集,这引发了两个主要问题:一是如何获取最新知识,二是如何减少生成幻觉(hallucination)的现象。

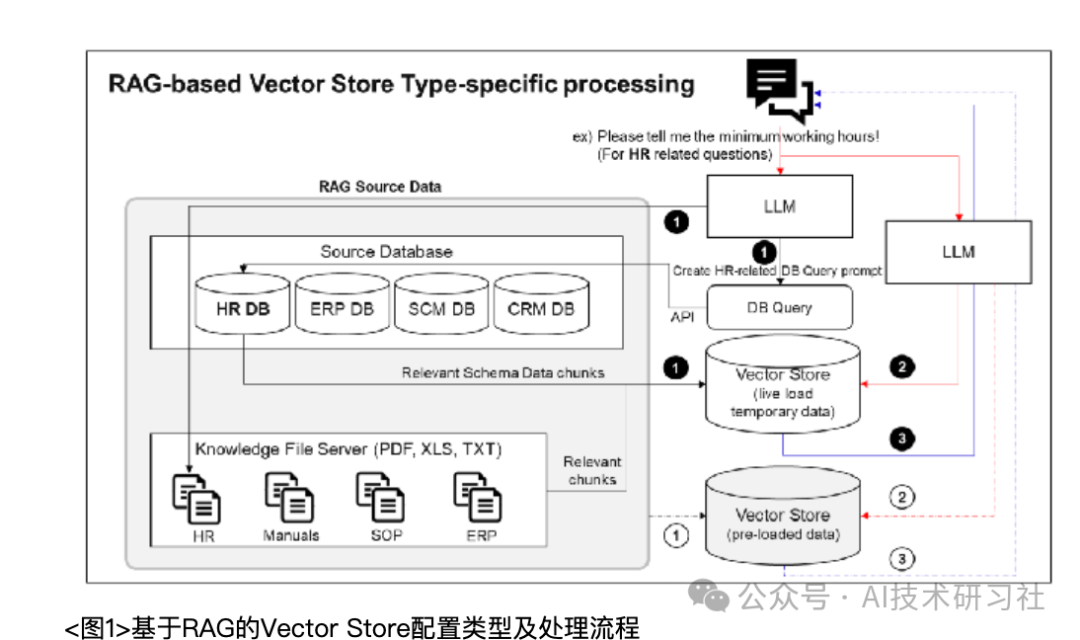

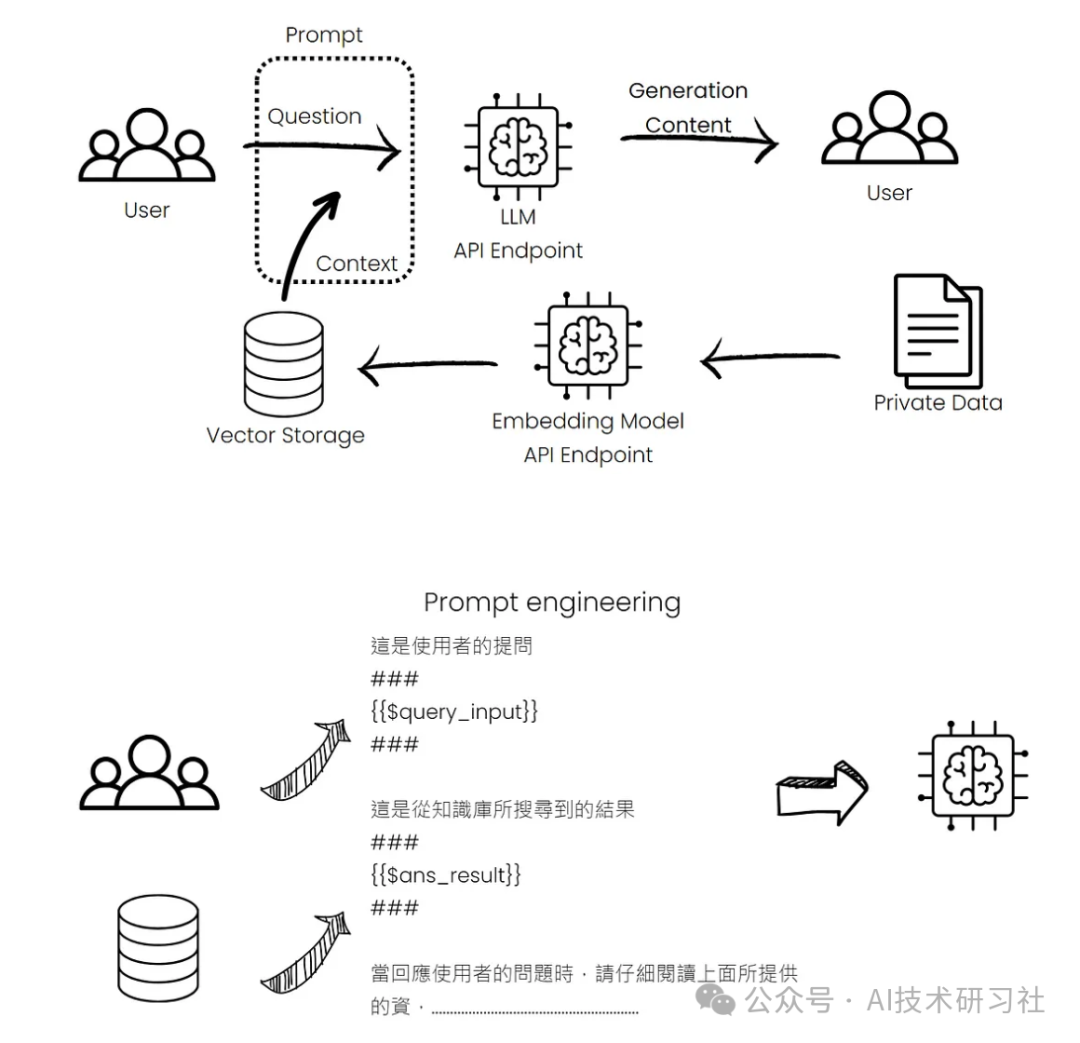

为应对这些挑战,通常采取两种方法:微调(fine-tuning)和检索增强生成(RAG)。其中,RAG因其成本较低、前期准备相对简单且效果显著,已成为主流的解决方案。在RAG的架构中,首要的挑战是确保检索到的参考资料具有足够的参考价值。解决这一问题的关键在于向量嵌入(Vector Embedding)和向量数据库(Vector Database)。简而言之,就是将问题转化为向量,通过相似度搜索技术,在向量数据库中寻找与问题向量相似的数据向量,从而找到可能的答案。以下两张图展示了RAG架构中的操作流程与概念。

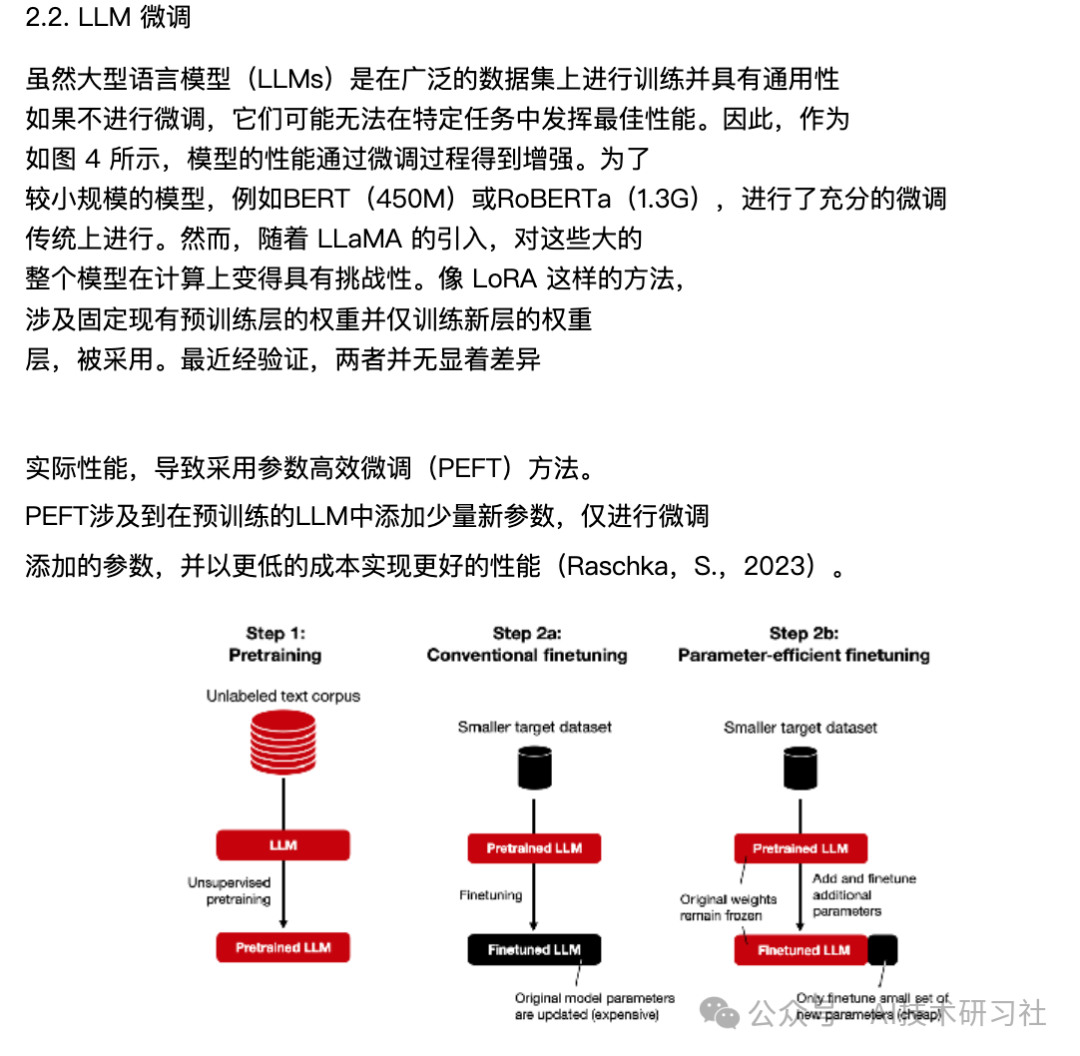

DSF(Domain-Specific Fine-tuning)是对已训练模型进行微调的过程,使其专门针对特定任务进行优化。初步训练的LLM学会一般的语言模式,而通过微调,模型能够在更狭窄的领域内进行训练,以适应特定应用场景,如客户服务或代码生成。

微调LLMs涉及在较小的特定领域数据集上训练预训练模型,使其能够调整其知识和语言模式以适应该领域的特定特征和细微差别。通过利用LLMs的迁移学习功能,微调使模型能够获得领域专业知识,并在数据标记和注释任务中提供更准确且与上下文相关的结果。这在医疗保健、金融、法律和科学研究等行业尤其有价值,在这些行业中,特定领域的术语、行话和语义关系对于准确的数据解释和注释至关重要。

DSF 的优点:

-

专门针对特定领域或任务进行优化,提供高度准确和专业的响应。

-

微调后的模型能够理解特定领域的术语和上下文,适用于命名实体识别(NER)、情感分析等任务。

DSF 的缺点:

-

微调过程可能耗时且资源密集,需具备高水平的NLP和深度学习知识。

-

模型性能受限于训练数据的质量,如果数据不够广泛或质量不高,可能导致模型表现不佳。

技术支持场景:

-

RAG:在处理技术支持查询时,RAG可以检索最新的技术手册和指南,提供即时解决方案。例如,当用户询问如何解决特定软件错误时,RAG可以引用最新的技术文档,提供详细的解决步骤。

-

DSF:微调过的技术支持模型能够更好地理解技术术语和特定问题的上下文,提供更专业和准确的回答。例如,微调模型能够识别并理解各种错误代码,提供有针对性的解决方案,而不仅仅是一般性建议。

如何系统的去学习大模型LLM ?

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高

针对所有自学遇到困难的同学们,我帮大家系统梳理大模型学习脉络,将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

👉[CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)]()👈

RAG 更适合需要实时查询并利用大量最新数据的情境,而 DSF 则更适合需要高精度和专业知识的特定领域任务。根据具体需求和资源,选择适合的方法来增强LLM的性能将是最有效的策略。