前言

过去一年里,大模型遍地开花,我自己也在做大模型训练相关的工作,踩过了很多很多坑,这里分享一些教训:用成熟的分布式训练框架:

-

多用 DeepSpeed,少用 Pytorch 原生的 torchrun。在节点数量较少的情况下,使用哪种训练框架并不是特别重要;然而,一旦涉及到数百个节点,DeepSpeed的优点就显得很明显,其简便的启动和便于性能分析的特点使其成为理想之选。

-

弹性容错和自动重启机制:大模型训练不是以往那种单机训个几小时就结束的任务,往往需要训练好几周甚至好几个月,这时候你就知道能稳定训练有多么重要。弹性容错能让你在机器故障的情况下依然继续重启训练;自动重启能让你在训练中断之后立刻重启训练。毕竟,大模型时代,节约时间就是节约钱。

-

定期保存模型:训练的时候每隔一段时间做个checkpointing,这样如果训练中断还能从上次的断点来恢复训练。

-

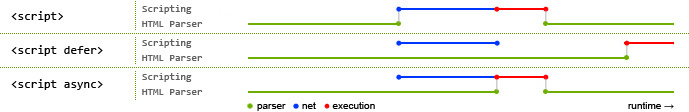

训练加速方法:最常用的有FlashAttention(V1 和 V2),加速效果很不错,基本是开箱即用;其他的有算子融合,fused_kernels等。

-

流水线并行和张量并行:大模型的参数规模都特别大,大到单机存不下。通常都会用流水线并行和张量并行的方法在有限的GPU机器下训练大模型。

-

使用高速网卡:用以太网卡来跑大模型训练是不现实的,大模型多机多卡训练一般都会用到RDMA技术,需要使用IB网卡和RoCE网卡(IB网卡的速度会比RoCE快一些,也贵一些)。

-

想清楚再开始训练:训练一次大模型的成本很高的。在训练之前先想清楚这次训练的目的,记录训练参数和中间过程结果,少做重复劳动。

-

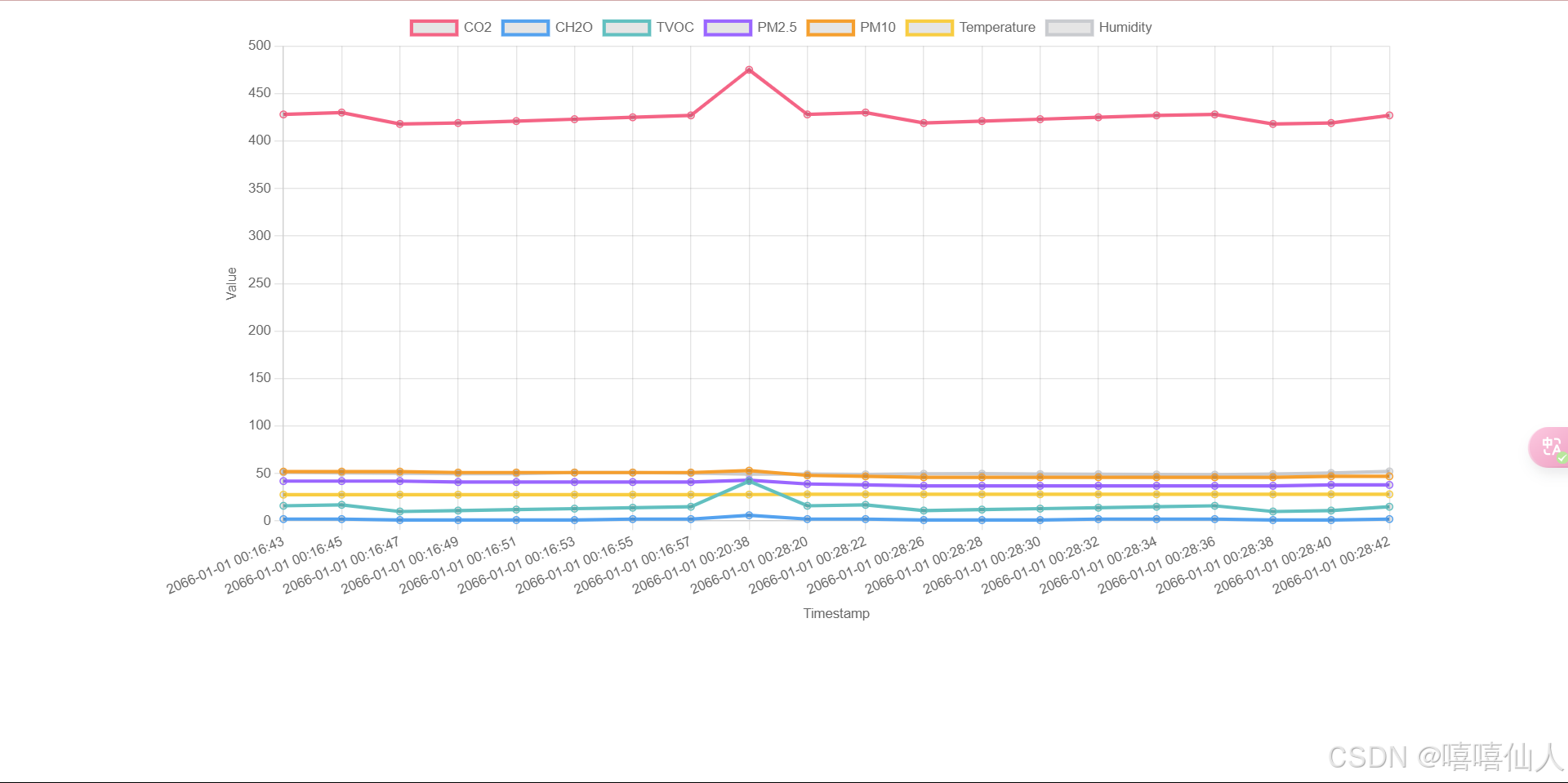

关注GPU使用效率:有时候,即使增加了多块 A100 GPU,大型模型的训练速度未必会加快,这很可能是因为GPU使用效率不高,尤其在多机训练情况下更为明显。仅仅依赖nvidia-smi显示的GPU 利用率并不足以准确反映实际情况,因为即使显示为100%,实际GPU利用率也可能不是真正的 100%。要更准确地评估GPU利用率,需要关注TFLOPS和吞吐率等指标,这些监控在DeepSpeed框架中都有。

如果你也想学习AI大模型

现在社会上大模型越来越普及了,已经有很多人都想往这里面扎,但是却找不到适合的方法去学习。作为一名资深码农,初入大模型时也吃了很多亏,踩了无数坑。现在我想把我的经验和知识分享给你们,帮助你们学习AI大模型,能够解决你们学习中的苦难。我已将重要的AI大模型资料包括市面上AI大模型商业报告、AGI大模型系统学习路线、AI大模型视频教程、实战学习,等录播视频免费分享出来。

这份完整版的Android全套学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

大模型知识脑图

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

经典书籍阅读

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的Android全套学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】