时序预测|基于贝叶斯BO-卷积-双向门控单元-注意力机制的单变量时间序列预测模型BO-CNN-BiGRU-Attention

文章目录

- 前言

- 时序预测|基于贝叶斯BO-卷积-双向门控单元-注意力机制的单变量时间序列预测模型BO-CNN-BiGRU-Attention

- 一、BO-CNN-BiGRU-Attention模型

- 1. 贝叶斯优化(BO)

- 2. 卷积神经网络(CNN)

- 3. 双向门控循环单元(BiGRU)

- 4. 自注意力机制(Attention)

- 综合流程

- 二、实验结果

- 三、核心代码

- 四、代码获取

- 五、总结

前言

时序预测|基于贝叶斯BO-卷积-双向门控单元-注意力机制的单变量时间序列预测模型BO-CNN-BiGRU-Attention

matlab版本要求2023a以上

基于贝叶斯BO-卷积-双向门控单元-注意力机制的单变量时间序列预测

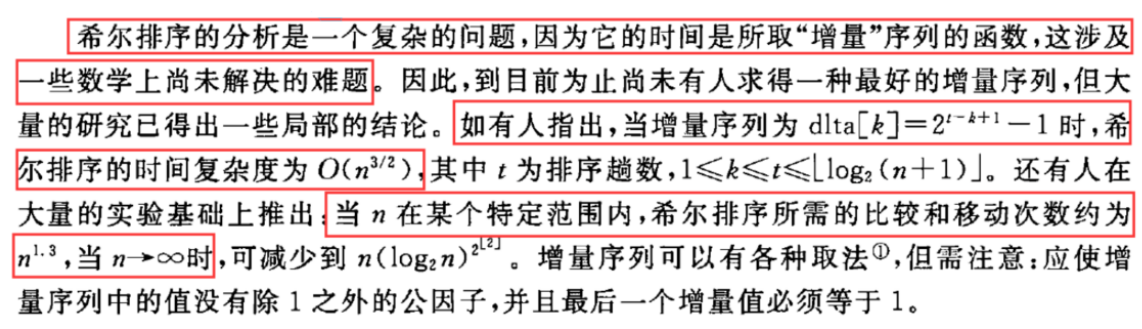

本文提出了一种基于贝叶斯BO-卷积-双向门控单元-注意力机制的单变量时间序列预测方法,使用BO算法来优化CNN和BiGRU网络结构的超参数,同时添加了注意力机制提高模型的预测性能。为了提高代码的可读性和可维护性。该方法在多个公共数据集上进行了实验,结果表明该方法在预测单变量时间序列方面具有显著的优势,且与当前最先进的方法相比,能够显著提高预测性能。

一、BO-CNN-BiGRU-Attention模型

BO-CNN-BiGRU-Attention模型结合了贝叶斯优化、卷积神经网络(CNN)、双向门控循环单元(BiGRU)和自注意力机制(Attention),每个组件在模型中的作用如下:

1. 贝叶斯优化(BO)

贝叶斯优化是一种用于优化超参数的技术。它通过建模目标函数的概率分布,利用贝叶斯推断来指导搜索过程,选择最有可能提高模型性能的超参数组合。这有助于找到最优的模型配置,而不是依赖于网格搜索或随机搜索等传统方法。

流程:

- 选择目标函数:通常是模型的性能指标(如验证集上的准确率)。

- 构建代理模型:通常使用高斯过程来近似目标函数。

- 选择下一点:利用代理模型选择最可能带来性能提升的超参数组合。

- 更新模型:用实际的目标函数值更新代理模型。

- 迭代:重复上述步骤,直到找到最优的超参数组合。

2. 卷积神经网络(CNN)

CNN用于提取输入数据中的局部特征,特别适合处理图像和序列数据中的空间信息。在这个模型中,CNN的任务是从输入序列中提取高层次的特征表示。

流程:

- 卷积层:通过卷积操作提取局部特征。

- 激活函数:如ReLU,引入非线性变换。

- 池化层:减少特征图的尺寸,保留重要的特征信息。

3. 双向门控循环单元(BiGRU)

BiGRU是对标准GRU(门控循环单元)的扩展,它可以同时考虑序列中的前向和后向信息。这有助于捕捉序列中前后文的相关性,从而提高对序列数据的建模能力。

流程:

- 前向GRU:处理序列的正向信息。

- 后向GRU:处理序列的反向信息。

- 融合:将前向和后向的隐藏状态结合,以形成对序列更全面的表示。

4. 自注意力机制(Attention)

自注意力机制允许模型在处理输入序列时,动态地关注序列中的不同部分。它计算每个位置的表示与其他位置的关系,从而加权不同位置的重要性,生成上下文感知的表示。

流程:

- 计算注意力权重:使用查询、键和值矩阵计算注意力得分。

- 加权求和:根据注意力权重对值进行加权求和,得到加权表示。

- 应用:将加权表示传递到后续层。

综合流程

- 输入数据预处理:对输入数据进行必要的预处理和特征提取。

- 贝叶斯优化:使用贝叶斯优化调整CNN、BiGRU和Attention机制的超参数,以获得最佳模型配置。

- 特征提取:使用CNN从输入序列中提取特征。

- 序列建模:将CNN提取的特征输入到BiGRU中,以建模序列的前向和后向信息。

- 上下文建模:通过自注意力机制对BiGRU输出进行加权和调整,生成最终的上下文感知表示。

- 输出:根据模型任务(如分类、回归等)生成最终预测结果。

通过这种方式,BO-CNN-BiGRU-Attention模型将贝叶斯优化的超参数调优能力与CNN、BiGRU和自注意力机制的特征提取和上下文建模能力结合起来,以提高模型的性能和准确性。

二、实验结果

BO-CNN-BiGRU-Attention实验结果

三、核心代码

%% 数据分析

num_size = 0.7; % 训练集占数据集比例

outdim = 1; % 最后一列为输出

num_samples = size(res, 1); % 样本个数

num_train_s = round(num_size * num_samples); % 训练集样本个数

f_ = size(res, 2) - outdim; % 输入特征维度

%% 划分训练集和测试集

P_train = res(1: num_train_s, 1: f_)';

T_train = res(1: num_train_s, f_ + 1: end)';

M = size(P_train, 2);

P_test = res(num_train_s + 1: end, 1: f_)';

T_test = res(num_train_s + 1: end, f_ + 1: end)';

N = size(P_test, 2);

%% 数据归一化

[p_train, ps_input] = mapminmax(P_train, 0, 1);

p_test = mapminmax('apply', P_test, ps_input);

[t_train, ps_output] = mapminmax(T_train, 0, 1);

t_test = mapminmax('apply', T_test, ps_output);

四、代码获取

私信即可 79米

五、总结

包括但不限于

优化BP神经网络,深度神经网络DNN,极限学习机ELM,鲁棒极限学习机RELM,核极限学习机KELM,混合核极限学习机HKELM,支持向量机SVR,相关向量机RVM,最小二乘回归PLS,最小二乘支持向量机LSSVM,LightGBM,Xgboost,RBF径向基神经网络,概率神经网络PNN,GRNN,Elman,随机森林RF,卷积神经网络CNN,长短期记忆网络LSTM,BiLSTM,GRU,BiGRU,TCN,BiTCN,CNN-LSTM,TCN-LSTM,BiTCN-BiGRU,LSTM–Attention,VMD–LSTM,PCA–BP等等

用于数据的分类,时序,回归预测。

多特征输入,单输出,多输出