一、明确需求

目标:爬取最新更新的电影的豆瓣链接

观察网页和页面源代码,每部电影都有一个超链接去到子页面,我们需要的内容在子页面,如果我们一个一个子页面的去爬取会比较麻烦,可以尝试先通过首页爬取子页面的超链接,在通过子页面链接与首页url拼接的方式去访问每一个子页面。

首页:

子页面:

子页面:

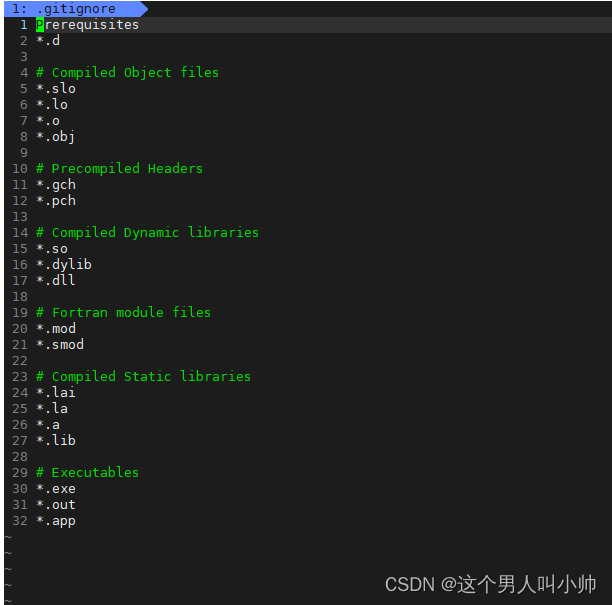

二、编写代码:

import requests

import re

import csv

url = 'https://www.dyttcn.com/'

resp = requests.get(url,verify=False) # verify=False忽略证书错误

resp.encoding = 'gb2312' # 指定编码格式

#print(obj1.text)

# obj1拿到ul列表中的内容 obj2拿到超链接 obj3拿到子页面中的电影名和电影对应的豆瓣链接

obj1 = re.compile(r"最新更新.*?<ul>(?P<UL>.*?)</ul>",re.S) # re.S表示.可以匹配换行符

obj2 = re.compile(r"<a href='(?P<url>.*?)'",re.S)

obj3 = re.compile(r"◎片 名(?P<name>.*?)</p>.*?◎豆瓣链接(?P<DBLJ>.*?)</p>",re.S)

# result1是提取的ul列表中的内容

result1 = obj1.finditer(resp.text)

# 利用列表保存提取后的链接

ZUrl_list = []

for i in result1:

# print(i.group('lianjie').strip())

result2 = obj2.finditer(i.group('UL').strip())

# 提取子页面的链接

for j in result2:

# 拼接子页面的链接

ZUrl = url + j.group('url').strip('/')

# 保存链接到列表中

ZUrl_list.append(ZUrl)

# print(j.group('url').strip('/'))

# 提取子页面内容,子页面像提取首页那样来处理

for z in ZUrl_list:

resp2 = requests.get(z,verify=False) # verify=False忽略子页面证书错误

resp2.encoding = 'gb2312' # 指定编码格式

result3 = obj3.finditer(resp2.text) # result3是提取子页面中的电影名和豆瓣链接

# print(resp2.text)

# a的意思是追加 newline=''的意思是不换行

with open('movieDBTT.csv', 'a', newline='', encoding='utf-8') as f:

writer = csv.writer(f)

# 写入数据

for i in result3:

dict = {

'name': i.group('name').strip(),

'DBLJ': i.group('DBLJ').strip()

}

writer.writerow(dict.values()) # 写入数据

#print(dict)

resp2.close()

f.close()

resp.close()

print('over')三、最终结果:

保存为csv文件

需要其它内容,修改获取子链接数据的正则表达式即可,按自己需求来。

需要其它内容,修改获取子链接数据的正则表达式即可,按自己需求来。