规模(scale)是除去时间、空间之外另一个重要的维度。规模缩放(Scaling)的过程中隐藏着世界非线性本质奥秘背后的共性——规模法则。结合伯努瓦·曼德布洛特 Benoit Mandelbrot的《大自然的分形几何》、杰弗里·韦斯特 Geoffery West 的《规模》以及唐纳德·特科特 Donnald Turcotte《分形与混沌——在地质学与地球物理学中的应用》等文献资料,介绍规模法则的相关的内容。

所谓“Scaling Laws”,就是模型性能会随着参数、算力、数据集的规模增加而提高。时间来到2024年,大模型领域依旧是“Scaling Laws”的统治区。

模型参数增长到万亿,训练集群从千卡到万卡、五万卡,前不久刚开源的一个高质量通用数据集达到45T,让开发者为了网络带宽而发愁……有人调侃:“在就近网络服务区下载好,再把硬盘用高铁飞机带过来,都比直接下载省时省力。”人工智能时代爆炸式的数据增长,对于攀爬Scaling law的中国AI产业来说,传统网络已经捉襟见肘,必须全面升级和重塑,更有效地支持大模型时代的联接需求。

Scaling Laws 是最早由 Open AI 提出的大模型开发的黄金经验法则,核心在于得到模 型参数规模、模型训练数据量以及模型计算资源三因素之间关系。实验结果 显示,在 transformer 架构下,如果不断扩大模型三因素规模,得到的模型效 果越优,算力规模增大和升级仍是通往 AGI 的关键。模型三因素之间存在幂律关系,可对模型进行效果预测,同时 三因素之间存在最优解。

OpenAI 在论文《Scaling Laws for Neural Language Models》中发现 AI 大语言模型性能的三个主要因素(即模型大小、数据集大 小和训练计算量)存在幂律关系,幂律关系意味着可通过对数转换变成线性 关系,从而实现模型建模,达到预训练模型对模型效果的预测作用,从而为模 型实际训练提供重要参考和指导。同时 DeepMind 对于 Scaling Laws 的进一步 研究发现,在设定条件下,模型三因素之间存在最优解。

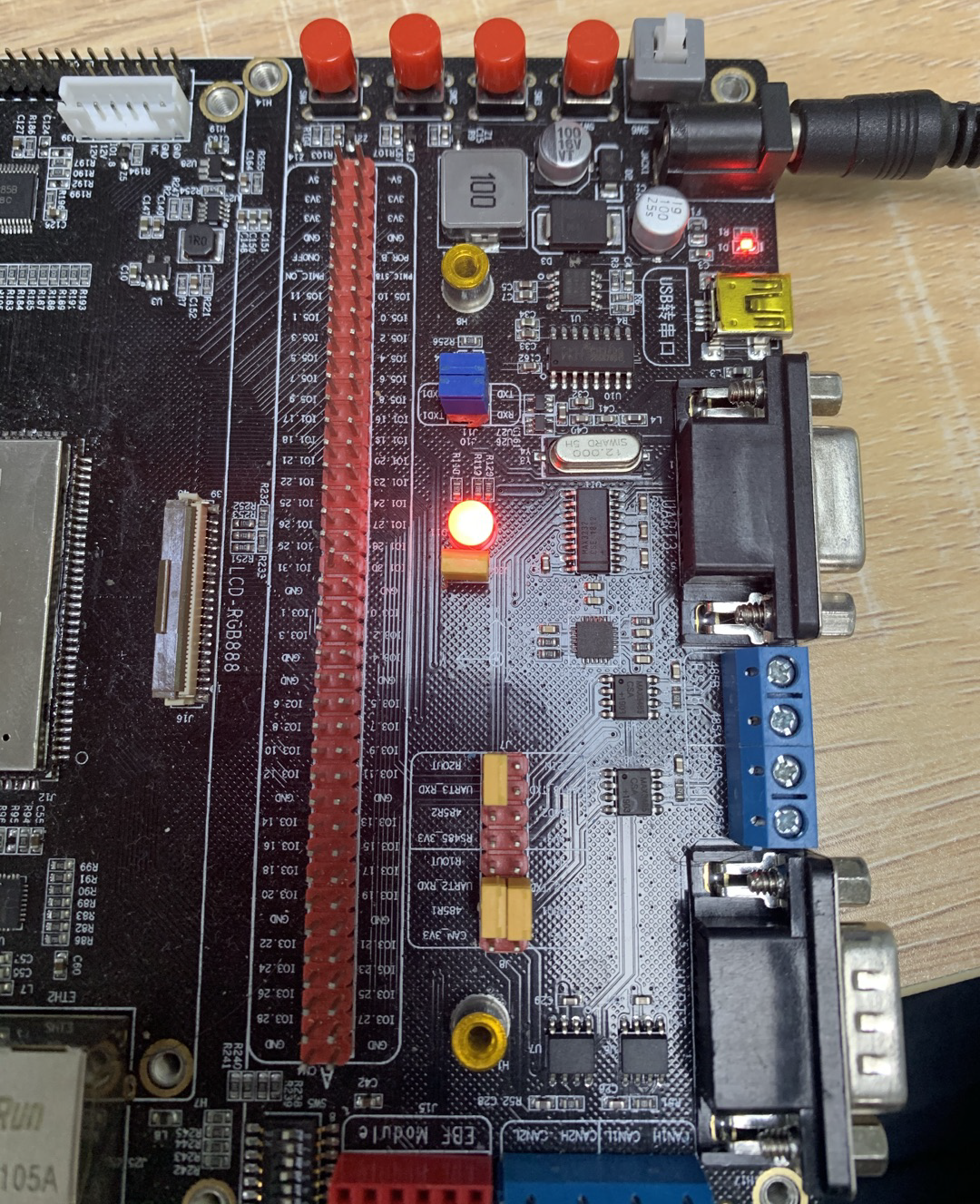

万亿参数,传输“费时”。大模型的参数量巨大,需要传输大量的数据,传统网络无法满足高带宽需求,需要接入带宽高达400G甚至达到800G的超大容量网络。

万卡集群,训练“费力”。AI大模型并行计算模式,催生了新的大规模网络架构,从千卡到万卡集群,未来更新的GPT模型可能需要十万卡、几十万卡支撑起来。而AI计算集群规模越大,通信量和复杂度越大,网络设备的规模、端口数、光模块的数量指数上升,传统网络面临越来越明显的传输效率瓶颈,一次通信延误,会拖慢整个训练过程,导致整体计算集群效能低下、成本高昂。

万里部署,使用“费心”。算力的分布式部署,全国一体化算网可以减少训练推理成本,解决算力紧缺、算力贵的问题。但跨东西部的算力流动与调度,会受限于“联接瓶颈”,抖动、时延、较长的通信时间,都会让用户身心俱疲,宁可用硬盘坐高铁送。

总而言之,在AI大模型场景和应用中,让模型供应商、算力服务商、应用开发者及用户不头疼,轻松翻越“Scaling Laws”的网络,就是先进网络。

![无缝融入,即刻智能[二]:Dify-LLM平台(聊天智能助手、AI工作流)快速使用指南,42K+星标见证专属智能方案](https://img-blog.csdnimg.cn/img_convert/4eb1e52f7a4082f5478b8894cff657ab.png)