复现nnUNet2并跑通自定义数据

- 1. 配置环境

- 2. 处理数据集

- 2.1 创建文件夹

- 2.2 数据集格式转换

- 2.3 数据集预处理

- 3. 训练

1. 配置环境

stage1:创建python环境,这里建议python3.10

conda create --n nnunet python=3.10

conda activate nnunet

stage2:按照pytorch官方链接 (conda/pip) 上的说明安装PyTorch。

nnunetv2 2.5.1 需要 torch>=2.1.2,比如:

conda install pytorch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 pytorch-cuda=11.8

但是,使用上述指令安装pytorch,很多时候还是装的cpuonly版,这里可以进行本地安装,首先搜索whl,最后的cuda版本可以自行更改。

https://download.pytorch.org/whl/cu117

最后,直接cd到下载文件所属的盘符下:

d:

cd D:\program

pip install torch-2.1.2+cu118-cp310-cp310-win_amd64.whl

stage3:git nnUnet的源代码,并配置nnUnet

git clone https://github.com/MIC-DKFZ/nnUNet.git

cd nnUNet

pip install -e .

2. 处理数据集

可以通过运行将 nnU-Net v1 中的数据集转换为 V2 nnUNetv2_convert_old_nnUNet_dataset INPUT_FOLDER OUTPUT_DATASET_NAME。请记住,v2 调用数据集 DatasetXXX_Name(而不是 Task),其中 XXX 是一个 3 位数字。请提供旧任务的路径,而不仅仅是任务名称。nnU-Net V2 不知道 v1 任务在哪里!

2.1 创建文件夹

首先,创建nnUNet_raw、nnUNet_preprocessed、nnUNet_results三个文件夹,将下载的原始数据集放到nnUNet_raw下,这里MSD挑战赛的Task02_Heart数据集为例。

nnUNet_raw用于存放原始数据集;

nnUNet_preprocessed用于存放格式转换并预处理的数据集及配置信息;

nnUNet_results用于存放训练结果相关的信息文件。

2.2 数据集格式转换

接着,我们转换数据集格式:

nnUNetv2_convert_MSD_dataset -i D:\nnUNet\nnUNet_raw\Task02_Heart

可能会出现下列错误:

TypeError: expected str, bytes or os.PathLike object, not NoneType

解决方法:

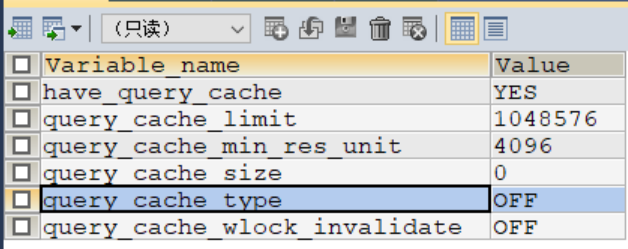

原因是没有设置相关数据集的路径,打开D:\nnUNet\nnunetv2\paths.py文件

方法1:直接在这个py文件指定数据集路径:

方法2:

设置环境变量:

1.windows:

#这个变量只在当前命令提示符会话中有效,不会被保存到系统环境变量中

set nnUNet_raw=D:/nnUNet/nnUNet_raw

set nnUNet_preprocessed=D:/nnUNet/nnUNet_preprocessed

set nnUNet_results=D:/nnUNet/nnUNet_results

2.linux:

export nnUNet_raw="D:/nnUNet/nnUNet_raw"

export nnUNet_preprocessed="D:/nnUNet/nnUNet_preprocessed"

export nnUNet_results="D:/nnUNet/nnUNet_results"

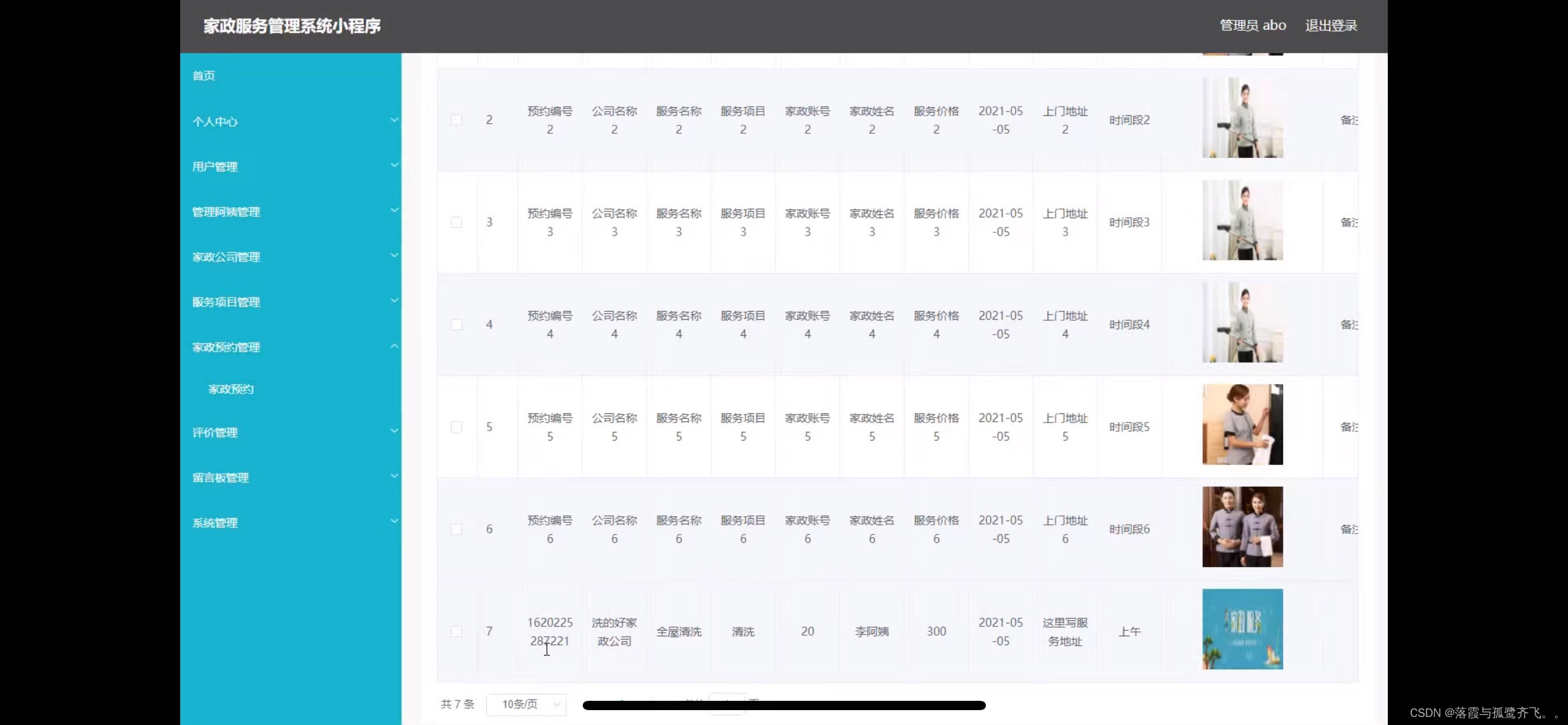

发现,转换成功,生成了1个Dataset002_Heart文件夹:

转换前后主要区别在于:

1、文件夹由Task02_Heart变成Dataset002_Heart。

ps:文件夹命名为:Dataset+三位整数+任务名,Dataset002_Heart中数据集ID为2,任务名为Heart。此文件夹下存放需要的训练数据集imageTr、测试集imageTs、标签labelsTr。其中labelsTr是与imageTr中一一对应的标签,文件中都是nii.gz文件。imageTs是可选项,可以没有。

2、原始json中是:

转换后,字典的key为"channel_names":

3、原始json中有"training"、"test"这两个key存放数据集的相对路径:

转换后,字典的key为"file_ending",直接记录数据集的后缀名即可:

2.3 数据集预处理

nnUNetv2_plan_and_preprocess -d DATASET\_ID --verify_dataset_integrity

#这里我是用的是Dataset002_Heart,将ID改为2

nnUNetv2_plan_and_preprocess -d 2 --verify_dataset_integrity

运行成功后,会在nnUNet_preprocessed文件下生成如下文件:

此步骤主要就是对数据进行:裁剪crop,重采样resample以及标准化normalization。将提取数据集fingerprint(一组特定于数据集的属性,例如图像大小、体素间距、强度信息等)。此信息用于设计三种 U-Net 配置。每个管道都在其自己的数据集预处理版本上运行。其中的nnUNetPlans.json是网络结构相关的配置文件。

3. 训练

训练使用如下脚本指令:

nnUNetv2_train DATASET_NAME_OR_ID UNET_CONFIGURATION FOLD [additional options, see -h]

DATASET_NAME_OR_ID 指定应在哪个数据集上进行训练;UNET_CONFIGURATION 是一个字符串,用于标识所请求的 U-Net 配置(默认值:2d、3d_fullres、3d_lowres、3d_cascade_lowres);

FOLD 指定训练 5 折交叉验证中的哪一折。

根据数据集名称或者数据集的ID、UNET配置、折数FOLD,进行训练:

nnUNetv2_train 2 2d 0

成功开始训练: