【大模型LLMs】LLMs-based Summarization方法梳理

- Survey

- 1 Knowledge Distillation from LLMs

- Referee

- InheritSumm

- 2 Prompt Engineering

- 2.1 Template Engineering

- OdSum

- 2.2 CoT

- SumCoT

- CoD

- SuRe

- SliSum

- Refiner

梳理基于大模型的摘要总结方案,持续汇总中(更关注query-focused summarization)

Survey

论文: A Comprehensive Survey on Process-Oriented Automatic Text Summarization with Exploration of LLM-Based Methods

来源: arxiv 2024(投稿TKDE)

作者单位: 西南财经大学

核心结论: 大模型的ATS(Automatic Text Summarization)主要分3类(知识蒸馏、大模型微调、提示工程)

1 Knowledge Distillation from LLMs

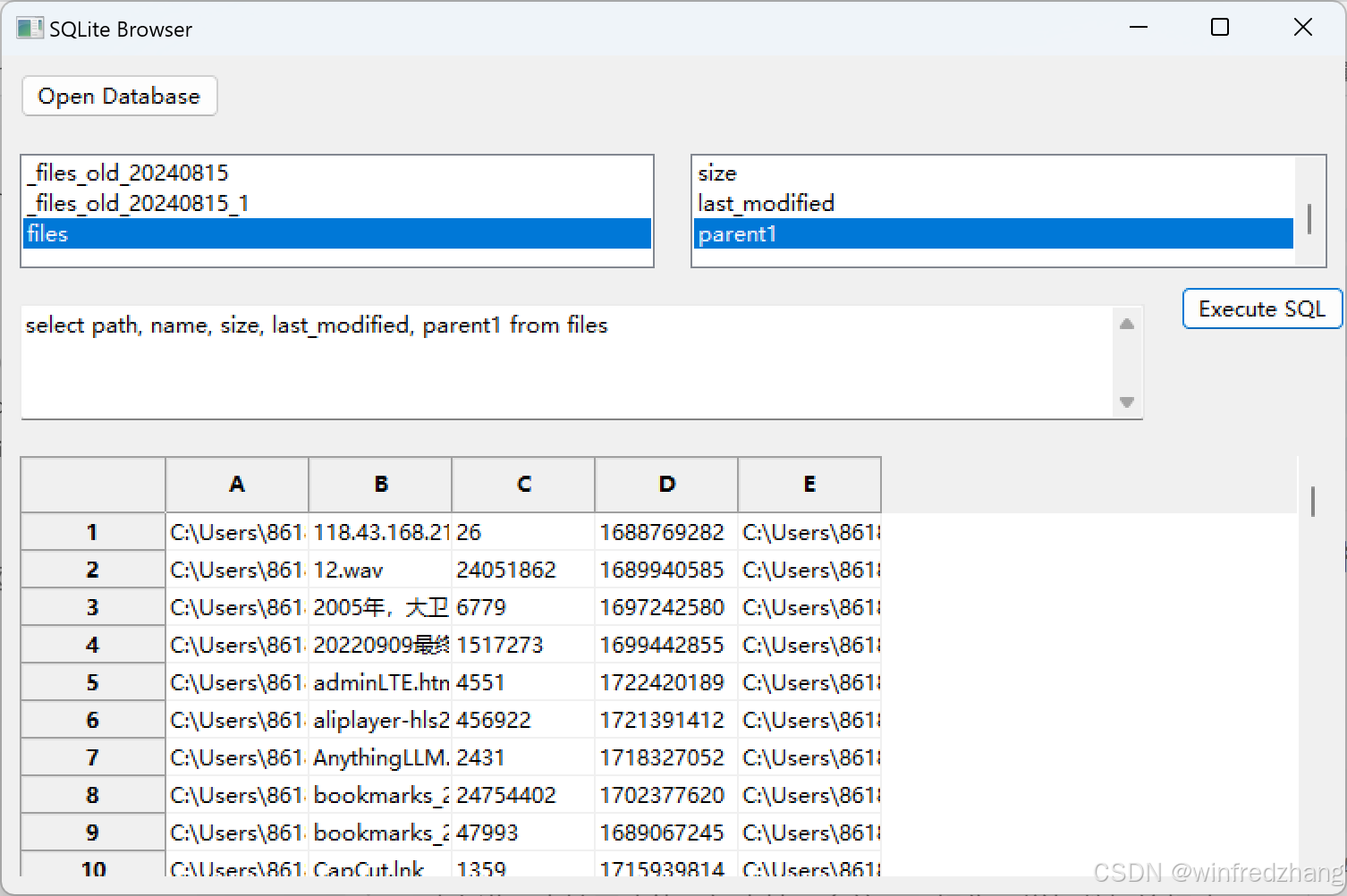

Referee

论文: REFEREE: Reference-Free Sentence Summarization with Sharper Controllability through Symbolic Knowledge Distillation

来源: EMNLP 2022

作者单位: University of Washington、Carnegie Mellon University、Allen Institute for Artificial Intelligence

核心结论: 提出一种在无参考(reference-free)的情况下进行训练的句子摘要框架,同时允许直接控制压缩比

具体流程:

- 知识蒸馏: 遵循teacher-student架构,但student模型在连续迭代中轮流成为teacher

![[图片]](https://i-blog.csdnimg.cn/direct/826f09551c814d3daba5a251cd1aad97.png)

- 过滤器:

- 保真度过滤器(摘要应该包含在输入句子中)

- 长度过滤器(通过限制压缩比)

- 上下文过滤器(基于NSP任务)

InheritSumm

论文: InheritSumm: A General, Versatile and Compact Summarizer by Distilling from GPT

来源: EMNLP 2023

作者单位: 微软

核心结论: 基于GPT3.5生成摘要,和高质量的人工标注文档一起作为训练语料,用于训练small LM

2 Prompt Engineering

2.1 Template Engineering

OdSum

论文: ODSum: New Benchmarks for Open Domain Multi-Document Summarization

来源: arxiv 2023

作者单位: 浙江大学、耶鲁大学、Allen Institute for AI

核心结论: 提供一个open-domail multi-document summarization数据集,采用retrieve-then-summarize的pipeline,对多篇文档进行summarization

2.2 CoT

SumCoT

论文: Element-aware Summarization with Large Language Models: Expert-aligned Evaluation and Chain-of-Thought Method

来源: ACL 2023

作者单位: 上海交通大学

核心结论: 将“Lasswell Communication Model”引入摘要模型,首先让大模型回答一系列问题(最重要的实体entity、最重要的时间date、什么事件event、事件结果result),进而完成summarization(element-aware),总结时需要注意流畅性(拼写、语法等问题)、连贯性(前后连贯,上下文)、一致性(无幻觉)、相关性(找到文本的核心关注点)

CoD

论文: From Sparse to Dense: GPT-4 Summarization with Chain of Density Prompting

来源: ACL WorkShop 2023

作者单位: 哥伦比亚大学、麻省理工大学

核心结论: Chain of Density,基于提示的迭代方法。prompt中提示“总结越来越简洁、实体密集”,通过多次生成摘要,每次都“反思”上一次摘要中遗漏的实体,然后编写新的、越来越密集的摘要,涵盖识别到的每个实体

SuRe

论文: SuRe: Summarizing Retrievals using Answer Candidates for Open-domain QA of LLMs

来源: ICLR 2024

作者单位: Carnegie Mellon University、KAIST AI、University of Michigan、Naver AI Lab、Naver Cloud

核心结论: 针对候选答案,由LLMs为参考答案汇总支撑条件,再进行验证(critique的效果)

SliSum

论文:Improving Faithfulness of Large Language Models in Summarization via Sliding Generation and Self-Consistency

来源: IREC-COLING 2024

作者单位: 浙江大学

核心结论: LLMs提取摘要可能更倾向于提取开头结尾的内容,尤其在长摘要里;针对该问题,SliSum通过滑动窗口和self-consistency的思想,对每个窗口的内容生成局部摘要,然后使用聚类和投票法聚合所有的局部摘要

Refiner

论文:Refiner: Restructure Retrieval Content Efficiently to Advance Question-Answering Capabilities

来源: arxiv

作者单位: 香港科技、清华、香港理工

核心结论: 对检索的内容进行重写,提取查询相关内容以及必要的上下文,并进行分段处理

- 知识蒸馏: 多个大模型提取输入内容中与query相关内容的完整上下文,构建训练集

- 微调: 对Llama-2-7B进行SFT得到refiner(随着prompt长度的增加,参数量更大的模型微调的计算成本更高,所以选择参数量小的模型)