MinIO 推出针对 AI 应用的 DataPOD 参考架构

MinIO 设计了一种旨在为 AI 训练提供数据的 exascale DataPOD 参考架构。这家开源对象存储软件供应商正将其可扩展至100 PiB(即大约112.6 PB)的单元定位为一种替代方案,以取代使用 GPU Direct 技术快速向 Nvidia 的高性能GPU供应数据的并行文件存储系统——同时借鉴了 Nvidia 的 SuperPOD 概念。MinIO 称其覆盖了 AI 数据管道的所有阶段:数据收集与摄入、预处理、向量化、模型训练与检查点、模型评估与测试以及模型部署与监控。

解决网络瓶颈问题

MinIO 指出:“AI 工作负载部署中的网络基础设施已经标准化为每秒 100 吉比特(Gbit/sec)带宽链接。现代 NVMe 驱动器平均提供 7 GBit/sec 的吞吐量,这使得存储服务器和 GPU 计算服务器之间的网络带宽成为 AI 管道执行性能的瓶颈。”这就是 Nvidia 发明 GPU Direct 的原因所在。

MinIO 认为无需使用复杂的 InfiniBand:“我们建议企业利用现有的基于行业标准的以太网解决方案(例如 HTTP over TCP),这些方案开箱即用,能够为 GPU 提供高吞吐量的数据。”这些解决方案具有:“高速互联(800GbE 以上)和 RDMA over Ethernet 支持(例如 RoCEv2)”。

对象存储的优势

根据 MinIO 的说法:“对象存储擅长处理各种数据格式和大量非结构化数据,并且可以轻松扩展以容纳不断增长的数据而不影响性能。”此外,MinIO 认为其对象存储可以轻松扩展到 exabyte 级别,以满足 AI 管道存储的需求,并且具有足够的性能。其中一个方面是 MinIO 具有:“分布式内存缓存,非常适合 AI 模型检查点使用案例。”

性能特点

一份名为“面向 AI 数据基础设施的高性能对象存储”的白皮书指出:“MinIO 的性能特性意味着您可以运行多个 Apache Spark、Presto/Trino 和 Apache Hive 查询,或者快速测试、训练和部署 AI 算法,而不会遇到存储瓶颈。”

该白皮书声称:“在模型训练过程中,MinIO 的分布式设置允许并行数据访问和 I/O 操作,减少了延迟并加速了训练时间。对于模型部署,MinIO 的高吞吐量数据访问确保了 AI 模型的快速检索和部署,并能够在最小的延迟下做出预测。更重要的是,MinIO 的性能可以线性地从数百 TB 扩展到数百 PB 甚至更多。”

根据性能基准测试,一个分布式的 MinIO 设置在一个 8 节点集群中实现了平均 46.54 GBit/sec 的读取吞吐量(GET)和 34.4 GBit/sec 的写入吞吐量(PUT)。一个 32 节点集群则达到了 349 GBit/sec 的读取吞吐量和 177.6 GBit/sec 的写入吞吐量。

MinIO 表示,它拥有达到 2.75 TBit/sec 读取速度的 300 台服务器的客户部署实例。我们可以认为 MinIO 设置可以实现与 GPU Direct 类似的整体速度,但没有找到 MinIO 系统与支持 GPU Direct 的并行文件系统在提供相同总体带宽方面的直接比较。因此,我们无法直接比较 MinIO 与例如 VAST Data 系统在服务器、存储和网络组件的数量和成本方面的差异,即使两者都能提供 349 GBit/sec 的读取吞吐量和 177.6 GBit/sec 的写入吞吐量。

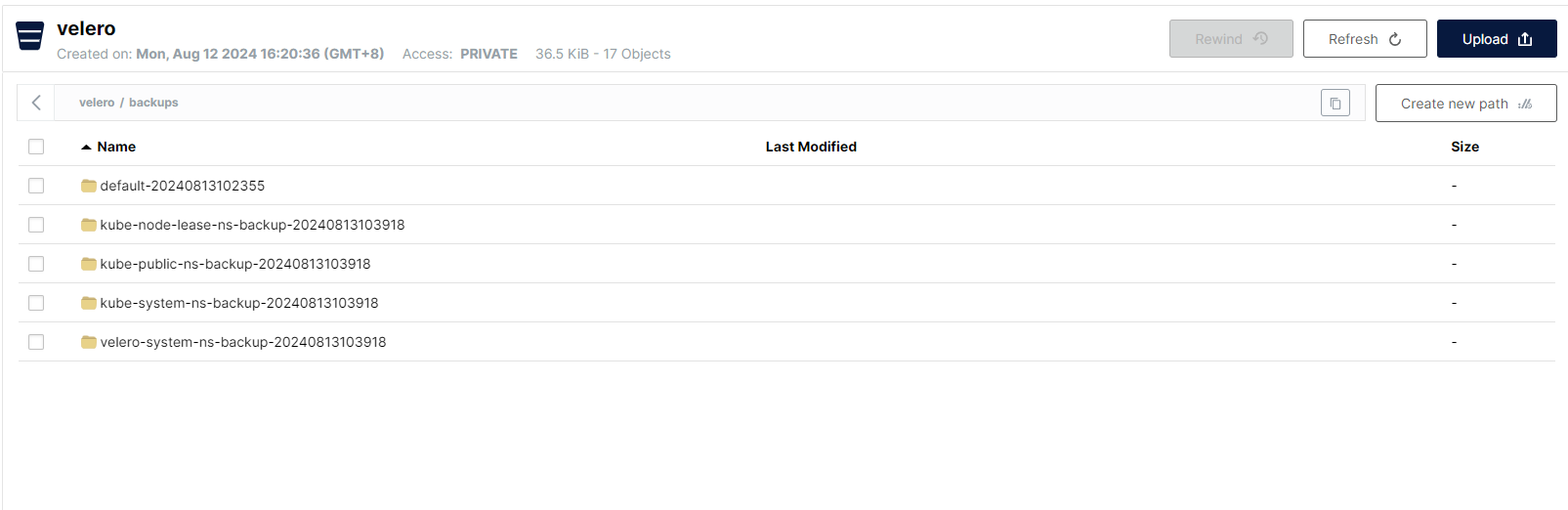

DataPOD 重复单元

DataPOD 白皮书称:“企业客户使用 MinIO 进行 AI 项目构建 exabyte 级别的数据基础设施作为重复单元,每个单元为 100 PiB。”这些单元包含 30 个机架,每个机架包含 11 台 2RU 存储服务器、2 个 Layer 2 顶部机架交换机、一个管理交换机,以及 10 个 64 端口网络脊交换机。

存储服务器是一个 2RU、单插槽 64 核 CPU 系统,具有 128 个 PCIe 4 通道、256 GB 内存、双端口 200GbE 网络接口卡、24 个 U.2 驱动器托架,每个托架安装一个 30 TB NVMe SSD,总共提供 720 TB 的原始容量。参考架构文档指定了 Supermicro A+ 2114SWN24RT、Dell PowerEdge R761 机架服务器和 HPE ProLiant DL345 Gen 11 作为有效的服务器选项。

据估算,这样的设置每月硬件成本为每 TB 1.5 美元,软件成本为每 TB 3.54 美元——即每月硬件费用为 1,500 美元,软件费用为 3,540 美元,总计为 5,040 美元。

MinIO 认为:“特定供应商的一体化硬件设备用于 AI 将导致高昂的总体拥有成本(TCO),并且从单位经济效益角度来看,在大规模数据 AI 项目中不具备可扩展性。”

他们还主张:“公共云中的 AI 数据基础设施都是基于对象存储构建的。这是因为公共云提供商不想保留与 POSIX 相关的复杂性和繁琐性。对于私有云/混合云部署来说,同样的架构也应该如此。”

MinIO 进一步断言:“随着高性能 GPU 的发展和网络带宽标准化为 200/400/800 Gbit/sec 及以上,专门构建的对象存储将是唯一能够满足 AI 工作负载性能 SLA 和规模要求的解决方案。”

DDN(Lustre)、IBM(StorageScale)、NetApp、PEAK:AIO、Pure Storage、Weka 以及 VAST Data ——这些支持 GPU Direct 的并行文件存储供应商——可能会不同意这一观点。