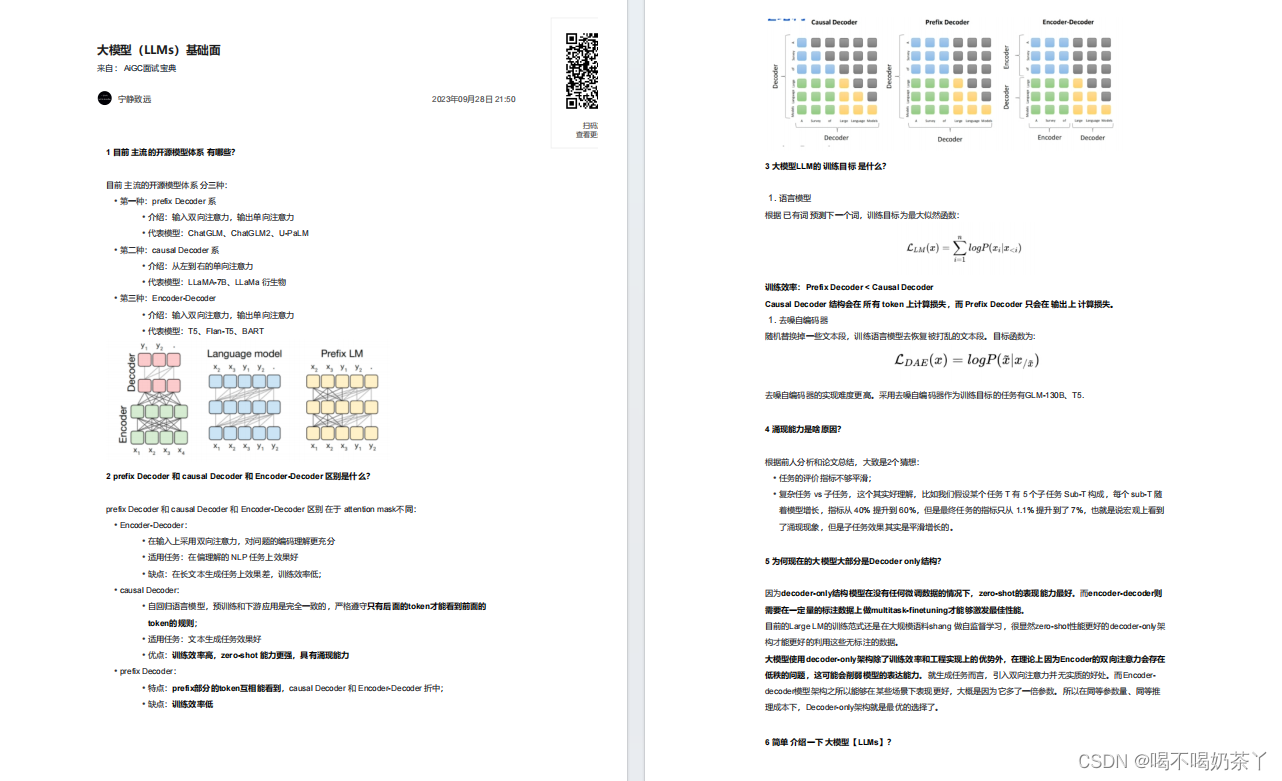

问题1、Decoder-Only和Encoder-Decoder模型相比有什么优势?在训练和推理效率上有什么区别?****

Decoder-Only模型:结构较为简洁,通常只由一个解码器组成。模型参数较少,相比于Encoder-Decoder模型在训练和推理上可能更高效。在自回归生成任务中表现优异,比如语言模型生成文本。

训练和推理效率:

训练效率:

Decoder-Only 模型:在训练过程中,由于模型仅处理解码器部分,参数较少,训练效率较高。

Encoder-Decoder 模型:由于需要同时训练编码器和解码器部分,模型的参数量通常较大,因此训练效率相对较低。

推理效率:

Decoder-Only 模型:推理过程中模型依赖先前生成的标记,因此推理时间较长,尤其在生成长文本时。

Encoder-Decoder 模型:推理时编码器只需处理一次输入,但解码器部分的推理仍然逐步进行,因此总的来说推理时间也较长,但对于复杂任务而言,效率可能更好。

问题2、说一下LLaMA LLaMA2 LLaMA3的区别?****

Llama-1有7B、13B、30B和65B四个参数量版本。Llama-1各个参数量版本都在超过1T token的语料上进行了预训训练。

相比于Llama-1,Llama-2将预训练的语料扩充到了 2T token,同时将模型的上下文长度从2,048翻倍到了4,096,并引入了分组查询注意力机制(grouped-query attention, GQA)等技术。

与Llama 2相比,Llama-3将tokenizer由sentencepiece换成了tiktoken,这与GPT4 保持一致。同时,词表大小由32k扩展到了128k。另外,为了提高模型效率,Llama-3 8B和70B都采用了GQA。同时上下文长度也扩展到了8k。

问题3、有哪些位置编码,其特点是什么?****

绝对位置编码:

固定正弦-余弦位置编码:最早由 Transformer 引入,使用不同频率的正弦和余弦函数将位置信息编码到每个标记中。

特点:固定不变,无需训练;能够保留序列顺序信息。

相对位置编码:

相对位置编码:相对于其他标记的位置信息,而不是绝对位置。常用于改进 Transformer 模型,如 Transformer-XL。

特点:在处理长序列时表现更好,能够捕捉到序列中不同位置之间的关系。

Learnable Position Encoding(可学习位置编码):

特点:直接在模型中引入可训练的参数来表示位置编码,允许模型自己学习最优的位置信息表示。

应用:在 GPT-3 等大型模型中广泛应用。

问题4、介绍一下MoE模型?****

MoE (Mixture of Experts) 模型是一种多专家模型,通过引入多个专家(子模型),每个专家擅长处理特定类型的数据。

Gating 机制:在模型中,使用 gating 机制(例如 softmax 函数)选择哪些专家参与推理或训练,从而提高模型效率。

稀疏激活:模型中的每个样本只激活一部分专家,这使得 MoE 模型在处理大规模数据时非常高效。

优势:

计算效率高:由于仅激活部分专家,MoE 模型可以在保证模型容量的情况下减少计算开销。

可扩展性强:通过增加专家的数量,可以轻松扩展模型容量而不显著增加计算成本。

应用场景:通常用于大型语言模型和推荐系统中,能够处理复杂、多样化的任务。

问题5、说一下beam search算法,为什么用的少了?****

Beam Search 是一种常用于序列生成任务的启发式搜索算法,它通过保留若干(称为 beam size)的最佳候选序列,逐步生成最终输出序列。

特点:相比贪心算法,Beam Search 可以避免局部最优解,生成质量更高的序列。

使用减少的原因:

计算复杂度高:Beam Search 需要同时跟踪多个候选序列,计算量较大,推理速度慢。

模型更新:近年来,随着生成模型(如 Transformer)的改进,模型自身在生成时能够更好地捕捉全局信息,因此对 Beam Search 的依赖降低。

替代方法:诸如 Sampling(采样)等方法,通过在输出时引入随机性,能够生成质量较好的序列,同时避免 Beam Search 的高计算成本。

问题6、假如需要上线一个公文写作的大模型,具体流程应当是怎样的?****

- 需求分析:

确定模型的功能需求,例如支持哪些文体的公文写作、支持的语言种类、生成的风格要求等。

确定目标用户群体和使用场景,例如是否面向政府机构或企业。

- 数据收集与预处理:

收集大规模的公文数据集,涵盖多种公文类型(如通知、报告、意见等)。

对数据进行清洗和标注,确保数据的质量和多样性,处理敏感信息和数据偏见问题。

- 模型选择与训练:

选择合适的预训练模型(如 GPT、BERT 等)作为基础模型。

在公文数据集上进行进一步的微调,确保模型能够生成符合公文写作规范的文本。

使用监督学习、强化学习等技术提高模型的生成质量,减少生成的错误和不合适的内容。

- 评估与优化:

使用自动化评估指标(如 BLEU、ROUGE)和人工评估(如人类专家打分)对模型进行评估。

根据评估结果调整模型参数、优化算法,必要时扩展训练数据集。

附上技术清单

在这里,我们想要强调的是:成功求职并不是一件难事,关键在于你是否做好了充分的准备。通过学习和掌握AI技术的相关知识和技能,了解面试中可能出现的问题和技巧,你就能够在面试中展现出自己的专业素养和实力,赢得面试官的青睐和认可。因此,让我们一起努力,用知识和技能武装自己,迎接AI时代的挑战和机遇吧!

有需要的朋友可以扫描下方二维码,免费获取更多相关资料!

最后,祝愿所有转行、求职的同学都能够在AI产品面试中取得优异的成绩,找到心仪的工作!加油!

大模型基础面

大模型进阶面

大模型微调面

大模型langchain面

大模型推理面

更多面试题分享