目录

写在前面

1、Haproxy简介

2、Haproxy的安装和基本配置信息

2.1、haproxy的安装

2.2haproxy的基本配置信息

2.2.1基本配置文件global参数

2.2.2基本配置文件proxys的相关参数

2.2.2.1 default的相关参数

2.2.2.2 frontend的相关配置

2.2.2.3 backend的相关配置

对于server配置参数的补充

3、haproxy热更新-socat

4、haproxy调度算法

4.1、静态算法

4.1.1、static-rrr:基于权重的轮询调度

4.1.2、first

4.2、动态算法

4.2.1、roundrobin

4.2.2、leastconn

4.3、其他算法

4.3.1、source

4.3.1.1、Source静态算法---map-base 取模法

4.3.1.2、一致性hash算法

4.3.2、uri

4.3.2.1、uri静态算法

4.3.2.2、uri动态算法

4.3.3、url_param

4.3.3.1、url_param静态算法

4.3.3.2、url_param动态算法

4.3.4、hdr

4.3.4.1、hdr静态算法

4.3.4.2、hdr动态算法

6、HAProxy状态页

7、IP透传

8、ACL

9、错误日志定向

10、四层tcp负载均衡数据库

11、Haproxy https实现

写在最后

慢启动

hash取模算法

写在前面

了解haproxy之前希望你能了解一定的负载均衡原理,这会对你了解haproxy有不小的帮助

详情请见http://t.csdnimg.cn/ijWYa

注:所有不清楚的知识点都可以在写在最后目录下找到

1、Haproxy简介

HAProxy是法国开发者 威利塔罗 (Willy Tarreau) 在 2000 年使用 C 语言开发的一个开源软件是一款具备高并发( 万级以上 ) 、高性能的 TCP 和 HTTP 负载均衡器,支持基于cookie 的持久性(不怎么用的到了),自动故障切换(这个很棒),支持正则表达式及 web 状态统计,支持动态更改服务器状态。社区版网站: http://www.haproxy.org

2、Haproxy的安装和基本配置信息

| 主机 | IP | 角色 |

| haproxy | 192.168.220.100 | 负载均衡调度器 |

| server1 | 192.168.220.150 | db1 |

| server2 | 192.168.220.200 | db2 |

2.1、haproxy的安装

这里haproxy采用的安装方式是配置rhel9的本地源,直接从本地源里下载

#创建挂载目录

mkdir /rhel9

#将挂载命令写入开机自启文件中,并授予该文件执行权限

echo "mount /dev/cdrom /rhel9" > /etc/rc.d/rc.local

chmod +x /etc/rc.d/rc.local

#写一个repl9的repo文件

[AppStream]

name=AppStream

baseurl=file:///rhel9/AppStream/ #本地yum源的配置

gpgcheck=0

[BaseOS]

name=BaseOS

baseurl=file:///rhel9/BaseOS/

gpgcheck=0

#下载haproxy

yum install haproxy -y2.2haproxy的基本配置信息

haproxy配置文件:/etc/haproxy/haproxy.cfg

2.2.1基本配置文件global参数

#打开配置文件

vim /etc/haproxy/haproxy.cfg

global #全局参数

log 127.0.0.1 local2 #日志存放目录,具体后续在/etc/rsyslog.conf

chroot /var/lib/haproxy #锁定运行目录

pidfile /var/run/haproxy.pid #指定Pid所在文件

maxconn 4000 #指定最大连接数,建议十万

user haproxy #指定用户

group haproxy #指定用户组

nbproc 2 #开启的haproxy的进程数,默认进程数为1

# nbthread 1 #指定每个haproxy进程开启的线程数,默认为每个进程一个线程,不能和nbproc共存

cpu-map 1 0 #将第一个进程绑定至0号CPU

maxsslconn 100000 #haproxy进程ssl最大连接数,用于https场景下

maxconnrate 100 #每个进程每秒创建的最大连接数量

daemon #以守护进程运行

# turn on stats unix socket

stats socket /var/lib/haproxy/stats #套接字文件

# utilize system-wide crypto-policies

ssl-default-bind-ciphers PROFILE=SYSTEM

ssl-default-server-ciphers PROFILE=SYSTEM2.2.2基本配置文件proxys的相关参数

2.2.2.1 default的相关参数

defaults

mode http #七层负载均衡,tcp为四层

log global #日志,根据global参数

option httplog #log选项,采集http会话相关的各种属性值

#包括HTTP请求、会话状态、源地址、连接时间等

option http-keep-alive #开启与客户端的会话保持

option dontlognull #log选项,不采集空会话连接日志

option http-server-close #等待客户端完整HTTP请求的时间,此处为等待10s

option forwardfor except 127.0.0.0/8 #透传客户端真实IP至后端web服务器,除lo外

option redispatch #当连接的服务器挂掉后,强制连接其他健康的server

retries 3 #连接后端服务器最多尝试次数

timeout http-request 10s #等待客户端请求完全被接收和处理的最长时间

timeout queue 1m #设置删除连接和客户端收到503信息前的等待时间

timeout connect 10s #设置等待服务器连接成功的时间

timeout client 1m #设置允许客户端处于非活动状态的时间

timeout server 1m #设置服务端超时的时间

timeout http-keep-alive 10s #session 会话保持超时时间

#此时间段内会转发到相同的后端服务器

timeout check 10s #指定后端服务器健康检查的超时时间

maxconn 3000 #指定一个haproxy进程最大的连接数

errorfile 503 /etc/errorpage/503.http #配置503,当报503时,使其访问定义的文件

errorloc 503 https://www.baidu.com #配置503,当报503时,使其重定向到百度default中这三个时间不好区分理解,采用画图方式理解

- option http-server-close

- timeout http-request

- timeout connect

2.2.2.2 frontend的相关配置

frontend webcluster #名字随意起

bind *:80 #监听的主机和端口 *表示任意,格式是IP:Port

mode http #采用几层负载均衡

use_backend webcluster-host #调用的backend2.2.2.3 backend的相关配置

backend webcluster-host #名字需要与frontend使用的backend名称一致

balance roundrobin #采用的算法是轮询

server web1 192.168.220.150:80 #后端服务器主机

server web2 192.168.220.200:80 #后端服务器主机对于server配置参数的补充

listen webserver_80

bind *:80

mode http

balance roundrobin

server web1 192.168.220.150:80 check inter 2 fall 2 rise 3

server web2 192.168.220.200:80 check inter 2 fall 2 rise 3 weight 2

server web3 192.168.220.100:8080 backu3、haproxy热更新-socat

我的haproxy配置

使用工具socat需要先在下载并修改haproxy配置文件,以下配置是socat热更新单进程的配置

socat动态热更新多进程

socat命令(重启失效)

- 查看帮助:echo "help" | socat stdio /var/lib/haproxy/stats

- 查看haproxy状态:echo "show info" | socat stdio /var/lib/haproxy/stats

- 查看集群状态:echo "show servers state" | socat stdio /var/lib/haproxy/stats

- 查看集群权重:echo "get weight myhaback/web1" | socat stdio /var/lib/haproxy/stats

- 设置集群权重:echo "set weight myhaback/web2 2" | socat stdio /var/lib/haproxy/stats

- 下线后端服务:echo "disable server myhabck/web1" | socat stdio/var/lib/haproxy/stats

- 上线后端服务:echo "enable server myhaback/web1" socat stdio /var/lib/haproxy/stats

4、haproxy调度算法

4.1、静态算法

静态算法:按照事先定义好的规则轮询公平调度,不关心后端服务器的当前负载、连接数和响应速度 等,且无法实时修改权重(只能为 0 和 1, 不支持其它值 ) ,只能靠重启 HAProxy 生效。

4.1.1、static-rrr:基于权重的轮询调度

-

不支持端服务器慢启动

-

其后端主机数量没有限制,相当于 LVS 中的 wrr

配置如下

验证:按照权重分配,访问9次,应是三次web1,6次web2

4.1.2、first

-

根据服务器在列表中的位置,自上而下进行调度

-

其只会当第一台服务器的连接数达到上限,新请求才会分配给下一台服务

-

其会忽略服务器的权重设置

配置如下

验证,如是first,那么全部的访问都应打向web1

4.2、动态算法

基于后端服务器状态进行调度适当调整,新请求将优先调度至当前负载较低的服务器,权重可以在haproxy运行时动态调整无需重启

4.2.1、roundrobin

先看负载,再看权重

相同权重,不同负载,选负载低的

不同权重,相同负载,选权重高的

不同权重,不同负载,选负载低的

-

基于权重的轮询动态调度算法

-

HAProxy 中的 roundrobin 支持慢启动

-

其每个后端 backend 中最多支持 4095 个 real server

-

roundrobin 为默认调度算法

配置如下

验证:其效果应与静态算法static-rr 调度算法效果一致,三次web1,6次web2

4.2.2、leastconn

-

leastconn加权的最少连接的动态

-

支持权重的运行时调整和慢启动,即 : 根据当前连接最少的后端服务器而非权重进行优先调度 ( 新客户端连接)

-

比较适合长连接的场景使用,比如: MySQL 等场景

配置如下

验证,可动态改变权重,但是调度与权重无关,所以对于短连接来说,效果应近似于两个主机权重皆为1的静态调度算法static-rr

没想到短链接leastconn的效果完全与两个主机权重皆为1的静态调度算法static-rr的效果一致

4.3、其他算法

其它算法即可作为静态算法,又可以通过选项成为动态算法

4.3.1、source

源地址hash,基于用户源地址hash并将请求转发到后端服务器,后续同一个源地址请求将被转发至同一 个后端web服务器。

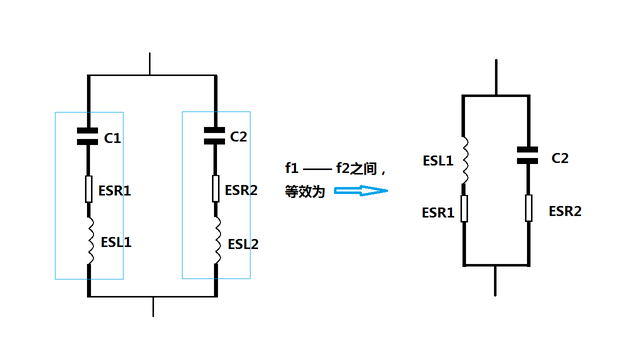

此方式当后端服务器数据量发生变化时,会导致很多用户的请求转发至新的后端服务器,默认为静态方式,但是可以通过hash-type 支持的选项更改

适用场景:这个算法一般是在不插入Cookie的TCP 模式下使用,也可给拒绝会话cookie 的客户提供最好的会话粘性,适用于 session 会话保持但不支持 cookie和缓存的场景源地址有两种转发客户端请求到后端服务器的服务器选取计算方式,分别是取模法和一致性hash

验证:因源地址不变,打向的后端服务器也不会变,所以访问全与第一次访问一致

4.3.1.1、Source静态算法---map-base 取模法

map-based:取模法,对 source 地址进行 hash 计算,再基于服务器总权重的取模,最终结果决定将此请求转发至对应的后端服务器。此方法是静态的,不支持在线调整权重,不支持慢启动,可实现对后端服务器均衡调度缺点是当服务器的总权重发生变化时,即有服务器上线或下线,都会因总权重发生变化而导致调度结果整体改变而且通常为了节约IT成本,一个公司往往只会有1个公网IP,那么当这个公司内用户访问服务器时,所有的流量都会打向同一个服务器,导致负载失衡。

配置如下

frontend webcluster bind *:80 mode http use_backend webcluster-host backend webcluster-host balance source server web1 192.168.220.150:80 check inter 2 fall 2 rise 3 weight 2 server web2 192.168.220.200:80 check inter 2 fall 2 rise 3 weight 1验证:不同的主机去访问haproxy服务器,根据总权重3,hash会将其hash(IP)之后对总权重3 取模,将其分向后端对应的服务器,且若IP没有改变,服务器没有下线,则流量流向不会变

4.3.1.2、一致性hash算法

一致性哈希,当服务器的总权重发生变化时,对调度结果影响是局部的,不会引起大的变动;该hash算法是动态的,支持使用 socat 等工具进行在线权重调整,支持慢启动算法:

- 后端服务器哈希环点keyA=hash(后端服务器虚拟ip)%(2^32)

hash环在服务器节点较少的情况下或许会发生hash环偏斜问题

hash环偏斜问题:Hash 环偏斜指的是在将数据或任务映射到 Hash 环上时,分布不均匀,导致某些节点承担了过多的负载,而其他节点负载较轻。

一致性 hash 示意图后端服务器在线与离线的调度方式

配置如下

frontend webcluster bind *:80 mode http use_backend webcluster-host backend webcluster-host balance source hash-type consistent server web1 192.168.220.150:80 check inter 2 fall 2 rise 3 weight 2 server web2 192.168.220.200:80 check inter 2 fall 2 rise 3 weight 1

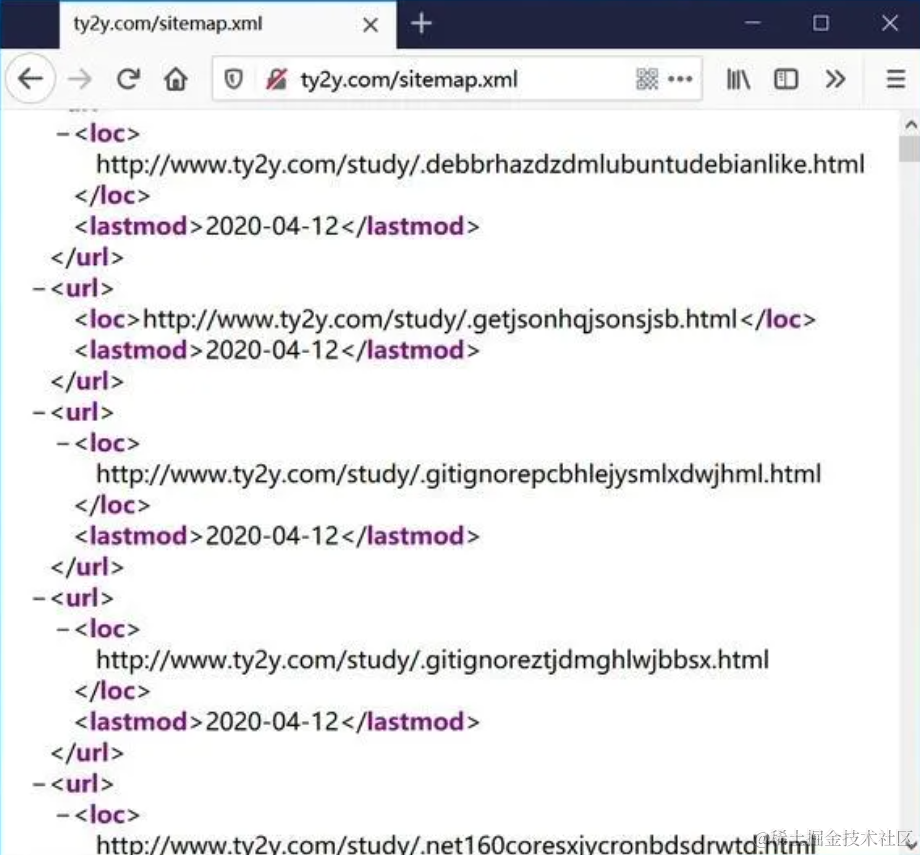

4.3.2、uri

uri仅支持http应用层,不支持tcp传输层

基于对用户请求的URI的左半部分或整个 uri 做 hash ,再将 hash 结果对总权重进行取模后根据最终结果将请求转发到后端指定服务器,适用于后端是缓存服务器场景,默认是静态算法,也可以通过hash-type 指定 map-based 和 consistent ,来定义使用取模法还是一致性hash

<scheme>://<user>:<password>@<host>:<port>/<path>;<params>?<query>#<frag><scheme>:协议<user>:用户<password>:密码<host>:域名或IP<port>:端口<params>:执行的命令<query>:字段<frag>:分段,分片,类似于索引左半部分: /<path>;<params>uri:/<path>;<params>?<query>#<frag>

4.3.2.1、uri静态算法

配置如下

haproxy

RS1

RS2

验证结果

4.3.2.2、uri动态算法

配置如下

haproxy

4.3.3、url_param

url_param对用户请求的 url 中的 params 部分中的一个参数 key 对应的 value 值作 hash 计算,并由服务器总权重相除以后派发至某挑出的服务器, 后端搜索同一个数据会被调度到同一个服务器,多用与电商通常用于追踪用户,以确保来自同一个用户的请求始终发往同一个real server,如果无没key ,将按 roundrobin 算法注:url_param指的是url组成中的“;<params>?<query>#”部分

4.3.3.1、url_param静态算法

配置如下

listen webcluster bind *:80 mode http balance url_param name,id server webserver1 192.168.220.150:80 weight 1 check inter 3s fall 3 rise 5 server webserver2 192.168.220.200:80 weight 1 check inter 3s fall 3 rise 5

4.3.3.2、url_param动态算法

配置如下

listen webcluster bind *:80 mode http balance url_param name, id hash-type consistent server webserver1 192.168.220.150:80 weight 1 check inter 3s fall 3 rise 5 server webserver2 192.168.220.200:80 weight 1 check inter 3s fall 3 rise 5

4.3.4、hdr

针对用户每个 http 头部 (header) 请求中的指定信息做 hash ,此处由 name 指定的 http 首部将会被取出并做 hash 计算, 然后由服务器总权重取模以后派发至某挑出的服务器,如果无有效值,则会使用默认的轮询调度。

4.3.4.1、hdr静态算法

配置如下

4.3.4.2、hdr动态算法

配置如下

5、基于cookie的会话保持

cookie仅支持http模式,不支持tcp模式

cookie value:为当前server指定cookie值,实现基于cookie的会话黏性,相对于基于 source 地址hash调度算法对客户端的粒度更精准,但同时也加大了haproxy负载,目前此模式使用较少, 已经被session共享服务器代替

配置如下

insert:插入新的cookie,默认不插入

nocache:不允许中间缓存服务器进行缓存

indirect:若客户端已有cookie值,则不会再发送cookle信息

6、HAProxy状态页

通过web界面,显示当前HAProxy的运行状态

配置

listen stats:

bind *:8200 #监听的主机和端口

mode http #采用http模式

stats enable #基于默认的参数启用stats page

stats hide-version # 将状态页中haproxy版本隐藏

stats refresh 5 # stats page 重刷新时间

log global # 日志参考全局参数

stats uri /stats # 自定义stats page uri 默认为:/haproxy?stats

stats auth admin:admin # 认证账号和密码,可多个,每行指定一个用户,默认无认证测试 登录页信息解析

登录页信息解析

- pid = 1709 (process #2, nbproc = 2, nbthread = 1)

#pid为当前pid号,process为当前进程号,nbproc和nbthread为一共多少进程和每个进程多少个线程

#启动了多长时间- system limits: memmax = unlimited; ulimit-n = 8037

#最大内存;最大打开文件数- maxsock = 8037; maxconn = 4000; maxpipes = 0

#最大socket连接数;单进程最大连接数;最大管道数- current conns = 1; current pipes = 0/0; conn rate = 0/sec; bit rate = 0.000 kbps

#当前连接数;当前管道连接数;当前连接速率;- Running tasks: 0/21; idle = 92 %

运行的任务;当前空闲率

7、IP透传

具有负载均衡架构的怎么分析真实数据来源----IP透传

7.1、七层IP透传

haproxy配置

apache配置

日志参数自取地:%{X-Forwarded-For}i

apache效果

nginx配置

日志参数自取地:

- $proxy_add_x_forwarded_for: 包括客户端IP和中间经过的所有代理的IP

- $http_x_forwarded_For: 只有客户端IP

nginx效果

7.2、四层IP透传

- 注:apache不支持四层IP透传

haproxy配置

nginx配置

日志参数自取地:"$proxy_protocol_addr"

nginx效果

8、ACL

访问控制列表ACL ( Access Control Lists ) 是一种基于包过滤的访问控制技术它可以根据设定的条件对经过服务器传输的数据包进行过滤( 条件匹配 ) 即对接收到的报文进行匹配和过滤,基于请求报文头部中的源地址、源端口、目标地址、目标端口、请求方法、URL 、文件后缀等信息内容进行匹配并执行进一步操作,比如允许其通过或丢弃。

8.1 ACL配置格式

# 用 acl 来定义或声明一个 aclacl <aclname> <criterion> [flags] [operator] [<value>]acl 名称 匹配规范 匹配模式 具体操作符 操作对象类型注:[]里内容可写可不写,<>里内容必须写

8.2、ACL名称定义

acl rule path_end -m sub /a#ACL 名称,可以使用大字母 A-Z 、小写字母 a-z 、数字 0-9 、冒号:、点 . 、中横线和下划线,并且严格区分大小写,比如:my_acl 和 My_Acl 就是两个完全不同的 acl5.8.1.2 ACL-criterion

匹配规则可以分为几个模块:hdr、base、path、url、src,dst

hdr模块

- hdr string,提取在一个HTTP请求报文的首部

- hdr([<name> [,<occ>]]):完全匹配字符串,header的指定信息,<occ> 表示在多值中使用的值的出现次数

- hdr_beg([<name> [,<occ>]]):前缀匹配,header中指定匹配内容的begin

- hdr_end([<name> [,<occ>]]):后缀匹配,header中指定匹配内容end

- hdr_dom([<name> [,<occ>]]):域匹配,header中的dom(host)

- hdr_dir([<name> [,<occ>]]):路径匹配,header的uri路径

- hdr_len([<name> [,<occ>]]):长度匹配,header的长度匹配

- hdr_reg([<name> [,<occ>]]):正则表达式匹配,自定义表达式(regex)模糊匹配

- hdr_sub([<name> [,<occ>]]):子串匹配,header中的uri模糊匹配 模糊匹配c 报文中a/b/c也会匹配

base模块

base : string返回第一个主机头和请求的路径部分的连接即<host>:<port>/<path>;<params>

- base : exact string match

- base_beg : prefix match

- base_dir : subdir match

- base_dom : domain match

- base_end : suffix match

- base_len : length match

- base_reg : regex match

- base_sub : substring match

path模块

path : string提取请求的URL路径,即/<path>;<params>

- path : exact string match

- path_beg : prefix match #请求的URL开头,如/static、/images、/img、/css

- path_end : suffix match #请求的URL中资源的结尾,如 .gif .png .css .js .jpg .jpeg

- path_dom : domain match

- path_dir : subdir match

- path_len : length match

- path_reg : regex match

- path_sub : substring match

url模块url : string #提取请求中的整个 URL 。url : exact string matchurl_beg : prefix matchurl_dir : subdir matchurl_dom : domain matchurl_end : suffix matchurl_len : length matchurl_reg : regex matchurl_sub : substring match

其余

- dst #目标IP

- dst_port #目标PORT

- src #源IP

- src_port #源PORT

8.3 ACL匹配模式

- -i 不区分大小写

- -m 使用指定的正则表达式匹配方法

- -n 不做DNS解析

- -u 禁止acl重名,否则多个同名ACL匹配或关系

8.4、ACL具体操作符

整数比较: eq 、 ge 、 gt 、 le 、 lt字符比较:- exact match (-m str) : 字符串必须完全匹配模式- substring match (-m sub) : 在提取的字符串中查找模式,如果其中任何一个被发现, ACL 将匹配- prefix match (-m beg) : 在提取的字符串首部中查找模式,如果其中任何一个被发现, ACL 将匹配- suffix match (-m end) : 将模式与提取字符串的尾部进行比较,如果其中任何一个匹配,则 ACL 进行匹配- subdir match (-m dir) : 查看提取出来的用斜线分隔( “/" )的字符串,如其中任一个匹配,则 ACL进行匹配- domain match (-m dom) : 查找提取的用点( “." )分隔字符串,如果其中任何一个匹配,则 ACL 进行匹配

8.5、ACL操作对象

The ACL engine can match these types against patterns of the following types :- Boolean # 布尔值- integer or integer range # 整数或整数范围,比如用于匹配端口范围- IP address / network #IP 地址或 IP 范围 , 192.168.0.1 ,192.168.0.1/24- string--> www.timinglee.orgexact #精确比较substring #子串suffix #后缀比较prefix #前缀比较subdir #路径, /wp-includes/js/jquery/jquery.jsdomain #域名, www.timinglee.org- regular expression # 正则表达式- hex block #16 进制

8.6、调用多个ACL的处理

逻辑处理与:隐式(默认)使用或:使用“or" 或 “||" 表示否定:使用 "!" 表示多个ACL调用方式if valid_src valid_port #与关系, ACL 中 A 和 B 都要满足为 true ,默认为与if invalid_src || invalid_port #或, ACL 中 A 或者 B 满足一个为 trueif ! invalid_src #非,取反,不满足 ACL 才为 true

8.7、ACL相关示例

8.7.1、ACL基于域名匹配

配置如下

验证成果

8.7.2、基于源IP或子网访问

配置如下

验证

8.7.3、基于源地址的访问控制

配置如下

验证

8.7.4、ACL匹配浏览器类型

配置如下

验证

8.7.5、基于文件后缀名实现动静分离

配置如下

验证

8.7.6、匹配访问路径实现动静分离

配置如下

RS1

RS2

验证

9、错误日志定向

先将所有的后端服务器全部关闭

9.1、errorfile

#第一个errorfile

#在haproxy配置文件中default模块中添加一行

errorfile 503 /etc/errorpage/503.http #目录自己创建,错误日志自己创建自己写

#创建错误日志

cp /usr/share/haproxy/503.http /etc/errorpage

vim /etc/errorpage/503.http

#修改其内容为自己想修改的

HTTP/1.0 503 Service Unavailable

Cache-Control: no-cache

Connection: close

Content-Type: text/html;charset=UTF-8

<html><body><h1>503报文</h1>

没有灵魂的人就是行尸走肉

</body></html>

验证

9.2、errorloc

#第二个errorloc

#在haproxy配置文件default模块中添加一行

errorloc 503 https://www.baidu.com

验证

10、四层tcp负载均衡数据库

环境需求

| 主机 | IP | 角色 |

| haproxy | 192.168.220.100 | 负载均衡调度器 |

| server1 | 192.168.220.150 | db1 |

| server2 | 192.168.220.200 | db2 |

haproxy

vim /etc/haproxy/haproxy.cfg

#在最下方写入内容

listen dbservers

bind *:3306 #监听任何主机的3306端口

mode tcp #使用四层负载均衡

balance static-rr #使用静态轮询算法

server db1 192.168.220.150:3306 check inter 2 fall 2 rise 3 #服务器1

server db2 192.168.220.200:3306 check inter 2 fall 2 rise 3 #服务器2

#保存并退出

:x

#重启haproxy,重启之前需要将server1和server2配置好

systemctl restart haproxyserver1

#安装数据库

yum install mariadb-server -y

#修改配置文件以区分集群中数据库

vim /etc/my.cnf.d/mariadb-server.cnf

#在[mysqld]下增加一行内容

server-id=1

#保存并退出

:x

#启动数据库

systemctl enable --now mariadb

server2

#安装数据库

yum install mariadb-server -y

#修改配置文件以区分集群中数据库

vim /etc/my.cnf.d/mariadb-server.cnf

#在[mysqld]下增加一行内容

server-id=2

#保存并退出

:x

#启动数据库

systemctl enable --now mariadb

最后在windows上验证数据库负载均衡是否成功 ,效果如下

11、Haproxy https实现

配置过程

配置证书

将证书和私钥都放进一个文件

配置haproxy配置文件

验证

写在最后

慢启动

慢启动是指在服务器刚刚启动上不会把他所应该承担的访问压力全部给它,而是先给一部分,当没 问题后在给一部分

hash取模算法

- 10对3取模 -> 10=3×3+1 -> 10%3=1

- 2对5取模 -> 2=5×0+2 -> 2%5=2

- 34对6取模 -> 34=6×5+4 -> 34%6=4