Redis 大Key排查与优化

什么是BigKey

bigkey简单来说就是存储本身的key值空间太大,或者hash,list,set等存储中value值过多。没有具体的衡量标准。

参考的大小范围:

- String 类型值大于10KB。

- Hash、List、Set、Zset类型元素个数超过5000个。

创建Bigkey

vim /etc/redis/redis.conf

# 不做任何的清理工作,在redis的内存超过限制之后,所有的写入操作都会返回错误;但是读操作都能正常的进行

maxmemory-policy noeviction

然后可以使用redis-cli 获取通过代码设置超过阈值的key,从而就会产生大key了。

排查Redis大key的方法

redis-cli --bigkeys

特点:

-

使用–bigkeys参数会扫描整个Redis数据库,应该在低流量峰值时执行

-

这个方法只能返回每种类型中最大的那个bigkey,无法得到大小排到前N位的bigkey

-

对于集合类型来说,这个方法只统计集合元素的多少,而不是实际占用的内存量。因为一个集合中元素个数多,并不一定占用内存就多

@GetMapping("init")

@Async

public void initData(@RequestParam (name = "size", defaultValue = "5000") Integer size){

redisTemplate.opsForValue().set("string_large_key1", generateTestData(10* 1024));

redisTemplate.opsForValue().set("string_large_key2", generateTestData(10* 1024));

redisTemplate.opsForSet().add("set_large_key1", new HashSet<>(50000));

redisTemplate.opsForSet().add("set_large_key2", new HashSet<>(50000));

redisTemplate.opsForHash().putAll("hash_large_key1", buildMapData(50000));

redisTemplate.opsForHash().putAll("hash_large_key2", buildMapData(50000));

redisTemplate.opsForList().rightPushAll("list_large_key1", buildListData(50000));

redisTemplate.opsForList().rightPushAll("list_large_key2", buildListData(50000));

}

private Map buildMapData(int initialCapacity){

Map<String, String> result =new HashMap<>(initialCapacity);

for (int i = 0; i < initialCapacity; i++) {

result.put("kevin_" + i, "123");

}

return result;

}

private List<String> buildListData(int initialCapacity){

List<String> result = new ArrayList<>(initialCapacity);

for (int i = 0; i < initialCapacity; i++) {

result.add("kevin_" + i );

}

return result;

}

- 使用–bigkeys查询

root@DESKTOP-0JS7U4E:~# redis-cli -h 127.0.0.1 -p 16379 --bigkeys

# Scanning the entire keyspace to find biggest keys as well as

# average sizes per key type. You can use -i 0.1 to sleep 0.1 sec

# per 100 SCAN commands (not usually needed).

[00.00%] Biggest hash found so far 'hash_large_key2' with 50000 fields

# 只返回了最大的那个bigkey

[00.00%] Biggest string found so far 'string_large_key2' with 10485762 bytes

[00.00%] Biggest set found so far 'set_large_key2' with 1 members

[00.00%] Biggest list found so far 'list_large_key1' with 50000 items

-------- summary -------

Sampled 9 keys in the keyspace!

Total key length in bytes is 135 (avg len 15.00)

Biggest list found 'list_large_key1' has 50000 items

Biggest hash found 'hash_large_key2' has 50000 fields

Biggest string found 'string_large_key2' has 10485762 bytes

Biggest set found 'set_large_key2' has 1 members

# 返回了list的容量

2 lists with 100000 items (22.22% of keys, avg size 50000.00)

# 返回了hash的容量

2 hashs with 100000 fields (22.22% of keys, avg size 50000.00)

2 strings with 20971524 bytes (22.22% of keys, avg size 10485762.00)

0 streams with 0 entries (00.00% of keys, avg size 0.00)

3 sets with 3 members (33.33% of keys, avg size 1.00)

0 zsets with 0 members (00.00% of keys, avg size 0.00)

root@DESKTOP-0JS7U4E:~#

redis-cli scan VS memory usage组合

实际上bigkey的底层也使用SCAN命令执行。

SCAN命令可以用于迭代遍历所有key。它是一个非阻塞操作,支持游标(cursor)的方式来逐步遍历所有key。使用SCAN命令可以避免阻塞,减少对Redis性能的影响。

Redis Scan命令说明

1、先使用scan扫描出key

127.0.0.1:16379> scan 1000 MATCH "string*"

1) "0"

2) 1) "string_large_key2"

2) "string_large_key1"

127.0.0.1:16379>

127.0.0.1:16379> scan 0 MATCH "string*" count 20

1) "0"

2) 1) "string_large_key2"

2) "string_large_key1"

127.0.0.1:16379>

2、使用 memory usage查询key占用的内存大小

127.0.0.1:16379> memory usage string_large_key1

(integer) 10485831

127.0.0.1:16379>

这样组合的方式操作比较复杂,需要对命令使用非常熟悉。在生产环境需要更快,更高效的发现问题还是建议使用成熟的分析工具,毕竟也都是用这些命令组合起来的。

使用云上的Redis可以直接使用CloundDBA功能

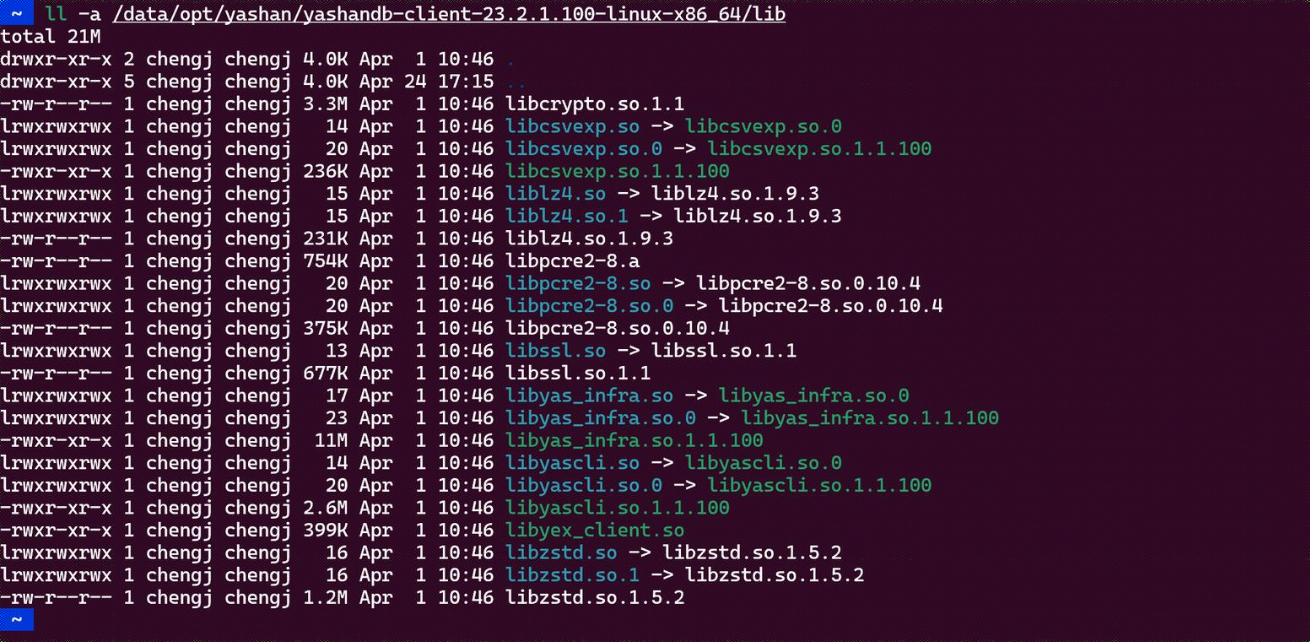

redis-rdb-tools

该三方工具Github地址redis-rdb-tools。

安装该分析工具

python setup.py install

要使用memory功能,需要安装

pip3 install python-lzf

如果出现没有权限的问题,那就以管理员打开cmd再运行

error: [Errno 13] Permission denied: 'C:\\Python310\\Scripts\\rdb-script.py'

安装完成之后目录下面多出这几个文件。

C:\Python310\Scripts>dir

....................

2024/08/08 13:38 996 rdb-script.py

2024/08/08 13:38 74,752 rdb.exe

2024/08/08 13:38 1,030 redis-memory-for-key-script.py

2024/08/08 13:38 74,752 redis-memory-for-key.exe

2024/08/08 13:38 1,018 redis-profiler-script.py

2024/08/08 13:38 74,752 redis-profiler.exe

C:\Python310\Scripts>

使用rdb进行分析

C:\Python310\Scripts>rdb --command memory --bytes 102400 \\wsl.localhost\Ubuntu-20.04\var\lib\redis\dump.rdb

database,type,key,size_in_bytes,encoding,num_elements,len_largest_element,expiry

0,hash,hash_large_key2,3186588,hashtable,50000,11,

0,hash,hash_large_key1,3186588,hashtable,50000,11,

0,string,string_large_key1,12582976,string,10485762,10485762,

0,list,list_large_key1,744355,quicklist,50000,13,

0,string,string_large_key2,12582976,string,10485762,10485762,

0,list,list_large_key2,744355,quicklist,50000,13,

C:\Python310\Scripts>

也可以加上-f参数,将结果输出到本地文件中。

rdb --command memory --bytes 102400 \\wsl.localhost\Ubuntu-20.04\var\lib\redis\dump.rdb -f d:\kevin.csv

大key问题如何优化

不管使用那种方式优化该问题,中心思想还是要体现在“预防大于后置处理”。在设计之初就要考虑是否会随着时间推移慢慢的出现大key的问题,从而融入优化解决的策略进去。

压缩数据

对于大量重复的数据,可以对数据压缩存储,减少存储空间。Redis提供了一些压缩算法,比如LZF,Snappy等,可以在存储和读取的时候进行压缩、解压操作。

数据拆分

也可以理解成,优化数据结构。

- string类型

- 存储关键数据,剔除非关键数据

- 对于已经出现的大key,可以将其拆分成多个小型key

- 大对象分拆成几个key-value,每个field代表一个具体的属性,使用hget,hmget来获取部分的value,使用hset,hmset来更新部分属性

- 集合类型

- 业务允许前提下,可以将集合类型拆分成多个string类型,同时统一前缀,通过mget和mset来访问。

建立Redis key 和value的规范

建立相关的开发规范和运维流程,比如限制单个string类型key的大小,集合类型的容量大小。在设计阶段就一定程度上面规避掉该风险。

合理的过期时间配置

对于不需要长期保存的数据,可以设置较短的过期时间,避免数据长期占用Redis服务器的内存资源,导致大key问题的发生

定期监控

通过 Redis 的监控工具、日志和性能分析工具来进行监控和优化。及时的发现问题,在没有产生大故障之前就消灭在摇篮里面。

增加Redis资源

硬件资源的扩展对软件层面的优化,那就是降维打击。