第1,2,3部分,介绍、概览和预训练

第4部分,后训练

第5部分,结果

第6部分,推理

7 Vision Experiments

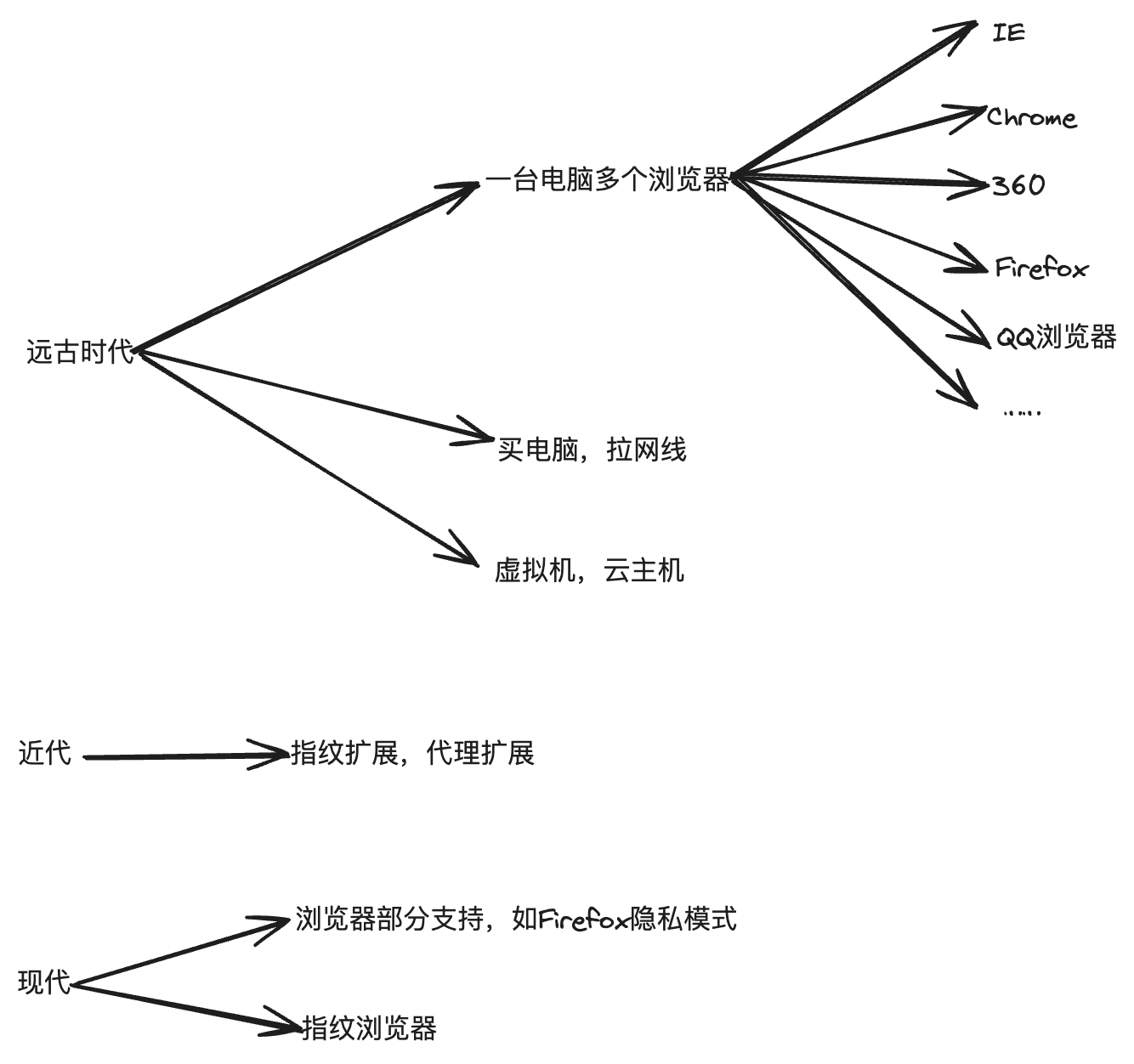

我们进行了一系列的实验,在这些实验中,我们通过一种由两个主要阶段组成的合成方法将视觉识别能力整合到Llama 3中。首先,我们通过在大量图像-文本对上引入和训练两种模型(Alayrac et al ., 2022)之间的一组交叉关注层,组成预训练图像编码器(Xu et al ., 2023)和预训练语言模型。这导致了图28中所示的模型。其次,我们引入时间聚合层和额外的视频交叉关注层,这些层对大量视频文本对进行操作,以学习模型识别和处理来自视频的时间信息。

基础模型开发的组合方法有几个优点:(1)它使我们能够并行化视觉和语言建模能力的开发;(2)避免了视觉和语言数据联合预训练的复杂性,这些复杂性源于视觉数据的标记化、不同模式下的标记的背景困惑差异以及模式之间的争用;(3)它保证了模型在纯文本任务上的性能不受视觉识别功能的影响,(4)交叉注意架构确保我们不必花费计算时间通过越来越多的LLM骨干(具体来说,每个变压器层中的前馈网络)传递全分辨率图像,使其在推理过程中更高效。我们注意到,我们的多模式模型仍在开发中,尚未准备好发布。

在7.6节和7.7节展示我们的实验结果之前,我们描述了我们用于训练视觉识别能力的数据,视觉组件的模型架构,我们如何扩展这些组件的训练,以及我们的训练前和训练后方法。

7.1 Data

我们在下面分别描述我们的图像和视频数据。

7.1.1 Image Data

我们的图像编码器和适配器是在图像-文本对上进行训练的。我们通过一个复杂的数据处理管道构建该数据集,该管道由四个主要阶段组成:(1)质量滤波,(2)感知去重复,(3)重采样和(4)光学字符识别。我们还应用了一系列安全缓解措施。

•质量过滤。我们通过启发式算法(如(Radford et al, 2021)产生的低对齐分数)实现了去除非英语字幕和低质量字幕的质量过滤器。具体来说,我们删除所有低于特定CLIP分数的图像-文本对。

•重复数据删除。去除重复的大规模训练数据集有利于模型性能,因为它减少了在冗余数据上花费的训练计算(Esser等,2024;Lee et al, 2021;Abbas等人,2023)和(Carlini et al, 2023;Somepalli et al, 2023)。因此,出于效率和隐私原因,我们对训练数据进行了去重复处理。为此,我们使用了最先进的SSCD复制检测模型的内部版本(Pizzi等人,2022)来大规模地去重复图像。对于所有图像,我们首先使用SSCD模型计算512维表示。我们使用这些嵌入对数据集中所有图像中的每个图像执行最近邻(NN)搜索,使用余弦相似度度量。我们将超过一定相似性阈值的例子定义为重复。我们使用连接组件算法对这些重复进行分组,并且每个连接组件仅维护一个图像-文本对。我们通过:(1)使用k-means聚类对数据进行预聚类,(2)使用FAISS (Johnson等人,2019)进行神经网络搜索和聚类来提高重复数据删除管道的效率。

•重新采样。我们通过类似于Xu等人(2023)的重新采样来确保图像-文本对的多样性;Mahajan et al (2018);Mikolov et al(2013)。首先,我们通过解析高质量的文本源来构建n-gram词汇表。接下来,我们计算数据集中每个词汇表n-gram的频率。然后我们按如下方式重新采样数据:如果标题中的n个图中的任何一个在词汇表中出现的次数少于T次,我们保留相应的图像-文本对。否则,我们以p T =fi的概率对标题中的n-gram ni中的每一个独立采样,其中fi表示n-gram ni的频率;如果n-gram中的任何一个被采样,我们保留图像-文本对。这种重采样有助于低频类别和细粒度识别任务的性能。

•光学字符识别。通过提取图像中写入的文本并将其与标题连接起来,我们进一步改进了图像-文本数据。使用专有的光学字符识别(OCR)管道提取书面文本。我们观察到,将OCR数据添加到训练数据中可以极大地改善需要OCR功能的任务,例如文档理解。

文件转换。为了提高模型在文档理解任务上的性能,我们将文档中的页面呈现为图像,并将图像与其各自的文本配对。文档文本可以直接从源代码获得,也可以通过文档解析管道获得。

安全。我们主要关注于确保图像识别的预训练数据集不包含不安全的内容,例如性虐待材料(CSAM) (Thiel, 2023)。我们使用感知哈希方法(如PhotoDNA (Farid, 2021))以及内部专有分类器扫描所有训练图像以获取CSAM。我们还使用专有的媒体风险检索管道来识别和删除我们认为是NSFW的图像-文本对,例如,因为它们包含性或暴力内容。我们认为,在不影响最终模型的有用性的情况下,最小化此类材料在训练数

![完整版 [vue 配置electron]](https://i-blog.csdnimg.cn/direct/6fc4b22c60a44692be779a9471ed8341.png)