💛前情提要💛

本文是传知代码平台中的相关前沿知识与技术的分享~

接下来我们即将进入一个全新的空间,对技术有一个全新的视角~

本文所涉及所有资源均在传知代码平台可获取

以下的内容一定会让你对AI 赋能时代有一个颠覆性的认识哦!!!

以下内容干货满满,跟上步伐吧~

📌导航小助手📌

- 💡本章重点

- 🍞一. 情感分析在多场景的应用

- 🍞二. 研究背景

- 🍞三.模型结构和代码

- 🍞四.数据集介绍

- 🍞五.性能展示

- 🍞六.模型总结

- 🫓总结

💡本章重点

- MSA+抑郁症模型总结(二)

🍞一. 情感分析在多场景的应用

随着社交网络的不断发展,近年来出现了多模态数据的热潮。越来越多的用户采用媒体形式的组合(例如文本加图像、文本加歌曲、文本加视频等)。来表达他们的态度和情绪。多模态情感分析(MSA)是从多模态信息中提取情感元素进行情感预测的一个热门研究课题。传统的文本情感分析依赖于词、短语以及它们之间的语义关系,不足以识别复杂的情感信息。随着面部表情和语调的加入,多模态信息(视觉、听觉和转录文本)提供了更生动的描述,并传达了更准确和丰富的情感信息。

此外,随着近些年来生活压力的增加,抑郁症已成为现代工作环境中最常见的现象。早期发现抑郁症对避免健康恶化和防止自杀倾向很重要。无创监测应激水平在筛查阶段是有效的。许多基于视觉提示、音频馈送和文本消息的方法已用于抑郁倾向监测。

概述

本篇文章开始,我计划使用连载的形式对经典的情感计算模型进行讲解、对比和复现,并开发不同数据集进行应用。并逐步实现集成,以方便各位读者和学者更深度地了解Multimodal Sentiment Analysis (MSA)以及他的研究重点和方向,为该领域的初学者尽量指明学习方向方法;

首先第一篇,我将介绍AAAI 2021的一篇经典MSA论文中的模型–Self_MM

论文地址

Learning Modality-Specific Representations with Self-Supervised Multi-Task Learning for Multimodal Sentiment Analysis

🍞二. 研究背景

近年来,多模态情感分析和抑郁检测是利用多模态数据预测人类心理状态的两个重要研究课题;多模态情感分析(MSA)和抑郁症检测(DD)引起了越来越多的关注。与单模态分析相比,多模态模型在处理社交媒体数据时更鲁棒,并取得了显着的改进。随着用户生成的在线内容的蓬勃发展,MSA已被引入许多应用,如风险管理,视频理解和视频转录。

其中,表征学习是多模态学习中一项重要而又具有挑战性的任务。有效的模态表征应包含两个方面的特征:一致性和差异性。由于统一的多模态标注,现有方法在捕获区分信息方面受到限制。然而,额外的单峰注解是高时间和人力成本的。本文设计了一个基于自监督学习策略的标签生成模块,以获得独立的单峰监督。然后,对多模态任务和单模态任务分别进行联合训练,以了解其一致性和差异性。此外,在训练阶段,作者设计了一个权重调整策略,以平衡不同子任务之间的学习进度。即引导子任务集中于模态监督之间差异较大的样本。

主要贡献

-

提出了一种用于多模态情感分析层次化MI最大化框架。MI最大化发生在输入级和融合级,以减少有价值的任务相关信息的损失。据我们所知,这是第一次尝试在MI和MSA之间建立桥梁;

-

作者制定了我们的框架中的计算细节,以解决棘手的问题。该公式包括参数学习和非参数GMM稳定和光滑的参数估计;

-

在两个公开的数据集上进行全面的实验,并获得上级或与最先进的模型相当的结果。

🍞三.模型结构和代码

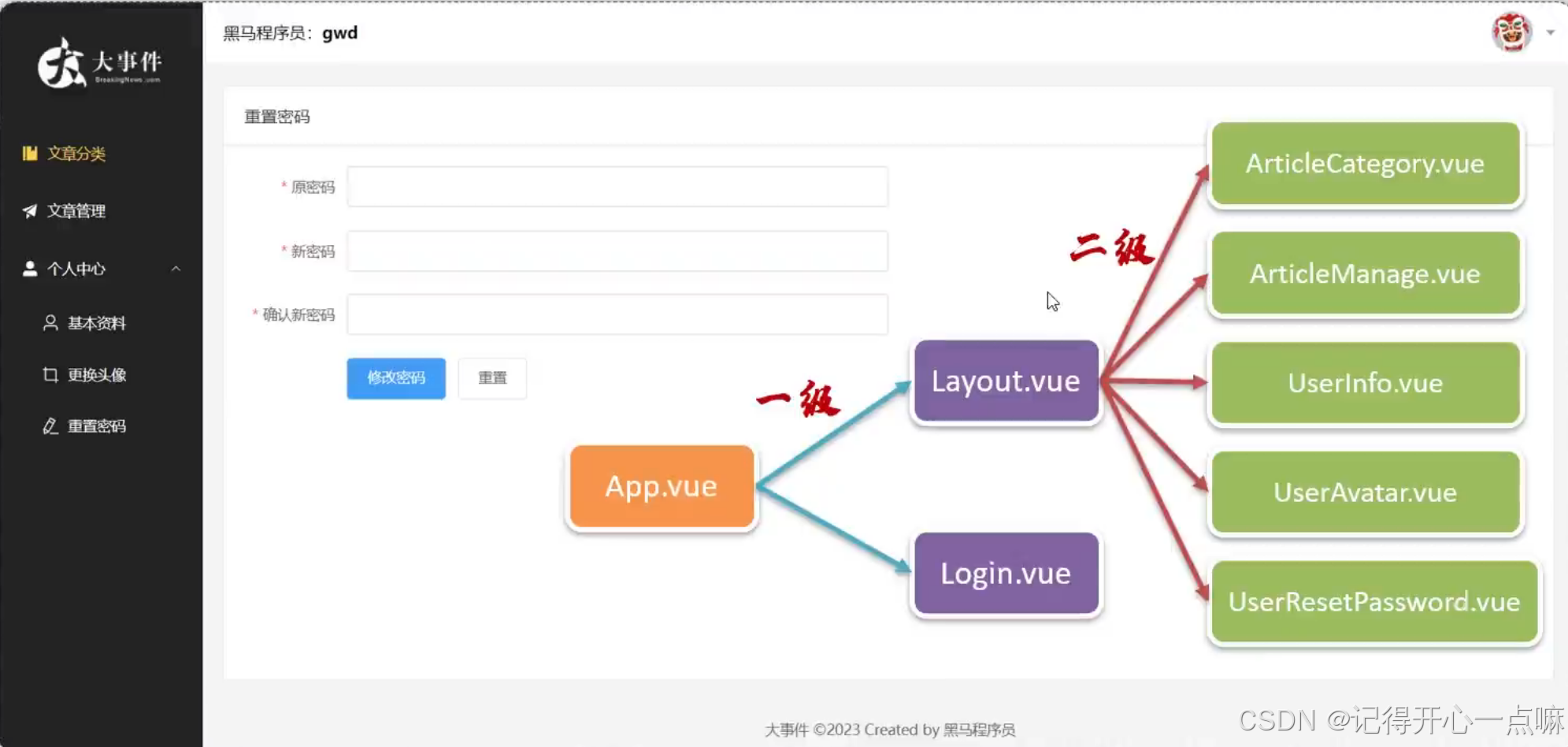

1. 总体框架

如下图所示,MMIM模型首先使用特征提取器(用于视觉和声学的固件,没有参数可供训练)和标记器(用于文本)将原始输入处理为数字序列向量。然后,将它们编码为单个单位长度表示。然后,该模型在两个协作部分中parts-fusion和MI最大化,分别由下图中的实线和虚线标记。

在融合部分,堆叠的线性激活层的融合网络F将单峰表示转换为融合结果Z,然后将其通过回归多层感知器(MLP)进行最终预测。这两个部分同时工作,以产生用于反向传播的任务和MI相关损失,通过该模型学习将任务相关信息注入融合结果,并提高主任务中预测的准确性。

2. 模态编码器

3. 模态间MI最大化

通过以上分析,我们希望通过在多模态输入之间提示MI,可以过滤掉与任务无关的模态特定随机噪声,并尽可能多地保留跨所有模态的模态不变内容。如前所述,作者提高了一个易于处理的下限,而不是为此直接计算MI。利用了Barber和Agakov中引入的精确和直接的MI下界。

4. 融合的MI最大化

为了加强中间融合结果以捕获模态之间的模态不变线索,在融合结果和输入模态之间重复MI最大化。

因为作者发现模型打算拉伸两个向量以最大化中的得分,而不进行这种归一化。然后,与Oord等人所做的相同,将此评分函数纳入噪声对比估计框架,将同一批次中该模态的所有其他表示处理为负样本;

以下是对这种提法的合理性的简短解释。对比预测编码(CPC)“在时间范围内”对上下文和未来元素之间的MI进行评分,以保持跨越许多时间步长的“慢功能”部分。类似地,在MMIM的模型中,要求融合结果 Z 反向预测“跨模态”的表示,以便可以将更多的模态不变信息传递给 Z。此外,通过将预测与每一种模态对齐,使模型能够确定它应该从每一种模态接收多少信息。

🍞四.数据集介绍

-

CMU-MOSI: 它是一个多模态数据集,包括文本、视觉和声学模态。它来自Youtube上的93个电影评论视频。这些视频被剪辑成2199个片段。每个片段都标注了[-3,3]范围内的情感强度。该数据集分为三个部分,训练集(1,284段)、验证集(229段)和测试集(686段)。

-

CMU-MOSEI: 它类似于CMU-MOSI,但规模更大。它包含了来自在线视频网站的23,453个注释视频片段,涵盖了250个不同的主题和1000个不同的演讲者。CMU-MOSEI中的样本被标记为[-3,3]范围内的情感强度和6种基本情绪。因此,CMU-MOSEI可用于情感分析和情感识别任务。

-

AVEC2019: AVEC2019 DDS数据集是从患者临床访谈的视听记录中获得的。访谈由虚拟代理进行,以排除人为干扰。与上述两个数据集不同的是,AVEC2019中的每种模态都提供了几种不同的特征。例如,声学模态包括MFCC、eGeMaps以及由VGG和DenseNet提取的深度特征。在之前的研究中,发现MFCC和AU姿势分别是声学和视觉模态中两个最具鉴别力的特征。因此,为了简单和高效的目的,我们只使用MFCC和AU姿势特征来检测抑郁症。数据集用区间[0,24]内的PHQ-8评分进行注释,PHQ-8评分越大,抑郁倾向越严重。该基准数据集中有163个训练样本、56个验证样本和56个测试样本。

-

SIMS/SIMSV2: CH-SIMS数据集[35]是一个中文多模态情感分析数据集,为每种模态提供了详细的标注。该数据集包括2281个精选视频片段,这些片段来自各种电影、电视剧和综艺节目,每个样本都被赋予了情感分数,范围从-1(极度负面)到1(极度正面)

🍞五.性能展示

-

在情感计算任务中,可以看到Self_MM模型性能超越其他模型,证明了其有效性:

-

抑郁症检测任务中,Self_MM在我们的数据集AVEC2019中依旧亮眼:

-

SIMS数据集

🍞六.模型总结

1. 适用场景

-

情感驱动的内容生成: 该模型可以应用于情感驱动的内容生成任务,如根据用户的情感状态生成符合其情绪的音频、图像或文本内容。这在个性化推荐系统和广告定制中具有潜在的应用。

-

心理健康监测与干预: 在心理健康领域,MMIM模型可以用于抑郁倾向监测和情绪干预。通过分析用户的语音、面部表情和文字信息,可以早期发现和处理心理健康问题,提供个性化的支持和建议。

-

在教育和培训领域: MMIM模型可以用于情感教育和人际关系技能培训。通过模拟多模态情境并提供实时反馈,帮助个体提高情感表达和沟通能力。

2. 项目特点

-

多模态整合: MMIM模型能够有效地整合文本、图像和音频等多模态数据,充分利用不同模态之间的相关性,提升情感分析的准确性和全面性。

-

自适应情感建模: 采用先进的自适应学习技术,MMIM模型能够根据具体任务和用户需求动态调整情感建模策略,提高模型的灵活性和适应性。

-

跨领域适用性: MMIM模型具有较强的跨领域适用性,不仅适用于社交媒体分析和心理健康监测,还能扩展至教育、电商推荐和人机交互等多个应用领域。

-

高效的情感表示学习: 通过深度学习技术,MMIM模型能够高效地学习和表示复杂的情感信息,实现对多模态数据的深度理解和情感分析。

🫓总结

综上,我们基本了解了“一项全新的技术啦” 🍭 ~~

恭喜你的内功又双叒叕得到了提高!!!

感谢你们的阅读😆

后续还会继续更新💓,欢迎持续关注📌哟~

💫如果有错误❌,欢迎指正呀💫

✨如果觉得收获满满,可以点点赞👍支持一下哟~✨

【传知科技 – 了解更多新知识】