目录

- LLM-based NLG Evaluation: Current Status and Challenges

- AdaptEval: Evaluating Large Language Models on Domain Adaptation for Text Summarization

- The Potential and Challenges of Evaluating **Attitudes, Opinions, and Values** in Large Language Models

- EvalLM: Interactive Evaluation of Large Language Model Prompts on User-Defined Criteria

- PandaLM: An Automatic Evaluation Benchmark for LLM Instruction Tuning Optimization

- JudgeLM: Fine-tuned Large Language Models are Scalable Judges

- Judging LLM-as-a-Judge with MT-Bench and Chatbot Arena

- 备注

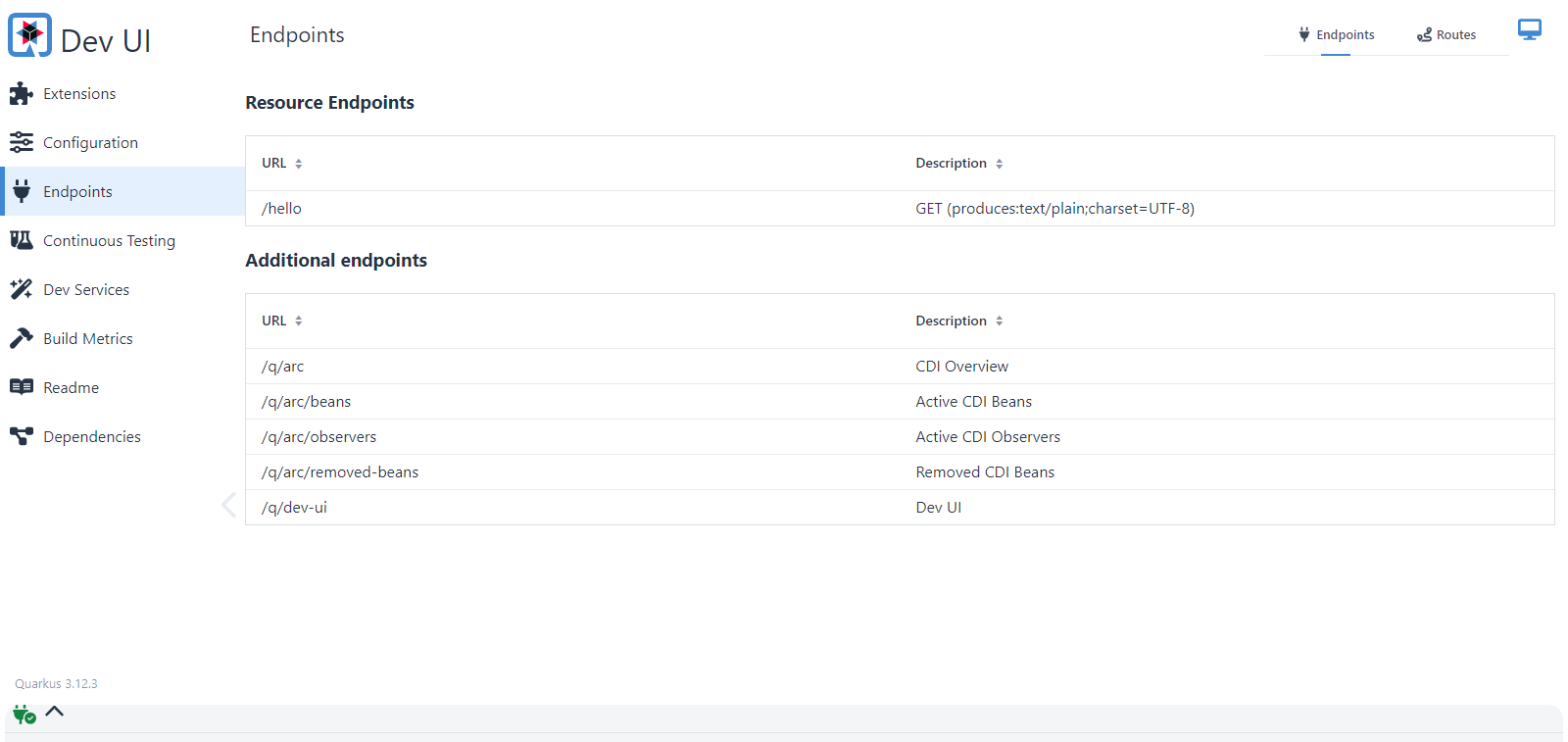

LLM-based NLG Evaluation: Current Status and Challenges

简述:将LLM的评估方法分为四类:LLM衍生指标评估、用提示词评估、模型微调评估、人类与LLM协作评估,分别总结各种评估方法的现状和优缺点。

-

LLM衍生指标评估

- 用生成词的概率评估:通过概率大小确定模型输出质量,强事实性的内容模型有更高的概率输出,也被用于幻觉检测,或加入扰动检测模型输出概率的变化

- 用词/句嵌入评估:RAG的时候判断引用和输出之间的相似性,BertScore 评分

- 鲁棒性不行,容易收到攻击,即微小变化的测试展示出完全不同的性能

- 用大模型推理太慢,而且闭源模型无法查看输出概率

- 偏见,预训练模型编码的内在偏差和相似性计算过程中注入的外在偏差

-

用提示词评估

- 单一答案打分

- 不止评分,给出原因再评分更具可解释性,类似思维链

- 分类别给出评分并加总,例如有用性、文笔丰富度、有害性;或几种特性给出评分,取最高分

- 李克特量表:使用一组陈述,对每个陈述分为5个类别,分别是非常同意、同意、不一定、不同意、非常不同意,对应1-5的评分,加总评估

- 成对比较

- 在使用中等模型评判时,成对比较效果优于打分

- 多例子排名

- 对于不同模型的最佳评估方法不一定,包括评分、比较和排名

- 布尔QA,对于是否类的评估场景

- 错误分析,衡量模型能否按照要求输出,例如能否以要求的json格式输出分数

- 单一答案打分

-

模型微调评估

- 通常方法都是精心构建评估数据,然后微调开源模型,下图是不同模型具体情况对比

- PandaLM和JudgeLM完全从常见的指令数据集中采样,如Alpaca 52K,而CritiqueLLM采用小规模采样,然后进行ChatGPT增强。相比之下,Prometheus和INSTRUCTSCORE依赖GPT-4根据种子数据生成所有指令,而Auto-J和Shepherd使用真实世界的数据。此外,由于大规模的人工注释是不切实际的,除了PandaLM和Shepherd分别在小规模社区数据上使用GPT-3.5和人工注释外,大多数作品都使用GPT-4作为强大的注释器。

-

人类-LLM协作评估

- 评估过程中人类与大模型不断修改审核

AdaptEval: Evaluating Large Language Models on Domain Adaptation for Text Summarization

- 发布自己的评估数据集和评估指标,数据集分科学、医学和政府领域,指标分为领域词重叠度和领域token分布偏移值,以及用GPT4来评估,测评了llama等多个模型的指标,包括零样本、两个样本、微调方法。

- 结论

- 小模型零样本不行,但给两个样本提示就能与大模型效果相当

- 微调不会改变词汇领域,只会改变风格

The Potential and Challenges of Evaluating Attitudes, Opinions, and Values in Large Language Models

- 对模型中潜藏的人类认知特点(AOV,态度、观点、价值观)进行评估,拆解人类偏好的复杂性,更好的理解模型

- 虽然之前有人调查模型中潜藏的特点,但没有专门研究AOV以及评估LLM内的AOV,这是第一篇。

EvalLM: Interactive Evaluation of Large Language Model Prompts on User-Defined Criteria

- 提出一个交互式系统—EvalLM。人类与LLM协作评估,人类先编写提示让LLM评估,在评估过程中人类指出LLM评估的问题,并给出更细致的评估标准,不断迭代优化评估标准,最终得到更准确的评估,并且减少了人工成本。

- 招募专业人员来手动设计提示,总结手动设计提示的难点

- 手动评估很费时间,评估者每次测试几个输出,但对于比较长的输出仍然很费时间

- 评估是多方面的,需要同时衡量多个标准,每个评估者按照自己方式去评估,但有可能改进提示后引入其他方面的退化

- 评估是动态的,评估过程中每个人的标准一直在变,且很难确定哪种是最好的标准

- 评估很难定义,评估者通常不知道如何改进提示

- 感觉文章写的晦涩,不过可以学习该系统的处理流程,以及文末附录中的提示词设计技巧

PandaLM: An Automatic Evaluation Benchmark for LLM Instruction Tuning Optimization

简述:制作评估数据集,用开源模型继续微调,评估效果可以与GPT4相当。

- 训练集由 Alpaca 52K 数据集中采样,通过多种开源模型输出响应对,用 GPT3.5 判断哪个更好以此标注数据,为防止位置固有偏见过滤位置不统一的样本,最终使用 300K 个样本

- 通过 llama-7B 微调的评判模型,更关注相对简洁性、清晰度、全面性、形式化程度和遵循指令

- 做数据集时用提示词告诉GPT4评分标准,让其更关注简洁性~~

- 自己创建了人工注释测试集,验证 PandaLM 的效果,7B 仅次于 GPT-3.5

JudgeLM: Fine-tuned Large Language Models are Scalable Judges

简述:对标PandaLM,制作评估数据集,用开源模型微调,分析LLM评判存在的问题并给出解决办法。

- 105K 种子任务,让 11 个大模型中生成答案,从中随机抽取配成答案对,让 GPT4 评判,最终得到训练集 100K、验证集 5K

- 样本分为带参考和不带参考两种,不同的模板

- GPT4先评分,再判断哪个更好,再给出原因

- 使用Vicuna-7B、13B和33B参数模型微调

- LLM评判偏差

- 位置偏差:倾向与给特定位置高分

- 交换位置来解决

- 知识偏差:询问预训练数据之外的问题出现幻觉,且评判模型无法判断这种幻觉

- 引入参考答案再让LLM来评判

- 格式偏差:使用无参考的模板微调模型,然后在带参考的问题上评判,会出现格式不匹配

- 随机丢弃带参考的样本,并使用相应的无参考的样本

- 位置偏差:倾向与给特定位置高分

Judging LLM-as-a-Judge with MT-Bench and Chatbot Arena

简述:提出两个数据集,观察模型标注和人类标注一致性,调研LLM作为评判者的问题及解决办法。

- 提出数据集

- 现有评估数据集无法评估多轮对话能力,所以提出MT-Bench数据集,由80多个高质量多轮对话问题组成,旨在测试多回合对话和指令遵循能力

- 创建聊天机器人竞技场(Chatbot Arena),用户自定义问题,由两个模型同时生成答案,用户判断哪个更好。在运行一个月后,收集了3万个样本。

- 对大模型作为评判模型进行调研

- 单一答案的评分:让LLM评委直接给一个答案打分单一答案

- 无法辨别相似答案之间的细微差别,且当评判模型发生变化,绝对分数波动更大

- 成对比较:一个LLM评委被告知一个问题和两个答案,任务是确定哪一个更好或者宣布一个平局

- 待评价模型变多时,评价数量呈二次增长

- 对模型效果排序才会存在此问题,只选出 top-1 不存在

- 待评价模型变多时,评价数量呈二次增长

- 参考资料指导下的评分:对于数学和推理问题,除了要比对的两个回答,再提供一个参考答案

- 单一答案的评分:让LLM评委直接给一个答案打分单一答案

- 大模型作为评判者存在的问题及解决办法

- 模型可能会存在位置偏见,倾向于给特定位置的答案打高分

- 位置偏见只在相似答案中出现,效果相差过大则偏见几乎消失

- 解决办法:交换数据位置,让评判模型评两次,只有当一个答案在两个顺序中都是首选时才宣布获胜。如果调换后的结果不一致,则可以称其为平局。另一个更激进的方法是随机分配位置,这在大数据下是有效的。

- 解决办法:引入小样本提示,可以显著提高一致性,但高一致性不代表高准确性,有可能引入新的偏差

- 词语偏见,模型倾向于给更长的文本打高分,即使它们不如短文本清晰有效。

- 自我增强偏差,有些模型更喜欢某个模型的输出,例如GPT4更喜欢自己的输出,GPT-3.5不喜欢自己

- 数学和推理能力有限,即使某些时候GPT4自己可以输出答案,但在评判时容易受到输入的影响

- 对于此类问题,让模型自己先独立生成答案,然后在评判时将其作为参考答案

- 模型可能会存在位置偏见,倾向于给特定位置的答案打高分

- 一致性评估

- 在MT-Bench和Chatbot Arena上用大模型和人类标注,发现 GPT4 与人类的一致性高于人类之间,且将 GPT4 的判断展示给人类后,一部分人类觉得有道理并愿意改变观点

- 模型之间的评判差异性越大,GPT4和人类一致性越高

备注

目前已解读论文有限,读者有什么好的论文可以再评论区推荐,我会及时更新