在前一篇文章中,我们学习了如何编写第一个爬虫程序,成功获取了网页的HTML内容。然而,原始HTML通常包含大量我们不需要的信息,真正有价值的数据往往隐藏在HTML的标签和属性中。这一篇,我们将学习如何使用Python的解析库从HTML中提取出有用的数据。

一、网页解析库概述

Python提供了几个强大的库用于解析HTML,最常用的有:

- BeautifulSoup:最流行的HTML解析库,使用简单,功能强大

- lxml:基于C语言的高性能库,支持HTML和XML解析

- PyQuery:类似jQuery的Python实现,适合熟悉jQuery的开发者

本文将主要介绍BeautifulSoup,因为它对初学者最友好,同时功能也足够强大。

二、安装BeautifulSoup

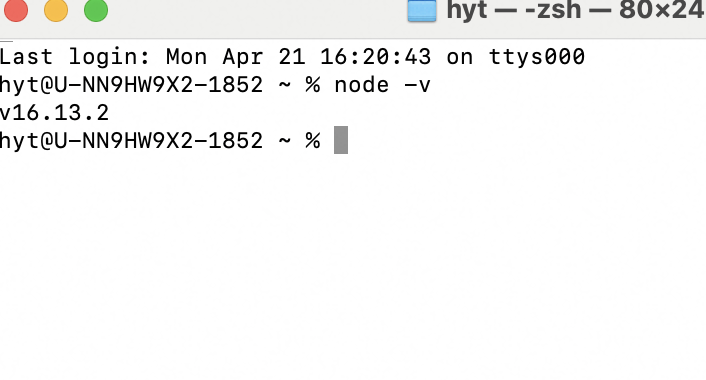

首先,我们需要安装BeautifulSoup库和解析器:

pip install beautifulsoup4

pip install lxml # 推荐的解析器

BeautifulSoup本身只是一个解析器接口,需要搭配HTML解析器使用。lxml是目前速度最快的解析器,推荐使用。

三、BeautifulSoup基础

1. 创建BeautifulSoup对象

使用BeautifulSoup解析HTML的第一步是创建一个BeautifulSoup对象:

from bs4 import BeautifulSoup

# 从HTML字符串创建BeautifulSoup对象

html_doc = """

<html>

<head>

<title>网页标题</title>

</head>

<body>

<h1>标题</h1>

<p class="content">这是一个<b>段落</b>。</p>

<p class="content">这是另一个段落。</p>

<div id="footer">

<a href="https://www.example.com">链接</a>

</div>

</body>

</html>

"""

soup = BeautifulSoup(html_doc, 'lxml') # 使用lxml解析器

# 从文件创建BeautifulSoup对象

with open('example.html', 'r', encoding='utf-8') as f:

soup = BeautifulSoup(f, 'lxml')

2. 基本导航方法

BeautifulSoup将HTML文档解析成树形结构,我们可以使用各种方法来导航和搜索这个树:

soup = BeautifulSoup(html_doc, 'lxml')

# 获取标题

title = soup.title

print(f"标题标签: {title}")

print(f"标题文本: {title.string}")

# 获取第一个段落

p = soup.p

print(f"第一个段落: {p}")

# 获取所有段落

all_p = soup.find_all('p')

print(f"找到 {len(all_p)} 个段落")

# 获取ID为footer的元素

footer = soup.find(id='footer')

print(f"页脚: {footer}")

3. 使用CSS选择器

BeautifulSoup支持使用CSS选择器来查找元素,这是一种强大而灵活的方法:

soup = BeautifulSoup(html_doc, 'lxml')

# 使用CSS选择器查找元素

content_paragraphs = soup.select('p.content') # 查找class为content的p标签

print(f"内容段落数量: {len(content_paragraphs)}")

# 查找ID为footer的元素内的所有链接

footer_links = soup.select('#footer a')

for link in footer_links:

print(f"链接: {link['href']}")

# 复杂的选择器

elements = soup.select('body > p.content') # 选择body直接子元素中class为content的p标签

CSS选择器语法说明:

tag:选择所有该类型的标签,如p选择所有段落#id:选择ID为指定值的元素,如#footer.class:选择具有指定class的元素,如.contentparent > child:选择parent的直接子元素中的child元素ancestor descendant:选择ancestor的后代元素中的descendant元素

四、提取数据

1. 提取文本内容

从元素中提取文本内容是最常见的操作之一:

soup = BeautifulSoup(html_doc, 'lxml')

# 提取文本方法1:使用.string属性(只适用于没有子标签的元素)

title_text = soup.title.string

print(f"标题: {title_text}")

# 提取文本方法2:使用.text属性(适用于任何元素,会提取所有子元素的文本)

p_text = soup.p.text

print(f"段落文本: {p_text}")

# 提取文本方法3:使用.get_text()方法(可以指定分隔符)

body_text = soup.body.get_text(separator=' | ')

print(f"正文文本: {body_text}")

2. 提取属性

HTML元素的属性通常包含重要信息,如链接的URL:

soup = BeautifulSoup(html_doc, 'lxml')

# 方法1:像字典一样访问属性

link = soup.find('a')

href = link['href']

print(f"链接地址: {href}")

# 方法2:使用.get()方法(当属性不存在时不会抛出异常)

img = soup.find('img')

if img:

src = img.get('src', '没有图片')

print(f"图片地址: {src}")

else:

print("没有找到图片标签")

# 获取所有属性

if link:

attrs = link.attrs

print(f"链接的所有属性: {attrs}")

3. 处理多个元素

通常,我们需要遍历和处理多个元素:

soup = BeautifulSoup(html_doc, 'lxml')

# 查找所有段落

paragraphs = soup.find_all('p')

# 遍历处理每个段落

for i, p in enumerate(paragraphs, 1):

print(f"段落 {i}: {p.get_text().strip()}")

# 使用CSS选择器查找多个元素

links = soup.select('a')

for link in links:

print(f"链接地址: {link['href']}, 文本: {link.text.strip()}")

五、实际案例:解析百度热搜榜

在上一篇文章中,我们爬取了百度热搜榜的HTML内容并保存到了文件中。现在,让我们解析这个HTML并提取热搜数据:

from bs4 import BeautifulSoup

import logging

# 配置日志

logging.basicConfig(level=logging.INFO, format='%(asctime)s - %(levelname)s: %(message)s')

def parse_baidu_hot_search():

"""解析百度热搜榜HTML"""

try:

# 从文件读取HTML

with open("baidu_hot_search.html", "r", encoding="utf-8") as f:

html_content = f.read()

logging.info("开始解析百度热搜榜HTML...")

# 创建BeautifulSoup对象

soup = BeautifulSoup(html_content, 'lxml')

# 找到热搜项元素

# 注意:以下选择器是基于当前百度热搜页面的结构,如果页面结构变化,选择器可能需要更新

hot_items = soup.select("div.category-wrap_iQLoo")

if not hot_items:

logging.warning("未找到热搜项,可能页面结构已变化,请检查HTML内容和选择器")

return []

logging.info(f"找到 {len(hot_items)} 个热搜项")

# 提取每个热搜项的数据

hot_search_list = []

for index, item in enumerate(hot_items, 1):

try:

# 提取标题

title_element = item.select_one("div.c-single-text-ellipsis")

title = title_element.text.strip() if title_element else "未知标题"

# 提取热度(如果有)

hot_element = item.select_one("div.hot-index_1Bl1a")

hot_value = hot_element.text.strip() if hot_element else "未知热度"

# 提取排名

rank = index

hot_search_list.append({

"rank": rank,

"title": title,

"hot_value": hot_value

})

except Exception as e:

logging.error(f"解析第 {index} 个热搜项时出错: {e}")

logging.info(f"成功解析 {len(hot_search_list)} 个热搜项")

return hot_search_list

except Exception as e:

logging.error(f"解析百度热搜榜时出错: {e}")

return []

def display_hot_search(hot_list):

"""展示热搜榜数据"""

if not hot_list:

print("没有获取到热搜数据")

return

print("\n===== 百度热搜榜 =====")

print("排名\t热度\t\t标题")

print("-" * 50)

for item in hot_list:

print(f"{item['rank']}\t{item['hot_value']}\t{item['title']}")

if __name__ == "__main__":

hot_search_list = parse_baidu_hot_search()

display_hot_search(hot_search_list)

注意:上面的选择器是基于编写时的百度热搜页面结构,如果页面结构发生变化,可能需要更新选择器。通常,我们需要先分析页面结构,找到包含目标数据的元素,然后编写相应的选择器。

六、如何找到正确的选择器?

在实际爬取过程中,找到正确的选择器是一个关键步骤。以下是一些实用技巧:

1. 使用浏览器开发者工具

- 在Chrome或Firefox中,右键点击要提取的元素,选择"检查"或"检查元素"

- 在元素面板中,右键点击对应的HTML代码,选择"Copy" > "Copy selector"获取CSS选择器

- 或者选择"Copy" > "Copy XPath"获取XPath表达式

2. 检查多个相似元素

当需要提取列表项(如热搜条目)时,检查多个相似元素,找出它们的共同特征:

- 检查第一个列表项,找到识别它的选择器

- 检查其他几个列表项,确认相同的选择器能够匹配所有项

- 尽量使用class、id等稳定属性,避免依赖位置或顺序

3. 从外到内逐层定位

对于复杂网页,可以采用从外到内的策略:

- 先定位包含所有目标数据的大容器(如列表容器)

- 再从容器中找出每个列表项

- 最后从每个列表项中提取所需的具体数据(标题、链接等)

# 从外到内逐层定位示例

container = soup.find('div', class_='list-container') # 先找到大容器

if container:

list_items = container.find_all('div', class_='list-item') # 再找所有列表项

for item in list_items:

title = item.find('h3', class_='title').text.strip() # 从列表项中提取标题

link = item.find('a')['href'] # 提取链接

七、常见问题与解决方案

1. 找不到元素

可能原因:

- 选择器不正确

- 页面结构与预期不同

- 内容是通过JavaScript动态加载的

解决方案:

- 检查HTML源码,确认元素是否存在

- 检查并调整选择器

- 如果内容是动态加载的,考虑使用Selenium等工具

2. 解析HTML出错

可能原因:

- HTML格式不规范

- 编码问题

解决方案:

- 使用更宽松的解析器,如html.parser

- 明确指定编码:

BeautifulSoup(html, 'lxml', from_encoding='utf-8')

3. 提取的文本包含多余内容

可能原因:

- 元素内包含子元素或多余空白

解决方案:

- 使用

.strip()去除多余空白 - 使用更精确的选择器定位具体文本节点

- 使用

.get_text(strip=True)获取清理后的文本

八、总结与最佳实践

通过本文,我们学习了如何使用BeautifulSoup从HTML中提取数据。以下是一些最佳实践:

-

选择合适的解析库:对于大多数情况,BeautifulSoup是一个很好的选择;对于更高性能需求,可以考虑直接使用lxml。

-

使用有意义的选择器:优先使用id、class等有语义的属性构建选择器,避免依赖元素位置。

-

健壮性处理:

- 总是检查元素是否存在再操作

- 使用try-except捕获可能的异常

- 使用

.get()方法获取属性,避免KeyError

-

文档和注释:由于网页结构可能变化,良好的文档和注释有助于维护。

-

定期检查:定期验证爬虫是否仍然有效,特别是在目标网站更新后。

在实际项目中,合理组合使用网页请求和数据提取技术,可以构建出强大而灵活的爬虫系统。

下一篇:【Python爬虫详解】第四篇:使用解析库提取网页数据——Xpath