感谢分享

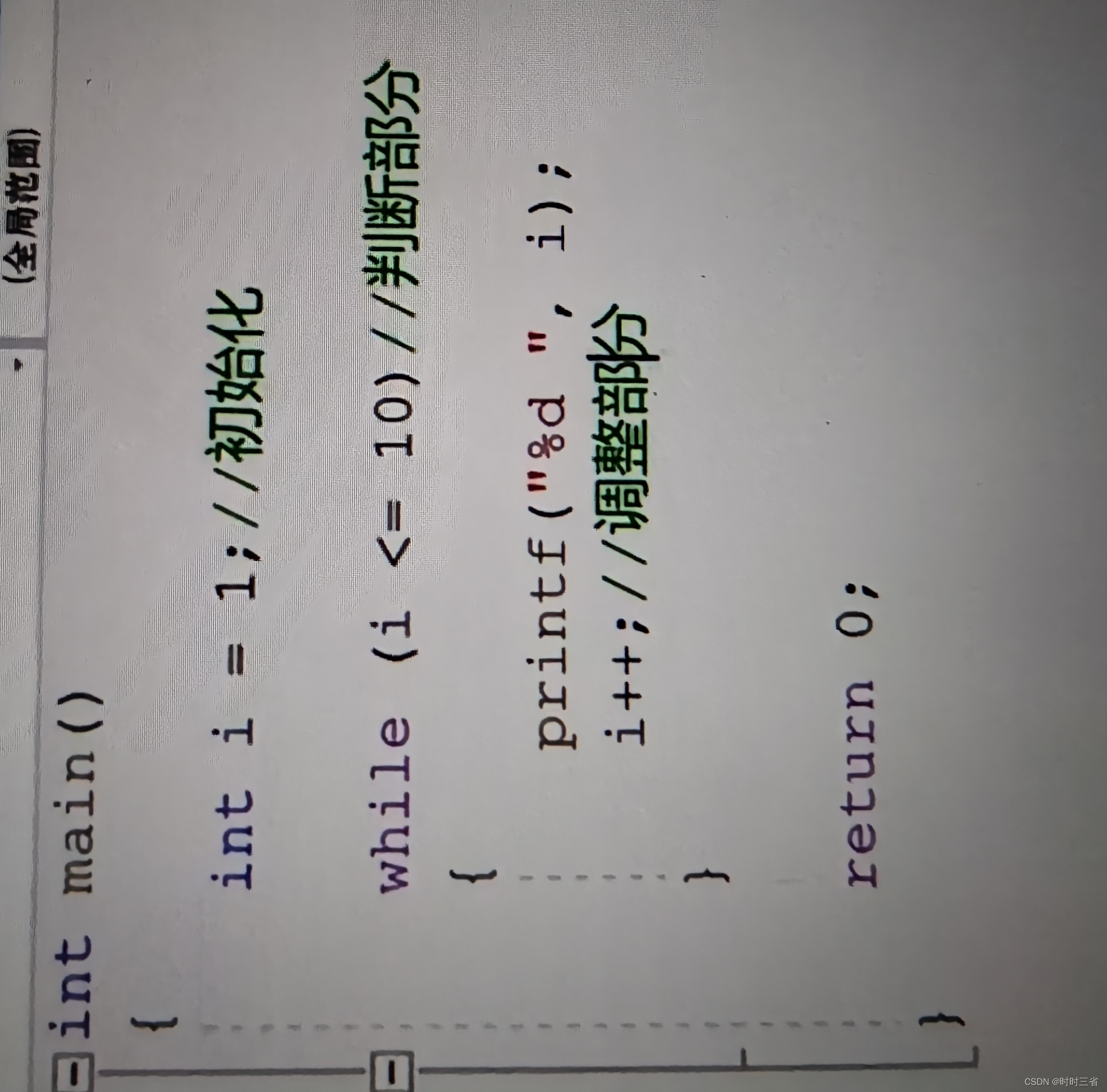

看这篇博客的时候,因为patch后做了一个fc的映射,也是有计算的消耗嘛,好奇为什么说patchtst能够减小“注意力图的内存使用和计算复杂度减少了S倍,从而在计算资源有限的情况下允许模型查看更长的历史序列。“ 所以思考了一下,问了一下GPT,看了一下GPT的分析,先上结论:

随着序列长度 𝐿 的增加,Attention的计算复杂度会比MLP高很多。对于较长的序列,Attention的复杂度会迅速增长,而MLP的复杂度保持相对稳定。那么这种情况下,假设d << L,那么这种情况下mlp的映射计算量相对于没映射前做处理的L直接做Attn的计算量小多了。

并且要注意只是说attn的计算量降低了,或者整体的降低了,但是引入了mlp的计算,不过这种计算是牺牲小挽救大局。