因果卷积神经网络公式与应用解析

因果卷积神经网络的核心作用

因果卷积神经网络(Temporal Convolutional Network, TCN)是一种专为时间序列预测而设计的网络结构。它通过因果卷积层,能够有效地处理时间序列数据,捕捉时间序列中的长期依赖关系。其核心公式涉及卷积操作,通过卷积核在时间序列上滑动,提取特征并进行预测。

基本的卷积操作公式如下:

y [ t ] = ( x ∗ w ) [ t ] = ∑ k = 0 K − 1 x [ t − k ] ⋅ w [ k ] y[t] = (x * w)[t] = \sum_{k=0}^{K-1} x[t-k] \cdot w[k] y[t]=(x∗w)[t]=k=0∑K−1x[t−k]⋅w[k]

其中, x [ t ] x[t] x[t] 是输入时间序列在时刻 t t t 的值, w [ k ] w[k] w[k] 是卷积核的权重, K K K 是卷积核的大小, y [ t ] y[t] y[t] 是卷积操作后的输出。

通俗解释与案例

-

因果卷积的核心思想

- 想象一下,你有一个时间序列数据,比如每天的股票价格。你想要预测未来的股票价格,就需要考虑过去的价格数据。

- 因果卷积就像是一个滑动窗口,它在时间序列上滑动,每次考虑窗口内的数据来计算输出。窗口的大小就是卷积核的大小。

-

因果卷积的应用

- 在时间序列预测中,因果卷积神经网络可以通过堆叠多个因果卷积层来捕捉长期依赖关系。

- 比如,预测未来的股票价格时,网络会考虑过去一个月的价格数据来做出预测。

-

因果卷积的性质

- 因果卷积有一个重要的性质,即输出只依赖于当前的输入和过去的输入,不会依赖于未来的输入。

- 这使得因果卷积神经网络特别适合于时间序列预测任务。

-

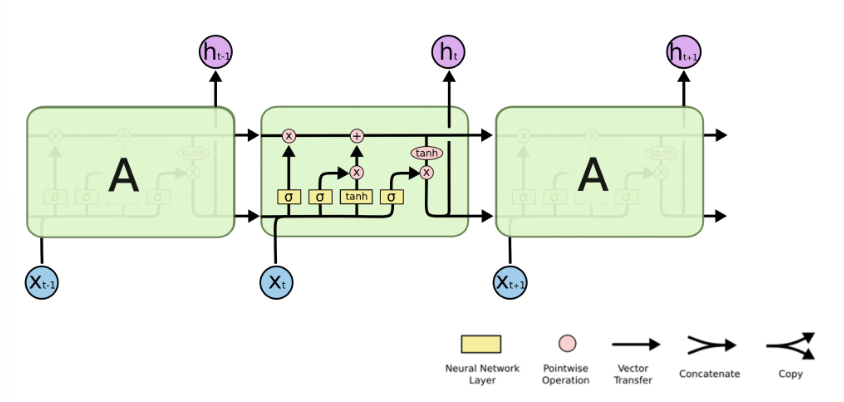

因果卷积的图像

- 因果卷积的图像可以想象成一个时间序列图,其中卷积核在时间轴上滑动,计算每个时刻的输出。

具体来说:

| 项目 | 描述 |

|---|---|

| 输入时间序列 | x [ t ] x[t] x[t] 表示在时刻 t t t 的输入值。 |

| 卷积核 | w [ k ] w[k] w[k] 表示卷积核的权重, K K K 是卷积核的大小。 |

| 输出时间序列 | y [ t ] y[t] y[t] 表示在时刻 t t t 的输出值,由输入时间序列和卷积核计算得到。 |

公式探索与推演运算

-

基本公式:

- y [ t ] = ( x ∗ w ) [ t ] = ∑ k = 0 K − 1 x [ t − k ] ⋅ w [ k ] y[t] = (x * w)[t] = \sum_{k=0}^{K-1} x[t-k] \cdot w[k] y[t]=(x∗w)[t]=∑k=0K−1x[t−k]⋅w[k]:表示基本的卷积操作。

-

扩展公式:

- 在因果卷积神经网络中,通常会使用多个卷积层来提取特征。每个卷积层的输出都会作为下一个卷积层的输入。

- 通过堆叠多个卷积层,网络可以捕捉时间序列中的长期依赖关系。

-

激活函数与残差连接:

- 在每个卷积层之后,通常会使用激活函数(如ReLU)来增加网络的非线性。

- 残差连接(Residual Connection)也常用于因果卷积神经网络中,以帮助网络学习更深的层次。

-

预测公式:

- 在进行时间序列预测时,网络的输出层通常会使用线性激活函数来得到预测值。

- 预测值可以表示为 y ^ [ t ] = ∑ k = 0 K − 1 x [ t − k ] ⋅ w [ k ] + b \hat{y}[t] = \sum_{k=0}^{K-1} x[t-k] \cdot w[k] + b y^[t]=∑k=0K−1x[t−k]⋅w[k]+b,其中 b b b 是偏置项。

关键词提炼

#因果卷积神经网络

#时间序列预测

#卷积操作

#长期依赖关系

#残差连接

![[ECharts] There is a chart instance already initialized on the dom. 已存在图表,渲染重复](https://i-blog.csdnimg.cn/direct/2357a51eef784635bb4e8c7341e2f0fc.png)