Deep Learning for 3D Point Clouds: A Survey - 3D点云的深度学习:一项调查(IEEE TPAMI 2020)

- 摘要

- 1. 引言

- 2. 背景

- 2.1 数据集

- 2.2 评估指标

- 3. 3D形状分类

- 3.1 基于多视图的方法

- 3.2 基于体积的方法

- 3.3 基于点的方法

- 3.3.1 逐点MLP方法

- 3.3.2 基于卷积的方法

- 3.3.3 基于图形的方法

- 3.3.4 基于分层数据结构的方法

- 3.3.5 其他方法

- 3.4 总结

- 4. 3D目标检测和跟踪

- 4.1 3D目标检测

- 4.1.1 基于区域提案的方法

- 4.1.2 单发方法

- 4.2 3D目标跟踪

- 4.3 3D场景流估计

- 4.4 总结

- 5. 3D点云分割

- 5.1 3D语义分割

- 5.1.1 基于投影的方法

- 5.1.2 基于离散化的方法

- 5.1.3 混合方法

- 5.1.4 基于点的方法

- 5.2 实例分割

- 5.2.1 基于提案的方法

- 5.2.2 无提案方法

- 5.3 部件分割

- 5.4 总结

- 6. 结论

- REFERENCES

声明:此翻译仅为个人学习记录

文章信息

- 标题:Deep Learning for 3D Point Clouds: A Survey (IEEE TPAMI 2020)

- 作者:Yulan Guo∗, Hanyun Wang∗, Qingyong Hu∗, Hao Liu∗, Li Liu, and Mohammed Bennamoun

- arxiv链接:https://arxiv.53yu.com/pdf/1912.12033.pdf

- 文章页面:https://github.com/QingyongHu/SoTA-Point-Cloud

摘要

由于点云学习在计算机视觉、自动驾驶和机器人等许多领域的广泛应用,点云学习最近引起了越来越多的关注。作为人工智能中的一项主要技术,深度学习已经成功地用于解决各种2D视觉问题。然而,由于使用深度神经网络处理点云所面临的独特挑战,点云的深度学习仍处于起步阶段。最近,点云上的深度学习变得更加繁荣,有许多方法被提出来解决这一领域的不同问题。为了促进未来的研究,本文全面回顾了点云深度学习方法的最新进展。它包括三个主要任务,包括3D形状分类、3D目标检测和跟踪以及3D点云分割。它还介绍了几个公开可用数据集的比较结果,以及富有洞察力的观察结果和启发未来研究方向。

索引术语-深度学习、点云、3D数据、形状分类、形状检索、目标检测、目标跟踪、场景流、实例分割、语义分割、部件分割。

1. 引言

随着3D采集技术的快速发展,3D传感器变得越来越可用且价格合理,包括各种类型的3D扫描仪、LiDAR和RGB-D相机(如Kinect、RealSense和Apple深度相机)[1]。这些传感器获取的3D数据可以提供丰富的几何、形状和比例信息[2],[3]。与2D图像互补,3D数据为更好地理解机器周围环境提供了机会。3D数据在不同领域有许多应用,包括自动驾驶、机器人、遥感和医疗[4]。

3D数据通常可以用不同的格式表示,包括深度图像、点云、网格和体积网格。作为一种常用的格式,点云表示保留了3D空间中的原始几何信息,而无需任何离散化。因此,它是许多场景理解相关应用(如自动驾驶和机器人)的首选表示。最近,深度学习技术主导了许多研究领域,如计算机视觉、语音识别和自然语言处理。然而,3D点云上的深度学习仍然面临几个重大挑战[5],例如数据集的规模小、高维度和3D点云的非结构化性质。在此基础上,本文重点分析了用于处理3D点云的深度学习方法。

点云的深度学习越来越受到关注,尤其是在过去五年中。还发布了一些公开可用的数据集,如ModelNet[6]、ScanObjectNN[7]、ShapeNet[8]、PartNet[9]、S3DIS[10]、ScanNet[11]、Semantic3D[12]、ApolloCar3D[13]和KITTI Vision Benchmark Suite[14]、[15]。这些数据集进一步推动了对3D点云的深度学习研究,提出了越来越多的方法来解决与点云处理相关的各种问题,包括3D形状分类、3D目标检测和跟踪、3D点云分割、3D点云配准、6-DOF姿态估计和3D重建[16],[17],[18]。关于3D数据的深度学习的调查也很少,如[19]、[20]、[21]、[22]。然而,我们的论文是第一篇专门关注点云理解的深度学习方法的论文。3D点云现有深度学习方法的分类如图1所示。

与现有文献相比,这项工作的主要贡献可以总结如下:

-

1) 据我们所知,这是第一篇全面涵盖多个重要点云理解任务的深度学习方法的调查论文,包括3D形状分类、3D目标检测和跟踪以及3D点云分割。

-

2) 与现有评论[19]、[20]不同,我们特别关注3D点云的深度学习方法,而不是所有类型的3D数据。

-

3) 本文介绍了点云深度学习的最新进展。因此,它为读者提供了最先进的方法。

-

4) 提供了几种公开可用数据集上现有方法的综合比较(如表2、3、4、5),并提供了简要总结和深入讨论。

本文的结构如下。第2节介绍了各个任务的数据集和评估指标。第3节回顾了3D形状分类的方法。第4节概述了3D目标检测和跟踪的现有方法。第5节介绍了点云分割的方法,包括语义分割、实例分割和部件分割。最后,第6节总结了本文。我们还提供了一个定期更新的项目页面:https://github.com/QingyongHu/SoTA-Point-Cloud.

图1. 3D点云的深度学习方法分类。

2. 背景

2.1 数据集

已经收集了大量数据集,以评估不同3D点云应用的深度学习算法的性能。表1列出了用于3D形状分类、3D目标检测和跟踪以及3D点云分割的一些典型数据集。特别是,还总结了这些数据集的属性。

对于3D形状分类,有两种类型的数据集:合成数据集[6],[8]和真实世界数据集[7],[11]。合成数据集中的目标是完整的,没有任何遮挡和背景。相比之下,真实世界数据集中的目标在不同级别被遮挡,一些目标被背景噪声污染。

对于3D目标检测和跟踪,有两种类型的数据集:室内场景[11],[25]和室外城市场景[14],[28],[30],[31]。室内数据集中的点云要么从密集深度图转换,要么从3D网格采样。户外城市数据集是为自动驾驶而设计的,其中目标在空间上很好地分离,这些点云很稀疏。

对于3D点云分割,这些数据集由不同类型的传感器获取,包括移动激光扫描仪(MLS)[15]、[34]、[36]、空中激光扫描仪(ALS)[33]、[38]、静态地面激光扫描仪(TLS)[12]、RGB-D相机[11]和其他3D扫描仪[10]。这些数据集可用于开发各种挑战的算法,包括类似的干扰因素、形状不完整性和类不平衡。

2.2 评估指标

已经提出了不同的评估度量来测试这些方法用于各种点云理解任务。对于3D形状分类,总体精度(OA)和平均等级精度(mAcc)是最常用的性能标准。‘OA’表示所有测试实例的平均精度,‘mAcc’表示所有形状类别的平均精度。对于3D目标检测,平均精度(AP)是最常用的标准。它被计算为精度召回曲线下的面积。精度和成功通常用于评估3D单目标跟踪器的整体性能。平均多目标跟踪精度(AMOTA)和平均多目标追踪精度(AMOTP)是评估3D多目标跟踪的最常用标准。对于3D点云分割,OA、交并比(mIoU)和平均等级精度(mAcc)[10]、[12]、[15]、[36]、[37]是性能评估最常用的标准。特别是,平均平均精度(mAP)[39]也用于3D点云的实例分割。

3. 3D形状分类

该任务的方法通常首先学习每个点的嵌入,然后使用聚合方法从整个点云中提取全局形状嵌入。通过将全局嵌入馈送到几个完全连接的层中,最终实现了分类。根据神经网络输入的数据类型,现有的3D形状分类方法可分为基于多视图、基于体积和基于点的方法。几个里程碑方法如图2所示。

基于多视图的方法将非结构化点云投影到2D图像中,而基于体积的方法将点云转换为3D体积表示。然后,利用成熟的2D或3D卷积网络来实现形状分类。相反,基于点的方法直接处理原始点云,而无需任何体素化或投影。基于点的方法不会引入明显的信息丢失,并且越来越流行。请注意,本文主要关注基于点的方法,但也包括少数基于多视图和基于体积的方法,以确保完整性。

表1. 3D形状分类、3D目标检测和跟踪以及3D点云分割的现有数据集汇总。用于评估的类的数量和注释类的数量(括号中显示)。

3.1 基于多视图的方法

这些方法首先将3D形状投影到多个视图中并提取视图特征,然后融合这些特征以进行精确的形状分类。对于这些方法来说,如何将多个视图方面的特征聚合到有区别的全局表示中是一个关键挑战。

MVCNN[40]是一项开创性的工作,它将多视图特征最大限度地集成到一个全局描述符中。然而,最大池仅保留特定视图中的最大元素,从而导致信息丢失。MHBN[41]通过协调双线性池来集成局部卷积特征,以产生紧凑的全局描述符。Yang等人[42]首先利用关系网络来利用一组视图上的相互关系(例如,区域-区域关系和视图-视图关系),然后聚合这些视图以获得有区别的3D目标表示。此外,还提出了几种其他方法[43]、[44]、[45]、[46]来提高识别精度。与之前的方法不同,Wei等人[47]通过将多个视图视为grpah节点,在View GCN中使用了有向图。然后将由局部图卷积、非局部消息传递和选择性视图采样组成的核心层应用于构建的图。所有级别的最大池节点特征的串联最终用于形成全局形状描述符。

3.2 基于体积的方法

这些方法通常将点云体素化为3D网格,然后在体积表示上应用3D卷积神经网络(CNN)进行形状分类。

Maturana等人[48]引入了一种称为VoxNet的体积占用网络,以实现稳健的3D目标识别。Wu等人[6]提出了一种基于卷积深度信念的3D ShapeNets,以学习来自各种3D形状的点的分布(由体素网格上的二进制变量的概率分布表示)。尽管已经取得了令人鼓舞的性能,但这些方法无法很好地扩展到密集的3D数据,因为计算和内存占用随着分辨率呈立方体增长。

为此,引入了分层和紧凑的结构(如八叉树),以降低这些方法的计算和存储成本。OctNet[49]首先使用混合网格八叉树结构分层划分点云,该结构表示沿规则网格具有多个浅八叉树的场景。使用位串表示对八叉树的结构进行有效编码,并通过简单的算法对每个体素的特征向量进行索引。Wang等人[50]提出了一种基于八叉树的CNN用于3D形状分类。在最精细的叶八分体中采样的3D模型的平均法向量被馈送到网络中,并且3D-CNN被应用于由3D形状表面占据的八分体。与基于密集输入网格的基线网络相比,OctNet对高分辨率点云所需的内存和运行时间要少得多。Le等人[51]提出了一种称为PointGrid的混合网络,它集成了点和网格表示,以实现高效的点云处理。在每个嵌入体积网格单元内采样恒定数量的点,这允许网络通过使用3D卷积提取几何细节。Ben Shabat等人[52]将输入点云转换为3D网格,这些网格由3D修改的Fisher矢量(3DmFV)方法进一步表示,然后通过传统的CNN架构学习全局表示。

图2. 最相关的基于深度学习的3D形状分类方法的时序概述。

3.3 基于点的方法

根据用于每个点的特征学习的网络架构,这类方法可以分为逐点MLP、基于卷积、基于图、基于分层数据结构的方法和其他典型方法。

3.3.1 逐点MLP方法

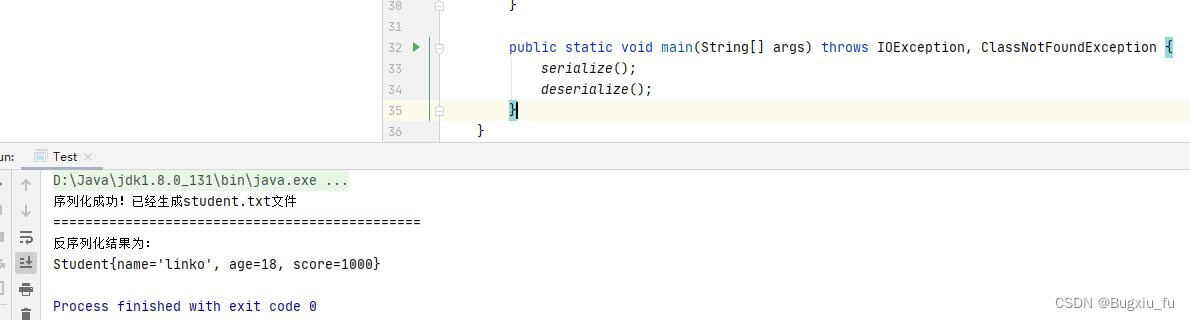

这些方法使用几个共享的多层感知器(MLP)独立地建模每个点,然后使用对称聚合函数聚合全局特征,如图3所示。

2D图像的典型深度学习方法不能直接应用于3D点云由于其固有的数据不规则性。作为一项开创性工作,PointNet[5]直接将点云作为其输入,并通过对称函数实现置换不变性。具体来说,PointNet通过多个MLP层独立学习逐点特征,并通过最大池化层提取全局特征。Deep sets[53]通过对所有表示求和并应用非线性变换来实现置换不变性。由于PointNet[5]中的每个点的特征都是独立学习的,因此无法捕获点之间的局部结构信息。因此,Qi等人[54]提出了一种分层网络PointNet++,以从每个点的邻域中捕捉精细的几何结构。作为PointNet++层次结构的核心,其集合抽象层由三层组成:采样层、分组层和基于PointNet的学习层。通过堆叠多个集合抽象级别,PointNet++从局部几何结构中学习特征,并逐层抽象局部特征。

由于其简单性和强大的表示能力,许多网络都是基于PointNet开发的[5]。Mo-Net[55]的架构类似于PointNet[5],但它采用有限的一组矩作为输入。Point Attention Transformers (PATs)[56]通过其相对于相邻点的绝对位置和相对位置来表示每个点,并通过MLP学习高维特征。然后,使用Group Shuffle Attention (GSA)来捕捉点之间的关系,并开发了置换不变、可微和可训练的端到端Gumbel Subset Sampling (GSS)层来学习分层特征。基于PointNet++[54],PointWeb[57]利用局部邻域的上下文,使用Adaptive Feature Adjustment (AFA)来改进点特征。Duan等人[58]提出了一种Structural Relational Network (SRN),以使用MLP学习不同局部结构之间的结构关系特征。Lin等人[59]通过为PointNet学习的输入空间和函数空间构建查找表,加快了推理过程。ModelNet和ShapeNet数据集上的推理时间在中等机器上比PointNet快1.5毫秒和32倍。SRINet[60]首先投影点云以获得旋转不变表示,然后利用基于PointNet的主干来提取全局特征,并利用基于图的聚合来提取局部特征。在PointASNL中,Yan等人[61]使用Adaptive Sampling (AS)模块来自适应调整由Furthest Point Sampling (FPS)算法采样的点的坐标和特征,并提出了一个局部非局部(L-NL)模块来捕获这些采样点的局部和长程相关性。

图3. PointNet的轻量级架构。n表示输入点的数量,M表示每个点的学习特征的维数。

3.3.2 基于卷积的方法

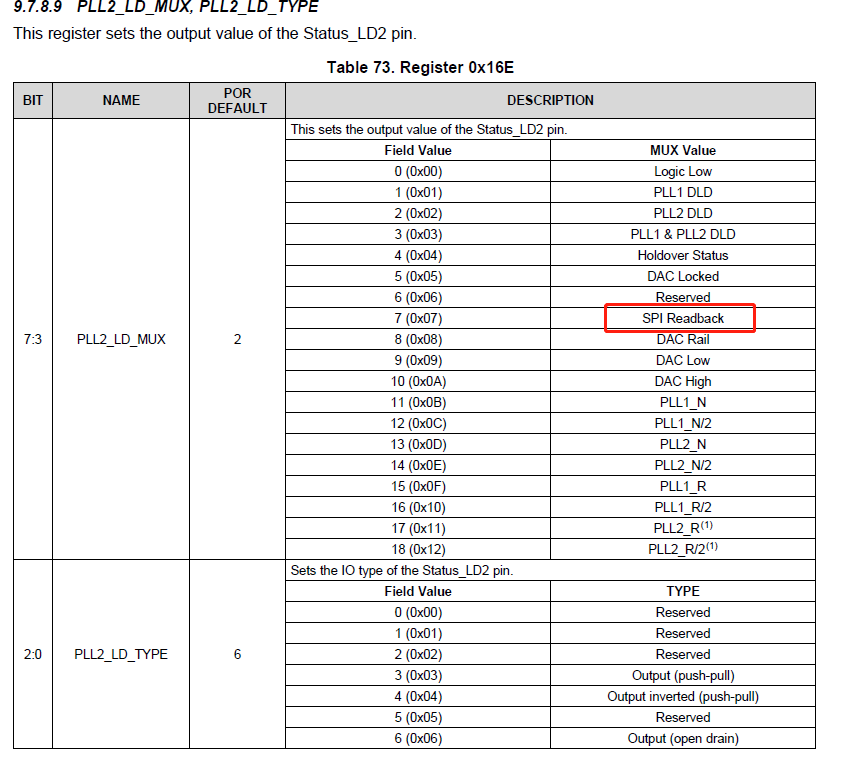

与2D网格结构(例如图像)上定义的核相比,由于点云的不规则性,3D点云的卷积核很难设计。根据卷积核的类型,当前的3D卷积方法可以分为连续和离散卷积方法,如图4所示。

3D连续卷积方法。这些方法定义了连续空间上的卷积核,其中相邻点的权重与相对于中心点的空间分布相关。

3D卷积可以被解释为给定子集上的加权和。作为RS-CNN的核心层[62],RSConv将某个点周围的点的局部子集作为其输入,通过学习从低层关系(如欧几里德距离和相对位置)到局部子集中点之间的高层关系的映射,使用MLP实现卷积。在[63]中,在单位球体中随机选择内核元素。然后使用基于MLP的连续函数来建立核元素和点云的位置之间的关系。在DensePoint[64]中,卷积被定义为具有非线性激活器的单层感知器(SLP)。通过连接来自所有先前层的特征来学习特征,以充分利用上下文信息。Thomas等人[65]使用一组可学习核点为3D点云提出了刚性和可变形核点卷积(KPConv)算子。ConvPoint[66]将卷积核分离为空间和特征部分。从单位球体中随机选择空间部分的位置,并通过简单的MLP学习加权函数。

一些方法还使用现有算法来执行卷积。在PointConv[67]中,卷积被定义为关于重要采样的连续3D卷积的蒙特卡洛估计。卷积核由加权函数(通过MLP层学习)和密度函数(通过核化密度估计和MLP层来学习)组成。为了提高内存和计算效率,3D卷积进一步简化为两种操作:矩阵乘法和2D卷积。使用相同的参数设置,其内存消耗可减少约64倍。在MCCNN[68]中,卷积被视为依赖于样本密度函数的蒙特卡罗估计过程(通过MLP实现)。然后使用泊松圆盘采样来构建点云层次结构。该卷积算子可用于执行两种或多种采样方法之间的卷积,并可处理不同的采样密度。在SpiderCNN[69]中,SpiderConv提出将卷积定义为阶跃函数和在k个最近邻居上定义的泰勒展开的乘积。阶跃函数通过编码局部测地线距离来捕获粗略几何,泰勒展开通过在立方体顶点处插入任意值来捕获内在的局部几何变化。此外,还提出了基于径向基函数的3D点云卷积网络PCNN[70]。

已经提出了几种方法来解决3D卷积网络所面临的旋转等变问题。Esteves等人[71]提出了3D球形CNN来学习3D形状的旋转等变表示,其将多值球形函数作为其输入。局部卷积滤波器是通过在球面谐波域中使用锚点对频谱进行参数化而获得的。张量场网络[72]被提出将点卷积运算定义为可学习的径向函数和球面谐波的乘积,球面谐波与3D旋转、平移和置换局部等价。[73]中的卷积基于球面互相关定义,并使用广义快速傅里叶变换(FFT)算法实现。基于PCNN,SPHNet[74]通过在体积函数卷积期间合并球面调和核来实现旋转不变性。

图4. 点的局部邻域的连续和离散卷积的图示。(a) 表示以点p为中心的局部邻域qi;(b) 和(c)分别表示3D连续卷积和离散卷积。

为了加快计算速度,Flex卷积[75]将卷积核的权重定义为k个最近邻上的标准标量积,可以使用CUDA来加速。实验结果表明,它在具有较少参数和较低内存消耗的小数据集上具有竞争力。

3D离散卷积方法。这些方法在规则网格上定义卷积核,其中相邻点的权重与相对于中心点的偏移有关。

Hua等人[76]将非均匀3D点云转换为均匀网格,并在每个网格上定义卷积核。所提出的3D内核为落入同一网格的所有点分配相同的权重。对于给定点,位于同一网格上的所有相邻点的平均特征是从上一层计算的。然后,对所有网格的平均特征进行加权和求和,以产生当前层的输出。Lei等人[77]通过将3D球形相邻区域划分为多个体积仓并将每个仓与可学习加权矩阵相关联,定义了球形卷积核。一个点的球面卷积核的输出由其相邻点的加权激活值的平均值的非线性激活确定。在GeoConv[78]中,一个点与其相邻点之间的几何关系是基于六个基显式建模的。沿着基的每个方向的边缘特征由方向相关的可学习矩阵独立地加权。然后根据给定点及其相邻点形成的角度来聚集这些方向相关特征。对于给定点,其在当前层的特征定义为给定点及其在上一层的相邻边缘特征的总和。

PointCNN[79]通过χ-conv变换(通过MLP实现)将输入点转换为潜在的和潜在的规范阶,然后对转换的特征应用典型的卷积算子。通过将点特征插值到相邻的离散卷积核权重坐标,Mao等人[80]提出了插值卷积算子InterpCov,以测量输入点云和核权重坐标之间的几何关系。Zhang等人[81]提出了一种RIConv算子来实现旋转不变性,该算子将低级旋转不变性几何特征作为输入,然后通过简单的装箱方法将卷积转换为1D。A-CNN[82]通过相对于查询点的每个环上的核大小循环邻居阵列来定义环形卷积,并学习局部子集中相邻点之间的关系。

为了降低3D CNN的计算和存储成本,Kumawat等人[83]提出了一种基于3D短时傅里叶变换(STFT)的校正局部相位体积(ReLPV)块,以提取3D局部邻域中的相位,这显著减少了参数的数量。在SFCNN[84]中,点云被投影到具有对齐球坐标的正二十面体晶格上。然后,通过卷积最大池卷积结构,对从球格顶点及其相邻顶点连接的特征进行卷积。SFCNN抗旋转和扰动。

3.3.3 基于图形的方法

基于图的网络将点云中的每个点视为图的顶点,并基于每个点的邻居为图生成有向边。然后在空间或光谱域中执行特征学习[85]。图5显示了一个典型的基于图形的网络。

图5. 基于图形的网络示意图。

空间域中基于图的方法。这些方法定义了空间域中的操作(例如卷积和池)。具体而言,卷积通常通过空间邻居上的MLP来实现,并且通过聚合来自每个点的邻居的信息来采用池来生成新的粗化图。每个顶点处的特征通常被指定坐标、激光强度或颜色,而每个边缘处的特征则通常被指定两个连接点之间的几何属性。

作为一项开创性工作,Simonovsky等人[85]将每个点视为图的顶点,并通过有向边将每个顶点连接到其所有邻居。然后,使用滤波器生成网络(例如,MLP)提出边缘条件卷积(ECC)。采用最大池来聚集邻域信息,并基于VoxelGrid实现图粗化[86]。在DGCNN[87]中,在特征空间中构建图,并在网络的每一层之后动态更新。作为EdgeConv的核心层,MLP被用作每个边缘的特征学习函数,并将通道对称聚合应用于与每个点的邻居相关联的边缘特征。此外,LDGCNN[88]移除了变换网络,并链接了DGCNN[87]中不同层的分层特征,以提高其性能并减小模型大小。还提出了一种端到端无监督深度自动编码器网络(即FoldingNet[89]),以使用矢量化局部协方差矩阵和点坐标的级联作为其输入。受到Inception[90]和DGCNN[87]的启发,Hassani和Haley[91]提出了一种无监督的多任务自动编码器来学习点和形状特征。编码器是基于多尺度图构造的。解码器使用三个无监督任务构建,包括聚类、自监督分类和重建,这些任务与多任务损失一起进行训练。Liu等人[92]提出了一种基于图卷积的动态点聚集模块(DPAM),以将点聚集(采样、分组和汇集)过程简化为一个简单的步骤,该步骤通过聚集矩阵和点特征矩阵的乘法来实现。基于PointNet架构,通过堆叠多个DPAM来构建分层学习架构。与PointNet++[54]的层次策略相比,DPAM动态地利用了点的关系,并在语义空间中聚集了点。

为了利用局部几何结构,KCNet[93]基于核相关性学习特征。具体而言,表征局部结构几何类型的一组可学习点被定义为核。然后,计算核与给定点的邻域之间的亲和度。在G3D[94]中,卷积被定义为邻接矩阵的多项式的变体,而池化被定义为将拉普拉斯矩阵和顶点矩阵乘以粗化矩阵。ClusterNet[95]利用严格的旋转不变模块从每个点的k个最近邻居中提取旋转不变特征,并基于无监督聚集分层聚类方法和沃德链接标准构建点云的分层结构[96]。每个子集群中的特征首先通过EdgeConv块学习,然后通过最大池聚合。

为了解决当前数据结构化方法(如FPS和相邻点查询)的耗时问题,Xu等人[97]提出将基于体积的方法和基于点的方法的优点结合起来,以提高计算效率。在ModelNet分类任务上的实验表明,所提出的网格GCN网络的计算效率平均比其他模型快5倍。

谱域中基于图的方法。这些方法将卷积定义为频谱滤波,其实现为将图上的信号与图拉普拉斯矩阵的特征向量相乘[98],[99]。

RGCNN[100]通过将每个点与点云中的所有其他点连接来构造图,并更新每个层中的图拉普拉斯矩阵。为了使相邻顶点的特征更相似,在损失函数中添加了图形信号平滑度先验。为了解决数据的不同图拓扑所带来的挑战,AGCN[101]中的SGC-LL层利用可学习距离度量来参数化图上两个顶点之间的相似性。使用高斯核和学习距离对从图中获得的邻接矩阵进行归一化。HGNN[102]通过在超图上应用谱卷积来构建超边缘卷积层。

上述方法适用于完整图形。为了利用局部结构信息,Wang等人[103]提出了端到端光谱卷积网络LocalSpecGCN来处理局部图(由k个最近邻居构建)。该方法不需要对图拉普拉斯矩阵和图粗化层次进行任何离线计算。在PointGCN[104]中,基于来自点云的k个最近邻居构建图,并使用高斯核对每个边缘进行加权。卷积滤波器定义为图谱域中的切比雪夫多项式。全局池和多分辨率池用于捕捉点云的全局和局部特征。Pan等人[105]通过在谱域中的k个最近相邻图上应用卷积,提出了3DTI Net。通过从相对欧几里德距离和方向距离学习,实现了几何变换的不变性。

3.3.4 基于分层数据结构的方法

这些网络是基于不同的分层数据结构(例如八叉树和kd树)构建的。在这些方法中,沿着树从叶节点到根节点分层学习点特征。

Lei等人[77]提出了一种使用球面卷积核的八叉树引导CNN(如第3.3.2节所述)。网络的每一层对应于八叉树的一层,并且在每一层应用球面卷积核。当前层中神经元的值被确定为前一层中所有相关子节点的平均值。与基于八叉树的OctNet[49]不同,Kd-Net[106]是使用每次迭代时具有不同分裂方向的多个K-d树构建的。遵循自下而上的方法,使用MLP从其子节点的表示中计算非叶节点的表示。根节点的特征(描述整个点云)最终被馈送到完全连接的层以预测分类分数。注意,Kd-Net根据节点的拆分类型在每个级别共享参数。3DContextNet[107]使用标准的平衡K-d树来实现特征学习和聚合。在每个级别,首先基于局部线索(其对局部区域中的点之间的相互依赖性进行建模)和全局上下文线索(其建模一个位置相对于所有其他位置的关系)通过MLP来学习点特征。然后,使用MLP从其子节点计算非叶节点的特征,并通过最大池聚合。对于分类,重复上述过程直到获得根节点。

SO-Net网络的层次结构是通过执行点到节点k最近邻居搜索来构建的[108]。具体而言,使用修改的置换不变自组织映射(SOM)来建模点云的空间分布。通过一系列完全连接的层,从标准化的点到节点坐标学习单个点特征。SOM中每个节点的特征是使用通道最大池从与该节点相关联的点特征中提取的。然后使用类似于PointNet[5]的方法从节点特征中学习最终特征。与PointNet++[54]相比,SOM的层次结构更有效,并且充分探索了点云的空间分布。

3.3.5 其他方法

此外,还提出了许多其他方案。RBFNet[113]通过将稀疏分布的径向基函数(RBF)核的特征与可学习的核位置和大小进行聚合,明确地对点的空间分布进行建模。3DPointCapsNet[112]使用逐点MLP和卷积层学习点无关特征,并使用多个最大池化层提取全局潜在表示。基于无监督动态路由,然后学习具有强大代表性的潜在胶囊。Qin等人[116]提出了一种用于3D点云表示的端到端无监督域自适应网络PointDAN。为了捕获点云的语义属性,提出了一种自我监督的方法来重建点云,其部分已被随机重排[117]。Li等人[118]提出了一种自动增强框架PointAugment,用于自动优化和增强用于网络训练的点云样本。具体而言,每个输入样本的形状方向变换和点方向位移被自动学习,并且通过交替地优化和更新其增广器和分类器的可学习参数来训练网络。受形状上下文[119]的启发,Xie等人[109]提出了一种ShapeContextNet架构,通过将亲和点选择和紧凑特征聚合结合到使用点积自关注的软对齐操作中[120]。为了处理3D点云中的噪声和遮挡,Bobkov等人[121]将手工制作的基于点对函数的4D旋转不变描述符输入到4D卷积神经网络中。Prokudin等人[122]首先从单位球中随机采样具有均匀分布的基点集,然后将点云编码为与基点集的最小距离。因此,点云被转换为具有相对较小固定长度的向量。然后可以用现有的机器学习方法处理编码的表示。

RCNet[115]利用标准RNN和2D CNN构建用于3D点云处理的置换不变网络。首先将点云划分为平行光束并沿特定维度进行排序,然后将每个光束输入共享的RNN。学习的特征被进一步馈送到用于分层特征聚合的有效2D CNN中。为了增强其描述能力,RCNet-E被提议沿着不同的分区和排序方向集成多个RCNets。Point2Sequences[114]是另一个基于RNN的模型,它捕获了点云局部区域中不同区域之间的相关性。它将从多个尺度的局部区域学习的特征视为序列,并将这些来自所有局部区域的序列馈送到基于RNN的编码器-解码器结构中,以聚集局部区域特征。

表2. ModelNet10/40基准的比较3D形状分类结果。在这里,我们只关注基于点的网络。’#params’表示模型的参数数量,’OA’表示所有测试实例的平均精度,’mAcc’表示表中所有形状类别的平均精度。符号’-’表示结果不可用。

一些方法也可以从3D点云和2D图像中学习。在PVNet[110]中,通过嵌入网络将从多视图图像中提取的高级全局特征投影到点云的子空间中,并通过软注意力掩模与点云特征融合。最后,对融合特征和多视图特征采用残差连接进行形状识别。随后,PVRNet[111]进一步被提出通过关系评分模块来利用3D点云与其多个视图之间的关系。基于关系分数,对原始二维全局视图特征进行增强,以实现点单视图融合和点多视图融合。

3.4 总结

ModelNet10/40[6]数据集是3D形状分类最常用的数据集。表2显示了不同基于点的网络所获得的结果。可以得出几个观察结果:

-

逐点MLP网络通常用作其他类型网络学习逐点特征的基本构建块。

-

作为标准的深度学习架构,基于卷积的网络可以在不规则的3D点云上实现卓越的性能。不规则数据的离散和连续卷积网络都应受到更多关注。

-

由于其固有的强大处理不规则数据的能力,近年来,基于图形的网络越来越受到关注。然而,在谱域中将基于图的网络扩展到各种图结构仍然具有挑战性。

4. 3D目标检测和跟踪

在本节中,我们将回顾3D目标检测、3D目标跟踪和3D场景流估计的现有方法。

4.1 3D目标检测

典型的3D目标检测器将场景的点云作为其输入,并在每个检测到的目标周围生成一个定向的3D边界框,如图6所示。与图像中的目标检测类似[123],3D目标检测方法可分为两类:基于区域提案的方法和单发方法。几个里程碑方法如图7所示。

图6. 3D目标检测示意图。(a) 和(b)最初分别显示在[124]和[125]中。

4.1.1 基于区域提案的方法

这些方法首先提出包含目标的几个可能区域(也称为提案),然后提取区域特征以确定每个提案的类别标签。根据其目标提案生成方法,这些方法可以进一步分为三类:基于多视图的方法、基于分割的方法和基于截头体的方法。

基于多视图的方法。这些方法融合了来自不同视图的图(例如,LiDAR前视图、鸟瞰图(BEV)和图像)的提案特征,以获得3D旋转框,如图8(a)所示。这些方法的计算成本通常很高。

Chen等人[4]从BEV图生成了一组高度精确的3D候选框,并将其投影到多个视图的特征图(例如,LiDAR前视图图像、RGB图像)。然后,他们将不同视图中的这些区域特征组合起来,以预测定向的3D边界框,如图8(a)所示。尽管该方法在0.25的交并比(IoU)处仅用300个提案就实现了99.1%的召回率,但其速度对于实际应用来说太慢了。随后,已经从两个方面开发了几种方法来改进多视图3D目标检测方法。

首先,已经提出了几种方法来有效地融合不同模态的信息。为了生成对小目标具有高召回率的3D提案,Ku等人[126]提出了一种基于多模态融合的区域提案网络。他们首先使用裁剪和调整大小操作从BEV和图像视图中提取等大小的特征,然后使用元素平均值池融合这些特征。Liang等人[127]利用连续卷积实现不同分辨率的图像和3D激光雷达特征图的有效融合。具体而言,他们为BEV空间中的每个点提取最近的对应图像特征,然后使用双线性插值,通过将图像特征投影到BEV平面中来获得密集的BEV特征图。实验结果表明,密集BEV特征图比离散图像特征图和稀疏LiDAR特征图更适合于3D目标检测。Liang等人[128]提出了一种用于端到端训练的多任务多传感器3D目标检测网络。具体而言,利用多个任务(例如,2D目标检测、地面估计和深度完成)来帮助网络学习更好的特征表示。进一步利用所学习的跨模态表示来产生高度准确的目标检测结果。实验结果表明,该方法在2D、3D和BEV检测任务上实现了显著改进,并在TOR4D基准[129]、[130]上优于先前的最先进方法。

其次,研究了提取输入数据的鲁棒表示的不同方法。Lu等人[39]通过引入空间通道注意力(SCA)模块来探索多尺度上下文信息,该模块捕捉场景的全局和多尺度上下文,并突出有用的特征。他们还提出了一个扩展空间非采样(ESU)模块,通过组合多尺度低层次特征,获得具有丰富空间信息的高层次特征,从而生成可靠的3D目标提案。尽管可以实现更好的检测性能,但上述多视图方法需要较长的运行时间,因为它们为每个方案执行特征池。随后,Zeng等人[131]使用预RoI池卷积来提高[4]的效率。具体来说,他们将大部分卷积运算移动到RoI池模块之前。因此,对所有目标提案执行一次RoI卷积。实验结果表明,该方法可以以11.1 fps的速度运行,比MV3D[4]快5倍。

基于分割的方法。这些方法首先利用现有的语义分割技术去除大部分背景点,然后在前景点上生成大量高质量的提案以节省计算,如图8(b)所示。与多视图方法[4]、[126]、[131]相比,这些方法实现了更高的目标召回率,并且更适用于具有高度遮挡和拥挤目标的复杂场景。

Yang等人[132]使用2D分割网络来预测前景像素,并将其投影到点云中,以去除大多数背景点。然后,他们在预测的前景点上生成提案,并设计了一个名为PointsIoU的新标准,以减少提案的冗余和模糊性。继[132]之后,Shi等人[133]提出了PointRCNN框架。具体来说,他们直接分割3D点云以获得前景点,然后融合语义特征和局部空间特征以产生高质量的3D框。继[133]的区域提案网络(RPN)阶段之后,Jesus等人[134]提出了一项开拓性工作,以利用图形卷积网络(GCN)进行3D目标检测。具体来说,引入了两个模块来使用图卷积来细化目标提案。第一模块R-GCN利用提案中包含的所有点来实现每个提案的特征聚合。第二个模块C-GCN融合来自所有提案的帧间信息,通过利用上下文回归精确的目标框。Sourabh等人[135]将点云投影到基于图像的分割网络的输出中,并将语义预测分数附加到点上。绘制的点被馈送到现有的检测器[133]、[136]、[137]中,以实现显著的性能改进。Yang等人[138]将每个点与球形锚点相关联。然后使用每个点的语义得分来移除冗余锚点。因此,与之前的方法[132],[133]相比,该方法以较低的计算成本实现了较高的召回率。此外,提出了PointsPool层来学习提案中内部点的紧凑特征,并引入了并行IoU分支来提高定位精度和检测性能。

图7. 最相关的基于深度学习的3D目标检测方法的时序概述。

基于截头体的方法。这些方法首先利用现有的2D目标检测器来生成目标的2D候选区域,然后为每个2D候选区域提取3D截头体提案,如图8(c)所示。尽管这些方法可以有效地提出3D目标的可能位置,但逐步流水线使其性能受到2D图像检测器的限制。

F-PointNets[139]是这方面的一项开创性工作。它为每个2D区域生成一个截头体提案,并应用PointNet[5](或PointNet++[54])来学习每个3D截头体的点云特征,以进行amodal 3D框估计。在后续工作中,Zhao等人[140]提出了一个Point-SENet模块来预测一组缩放因子,这些缩放因子进一步用于自适应地突出有用的特征并抑制信息较少的特征。他们还将PointSIFT[141]模块集成到网络中,以捕获点云的方向信息,这实现了对形状缩放的强大鲁棒性。与F-PointNets[139]相比,该方法在室内和室外数据集[14]、[25]上都实现了显著的改进。

Xu等人[142]利用2D图像区域及其对应的截头体点来精确回归3D框。为了融合图像特征和点云的全局特征,他们提出了一个用于框角位置直接回归的全局融合网络。他们还提出了一种密集融合网络,用于预测每个角点的逐点偏移。Shin等人[143]首先从2D图像中估计目标的2D边界框和3D姿态,然后提取多个几何上可行的目标候选。这些3D候选被馈送到框回归网络中,以预测准确的3D目标框。Wang等人[144]为每个2D区域生成了沿着截头体轴的截头体序列,并应用PointNet[5]为每个截头体提取特征。对截头体级特征进行改造以生成2D特征图,然后将其馈送到用于3D框估计的全卷积网络中。该方法在基于2D图像的方法中实现了最先进的性能,并在官方KITTI排行榜中排名第一。Johannes等人[145]首先在BEV图上获得了初步检测结果,然后根据BEV预测提取了小的点子集(也称为面片)。应用局部细化网络来学习面片的局部特征,以预测高度精确的3D边界框。

其他方法。受图像中目标检测中轴对齐IoU的成功启发,Zhou等人[146]将两个3D旋转边界框的IoU集成到几个最先进的检测器[133]、[137]、[158]中,以实现一致的性能改进。Chen等人[147]提出了一种使用点云和体素表示的两阶段网络架构。首先,对点云进行体素化,并将其馈送到3D主干网络以产生初始检测结果。第二,进一步利用初始预测的内点特征进行方框细化。虽然这种设计在概念上很简单,但在保持16.7 fps的速度的同时,它实现了与[133]相当的性能。Shi等人[148]提出了PointVoxel RCNN(PV-RCNN),以利用3D卷积网络和基于PointNet的集合抽象来学习点云特征。具体而言,输入点云首先被体素化,然后被馈送到3D稀疏卷积网络中,以生成高质量的提案。然后通过体素集合抽象模块将学习到的体素特征编码成一小组关键点。此外,他们还提出了一个关键点到网格ROI抽象模块,以捕获丰富的上下文信息,用于框细化。实验结果表明,该方法以显著的优势优于先前的方法,并且在KITTI 3D检测基准的Car类中排名第一(排名是指提交时间:2020年6月12日)。

表3. KITTI测试3D检测基准的对比3D目标检测结果。3D边界框IoU阈值对于汽车为0.7,对于行人和骑车人为0.5。模态为激光雷达(L)和图像(I)’E’、’M’和’H’分别表示简单、中等和困难的类目标。为了简单起见,我们省略了值后面的’%’。符号’-’表示结果不可用。

受基于Hough投票的2D目标检测器的启发,Qi等人[124]提出VoteNet直接投票从点云中选择目标的虚拟中心点,并通过聚合投票特征生成一组高质量的3D目标提案。VoteNet显著优于仅使用几何信息的先前方法,并在两个大型室内基准(即ScanNet[11]和SUN RGB-D[25])上实现了最先进的性能。然而,对于部分遮挡的目标,虚拟中心点的预测是不稳定的。此外,Feng等人[149]添加了方向向量的辅助分支,以提高虚拟中心点和3D候选框的预测精度。此外,构建了提案之间的3D目标-目标关系图,以强调用于精确目标检测的有用特征。Qi等人[150]通过将2D目标检测线索(例如,几何和语义/纹理线索)融合到3D投票管道中,提出了一种ImVoteNet检测器。受3D目标的真值框提供目标内部部分的准确位置这一观察结果的启发,Shi等人[151]提出了Part-A2-Net,它由部分感知阶段和部分聚合阶段组成。部分感知阶段应用具有稀疏卷积和稀疏去卷积的UNet-like[165]网络,以学习用于预测和粗略生成目标内部分位置的逐点特征。部件聚合阶段采用RoI感知池来聚合预测的部件位置,以进行方框细化。

图8. 三类基于区域提案的3D目标检测方法的典型网络。从上到下:(a)基于多视图的方法,(b)基于分割的方法和(c)基于截头体的方法。

4.1.2 单发方法

这些方法直接预测类概率,并使用单级网络回归目标的3D边界框。它们不需要区域提案生成和后处理。因此,它们可以高速运行。根据输入数据的类型,单发方法可分为三类:基于BEV的方法、基于离散化的方法和基于点的方法。

基于BEV的方法。这些方法主要以BEV表示为输入。Yang等人[129]使用等间距单元离散场景的点云,并以类似的方式编码反射率,从而得到规则表示。然后应用全卷积网络(FCN)网络来估计目标的位置和方位角。该方法在以28.6 fps的速度运行时优于大多数单发方法(包括VeloFCN[154]、3D-FCN[155]和Vote3Deep[156])。后来,Yang等人[152]利用高清晰度(HD)地图提供的几何和语义先验信息来提高[129]的鲁棒性和检测性能。具体来说,他们从HD地图中获得地面点的坐标,然后使用相对于地面的距离进行BEV表示,以弥补道路坡度造成的平移差异。此外,他们沿着通道维度将二进制道路遮罩与BEV表示连接起来,以关注移动目标。由于高清地图并非随处可见,他们还提出了一个在线地图预测模块,以估计来自单个LiDAR点云的地图先验。这种地图感知方法在TOR4D[129]、[130]和KITTI[14]数据集上显著优于其基线。然而,它对不同密度点云的泛化性能较差。为了解决这个问题,Beltr´an等人[153]提出了一个归一化图,以考虑不同LiDAR传感器之间的差异。标准化贴图是一个2D网格,分辨率与BEV贴图相同,它编码每个单元格中包含的最大点数。结果表明,该归一化映射显著提高了基于BEV的检测器的泛化能力。

基于离散化的方法。这些方法将点云转换为规则的离散表示,然后应用CNN预测目标的类别和3D框。

Li等人[154]提出了第一种使用FCN进行3D目标检测的方法。他们将点云转换为2D点地图,并使用2D FCN预测目标的边界框和置信度。后来,他们[155]将点云离散化为具有长度、宽度、高度和通道维度的4D张量,并将基于2D FCN的检测技术扩展到3D域以进行3D目标检测。与[154]相比,基于3D FCN的方法[155]获得了超过20%的精度增益,但由于3D卷积和数据的稀疏性,不可避免地需要更多的计算资源。为了解决体素的稀疏性问题,Engelcke等人[156]利用以特征为中心的投票方案为每个非空体素生成一组投票,并通过累积投票获得卷积结果。其计算复杂度与所占体素的数量成比例。Li等人[157]通过堆叠多个稀疏3D CNN构建了3D骨干网络。该方法通过充分利用体素的稀疏性来节省内存并加速计算。该3D主干网络提取丰富的3D特征用于目标检测,而不引入沉重的计算负担。

Zhou等人[136]提出了一种基于体素的端到端可训练框架VoxelNet。他们将点云分割成等间距的体素,并将每个体素内的特征编码成4D张量。然后连接区域提案网络以产生检测结果。尽管它的性能很强,但由于体素和3D卷积的稀疏性,该方法非常慢。后来,Yan等人[158]使用稀疏卷积网络[166]来提高[136]的推理效率。他们还提出了正弦误差角损失来解决0和π方向之间的模糊性。Sindagi等人[159]在早期阶段通过融合图像和点云特征来扩展VoxelNet。具体而言,他们将[136]生成的非空体素投影到图像中,并使用预先训练的网络来提取每个投影体素的图像特征。然后将这些图像特征与体素特征连接起来,以生成精确的3D框。与[136]、[158]相比,该方法可以有效地利用多模态信息来减少误报和漏报。Lang等人[137]提出了一种名为PointPillars的3D目标检测器。该方法利用PointNet[5]学习垂直列(柱)中组织的点云的特征,并将学习到的特征编码为伪图像。然后应用2D目标检测流水线来预测3D边界框。在平均精度(AP)方面,PointPillars优于大多数融合方法(包括MV3D[4]、RoarNet[143]和AVOD[126])。此外,PointPillars可以在3D和BEV KITTI[14]基准上以62 fps的速度运行,因此非常适合实际应用。

受点云的部分空间信息不可避免地在现有单发检测器的逐渐缩小的特征图中丢失的观察结果的启发,He等人[160]提出了一种SA-SSD检测器,以利用细粒度结构信息来提高定位精度。具体来说,他们首先将点云转换为张量,并将其输入骨干网络以提取多阶段特征。此外,采用具有点级监督的辅助网络来引导特征学习点云的结构。实验结果表明,SA-SSD在KITTI BEV检测基准的Car类中排名第一(排名是指提交时间:2020年6月12日)。

基于点的方法。这些方法直接将原始点云作为其输入。3DSSD[161]是这方面的一项开创性工作。它为Distance-FPS(D-FPS)和Feature-FPS(F-FPS)引入了融合采样策略,以去除耗时的特征传播(FP)层和[133]中的细化模块。然后,候选生成(CG)层被用于充分利用代表点,这些代表点被进一步馈送到具有3D中心度标签的无锚回归头中,以预测3D目标框。实验结果表明,3DSSD在保持25 fps的速度的同时,优于两阶段基于点的方法PointRCNN[133]。

其他方法。Meyer等人[162]提出了一种称为LaserNet的高效3D目标检测器。该方法预测每个点的边界框上的概率分布,然后组合这些每个点的分布以生成最终的3D目标框。此外,使用点云的密集距离视图(RV)表示作为输入,并提出了一种快速均值移动算法以减少逐点预测产生的噪声。LaserNet在0至50米的范围内实现了最先进的性能,其运行时间明显低于现有方法。Meyer等人[163]随后扩展了LaserNet[162],以利用RGB图像提供的密集纹理(例如,50至70米)。具体来说,他们通过将3D点云投影到2D图像上,将LiDAR点与图像像素相关联,并利用这种关联将RGB信息融合到3D点中。他们还将3D语义分割作为学习更好表示的辅助任务。该方法在保持LaserNet的高效率的同时,在长距离(例如,50至70米)目标检测和语义分割方面实现了显著的改进。受孤立目标部分上的点可以提供关于目标位置和方向的丰富信息这一观察结果的启发,Chen等人[164]提出了一种新的热点表示和第一个基于热点的无锚检测器。具体来说,首先对原始点云进行体素化,然后将其输入主干网络以生成3D特征图。这些特征图用于同时对热点进行分类和预测3D边界框。注意,热点被分配在骨干网络的最后一个卷积层。实验结果表明,该方法具有相当的性能,并且对稀疏点云具有鲁棒性。Shi等人[125]提出了一种图形神经网络Point GNN,用于从激光雷达点云中检测3D目标。他们首先将输入点云编码为具有固定半径的近邻图,然后将该图输入点GNN以预测目标的类别和框。

4.2 3D目标跟踪

给定第一帧中目标的位置,目标跟踪的任务是估计其在后续帧中的状态[167],[168]。由于3D目标跟踪可以使用点云中丰富的几何信息,因此有望克服基于图像的跟踪所面临的几个缺点,包括遮挡、照明和尺度变化。

受暹罗网络[169]成功用于基于图像的目标跟踪的启发,Giancola等人[170]提出了一种具有形状完成正则化的3D暹罗网络。具体来说,他们首先使用卡尔曼滤波器生成候选,并使用形状正则化将模型和候选编码为紧凑表示。然后使用余弦相似度来搜索下一帧中被跟踪目标的位置。该方法可作为目标跟踪的替代方法,并显著优于大多数2D目标跟踪方法,包括STAPLECA[171]和SiamFC[169]。为了有效搜索指定目标,Zarzar等人[172]利用2D暹罗网络在BEV表示上生成大量粗目标候选。然后,他们利用3D暹罗网络中的余弦相似性来细化候选目标。在精度(即18%)和成功率(即12%)方面,该方法显著优于[170]。Simon等人[173]提出了一种用于语义点云的3D目标检测和跟踪架构。他们首先通过融合2D视觉语义信息生成体素化语义点云,然后利用时间信息提高多目标跟踪的准确性和鲁棒性。此外,他们还引入了一种功能强大且简化的评估指标(即尺度旋转平移分数(SRF)),以加快训练和推理。Complexer-YOLO实现了有希望的跟踪性能,并且仍然可以实时运行。此外,Qi等人[174]提出了点对盒(P2B)网络。他们将模板和搜索区域输入主干以获取种子。搜索区域种子被目标特定特征增强,然后通过霍夫投票回归潜在目标中心。实验结果表明,当以40 fps运行时,P2B的性能优于[170]超过10%。

4.3 3D场景流估计

给定两个点云X和Y,3D场景流D={di}N描述了X中每个点xi到Y中相应位置x’i的移动,例如x’i=xi+di。图9显示了两个KITTI点云之间的3D场景流。类似于2D视觉中的光流估计,一些方法已经开始从点云序列中学习有用的信息(例如3D场景流、空间临时信息)。

表4. KITTI测试BEV检测基准的对比3D目标检测结果。3D边界框IoU阈值对于汽车为0.7,对于行人和骑车人为0.5。模态为激光雷达(L)和图像(I)’E’、’M’和’H’分别表示简单、中等和困难类目标。为了简单起见,我们省略了值后面的’%’。符号’-’表示结果不可用。

图9. 两个KITTI点云之间的3D场景流,最初如[175]所示。点云X、Y和X的平移点云分别以红色、绿色和蓝色亮显。

Liu等人[175]提出FlowNet3D直接从一对连续点云学习场景流。FlowNet3D通过流嵌入层学习点级特征和运动特征。然而,FlowNet3D存在两个问题。首先,一些预测的运动矢量在其方向上与真值显著不同。其次,很难将FlowNet应用于非静态场景,特别是对于由可变形目标主导的场景。为了解决这个问题,Wang等人[176]引入了余弦距离损失,以最小化预测与真值之间的角度。此外,他们还提出了点到平面的距离损失,以提高刚性场景和动态场景的精度。实验结果表明,这两个损失项将FlowNet3D的准确率从57.85%提高到63.43%,并加快和稳定了训练过程。Gu等人[177]提出了一种分层Permutohideral Lattice FlowNet(HPLFlowNet),以直接估计来自大规模点云的场景流。提出了几个双边卷积层来从原始点云恢复结构信息,同时降低了计算成本。

为了有效地处理顺序点云,Fan和Yang[178]提出了PointRNN、PointGRU和PointLSTM网络以及一个序列到序列模型来跟踪移动点。PointRNN、PointGRU和PointLSTM能够捕获空间临时信息并对动态点云进行建模。类似地,Liu等人[179]提出MeteorNet直接从动态点云中学习表示。该方法学习从时空相邻点聚集信息。进一步引入直接分组和链式流分组来确定时间邻居。然而,上述方法的性能受到数据集规模的限制。Mittal等人[180]提出了两种自监督损失,以在大型未标记数据集上训练其网络。他们的主要思想是,稳健的场景流估计方法在前向和后向预测中都应该是有效的。由于场景流注释不可用,预测变换点的最近邻居被认为是伪真值。然而,真实的真值可能与最近的点不同。为了避免这个问题,他们计算了反向的场景流,并提出了一个循环一致性损失来将点转换到原始位置。实验结果表明,这种自监督方法超过了基于监督学习的方法的最先进性能。

4.4 总结

KITTI[14]基准是自动驾驶领域最具影响力的数据集之一,在学术界和工业界都普遍使用。表3和表4显示了不同检测器在KITTI测试3D基准上获得的结果。可以进行以下观察:

-

基于区域提案的方法是这两类方法中最常被研究的方法,在KITTI测试3D和BEV基准上都大大优于单发方法。

-

现有3D目标检测器有两个限制。首先,现有方法的远程检测能力相对较差。第二,如何充分利用图像中的纹理信息仍然是一个悬而未决的问题。

-

多任务学习是3D目标检测的未来方向。例如,MMF[128]学习跨模态表示,以通过合并多个任务实现最先进的检测性能。

-

3D目标跟踪和场景流估计是新兴的研究课题,自2019年以来逐渐受到越来越多的关注。

5. 3D点云分割

3D点云分割需要了解全局几何结构和每个点的细粒度细节。根据分割粒度,3D点云分割方法可分为三类:语义分割(场景级)、实例分割(目标级)和部件分割(部件级)。

5.1 3D语义分割

给定一个点云,语义分割的目标是根据点的语义将其分为几个子集。与3D形状分类的分类法(第3节)类似,语义分割有四种范式:基于投影的、基于离散化的、基于点的和混合方法。

基于投影和离散化的方法的第一步是将点云转换为中间规则表示,如多视图[181]、[182]、球形[183]、[184]、[185]、体积[166]、[186]、[187]、六面体晶格[188]、[189]和混合表示[190]、[191],如图11所示。然后将中间分割结果投影回原始点云。相反,基于点的方法直接适用于不规则点云。图10显示了几种代表性方法。

5.1.1 基于投影的方法

这些方法通常将3D点云投影到2D图像中,包括多视图和球形图像。

多视图表示。Lawin等人[181]首先从多个虚拟相机视图将3D点云投影到2D平面上。然后,使用多流FCN来预测合成图像上的逐像素得分。通过融合不同视图上的重新投影分数,获得每个点的最终语义标签。类似地,Boulch等人[182]首先使用多个相机位置生成了点云的几个RGB和深度快照。然后,他们使用2D分割网络对这些快照进行逐像素标记。使用残差校正进一步融合从RGB和深度图像预测的分数[192]。基于从局部欧几里得曲面采样点云的假设,Tatarchenko等人[193]引入了用于密集点云分割的切线卷积。该方法首先将每个点周围的局部曲面几何体投影到虚拟切平面。然后直接对表面几何结构进行切线卷积。该方法显示出极大的可扩展性,能够处理数百万点的大规模点云。总体而言,多视图分割方法的性能对视点选择和遮挡非常敏感。此外,这些方法没有充分利用潜在的几何和结构信息,因为投影步骤不可避免地引入信息丢失。

球形表示。为了实现3D点云的快速准确分割,Wu等人[183]提出了一种基于SqueezeNet[194]和条件随机场(CRF)的端到端网络。为了进一步提高分割精度,引入SquezeSegV2[184],通过使用无监督域自适应流水线来解决域移位。Milioto等人[185]提出了RangeNet++用于LiDAR点云的实时语义分割。首先将2D距离图像的语义标签转移到3D点云,进一步使用基于GPU的KNN后处理步骤来缓解离散化错误和模糊推理输出的问题。与单视图投影相比,球形投影保留了更多的信息,适合于LiDAR点云的标记。然而,这种中间表示不可避免地带来了一些问题,例如离散化误差和遮挡。

图10. 最相关的基于深度学习的3D语义分割方法的时序概述。

图11. 中间表示的图示。(a) 和(b)最初分别显示在[182]和[183]中。

5.1.2 基于离散化的方法

这些方法通常将点云转换为密集/稀疏的离散表示,例如体积和稀疏的置换体晶格。

密集离散化表示。早期的方法通常将点云体素化为密集网格,然后利用标准的3D卷积。Huang等人[195]首先将点云划分为一组占用体素,然后将这些中间数据提供给全3D CNN进行体素分割。最后,为体素内的所有点指定与体素相同的语义标签。该方法的性能严重受限于体素的粒度和由点云分割引起的边界伪影。此外,Tchapmi等人[196]提出了SEGCloud,以实现细粒度和全局一致的语义分割。该方法引入了确定性三线性插值,以将3D-FCNN[197]生成的粗体素预测映射回点云,然后使用完全连接的CRF(FC-CRF)来增强这些推断的每个点标签的空间一致性。Meng等人[186]引入了一种基于核的插值变分自动编码器架构,以编码每个体素内的局部几何结构。代替二进制占用表示,RBF用于每个体素以获得连续表示并捕获每个体素中的点分布。VAE还用于将每个体素内的点分布映射到紧凑的潜在空间。然后,使用对称群和等价CNN来实现鲁棒特征学习。

由于3D CNN的良好可扩展性,基于体积的网络可以在不同空间大小的点云上自由训练和测试。在完全卷积点网络(FCPN)[187]中,首先从点云中分层抽象不同层次的几何关系,然后使用3D卷积和加权平均池来提取特征并合并长距离相关性。该方法可以处理大规模点云,在推理过程中具有良好的可扩展性。Dai等人[198]提出了ScanComplete以实现3D扫描完成和每体素语义标记。该方法利用了完全卷积神经网络的可扩展性,并可以在训练和测试期间适应不同的输入数据大小。使用从粗到细的策略来分层地提高预测结果的分辨率。

总体而言,体积表示自然地保留了3D点云的邻域结构。其常规数据格式还允许直接应用标准3D卷积。这些因素导致该领域的性能稳步提高。然而,体素化步骤固有地引入了离散化伪影和信息丢失。通常,高分辨率会导致高内存和计算成本,而低分辨率会导致细节丢失。在实践中选择合适的网格分辨率是非常重要的。

稀疏离散化表示。体积表示自然是稀疏的,因为非零值的数量只占很小的百分比。因此,在空间稀疏数据上应用密集卷积神经网络是低效的。为此,Graham等人[166]提出了基于索引结构的子流形稀疏卷积网络。该方法通过将卷积的输出限制为仅与占用的体素相关,显著降低了存储和计算成本。同时,它的稀疏卷积还可以控制提取特征的稀疏性。这种子流形稀疏卷积适用于高维和空间稀疏数据的有效处理。此外,Choy等人[1999]提出了一种4D时空卷积神经网络,称为MinkowskiNet,用于3D视频感知。提出了一种广义稀疏卷积来有效地处理高维数据。进一步应用三边平稳条件随机场来增强一致性。

另一方面,Su等人[188]提出了基于双边卷积层(BCL)的稀疏晶格网络(SPLATNet)。该方法首先将原始点云插值到置换体稀疏网格,然后应用BCL对稀疏网格的占用部分进行卷积。然后将过滤后的输出内插回原始点云。此外,该方法允许对多视图图像和点云进行灵活的联合处理。此外,Rosu等人[189]提出LatticeNet以实现对大型点云的有效处理。还引入了一个称为DeformsSlice的数据相关插值模块,用于将晶格特征反向投影到点云。

5.1.3 混合方法

为了进一步利用所有可用信息,已经提出了几种方法来从3D扫描中学习多模态特征。Dai和Nießner[190]提出了一种结合RGB特征和几何特征的联合3D多视图网络。使用3D CNN流和多个2D流来提取特征,并提出了可微反投影层来联合融合所学习的2D嵌入和3D几何特征。此外,Chiang等人[200]提出了一个统一的基于点的框架,以从点云学习2D纹理外观、3D结构和全局上下文特征。该方法直接应用基于点的网络从稀疏采样的点集中提取局部几何特征和全局上下文,而无需任何体素化。Jaritz等人[191]提出了多视图PointNet(MVPNet),以聚合来自2D多视图图像的外观特征和规范点云空间中的空间几何特征。

5.1.4 基于点的方法

基于点的网络直接处理不规则点云。然而,点云是无秩序的和非结构化的,这使得直接应用标准CNN是不可行的。为此,提出了开创性工作PointNet[5],使用共享MLP学习每点特征,使用对称池函数学习全局特征。基于PointNet,最近提出了一系列基于点的网络。总体而言,这些方法可以大致分为逐点MLP方法、点卷积方法、基于RNN的方法和基于图的方法。

逐点MLP方法。这些方法通常使用共享MLP作为其网络中的基本单元,因为其效率高。然而,共享MLP提取的逐点特征不能捕捉点云中的局部几何结构和点之间的相互作用[5]。为了为每个点捕捉更广泛的上下文并学习更丰富的局部结构,引入了几种专用网络,包括基于相邻特征池、基于注意力的聚合和局部全局特征级联的方法。

图12. 基于点的方法图解。(a) -(d)最初分别显示在[54]、[201]、[202]和[203]中。

相邻特征池:为了捕获局部几何模式,这些方法通过聚集来自局部相邻点的信息来学习每个点的特征。特别是,PointNet++[54]对点进行分层分组,并从较大的局部区域逐步学习,如图12(a)所示。为了克服点云的不均匀性和密度变化带来的问题,还提出了多尺度分组和多分辨率分组。后来,Jiang等人[141]提出了一种PointSIFT模块,以实现方向编码和尺度感知。该模块通过三级有序卷积对来自八个空间方向的信息进行堆叠和编码。多尺度特征被连接以实现对不同尺度的适应性。与PointNet++中使用的分组技术(即球查询)不同,Engelmann等人[204]利用K-means聚类和KNN分别定义世界空间和特征空间中的两个邻域。基于来自同一类的点预期在特征空间中更接近的假设,引入成对距离损失和质心损失来进一步正则化特征学习。为了模拟不同点之间的相互作用,Zhao等人[57]提出了PointWeb,通过密集地构建局部完全链接的网络来探索局部区域中所有点对之间的关系。提出了一种自适应特征调整(AFA)模块,以实现信息交换和特征细化。该聚合操作有助于网络学习辨别特征表示。Zhang等人[205]基于同心球壳的统计数据,提出了一种称为Shellconv的置换不变卷积。该方法首先查询一组多尺度同心球,然后在不同的壳中使用最大池运算来汇总统计信息,使用MLP和1D卷积来获得最终的卷积输出。Hu等人[206]提出了一种高效且轻量级的网络,称为RandLA Net,用于大规模点云分割。该网络利用随机点采样在存储器和计算方面实现了显著的高效率。进一步提出了一种局部特征聚合模块来捕获和保存几何特征。

基于注意力的聚合:为了进一步提高分割精度,将注意力机制[120]引入点云分割。Yang等人[56]提出了一种组洗牌注意力来建模点之间的关系,并提出了置换不变、任务不可知和可微的Gumbel子集采样(GSS)来取代广泛使用的FPS方法。该模块对异常值不太敏感,可以选择具有代表性的点子集。为了更好地捕捉点云的空间分布,Chen等人[207]提出了局部空间感知(LSA)层,以基于点云的局部结构和空间布局来学习空间感知权重。与CRF相似,Zhao等人[208]提出了一种基于注意力的分数细化(ASR)模块,用于对网络产生的分割结果进行后处理。通过将相邻点的分数与学习到的注意力权重合并来细化初始分割结果。该模块可以很容易地集成到现有的深度网络中,以提高分割性能。

局部-全局连接:Zhao等人[112]提出了一种置换不变的PS2-Net,以结合点云的局部结构和全局上下文。Edgeconv[87]和NetVLAD[209]被重复堆叠以捕获局部信息和场景级全局特征。

点卷积方法。这些方法倾向于为点云提出有效的卷积算子。Hua等人[76]提出了一种逐点卷积算子,其中将相邻点合并到核单元中,然后与核权重卷积。如图12(b)所示,Wang等人[201]基于参数连续卷积层提出了一种称为PCCN的网络。该层的内核函数由MLP参数化,并跨越连续向量空间。Thomas等人[65]提出了一种基于核点卷积(KPConv)的核点全卷积网络(KP-FCNN)。具体而言,KPConv的卷积权重由到核点的欧几里德距离决定,核点的数量不是固定的。核点的位置被公式化为球面空间中最佳覆盖的优化问题。注意,半径邻域用于保持一致的接收场,而网格子采样用于每个层,以在不同密度的点云下实现高鲁棒性。在[211]中,Engelmann等人提供了丰富的消融实验和可视化结果,以显示感受野对基于聚集的方法性能的影响。他们还提出了一种扩展点卷积(DPC)操作来聚合扩展的相邻特征,而不是K个最近的邻居。该操作被证明在增加接受野方面非常有效,并且可以容易地集成到现有的基于聚合的网络中。

基于RNN的方法。为了从点云中捕获固有的上下文特征,递归神经网络(RNN)也被用于点云的语义分割。基于PointNet[5],Engelmann等人[213]首先将一块点转换为多尺度块和网格块,以获得输入级上下文。然后,将PointNet提取的逐块特征依次输入合并单元(CU)或循环合并单元(RCU),以获得输出级上下文。实验结果表明,引入空间上下文对提高分割性能非常重要。Huang等人[212]提出了一种轻量级的局部依赖性建模模块,并利用切片池层将无序点特征集转换为有序的特征向量序列。如图12(c)所示,Ye等人[202]首先提出了一个逐点金字塔池(3P)模块来捕获从粗到细的局部结构,然后利用双向分层RNN来进一步获得长距离空间依赖性。然后应用RNN来实现端到端学习。然而,当将局部邻域特征与全局结构特征聚合时,这些方法失去了点云的丰富几何特征和密度分布[220]。为了缓解刚性和静态池化操作造成的问题,Zhao等人[220]提出了一种动态聚合网络(DAR-Net),以同时考虑全局场景复杂性和局部几何特征。使用自适应的感受野和节点权重动态地聚集介质间特征。Liu等人[221]提出了3DCNN-DQN-RNN用于大规模点云的高效语义解析。该网络首先使用3D CNN网络学习空间分布和颜色特征,DQN进一步用于定位属于特定类别的目标。将最终连接的特征向量馈送到残差RNN中以获得最终分割结果。

基于图形的方法。为了捕捉3D点云的基本形状和几何结构,有几种方法采用图形网络。如图12(d)所示,Landrieu等人[203]将点云表示为一组互连的简单形状和叠加点,并使用属性有向图(即叠加点图)来捕获结构和上下文信息。然后,将大规模点云分割问题分为三个子问题,即几何齐次分割、叠加点嵌入和上下文分割。为了进一步改进分割步骤,Landrieu和Boussaha[214]提出了一个监督框架,将点云过度分割为纯叠加点。该问题被表述为由邻接图构造的深度度量学习问题。此外,还提出了一种图结构的对比损失来帮助识别目标之间的边界。

为了更好地捕捉高维空间中的局部几何关系,Kang等人[222]提出了基于图嵌入模块(GEM)和金字塔注意力网络(PAN)的PyramNet。GEM模块将点云表示为有向无环图,并使用协方差矩阵代替欧几里德距离来构建相邻相似性矩阵。PAN模块中使用四种不同大小的卷积核来提取具有不同语义强度的特征。在[215]中,提出了图注意卷积(GAC)来从局部相邻集合选择性地学习相关特征。该操作是通过基于不同的相邻点和特征通道的空间位置和特征差异来动态地分配关注权重来实现的。GAC可以学习捕获区分特征以进行分割,并且具有与常用的CRF模型相似的特性。Ma等人[223]提出了点全局上下文推理(PointGCR)模块,以使用无向图表示沿信道维度捕获全局上下文信息。PointGCR是一个即插即用、端到端可训练的模块。它可以很容易地集成到现有的分割网络中,以实现性能改进。

表5. S3DIS(包括Area5和6倍交叉验证)[10]、Semantic3D(包括语义-8和缩减-8子集)[12]、ScanNet[11]和SemanticKITTI[15]数据集的比较语义分割结果。总体精度(OA)、平均交并比(mIoU)是主要的评估指标。为了简单起见,我们省略了值后面的’%’。符号’-’表示结果不可用。

图13. 最相关的基于深度学习的3D实例分割方法的时序概述。

此外,最近的几项工作试图在弱监督下实现点云的语义分割。Wei等人[224]提出了一种两阶段方法来训练具有亚云级别标签的分割网络。Xu等人[225]研究了点云语义分割的几种不精确监督方案。他们还提出了一种网络,该网络只能用部分标记的点(例如10%)进行训练。

5.2 实例分割

与语义分割相比,实例分割更具挑战性,因为它需要更精确和细粒度的点推理。特别是,它不仅需要区分具有不同语义的点,还需要分离具有相同语义的实例。总体而言,现有方法可分为两组:基于提案的方法和无提案的方法。几个里程碑方法如图13所示。

5.2.1 基于提案的方法

这些方法将实例分割问题转化为两个子任务:3D目标检测和实例掩码预测。

Hou等人[226]提出了一种3D全卷积语义实例分割(3D-SIS)网络,以实现RGB-D扫描上的语义实例分割。该网络学习颜色和几何特征。与3D目标检测类似,3D区域提案网络(3D-RPN)和3D感兴趣区域(3D-RI)层用于预测边界框位置、目标类标签和实例掩码。在综合策略分析之后,Yi等人[227]提出了一种生成形状提案网络(GSPN),以生成高目标性3D提案。基于区域的PointNet(R-PointNet)进一步完善了这些提案。通过预测每个类标签的逐点二进制掩码来获得最终标签。与从点云直接回归3D边界框不同,该方法通过加强几何理解来去除大量无意义的提案。

通过将2D全景分割扩展到3D映射,Narita等人[228]提出了一种在线体积3D映射系统,以联合实现大规模3D重建、语义标记和实例分割。他们首先利用2D语义和实例分割网络获得像素级全景标签,然后将这些标签集成到体积图中。进一步使用完全连接的CRF来实现精确的分割。该语义映射系统可以实现高质量的语义映射和区分目标识别。Yang等人[229]提出了一种称为3D BoNet的单级、无锚和端到端可训练网络,以实现点云上的实例分割。该方法直接回归所有潜在实例的粗略3D边界框,然后利用点级二元分类器获得实例标签。特别地,边界框生成任务被公式化为最优分配问题。此外,还提出了一种多准则损失函数来正则化生成的边界框。该方法不需要任何后处理,并且计算效率高。Zhang等人[230]提出了一种网络,例如大规模室外激光雷达点云的分割。该方法使用自注意块学习点云鸟瞰图上的特征表示。最终实例标签是基于预测的水平中心和高度限制获得的。Shi等人[231]提出了一种分层感知变分去噪递归自动编码器(VDRAE)来预测室内3D空间的布局。目标提案通过递归上下文聚合和传播迭代生成和细化。

总的来说,基于提案的方法[226]、[227]、[229]、[232]是直观和直接的,并且实例分割结果通常具有良好的客观性。然而,这些方法需要多阶段的训练和冗余提案的修剪。因此,它们通常是耗时且计算昂贵的。

5.2.2 无提案方法

无提案方法[233]、[234]、[235]、[236]、[237]、[238]、[239]、[240]不具有目标检测模块。相反,他们通常将实例分割视为语义分割之后的后续聚类步骤。特别是,大多数现有方法都基于这样的假设,即属于同一实例的点应该具有非常相似的特征。因此,这些方法主要集中于区分特征学习和点分组。

在一项开创性工作中,Wang等人[233]首先引入了相似性组提案网络(SGPN)。该方法首先学习每个点的特征和语义图,然后引入相似度矩阵来表示每个成对特征之间的相似度。为了学习更多的辨别特征,他们使用双铰链损失来相互调整相似度矩阵和语义分割结果。最后,采用启发式和非最大抑制方法将相似点合并到实例中。由于相似度矩阵的构建需要大量的内存消耗,因此该方法的可扩展性受到限制。类似地,Liu等人[237]首先利用子流形稀疏卷积[166]来预测每个体素的语义得分和相邻体素之间的亲和力。然后,他们引入了一种聚类算法,根据预测的亲和度和网格拓扑将点分组到实例中。Mo等人[241]在PartNet中引入了detection-by-segmentation网络,以实现实例分割。PointNet++被用作主干来预测每个点的语义标签和不相交的实例掩码。此外,Liang等人[238]提出了用于区分嵌入学习的结构感知损失。这种损失考虑了特征的相似性和点之间的几何关系。基于注意力的图CNN进一步用于通过聚集来自邻居的不同信息来自适应地细化所学习的特征。

由于点的语义类别和实例标签通常相互依赖,因此已经提出了几种方法来将这两个任务耦合到单个任务中。Wang等人[234]通过引入端到端和可学习的关联分割实例和语义(ASIS)模块,整合了这两项任务。实验表明,通过该ASIS模块,语义特征和实例特征可以相互支持,从而提高性能。类似地,Zhao等人[242]提出了JSNet来实现语义和实例分割。此外,Pham等人[235]首先引入了多任务逐点网络(MT PNet)来为每个点分配标签,并通过引入辨别损失来规范特征空间中的嵌入[243]。然后,他们将预测的语义标签和嵌入融合到多值条件随机场(MV-CRF)模型中进行联合优化。最后,使用均值场变分推理生成语义标签和实例标签。Hu等人[244]首先提出了一种动态区域增长(DRG)方法,将点云动态分离为一组不相交的面片,然后使用无监督Kmeans++算法对所有这些面片进行分组。然后在块之间的上下文信息的指导下执行多尺度块分割。最后,这些标记的补丁被合并到目标级别,以获得最终的语义和实例标签。

为了在全3D场景上实现实例分割,Elich等人[236]提出了一种混合2D-3D网络,以从BEV表示和点云的局部几何特征中联合学习全局一致的实例特征。然后将学习到的特征组合起来以实现语义和实例分割。注意,与启发式GroupMerging算法[233]不同,更灵活的Meanshift[245]算法用于将这些点分组到实例中。或者,还引入了多任务学习用于实例分割。Lahoud等人[246]学习了每个实例的独特特征嵌入和估计目标中心的方向信息。提出了特征嵌入损失和方向损失来调整潜在特征空间中的学习特征嵌入。采用均值移位聚类和非最大值抑制将体素分组到实例中。该方法在ScanNet[11]基准测试上达到了最先进的性能。此外,预测的方向信息对于确定实例的边界特别有用。Zhang等人[247]将概率嵌入引入点云的实例分割。该方法还结合了不确定性估计,并为聚类步骤提出了一个新的损失函数。Jiang等人[240]提出了一个PointGroup网络,它由语义分割分支和偏移预测分支组成。进一步利用双集聚类算法和ScoreNet来获得更好的分组结果。

总之,无提案方法不需要计算昂贵的区域提案组件。然而,由这些方法分组的实例分割的目标性通常很低,因为这些方法不显式检测目标边界。

5.3 部件分割

3D形状的部件分割有两方面的困难。首先,具有相同语义标签的形状部件具有较大的几何变化和歧义。第二,具有相同语义的目标中的部件数量可能不同。

VoxSegNet[248]被提出用于在有限的解决方案下实现3D体素化数据的细粒度部件分割。提出了一种空间密集提取(SDE)模块(由堆叠的萎缩残差块组成),以从稀疏体积数据中提取多尺度鉴别特征。通过逐步应用注意力特征聚合(AFA)模块,进一步对学习到的特征进行重新加权和融合。Kalogerakis等人[249]将FCN和基于表面的CRF相结合,以实现端到端的3D部件分割。他们首先从多个视图生成图像以实现最佳表面覆盖,并将这些图像送入2D网络以生成置信度图。然后,这些置信图由基于表面的CRF汇总,该CRF负责整个场景的一致标记。Yi等人[250]引入了同步光谱CNN(SyncSpecCNN),以对不规则和非同构形状图执行卷积。引入了扩展卷积核的频谱参数化和频谱变换器网络,以解决部件的多尺度分析和形状之间的信息共享问题。

Wang等人[251]首先通过引入形状完全卷积网络(SFCN)并将三个低级几何特征作为其输入,在3D网格上执行形状分割。然后,他们利用基于投票的多标签图切割来进一步细化分割结果。Zhu等人[252]提出了一种用于3D形状共分割的弱监督CoSegNet。该网络将一组未分段的3D点云形状作为输入,并通过迭代最小化组一致性损失来生成形状部件标签。与CRF类似,提出了一个预先训练的部件细化网络,以进一步细化和去噪部件提案。Chen等人[253]提出了一种用于无监督、单镜头和弱监督3D形状共分割的分支自动编码器网络(BAE-NET)。该方法将形状共分割任务表述为表示学习问题,旨在通过最小化形状重建损失来找到最简单的部件表示。基于编码器-解码器架构,该网络的每个分支可以学习特定部件形状的紧凑表示。从每个分支学习的特征和点坐标然后被馈送到解码器以产生二进制值(指示该点是否属于该部件)。该方法具有良好的泛化能力,可以处理大型3D形状集合(最多5000+个形状)。然而,它对初始参数敏感,并且没有将形状语义纳入网络中,这阻碍了该方法在每次迭代中获得鲁棒和稳定的估计。Yu等人[254]提出了用于分层形状分割的自上而下递归部件分解网络(PartNet)。与现有的将形状分割为固定标签集的方法不同,该网络将部件分割表述为级联二进制标记问题,并基于几何结构将输入点云分解为任意数量的部件。Luo等人[255]为零镜头3D部件分割任务引入了基于学习的分组框架。为了提高跨类别泛化能力,该方法倾向于学习分组策略,该分组策略限制网络在局部上下文中学习局部级特征。

5.4 总结

表5显示了现有方法在公共基准测试上取得的结果,包括S3DIS[10]、Semantic3D[12]、ScanNet[39]和SemanticKITTI[15]。以下问题需要进一步调查:

-

由于常规数据表示,基于投影的方法和基于离散化的方法都可以利用其2D图像对应物的成熟网络架构。然而,基于投影的方法的主要局限性在于3D-2D投影造成的信息损失,而基于离散化的方法的最大瓶颈是分辨率提高导致的计算和存储成本的增加。为此,基于索引结构的稀疏卷积构建将是一个可行的解决方案,值得进一步探索。

-

基于点的网络是最常用的研究方法。然而,点表示自然不具有明确的相邻信息,大多数现有的基于点的方法诉诸于昂贵的相邻搜索机制(例如,KNN[79]或球查询[54])。这固有地限制了这些方法的效率,最近提出的点体素联合表示[256]将是进一步研究的一个有趣方向。

-

在点云分割中,从不平衡数据中学习仍然是一个具有挑战性的问题。尽管有几种方法[65]、[203]、[205]取得了显著的总体性能,但它们在少数族裔群体中的性能仍然有限。例如,RandLA Net[206]在Semantic3D的缩减-8子集上实现了76.0%的总体IoU,但在困难场景类上实现了41.1%的非常低的IoU。

-

大多数现有方法[5]、[54]、[79]、[205]、[207]都适用于小型点云(例如,1m×1m,4096个点)。实际上,深度传感器获取的点云通常是巨大的、大规模的。因此,有必要进一步研究大规模点云的有效分割问题。

-

一些工作[178]、[179]、[199]已经开始从动态点云中学习时空信息。预计时空信息可以帮助提高后续任务的性能,如3D目标识别、分割和补全。

6. 结论

本文介绍了最先进的3D理解方法,包括3D形状分类、3D目标检测和跟踪以及3D场景和目标分割。对这些方法进行了全面的分类和性能比较。还介绍了各种方法的优缺点,并列出了潜在的研究方向。

ACKNOWLEDGMENTS

This work was partially supported by the National Natural Science Foundation of China (No. 61972435, 61602499, 61872379), the Natural Science Foundation of Guangdong Province (2019A1515011271), the Science and Technology Innovation Committee of Shenzhen Municipality (JCYJ20190807152209394), the Australian Research Council (Grants DP150100294 and DP150104251), the China Scholarship Council (CSC) and the Academy of Finland.

REFERENCES

[1] Z. Liang, Y. Guo, Y. Feng, W. Chen, L. Qiao, L. Zhou, J. Zhang, and H. Liu, “Stereo matching using multi-level cost volume and multi-scale feature constancy,” IEEE TPAMI, 2019.

[2] Y. Guo, F. Sohel, M. Bennamoun, M. Lu, and J. Wan, “Rotational projection statistics for 3D local surface description and object recognition,” IJCV, 2013.

[3] Y. Guo, M. Bennamoun, F. Sohel, M. Lu, and J. Wan, “3D object recognition in cluttered scenes with local surface features: a survey,” IEEE TPAMI, 2014.

[4] X. Chen, H. Ma, J. Wan, B. Li, and T. Xia, “Multi-view 3D object detection network for autonomous driving,” in CVPR, 2017.

[5] C. R. Qi, H. Su, K. Mo, and L. J. Guibas, “PointNet: Deep learning on point sets for 3D classification and segmentation,” in CVPR, 2017.

[6] Z. Wu, S. Song, A. Khosla, F. Yu, L. Zhang, X. Tang, and J. Xiao, “3D shapeNets: A deep representation for volumetric shapes,” in CVPR, 2015.

[7] M. A. Uy, Q.-H. Pham, B.-S. Hua, T. Nguyen, and S.-K. Yeung, “Revisiting point cloud classification: A new benchmark dataset and classification model on real-world data,” in ICCV, 2019.

[8] A. X. Chang, T. Funkhouser, L. Guibas, P. Hanrahan, Q. Huang, Z. Li, S. Savarese, M. Savva, S. Song, and H. Su, “ShapeNet: An information-rich 3D model repository,” arXiv preprint arXiv:1512.03012, 2015.

[9] K. Mo, S. Zhu, A. X. Chang, L. Yi, S. Tripathi, L. J. Guibas, and H. Su, “PartNet: A large-scale benchmark for fine-grained and hierarchical part-level 3D object understanding,” in CVPR, 2019.

[10] I. Armeni, O. Sener, A. R. Zamir, H. Jiang, I. Brilakis, M. Fischer, and S. Savarese, “3D semantic parsing of large-scale indoor spaces,” in CVPR, 2016.

[11] A. Dai, A. X. Chang, M. Savva, M. Halber, T. Funkhouser, and M. Nießner, “ScanNet: Richly-annotated 3D reconstructions of indoor scenes,” in CVPR, 2017.

[12] T. Hackel, N. Savinov, L. Ladicky, J. Wegner, K. Schindler, and M. Pollefeys, “Semantic3D.net: A new large-scale point cloud classification benchmark,” ISPRS, 2017.

[13] X. Song, P. Wang, D. Zhou, R. Zhu, C. Guan, Y. Dai, H. Su, H. Li, and R. Yang, “Apollocar3D: A large 3D car instance understanding benchmark for autonomous driving,” in CVPR, 2019.

[14] A. Geiger, P. Lenz, and R. Urtasun, “Are we ready for autonomous driving,” in CVPR, 2012.

[15] J. Behley, M. Garbade, A. Milioto, J. Quenzel, S. Behnke, C. Stachniss, and J. Gall, “SemanticKITTI: A dataset for semantic scene understanding of lidar sequences,” in ICCV, 2019.

[16] G. Elbaz, T. Avraham, and A. Fischer, “3D point cloud registration for localization using a deep neural network auto-encoder,” in CVPR, 2017, pp. 4631–4640.

[17] A. Zeng, K.-T. Yu, S. Song, D. Suo, E. Walker, A. Rodriguez, and J. Xiao, “Multi-view self-supervised deep learning for 6D pose estimation in the amazon picking challenge,” in ICRA, 2017, pp. 1386–1383.

[18] X. Han, H. Laga, and M. Bennamoun, “Image-based 3D object reconstruction: State-of-the-art and trends in the deep learning era,” IEEE TPAMI, 2019.

[19] A. Ioannidou, E. Chatzilari, S. Nikolopoulos, and I. Kompatsiaris, “Deep learning advances in computer vision with 3D data: A survey,” ACM Computing Surveys, 2017.

[20] E. Ahmed, A. Saint, A. E. R. Shabayek, K. Cherenkova, R. Das, G. Gusev, D. Aouada, and B. Ottersten, “Deep learning advances on different 3D data representations: A survey,” arXiv preprint arXiv:1808.01462, 2018.

[21] Y. Xie, J. Tian, and X. Zhu, “A review of point cloud semantic segmentation,” IEEE GRSM, 2020.

[22] M. M. Rahman, Y. Tan, J. Xue, and K. Lu, “Recent advances in 3D object detection in the era of deep neural networks: A survey,” IEEE TIP, 2019.

[23] K. Siddiqi, J. Zhang, D. Macrini, A. Shokoufandeh, S. Bouix, and S. Dickinson, “Retrieving articulated 3-D models using medial surfaces,” Machine Vision and Applications, vol. 19, no. 4, pp. 261–275, 2008.

[24] M. De Deuge, B. Douillard, C. Hung, and A. Quadros, “Unsupervised feature learning for classification of outdoor 3D scans,” in ACRA, 2013.

[25] S. Song, S. P. Lichtenberg, and J. Xiao, “Sun RGB-D: A RGB-D scene understanding benchmark suite,” in CVPR, 2015.

[26] A. Patil, S. Malla, H. Gang, and Y.-T. Chen, “The H3D dataset for full-surround 3D multi-object detection and tracking in crowded urban scenes,” in ICRA, 2019.

[27] M.-F. Chang, J. Lambert, P. Sangkloy, J. Singh, S. Bak, A. Hartnett, D. Wang, P. Carr, S. Lucey, D. Ramanan et al., “Argoverse: 3D tracking and forecasting with rich maps,” in CVPR, 2019.

[28] R. Kesten, M. Usman, J. Houston, T. Pandya, K. Nadhamuni, A. Ferreira, M. Yuan, B. Low, A. Jain, P. Ondruska et al., “Lyft level 5 av dataset 2019,” 2019.

[29] Q.-H. Pham, P. Sevestre, R. S. Pahwa, H. Zhan, C. H. Pang, Y. Chen, A. Mustafa, V. Chandrasekhar, and J. Lin, “A*3D dataset: Towards autonomous driving in challenging environments,” ICRA, 2020.

[30] P. Sun, H. Kretzschmar, X. Dotiwalla, A. Chouard, V. Patnaik, P. Tsui, J. Guo, Y. Zhou, Y. Chai, B. Caine, V. Vasudevan, W. Han, J. Ngiam, H. Zhao, A. Timofeev, S. Ettinger, M. Krivokon, A. Gao, A. Joshi, Y. Zhang, J. Shlens, Z. Chen, and D. Anguelov, “Scalability in perception for autonomous driving: Waymo open dataset,” in CVPR, 2020.

[31] H. Caesar, V. Bankiti, A. H. Lang, S. Vora, V. E. Liong, Q. Xu, A. Krishnan, Y. Pan, G. Baldan, and O. Beijbom, “nuscenes: A multimodal dataset for autonomous driving,” in CVPR, 2020.

[32] D. Munoz, J. A. Bagnell, N. Vandapel, and M. Hebert, “Contextual classification with functional max-margin markov networks,” in CVPR, 2009, pp. 975–982.

[33] F. Rottensteiner, G. Sohn, J. Jung, M. Gerke, C. Baillard, S. Benitez, and U. Breitkopf, “The isprs benchmark on urban object classification and 3D building reconstruction,” ISPRS, 2012.

[34] A. Serna, B. Marcotegui, F. Goulette, and J.-E. Deschaud, “Parisrue-madame database: a 3D mobile laser scanner dataset for benchmarking urban detection, segmentation and classification methods,” in ICRA, 2014.

[35] B. Vallet, M. Br´edif, A. Serna, B. Marcotegui, and N. Paparoditis, “Terramobilita/iqmulus urban point cloud analysis benchmark,” Computers & Graphics, vol. 49, pp. 126–133, 2015.

[36] X. Roynard, J.-E. Deschaud, and F. Goulette, “Paris-lille-3d: A large and high-quality ground-truth urban point cloud dataset for automatic segmentation and classification,” IJRR, 2018.

[37] W. Tan, N. Qin, L. Ma, Y. Li, J. Du, G. Cai, K. Yang, and J. Li, “Toronto-3D: A large-scale mobile lidar dataset for semantic segmentation of urban roadways,” arXiv preprint arXiv:2003.08284, 2020.

[38] N. Varney, V. K. Asari, and Q. Graehling, “Dales: A large-scale aerial lidar data set for semantic segmentation,” arXiv preprint arXiv:2004.11985, 2020.

[39] H. Lu, X. Chen, G. Zhang, Q. Zhou, Y. Ma, and Y. Zhao, “SCANet: Spatial-channel attention network for 3D object detection,” in ICASSP, 2019.

[40] H. Su, S. Maji, E. Kalogerakis, and E. Learned-Miller, “Multi-view convolutional neural networks for 3D shape recognition,” in ICCV, 2015.

[41] T. Yu, J. Meng, and J. Yuan, “Multi-view harmonized bilinear network for 3D object recognition,” in CVPR, 2018.

[42] Z. Yang and L. Wang, “Learning relationships for multi-view 3D object recognition,” in ICCV, 2019.

[43] C. R. Qi, H. Su, M. Nießner, A. Dai, M. Yan, and L. J. Guibas, “Volumetric and multi-view CNNs for object classification on 3D data,” in CVPR, 2016.

[44] Y. Feng, Z. Zhang, X. Zhao, R. Ji, and Y. Gao, “GVCNN: Group-view convolutional neural networks for 3D shape recognition,” in CVPR, 2018.

[45] C. Wang, M. Pelillo, and K. Siddiqi, “Dominant set clustering and pooling for multi-view 3D object recognition,” BMVC, 2017.

[46] C. Ma, Y. Guo, J. Yang, and W. An, “Learning multi-view representation with LSTM for 3D shape recognition and retrieval,” IEEE TMM, 2018.

[47] X. Wei, R. Yu, and J. Sun, “View-gcn: View-based graph convolutional network for 3D shape analysis,” in CVPR, 2020.

[48] D. Maturana and S. Scherer, “VoxNet: A 3D convolutional neural network for real-time object recognition,” in IROS, 2015.

[49] G. Riegler, A. Osman Ulusoy, and A. Geiger, “OctNet: Learning deep 3D representations at high resolutions,” in CVPR, 2017.

[50] P.-S. Wang, Y. Liu, Y.-X. Guo, C.-Y. Sun, and X. Tong, “O-CNN: Octree-based convolutional neural networks for 3D shape analysis,” ACM TOG, 2017.

[51] T. Le and Y. Duan, “PointGrid: A deep network for 3D shape understanding,” in CVPR, 2018.

[52] Y. Ben-Shabat, M. Lindenbaum, and A. Fischer, “3D point cloud classification and segmentation using 3D modified fisher vector representation for convolutional neural networks,” arXiv preprint arXiv:1711.08241, 2017.

[53] M. Zaheer, S. Kottur, S. Ravanbakhsh, B. Poczos, R. R. Salakhutdinov, and A. J. Smola, “Deep sets,” in NeurIPS, 2017.

[54] C. R. Qi, L. Yi, H. Su, and L. J. Guibas, “PointNet++: Deep hierarchical feature learning on point sets in a metric space,” in NeurIPS, 2017.

[55] M. Joseph-Rivlin, A. Zvirin, and R. Kimmel, “Mo-Net: Flavor the moments in learning to classify shapes,” in ICCVW, 2018.

[56] J. Yang, Q. Zhang, B. Ni, L. Li, J. Liu, M. Zhou, and Q. Tian, “Modeling point clouds with self-attention and gumbel subset sampling,” in CVPR, 2019.

[57] H. Zhao, L. Jiang, C.-W. Fu, and J. Jia, “PointWeb: Enhancing local neighborhood features for point cloud processing,” in CVPR, 2019.

[58] Y. Duan, Y. Zheng, J. Lu, J. Zhou, and Q. Tian, “Structural relational reasoning of point clouds,” in CVPR, 2019.

[59] H. Lin, Z. Xiao, Y. Tan, H. Chao, and S. Ding, “Justlookup: One millisecond deep feature extraction for point clouds by lookup tables,” in ICME, 2019.

[60] X. Sun, Z. Lian, and J. Xiao, “SRINet: Learning strictly rotation-invariant representations for point cloud classification and segmentation,” in ACM MM, 2019.

[61] X. Yan, C. Zheng, Z. Li, S. Wang, and S. Cui, “Pointasnl: Robust point clouds processing using nonlocal neural networks with adaptive sampling,” in CVPR, 2020.

[62] Y. Liu, B. Fan, S. Xiang, and C. Pan, “Relation-shape convolutional neural network for point cloud analysis,” in CVPR, 2019.

[63] A. Boulch, “Generalizing discrete convolutions for unstructured point clouds,” arXiv preprint arXiv:1904.02375, 2019.

[64] Y. Liu, B. Fan, G. Meng, J. Lu, S. Xiang, and C. Pan, “DensePoint: Learning densely contextual representation for efficient point cloud processing,” in ICCV, 2019.

[65] H. Thomas, C. R. Qi, J.-E. Deschaud, B. Marcotegui, F. Goulette, and L. J. Guibas, “KPConv: Flexible and deformable convolution for point clouds,” in ICCV, 2019.

[66] A. Boulch, “ConvPoint: continuous convolutions for point cloud processing,” Computers & Graphics, 2020.

[67] W. Wu, Z. Qi, and L. Fuxin, “PointConv: Deep convolutional networks on 3D point clouds,” in CVPR, 2019.

[68] P. Hermosilla, T. Ritschel, P.-P. V´azquez, A. Vinacua, and T. Ropinski, “Monte carlo convolution for learning on non-uniformly sampled point clouds,” ACM TOG, 2018.

[69] Y. Xu, T. Fan, M. Xu, L. Zeng, and Y. Qiao, “SpiderCNN: Deep learning on point sets with parameterized convolutional filters,” in ECCV, 2018.

[70] A. Matan, M. Haggai, and L. Yaron, “Point convolutional neural networks by extension operators,” ACM TOG, 2018.

[71] C. Esteves, C. Allen-Blanchette, A. Makadia, and K. Daniilidis, “Learning so(3) equivariant representations with spherical CNNs,” in ECCV, 2017.

[72] N. Thomas, T. Smidt, S. Kearnes, L. Yang, L. Li, K. Kohlhoff, and P. Riley, “Tensor field networks: Rotation-and translation equivariant neural networks for 3D point clouds,” arXiv preprint arXiv:1802.08219, 2018.

[73] T. S. Cohen, M. Geiger, J. Koehler, and M. Welling, “Spherical CNNs,” ICLR, 2018.

[74] A. Poulenard, M.-J. Rakotosaona, Y. Ponty, and M. Ovsjanikov, “Effective rotation-invariant point CNN with spherical harmonics kernels,” in 3DV, 2019.

[75] F. Groh, P. Wieschollek, and H. P. Lensch, “Flex-Convolution,” in ACCV, 2018.

[76] B.-S. Hua, M.-K. Tran, and S.-K. Yeung, “Pointwise convolutional neural networks,” in CVPR, 2018.

[77] H. Lei, N. Akhtar, and A. Mian, “Octree guided cnn with spherical kernels for 3D point clouds,” in CVPR, 2019.

[78] S. Lan, R. Yu, G. Yu, and L. S. Davis, “Modeling local geometric structure of 3D point clouds using geo-cnn,” in CVPR, 2019.

[79] Y. Li, R. Bu, M. Sun, W. Wu, X. Di, and B. Chen, “PointCNN: Convolution on x-transformed points,” in NeurIPS, 2018.

[80] J. Mao, X. Wang, and H. Li, “Interpolated convolutional networks for 3D point cloud understanding,” in ICCV, 2019.

[81] Z. Zhang, B.-S. Hua, D. W. Rosen, and S.-K. Yeung, “Rotation invariant convolutions for 3D point clouds deep learning,” in 3DV, 2019.

[82] A. Komarichev, Z. Zhong, and J. Hua, “A-CNN: Annularly convolutional neural networks on point clouds,” in CVPR, 2019.

[83] S. Kumawat and S. Raman, “LP-3DCNN: Unveiling local phase in 3D convolutional neural networks,” in CVPR, 2019.

[84] Y. Rao, J. Lu, and J. Zhou, “Spherical fractal convolutional neural networks for point cloud recognition,” in CVPR, 2019.

[85] M. Simonovsky and N. Komodakis, “Dynamic edge-conditioned filters in convolutional neural networks on graphs,” in CVPR, 2017.

[86] R. B. Rusu and S. Cousins, “3D is here: Point cloud library (PCL),” in ICRA, 2011.

[87] Y. Wang, Y. Sun, Z. Liu, S. E. Sarma, M. M. Bronstein, and J. M. Solomon, “Dynamic graph CNN for learning on point clouds,” ACM TOG, 2019.

[88] K. Zhang, M. Hao, J. Wang, C. W. de Silva, and C. Fu, “Linked dynamic graph CNN: Learning on point cloud via linking hierarchical features,” arXiv preprint arXiv:1904.10014, 2019.

[89] Y. Yang, C. Feng, Y. Shen, and D. Tian, “FoldingNet: Point cloud auto-encoder via deep grid deformation,” in CVPR, 2018.

[90] C. Szegedy, W. Liu, Y. Jia, P. Sermanet, S. Reed, D. Anguelov, D. Erhan, V. Vanhoucke, and A. Rabinovich, “Going deeper with convolutions,” in CVPR, 2015.

[91] K. Hassani and M. Haley, “Unsupervised multi-task feature learning on point clouds,” in ICCV, 2019.

[92] J. Liu, B. Ni, C. Li, J. Yang, and Q. Tian, “Dynamic points agglomeration for hierarchical point sets learning,” in ICCV, 2019.

[93] Y. Shen, C. Feng, Y. Yang, and D. Tian, “Mining point cloud local structures by kernel correlation and graph pooling,” in CVPR, 2018.

[94] M. Dominguez, R. Dhamdhere, A. Petkar, S. Jain, S. Sah, and R. Ptucha, “General-purpose deep point cloud feature extractor,” in WACV, 2018.

[95] C. Chen, G. Li, R. Xu, T. Chen, M. Wang, and L. Lin, “ClusterNet: Deep hierarchical cluster network with rigorously rotation invariant representation for point cloud analysis,” in CVPR, 2019.

[96] D. M¨ullner, “Modern hierarchical, agglomerative clustering algorithms,” arXiv preprint arXiv:1109.2378, 2011.

[97] Q. Xu, X. Sun, C.-Y. Wu, P. Wang, and U. Neumann, “Grid-gcn for fast and scalable point cloud learning,” in CVPR, 2020.

[98] J. Bruna, W. Zaremba, A. Szlam, and Y. Lecun, “Spectral networks and locally connected networks on graphs,” ICLR, 2014.

[99] M. Defferrard, X. Bresson, and P. Vandergheynst, “Convolutional neural networks on graphs with fast localized spectral filtering,” in NeurIPS, 2016.

[100] G. Te, W. Hu, A. Zheng, and Z. Guo, “RGCNN: Regularized graph CNN for point cloud segmentation,” in ACM MM, 2018.

[101] R. Li, S. Wang, F. Zhu, and J. Huang, “Adaptive graph convolutional neural networks,” in AAAI, 2018.

[102] Y. Feng, H. You, Z. Zhang, R. Ji, and Y. Gao, “Hypergraph neural networks,” in AAAI, 2019.

[103] C. Wang, B. Samari, and K. Siddiqi, “Local spectral graph convolution for point set feature learning,” in ECCV, 2018.

[104] Y. Zhang and M. Rabbat, “A Graph-CNN for 3D point cloud classification,” in ICASSP, 2018.

[105] G. Pan, J. Wang, R. Ying, and P. Liu, “3DTI-Net: Learn inner transform invariant 3D geometry features using dynamic GCN,” arXiv preprint arXiv:1812.06254, 2018.

[106] R. Klokov and V. Lempitsky, “Escape from cells: Deep kd networks for the recognition of 3D point cloud models,” in ICCV, 2017.

[107] W. Zeng and T. Gevers, “3DContextNet: K-d tree guided hierarchical learning of point clouds using local and global contextual cues,” in ECCV, 2018.

[108] J. Li, B. M. Chen, and G. Hee Lee, “SO-Net: Self-organizing network for point cloud analysis,” in CVPR, 2018.

[109] S. Xie, S. Liu, Z. Chen, and Z. Tu, “Attentional ShapeContextNet for point cloud recognition,” in CVPR, 2018.

[110] H. You, Y. Feng, R. Ji, and Y. Gao, “PVNet: A joint convolutional network of point cloud and multi-view for 3D shape recognition,” in ACM MM, 2018.

[111] H. You, Y. Feng, X. Zhao, C. Zou, R. Ji, and Y. Gao, “PVRNet: Point-view relation neural network for 3D shape recognition,” in AAAI, 2019.

[112] Y. Zhao, T. Birdal, H. Deng, and F. Tombari, “3D point capsule networks,” in CVPR, 2019.

[113] W. Chen, X. Han, G. Li, C. Chen, J. Xing, Y. Zhao, and H. Li, “Deep RBFNet: Point cloud feature learning using radial basis functions,” arXiv preprint arXiv:1812.04302, 2018.

[114] X. Liu, Z. Han, Y.-S. Liu, and M. Zwicker, “Point2Sequence: Learning the shape representation of 3D point clouds with an attention-based sequence to sequence network,” in AAAI, 2019.

[115] P. Wu, C. Chen, J. Yi, and D. Metaxas, “Point cloud processing via recurrent set encoding,” in AAAI, 2019.

[116] C. Qin, H. You, L. Wang, C.-C. J. Kuo, and Y. Fu, “PointDAN: A multi-scale 3D domain adaption network for point cloud representation,” in NIPS, 2019.

[117] B. Sievers and J. Sauder, “Self-supervised deep learning on point clouds by reconstructing space,” in NIPS, 2019.

[118] R. Li, X. Li, P.-A. Heng, and C.-W. Fu, “PointAugment: An auto-augmentation framework for point cloud classification,” in CVPR, 2020.

[119] S. Belongie, J. Malik, and J. Puzicha, “Shape matching and object recognition using shape contexts,” IEEE TPAMI, 2002.

[120] A. Vaswani, N. Shazeer, N. Parmar, J. Uszkoreit, L. Jones, A. N. Gomez, Ł. Kaiser, and I. Polosukhin, “Attention is all you need,” in NeurIPS, 2017.

[121] D. Bobkov, S. Chen, R. Jian, Z. Iqbal, and E. Steinbach, “Noise resistant deep learning for object classification in 3D point clouds using a point pair descriptor,” IEEE RAL, 2018.

[122] S. Prokudin, C. Lassner, and J. Romero, “Efficient learning on point clouds with basis point sets,” in ICCV, 2019.

[123] L. Liu, W. Ouyang, X. Wang, P. Fieguth, J. Chen, X. Liu, and M. Pietik¨ainen, “Deep learning for generic object detection: A survey,” IJCV, 2020.

[124] C. R. Qi, O. Litany, K. He, and L. J. Guibas, “Deep hough voting for 3D object detection in point clouds,” ICCV, 2019.

[125] W. Shi and R. Rajkumar, “Point-GNN: Graph neural network for 3D object detection in a point cloud,” in CVPR, 2020.

[126] J. Ku, M. Mozifian, J. Lee, A. Harakeh, and S. L. Waslander, “Joint 3D proposal generation and object detection from view aggregation,” in IROS, 2018.

[127] M. Liang, B. Yang, S. Wang, and R. Urtasun, “Deep continuous fusion for multi-sensor 3D object detection,” in ECCV, 2018.

[128] M. Liang, B. Yang, Y. Chen, R. Hu, and R. Urtasun, “Multi-task multi-sensor fusion for 3D object detection,” in CVPR, 2019.

[129] B. Yang, W. Luo, and R. Urtasun, “PIXOR: Real-time 3D object detection from point clouds,” in CVPR, 2018.

[130] W. Luo, B. Yang, and R. Urtasun, “Fast and furious: Real time end-to-end 3D detection, tracking and motion forecasting with a single convolutional net,” in CVPR, 2018.

[131] Y. Zeng, Y. Hu, S. Liu, J. Ye, Y. Han, X. Li, and N. Sun, “RT3D: Real-time 3D vehicle detection in lidar point cloud for autonomous driving,” IEEE RAL, 2018.

[132] Z. Yang, Y. Sun, S. Liu, X. Shen, and J. Jia, “IPOD: Intensive point-based object detector for point cloud,” arXiv preprint arXiv:1812.05276, 2018.

[133] S. Shi, X. Wang, and H. Li, “PointRCNN: 3D object proposal generation and detection from point cloud,” in CVPR, 2019.

[134] Z. Jesus, G. Silvio, and G. Bernard, “PointRGCN: Graph convolution networks for 3D vehicles detection refinement,” arXiv preprint arXiv:1911.12236, 2019.

[135] V. Sourabh, L. Alex H., H. Bassam, and B. Oscar, “PointPainting: Sequential fusion for 3D object detection,” in CVPR, 2020.

[136] Y. Zhou and O. Tuzel, “VoxelNet: End-to-end learning for point cloud based 3D object detection,” in CVPR, 2018.

[137] A. H. Lang, S. Vora, H. Caesar, L. Zhou, J. Yang, and O. Beijbom, “PointPillars: Fast encoders for object detection from point clouds,” in CVPR, 2019.

[138] Z. Yang, Y. Sun, S. Liu, X. Shen, and J. Jia, “STD: Sparse-to-dense 3D object detector for point cloud,” in ICCV, 2019.

[139] C. R. Qi, W. Liu, C. Wu, H. Su, and L. J. Guibas, “Frustum PointNets for 3D object detection from RGB-D data,” in CVPR, 2018.

[140] X. Zhao, Z. Liu, R. Hu, and K. Huang, “3D object detection using scale invariant and feature reweighting networks,” in AAAI, 2019.

[141] M. Jiang, Y. Wu, and C. Lu, “PointSIFT: A sift-like network module for 3D point cloud semantic segmentation,” arXiv preprint arXiv:1807.00652, 2018.

[142] D. Xu, D. Anguelov, and A. Jain, “PointFusion: Deep sensor fusion for 3D bounding box estimation,” in CVPR, 2018.

[143] K. Shin, Y. P. Kwon, and M. Tomizuka, “RoarNet: A robust 3D object detection based on region approximation refinement,” in IEEE IV, 2019.

[144] Z. Wang and K. Jia, “Frustum convNet: Sliding frustums to aggregate local point-wise features for amodal 3D object detection,” in IROS, 2019.

[145] L. Johannes, M. Andreas, A. Thomas, H. Markus, N. Bernhard, and H. Sepp, “Patch refinement - localized 3D object detection,” arXiv preprint arXiv:1910.04093, 2019.

[146] D. Zhou, J. Fang, X. Song, C. Guan, J. Yin, Y. Dai, and R. Yang, “Iou loss for 2D/3D object detection,” in 3DV, 2019.

[147] Y. Chen, S. Liu, X. Shen, and J. Jia, “Fast point r-cnn,” in ICCV, 2019.

[148] S. Shi, C. Guo, L. Jiang, Z. Wang, J. Shi, X. Wang, and H. Li, “PV-RCNN: Point-voxel feature set abstraction for 3D object detection,” in CVPR, 2020.

[149] M. Feng, S. Z. Gilani, Y. Wang, L. Zhang, and A. Mian, “Relation graph network for 3D object detection in point clouds,” arXiv preprint arXiv:1912.00202, 2019.

[150] C. R. Qi, X. Chen, O. Litany, and L. J. Guibas, “ImVoteNet: Boosting 3D object detection in point clouds with image votes,”in CVPR, 2020.

[151] S. Shi, Z. Wang, X. Wang, and H. Li, “From points to parts: 3D object detection from point cloud with part-aware and part aggregation network,” TPAMI, 2020.

[152] B. Yang, M. Liang, and R. Urtasun, “HDNET: Exploiting hd maps for 3D object detection,” in CoRL, 2018.

[153] J. Beltr´an, C. Guindel, F. M. Moreno, D. Cruzado, F. Garc´ıa, and A. De La Escalera, “BirdNet: a 3D object detection framework from lidar information,” in ITSC, 2018.

[154] B. Li, T. Zhang, and T. Xia, “Vehicle detection from 3D lidar using fully convolutional network,” arXiv preprint arXiv:1608.07916, 2016.

[155] B. Li, “3D fully convolutional network for vehicle detection in point cloud,” in IROS, 2017.

[156] M. Engelcke, D. Rao, D. Z. Wang, C. H. Tong, and I. Posner, “Vote3Deep: Fast object detection in 3D point clouds using efficient convolutional neural networks,” in ICRA, 2017.

[157] X. Li, J. E. Guivant, N. Kwok, and Y. Xu, “3D backbone network for 3D object detection,” in CoRR, 2019.

[158] Y. Yan, Y. Mao, and B. Li, “SECOND: Sparsely embedded convolutional detection,” Sensors, 2018.

[159] V. A. Sindagi, Y. Zhou, and O. Tuzel, “MVX-Net: Multimodal voxelnet for 3D object detection,” in ICRA, 2019.

[160] C. He, H. Zeng, J. Huang, X.-S. Hua, and L. Zhang, “Structure aware single-stage 3D object detection from point cloud,” in CVPR, 2020.

[161] Z. Yang, Y. Sun, S. Liu, and J. Jia, “3DSSD: Point-based 3D single stage object detector,” in CVPR, 2020.

[162] G. P. Meyer, A. Laddha, E. Kee, C. Vallespi-Gonzalez, and C. K. Wellington, “LaserNet: An efficient probabilistic 3D object detector for autonomous driving,” CVPR, 2019.

[163] G. P. Meyer, J. Charland, D. Hegde, A. Laddha, and C. Vallespi Gonzalez, “Sensor fusion for joint 3D object detection and semantic segmentation,” CVPRW, 2019.

[164] Q. Chen, L. Sun, Z. Wang, K. Jia, and A. Yuille, “Object as hotspots: An anchor-free 3D object detection approach via firing of hotspots,” arXiv preprint arXiv:1912.12791, 2019.

[165] O. Ronneberger, P. Fischer, and T. Brox, “U-Net: Convolutional networks for biomedical image segmentation,” in MICCAI, 2015, pp. 234–241.

[166] B. Graham, M. Engelcke, and L. van der Maaten, “3D semantic segmentation with submanifold sparse convolutional networks,”in CVPR, 2018.

[167] Q. Hu, Y. Guo, Y. Chen, J. Xiao, and W. An, “Correlation filter tracking: Beyond an open-loop system,” in BMVC, 2017.

[168] H. Liu, Q. Hu, B. Li, and Y. Guo, “Robust long-term tracking via instance specific proposals,” IEEE TIM, 2019.

[169] L. Bertinetto, J. Valmadre, J. F. Henriques, A. Vedaldi, and P. H. Torr, “Fully-convolutional siamese networks for object tracking,”in ECCV, 2016.

[170] S. Giancola, J. Zarzar, and B. Ghanem, “Leveraging shape completion for 3D siamese tracking,” CVPR, 2019.

[171] M. Mueller, N. Smith, and B. Ghanem, “Context-aware correlation filter tracking,” in CVPR, 2017.

[172] J. Zarzar, S. Giancola, and B. Ghanem, “Efficient tracking proposals using 2D-3D siamese networks on lidar,” arXiv preprint arXiv:1903.10168, 2019.

[173] M. Simon, K. Amende, A. Kraus, J. Honer, T. S¨amann, H. Kaulbersch, S. Milz, and H. M. Gross, “Complexer-YOLO: Real-time 3D object detection and tracking on semantic point clouds,” CVPRW, 2019.

[174] H. Qi, C. Feng, Z. Cao, F. Zhao, and Y. Xiao, “P2B: Point-to-box network for 3D object tracking in point clouds,” in CVPR, 2020.

[175] X. Liu, C. R. Qi, and L. J. Guibas, “FlowNet3D: Learning scene flow in 3D point clouds,” in CVPR, 2019.

[176] Z. Wang, S. Li, H. Howard-Jenkins, V. Prisacariu, and M. Chen, “FlowNet3D++: Geometric losses for deep scene flow estimation,” in WACV, 2020.

[177] X. Gu, Y. Wang, C. Wu, Y. J. Lee, and P. Wang, “HPLFlowNet: Hierarchical permutohedral lattice flowNet for scene flow estimation on large-scale point clouds,” in CVPR, 2019.

[178] H. Fan and Y. Yang, “PointRNN: Point recurrent neural network for moving point cloud processing,” arXiv preprint arXiv:1910.08287, 2019.

[179] X. Liu, M. Yan, and J. Bohg, “MeteorNet: Deep learning on dynamic 3D point cloud sequences,” in ICCV, 2019.

[180] H. Mittal, B. Okorn, and D. Held, “Just go with the flow: Self-supervised scene flow estimation,” in CVPR, 2020.

[181] F. J. Lawin, M. Danelljan, P. Tosteberg, G. Bhat, F. S. Khan, and M. Felsberg, “Deep projective 3D semantic segmentation,” in CAIP, 2017.

[182] A. Boulch, B. Le Saux, and N. Audebert, “Unstructured point cloud semantic labeling using deep segmentation networks.” in 3DOR, 2017.

[183] B. Wu, A. Wan, X. Yue, and K. Keutzer, “SqueezeSeg: Convolutional neural nets with recurrent crf for real-time road-object segmentation from 3D lidar point cloud,” in ICRA, 2018.

[184] B. Wu, X. Zhou, S. Zhao, X. Yue, and K. Keutzer, “SqueezeSegV2: Improved model structure and unsupervised domain adaptation for road-object segmentation from a lidar point cloud,” in ICRA, 2019.

[185] A. Milioto, I. Vizzo, J. Behley, and C. Stachniss, “RangeNet++: Fast and accurate lidar semantic segmentation,” in IROS, 2019.

[186] H.-Y. Meng, L. Gao, Y.-K. Lai, and D. Manocha, “VV-Net: Voxel vae net with group convolutions for point cloud segmentation,” in ICCV, 2019.

[187] D. Rethage, J. Wald, J. Sturm, N. Navab, and F. Tombari, “Fully convolutional point networks for large-scale point clouds,” in ECCV, 2018.

[188] H. Su, V. Jampani, D. Sun, S. Maji, E. Kalogerakis, M.-H. Yang, and J. Kautz, “SplatNet: Sparse lattice networks for point cloud processing,” in CVPR, 2018.

[189] R. A. Rosu, P. Sch¨utt, J. Quenzel, and S. Behnke, “LatticeNet: Fast point cloud segmentation using permutohedral lattices,” arXiv preprint arXiv:1912.05905, 2019.

[190] A. Dai and M. Nießner, “3DMV: Joint 3D-multi-view prediction for 3D semantic scene segmentation,” in ECCV, 2018.

[191] M. Jaritz, J. Gu, and H. Su, “Multi-view pointNet for 3D scene understanding,” in ICCVW, 2019.

[192] N. Audebert, B. Le Saux, and S. Lef`evre, “Semantic segmentation of earth observation data using multimodal and multi-scale deep networks,” in ACCV, 2016.

[193] M. Tatarchenko, J. Park, V. Koltun, and Q.-Y. Zhou, “Tangent convolutions for dense prediction in 3D,” in CVPR, 2018.

[194] F. N. Iandola, S. Han, M. W. Moskewicz, K. Ashraf, W. J. Dally, and K. Keutzer, “SqueezeNet: Alexnet-level accuracy with 50x fewer parameters and < 0.5 MB model size,” in ICLR, 2016.

[195] J. Huang and S. You, “Point cloud labeling using 3D convolutional neural network,” in ICPR, 2016.

[196] L. Tchapmi, C. Choy, I. Armeni, J. Gwak, and S. Savarese, “SEG-Cloud: Semantic segmentation of 3D point clouds,” in 3DV, 2017.

[197] J. Long, E. Shelhamer, and T. Darrell, “Fully convolutional networks for semantic segmentation,” in CVPR, 2015.

[198] A. Dai, D. Ritchie, M. Bokeloh, S. Reed, J. Sturm, and M. Nießner, “ScanComplete: Large-scale scene completion and semantic segmentation for 3D scans,” in CVPR, 2018.

[199] C. Choy, J. Gwak, and S. Savarese, “4D spatio-temporal convnets: Minkowski convolutional neural networks,” in CVPR, 2019.

[200] H.-Y. Chiang, Y.-L. Lin, Y.-C. Liu, and W. H. Hsu, “A unified point-based framework for 3D segmentation,” in 3DV, 2019.

[201] S. Wang, S. Suo, W.-C. Ma, A. Pokrovsky, and R. Urtasun, “Deep parametric continuous convolutional neural networks,” in CVPR, 2018.

[202] X. Ye, J. Li, H. Huang, L. Du, and X. Zhang, “3D recurrent neural networks with context fusion for point cloud semantic segmentation,” in ECCV, 2018.

[203] L. Landrieu and M. Simonovsky, “Large-scale point cloud semantic segmentation with superpoint graphs,” in CVPR, 2018.

[204] F. Engelmann, T. Kontogianni, J. Schult, and B. Leibe, “Know what your neighbors do: 3D semantic segmentation of point clouds,” in ECCVW, 2018.

[205] Z. Zhang, B.-S. Hua, and S.-K. Yeung, “ShellNet: Efficient point cloud convolutional neural networks using concentric shells statistics,” in ICCV, 2019.

[206] Q. Hu, B. Yang, L. Xie, S. Rosa, Y. Guo, Z. Wang, N. Trigoni, and A. Markham, “RandLA-Net: Efficient semantic segmentation of large-scale point clouds,” CVPR, 2020.

[207] L.-Z. Chen, X.-Y. Li, D.-P. Fan, M.-M. Cheng, K. Wang, and S.-P. Lu, “LSANet: Feature learning on point sets by local spatial attention,” arXiv preprint arXiv:1905.05442, 2019.

[208] C. Zhao, W. Zhou, L. Lu, and Q. Zhao, “Pooling scores of neighboring points for improved 3D point cloud segmentation,” in ICIP, 2019.

[209] R. Arandjelovic, P. Gronat, A. Torii, T. Pajdla, and J. Sivic, “NetVLAD: CNN architecture for weakly supervised place recognition,” in CVPR, 2016.

[210] F. Engelmann, T. Kontogianni, J. Schult, and B. Leibe, “Know what your neighbors do: 3D semantic segmentation of point clouds,” in ECCV, 2018.

[211] F. Engelmann, T. Kontogianni, and B. Leibe, “Dilated point convolutions: On the receptive field of point convolutions,” in ICRA, 2020.

[212] Q. Huang, W. Wang, and U. Neumann, “Recurrent slice networks for 3D segmentation of point clouds,” in CVPR, 2018.

[213] F. Engelmann, T. Kontogianni, A. Hermans, and B. Leibe, “Exploring spatial context for 3D semantic segmentation of point clouds,” in ICCV, 2017.

[214] L. Landrieu and M. Boussaha, “Point cloud oversegmentation with graph-structured deep metric learning,” in CVPR, 2019.

[215] L. Wang, Y. Huang, Y. Hou, S. Zhang, and J. Shan, “Graph attention convolution for point cloud semantic segmentation,”in CVPR, 2019.

[216] L. Pan, C.-M. Chew, and G. H. Lee, “Pointatrousgraph: Deep hierarchical encoder-decoder with atrous convolution for point clouds,” arXiv preprint arXiv:1907.09798, 2019.

[217] Z. Liang, M. Yang, L. Deng, C. Wang, and B. Wang, “Hierarchical depthwise graph convolutional neural network for 3D semantic segmentation of point clouds,” in ICRA, 2019.

[218] L. Jiang, H. Zhao, S. Liu, X. Shen, C.-W. Fu, and J. Jia, “Hierarchical point-edge interaction network for point cloud semantic segmentation,” in ICCV, 2019.

[219] H. Lei, N. Akhtar, and A. Mian, “Spherical convolutional neural network for 3D point clouds,” arXiv preprint arXiv:1805.07872, 2018.

[220] Z. Zhao, M. Liu, and K. Ramani, “DAR-Net: Dynamic aggregation network for semantic scene segmentation,” arXiv preprint arXiv:1907.12022, 2019.

[221] F. Liu, S. Li, L. Zhang, C. Zhou, R. Ye, Y. Wang, and J. Lu, “3DCNN-DQN-RNN: A deep reinforcement learning framework for semantic parsing of large-scale 3D point clouds,” in ICCV,

2017.

[222] Z. Kang and N. Li, “PyramNet: Point cloud pyramid attention network and graph embedding module for classification and segmentation,” in ICONIP, 2019.

[223] Y. Ma, Y. Guo, H. Liu, Y. Lei, and G. Wen, “Global context reasoning for semantic segmentation of 3D point clouds,” in WACV, 2020.

[224] J. Wei, G. Lin, K.-H. Yap, T.-Y. Hung, and L. Xie, “Multi-path region mining for weakly supervised 3D semantic segmentation on point clouds,” in CVPR, 2020.

[225] X. Xu and G. H. Lee, “Weakly supervised semantic point cloud segmentation: Towards 10x fewer labels,” in CVPR, 2020, pp. 13 706–13 715.

[226] J. Hou, A. Dai, and M. Nießner, “3D-SIS: 3D semantic instance segmentation of RGB-D scans,” in CVPR, 2019.

[227] L. Yi, W. Zhao, H. Wang, M. Sung, and L. J. Guibas, “GSPN: Generative shape proposal network for 3D instance segmentation in point cloud,” in CVPR, 2019.

[228] G. Narita, T. Seno, T. Ishikawa, and Y. Kaji, “PanopticFusion: Online volumetric semantic mapping at the level of stuff and things,” in IROS, 2019.

[229] B. Yang, J. Wang, R. Clark, Q. Hu, S. Wang, A. Markham, and N. Trigoni, “Learning object bounding boxes for 3D instance segmentation on point clouds,” in NeurIPS, 2019.

[230] F. Zhang, C. Guan, J. Fang, S. Bai, R. Yang, P. Torr, and V. Prisacariu, “Instance segmentation of lidar point clouds,” in ICRA, 2020.

[231] Y. Shi, A. X. Chang, Z. Wu, M. Savva, and K. Xu, “Hierarchy denoising recursive autoencoders for 3D scene layout prediction,” in CVPR, 2019.

[232] F. Engelmann, M. Bokeloh, A. Fathi, B. Leibe, and M. Nießner, “3d-mpa: Multi-proposal aggregation for 3d semantic instance segmentation,” in CVPR, 2020.

[233] W. Wang, R. Yu, Q. Huang, and U. Neumann, “SGPN: Similarity group proposal network for 3D point cloud instance segmentation,” in CVPR, 2018.

[234] X. Wang, S. Liu, X. Shen, C. Shen, and J. Jia, “Associatively segmenting instances and semantics in point clouds,” in CVPR, 2019.

[235] Q.-H. Pham, T. Nguyen, B.-S. Hua, G. Roig, and S.-K. Yeung, “JSIS3D: Joint semantic-instance segmentation of 3D point clouds with multi-task pointwise networks and multi-value conditional

random fields,” in CVPR, 2019.

[236] C. Elich, F. Engelmann, J. Schult, T. Kontogianni, and B. Leibe, “3D-BEVIS: Birds-eye-view instance segmentation,” in GCPR, 2019.

[237] C. Liu and Y. Furukawa, “MASC: Multi-scale affinity with sparse convolution for 3D instance segmentation,” arXiv preprint arXiv:1902.04478, 2019.

[238] Z. Liang, M. Yang, and C. Wang, “3D graph embedding learning with a structure-aware loss function for point cloud semantic instance segmentation,” arXiv preprint arXiv:1902.05247, 2019.

[239] L. Han, T. Zheng, L. Xu, and L. Fang, “Occuseg: Occupancyaware 3d instance segmentation,” in CVPR, 2020.

[240] L. Jiang, H. Zhao, S. Shi, S. Liu, C.-W. Fu, and J. Jia, “PointGroup: Dual-set point grouping for 3D instance segmentation,” in CVPR, 2020.

[241] K. Mo, S. Zhu, A. X. Chang, L. Yi, S. Tripathi, L. J. Guibas, and H. Su, “PartNet: A large-scale benchmark for fine-grained and hierarchical part-level 3D object understanding,” in CVPR, 2019.

[242] L. Zhao and W. Tao, “JSNet: Joint instance and semantic segmentation of 3D point clouds,” in AAAI, 2020.

[243] B. De Brabandere, D. Neven, and L. Van Gool, “Semantic instance segmentation with a discriminative loss function,” in CVPRW, 2017.

[244] S.-M. Hu, J.-X. Cai, and Y.-K. Lai, “Semantic labeling and instance segmentation of 3D point clouds using patch context analysis and multiscale processing,” IEEE TVCG, 2018.

[245] D. Comaniciu and P. Meer, “Mean shift: A robust approach toward feature space analysis,” IEEE TPAMI, 2002.

[246] J. Lahoud, B. Ghanem, M. Pollefeys, and M. R. Oswald, “3D instance segmentation via multi-task metric learning,” in ICCV, 2019.

[247] B. Zhang and P. Wonka, “Point cloud instance segmentation using probabilistic embeddings,” arXiv preprint arXiv:1912.00145, 2019.

[248] Z. Wang and F. Lu, “VoxSegNet: Volumetric CNNs for semantic part segmentation of 3D shapes,” IEEE TVCG, 2019.

[249] E. Kalogerakis, M. Averkiou, S. Maji, and S. Chaudhuri, “3D shape segmentation with projective convolutional networks,” in CVPR, 2017.

[250] L. Yi, H. Su, X. Guo, and L. J. Guibas, “SyncSpecCNN: Synchronized spectral CNN for 3D shape segmentation,” in CVPR, 2017.

[251] P. Wang, Y. Gan, P. Shui, F. Yu, Y. Zhang, S. Chen, and Z. Sun, “3D shape segmentation via shape fully convolutional networks,”Computers & Graphics, 2018.

[252] C. Zhu, K. Xu, S. Chaudhuri, L. Yi, L. Guibas, and H. Zhang, “CoSegNet: Deep co-segmentation of 3D shapes with group consistency loss,” arXiv preprint arXiv:1903.10297, 2019.

[253] Z. Chen, K. Yin, M. Fisher, S. Chaudhuri, and H. Zhang, “BAENET: Branched autoencoder for shape co-segmentation,” in ICCV, 2019.

[254] F. Yu, K. Liu, Y. Zhang, C. Zhu, and K. Xu, “PartNet: A recursive part decomposition network for fine-grained and hierarchical shape segmentation,” in CVPR, 2019.

[255] T. Luo, K. Mo, Z. Huang, J. Xu, S. Hu, L. Wang, and H. Su, “Learning to group: A bottom-up framework for 3D part discovery in unseen categories,” in ICLR, 2020.

[256] Z. Liu, H. Tang, Y. Lin, and S. Han, “Point-Voxel CNN for efficient 3D deep learning,” in NeurIPS, 2019.