文本分类任务

- 任务简介

- 1.字符数值化

- 方式1

- 方式2

- 2.池化(pooling)

- 3.全连接层

- 4.归一化函数(Sigmoid)

- 5.总结

- 从任务抽象新的技术点

- Embedding层

- 池化层

任务简介

任务介绍: 字符串分类,根据一句话的含妈量,区分为两类,一类为正向,一类为负向

举例:

- 我的妈呀?

- 你妈妈的妈妈叫什么?

根据含有两个3妈以上,即含妈量超标,判定为负向。即1正,2负

目标: 所以我们需要建模,即建立一个f(x),将我们的含妈量语句输入后,输出1为正,输出0即为负。

1.字符数值化

释义: 我们知道,模型是进行数学运算,输入的内容一定要是数字,不能是直接的字符,所以我们先要把每个字转为字符。

方式1

问: 直观方式,我 -> 1, 你 -> 2, 他 -> 3 …. 妈 -> 26… 是否合理?

答: 问就是不合理。如果把汉字字符简单的映射为一个个的数字,那么这些数字就会存在一些明细的规律,比如:1+2 =3;那是不是意味着,我+你就等于他;这样很容易让模型找规律时,会被影响到。

方式2

方案: 将每一个字符转化为同维度的向量

例如:

我 - > [0.32618175 0.20962898 0.43550067 0.07120884 0.58215387]

你 - > [0.21841921 0.97431001 0.43676452 0.77925024 0.7307891 ]

…

他 -> [0.72847746 0.72803551 0.43888069 0.09266955 0.65148562]

详细释义:

1.我们将

每个字符随机生成一个向量,这样就避免了字符之间存在简单的加减乘除关系

2.我们将生成的向量也加入到模型的训练中,这就要求生成的维度必须相同,这样就可以使得语义相同的字:我、吾;其向量值会相近

输入:我的妈呀 --> 4x5的矩阵

这里我们输入模型的就不是简单的一个字符的数字,而是一串字符所代表的向量:

[[0.32618175 0.20962898 0.43550067 0.07120884 0.58215387]

[0.21841921 0.97431001 0.43676452 0.77925024 0.7307891 ]

[0.95035602 0.45280039 0.06675379 0.72238734 0.02466642]

[0.86751814 0.97157839 0.0127658 0.98910503 0.92606296]]

矩阵形状 = 文本长度 x 向量长度

2.池化(pooling)

问题点: 我们最后要求模型输出的是一个数字,这个数字接近1或者0来判断,语句的含妈量;但是我们看到了上面的输入,一段话输入,这个矩阵的行数我们不好控制,并且我们如何将维度降低呢?

解决方案: 所以我们首先将输入进行降维,也就是池化操作,通过池化操作将矩阵处理为向量。

示例:

操作释义:

1.我们将输入的语句转为矩阵后,我们这些向量相加,得到求和后的向量

2.我们将求和的向量的每列的数,根据相加向量的个数求平均,得到一个1*向量长度的矩阵,也就是向量。

上述过程就完成了降维,可以理解为对一句话的含义的压缩。

3.全连接层

目的: 很简单,根据第二部分,我们将矩阵转为向量,那么我们需要将向量转为数字输出,即通过我们线性层(全连接层)来处理。

方案:

1.这里我们采用最简单的线性层公式:y = wx +b

2.这里我们w的矩阵形状和前面的向量有关系,即1向量长度,b要能够和运算的结果相加,那么形状肯定也是1*向量长度。

举例:

注意:这里的x在实际中,potroch为将其转置,下图可以看到:

4.归一化函数(Sigmoid)

目的: 归一化函数也是激活函数,这里选择Sigmoid的目的,很简单,即将输出的值映射到[0,1]范围之间,我们想要的输出就是,靠近1就是正向,靠近0就是负向,它可以搬到

举例:

x = 3 归一化后值: σ(x) = 0.9526

函数图像:

5.总结

1.字符转成

向量,向量构成输入的矩阵

2.输入矩阵进行池化,得到向量

3.经过全连接层y=w*x +b得到实数

4.实数经过归一化sigmoid得到(0,1)之间的数

其中可以进行训练的为红色部分

从任务抽象新的技术点

Embedding层

释义: 上述分类任务中,将字符转化为向量的过程,我们叫Embedding。

举例: 这一层的作用很简单,就像你喊老外给你干活,用中文,他不懂;必须的先翻译成英文告诉他;embedding就相当于翻译给计算机听。

注意:

1.

embedding层一把只有深度学习任务中才有,是深度学习的一个特征

2.Embedding矩阵是可训练的参数,一般会在模型构建时随机初始化,可以使用预训练的词向量来做初始化,此时也可以选择不训练Embedding层中的参数

比如:在当前火热的大语言模型中,embedding层与模型层就是配套使用的,因为embedding加入到模型的训练中,蕴含了一定的规律在里面。

3.多个语种和符号可以放到一个词表中,也就是一个embedding层可以涵盖多种字符。

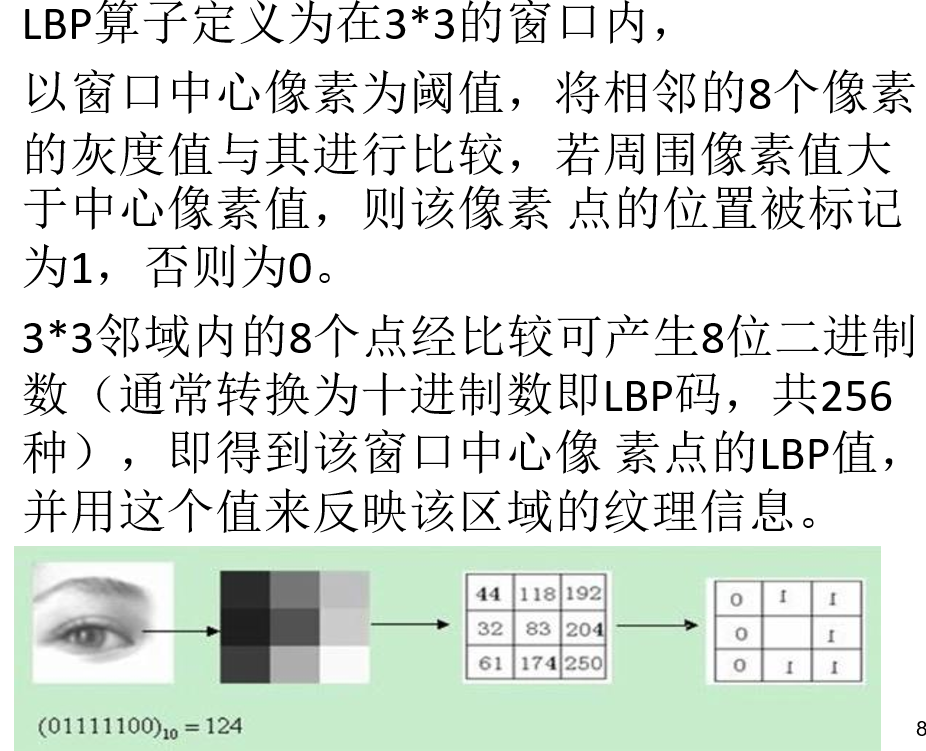

池化层

释义: 上述的分类任务中,将一句话的形成的张量,转化为一个向量的过程,就是我们说的池化。池化的目的是,降维,缩小模型,并且提取特征。

下面我们用视图领域的图像池化来做示例讲解:

过程:

上述左侧4x4的数字,是将一张图片Embedding为数字得到的

1.我们做一个2*2的正方形,将每一个正方形内最大的数字,提取为特征数字

2.全部提取完成后,即得到一个新的2x2的矩阵

好处:

- 可以

降低后续的网络层输入维度

2.减小了模型的大小,也就是参数量,因为输入的参数矩阵变小了,和其相乘的后续矩阵的维度也就变小了

3.提高了模型的计算速度,因为参数变少了

4.提高了特征的鲁棒性,防止过拟合,因为我们选取最大值,那么其他的参数只要在最大值一下,对我们整体的计算影响都会比较小;如果是平均值,同样如此

![[数仓]十二、离线数仓(Atlas元数据管理)](https://i-blog.csdnimg.cn/direct/665257d42e5e4ce4a3e00534999128f4.png)