文章目录

- 类别区分

- 变量与概念

- 逻辑回归

- Sigmoid函数

- 公式

- 决策边

- 逻辑损失函数和代价函数

- 逻辑回归的梯度下降

- 泛化

- 过拟合的解决方案

- 正则化

类别区分

变量与概念

| 决策边 | 置信度阈值threshold | 过拟合 | 欠拟合 |

|---|---|---|---|

| 正则化 | 高偏差 | lambda(λ) | |

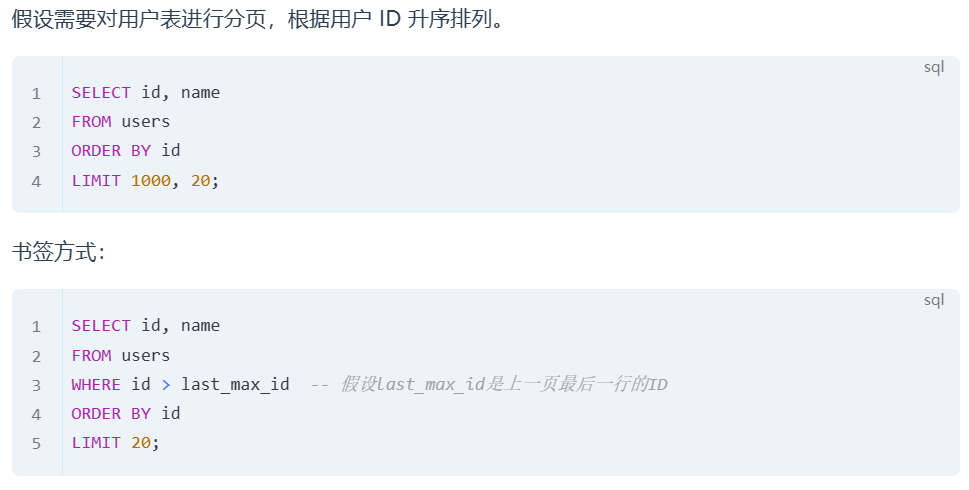

线性回归受个别极端值影响,不适合用于分类

逻辑回归

-

输出值介于(0,1)

-

解决输出标签,判断真值

-

用于回归和分类

Sigmoid函数

图注:z越大,函数g(z)值越趋近于1;z为负数,越小则函数g(z)值越趋近于零。

公式

f w ⃗ , b = g ( w ⃗ ∗ x ⃗ + b ) = 1 1 + e − ( w ⃗ ∗ x ⃗ + b ) f_{\vec{w},b}=g(\vec{w}*\vec{x}+b)=\dfrac{1}{1+e^{-(\vec{w}*\vec{x}+b)}} fw,b=g(w∗x+b)=1+e−(w∗x+b)1

P ( y = 0 ) + P ( y = 1 ) = 1 P(y=0)+P(y=1)=1 P(y=0)+P(y=1)=1

一般写法: f w ⃗ , b ( x ⃗ ) = P ( y = 1 ∣ x ⃗ ; w ⃗ , b ⃗ ) f_{\vec{w},b}(\vec x)=P(y=1|\vec x;\vec w,\vec b) fw,b(x)=P(y=1∣x;w,b)

含义:w,b为影响因子的时候,选中x行向量时,y=1的概率是多少。

决策边

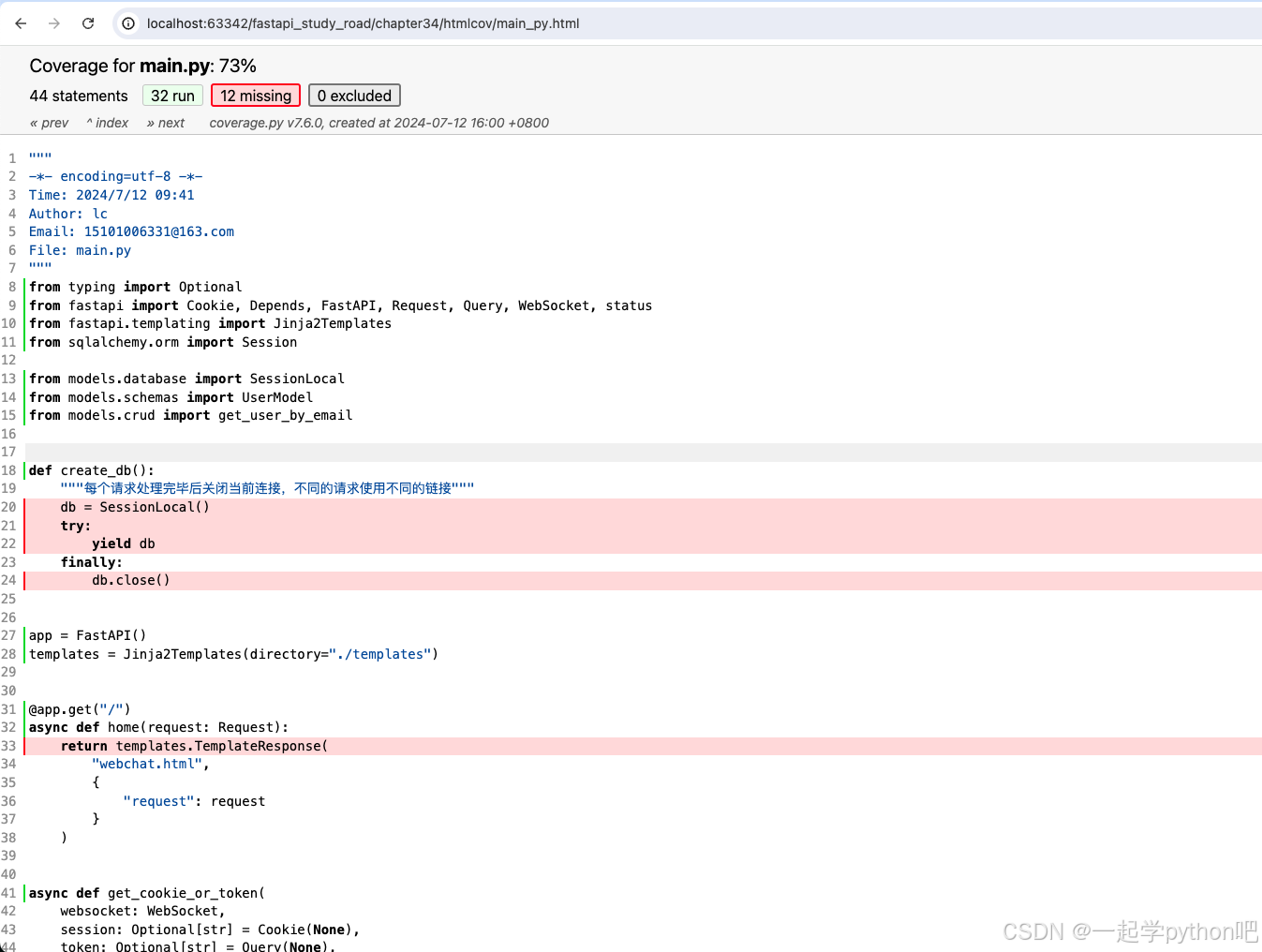

逻辑损失函数和代价函数

L ( f w ⃗ , b ( x ⃗ ( i ) ) , y ( i ) ) = − y ( i ) l o g ( f w ⃗ , b ( x ( i ) ) ) − ( 1 − y ( i ) ) l o g ( 1 − f w ⃗ , b ( x ⃗ ( i ) ) ) L(f_{\vec w,b}(\vec x^{(i)}),y^{(i)})=-y^{(i)}log(f_{\vec w,b}(x^{(i)}))-(1-y^{(i)})log(1-f_{\vec w,b}(\vec x^{(i)})) L(fw,b(x(i)),y(i))=−y(i)log(fw,b(x(i)))−(1−y(i))log(1−fw,b(x(i)))

分取值写,则如下图:

负的log函数取零到一的部分。如上图。

平方误差代价函数不适用原因:会出现多个局部最小值。

简化的代价函数为

J

(

w

⃗

,

b

)

=

−

1

m

∑

i

=

1

m

[

L

(

f

w

⃗

,

b

(

x

⃗

(

i

)

)

,

y

(

i

)

]

J(\vec w, b)=-\dfrac{1}{m}\sum\limits_{i=1}^m[L(f_{\vec w,b}(\vec x^{(i)}),y^{(i)}]

J(w,b)=−m1i=1∑m[L(fw,b(x(i)),y(i)]

它由极大似然估计法推出。

凸函数原因:凸优化学习

逻辑回归的梯度下降

重复地更新w和b,令其值为旧值-(学习率 α ∗ α * α∗ 偏导数项)

泛化

若一个模型能从从未见过的数据中做出准确的预测,我们说它能够从训练集泛化到测试集。我们的目标是构建一个泛化精度尽可能高的模型

一个模型不能太过特殊以至于只能用于一些数据,也不能过于宽泛难以拟合数据。

过拟合的解决方案

- 收集更多数据,但数据收集能力可能有上限。

- 观察是否可以用更少特征,应选用最相关特征,但有些被忽略的特征可能实际上有用。有些算法可以自动选择合适的特征。

- 正则化,w1到wn可以缩小以适应训练集,不推荐缩小b

正则化

一种惩罚,如果某一个w的增大使代价函数J增大,那它实际应该减小。

J ( w ⃗ , b ) = 1 2 m [ ∑ i = 1 m ( f w ⃗ , b ( x ⃗ ( i ) ) − y ( i ) ) 2 + λ 2 m ∑ j = 1 n w j 2 + λ 2 m b 2 ] ( λ > 0 ) J(\vec w, b)=\dfrac{1}{2m}[\sum\limits_{i=1}^m(f_{\vec w, b}(\vec x^{(i)})-y^{(i)})^2+\dfrac{λ}{2m}\sum\limits_{j=1}^nw_j^2+\dfrac{λ}{2m}b^2](λ>0) J(w,b)=2m1[i=1∑m(fw,b(x(i))−y(i))2+2mλj=1∑nwj2+2mλb2](λ>0)

选择合适的λ以避免过拟合和欠拟合。

![【web]-sql注入-bestdb](https://i-blog.csdnimg.cn/direct/97a8f63843074333ae0e3488126f4cd6.png)