1.粒子群算法的概念

PSO是粒子群优化算法(Particle Swarm Optimization)的英文缩写,是一种基于种群的随机优化技术,由Eberhart和Kennedy于1995年提出。粒子群算法是模仿昆虫、兽群、鸟群和鱼群等的群集行为,这些群体按照一种合作的方法寻找食物,群体中的每个成员通过学习它自身的经验和其他成员的经验来不断的改变其搜索方式。PSO由于操作简单、收敛速度快、并没有许多参数的调节,因此,被广泛应用于函数优化、神经网络训练、模糊系统控制以及其他遗传算法的应用领域。

2.粒子群算法的原理

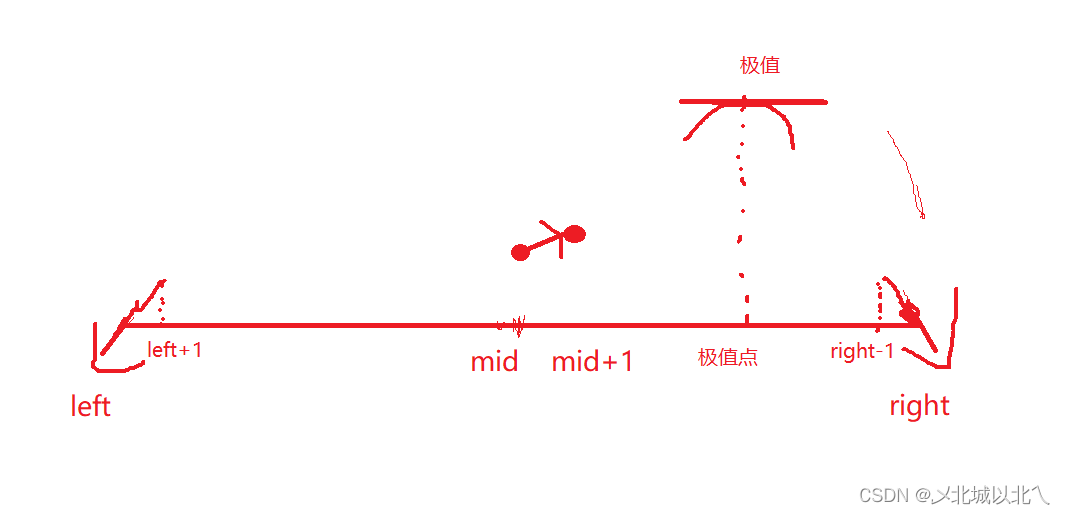

粒子群优化算法的基本思想是通过群体中个体之间的协作和信息共享来寻找最优解。用一种粒子模拟种群个体,每个粒子可视为N维搜索空间中的一个搜索个体,粒子的当前位置即为对应优化问题的一个候选解,粒子的飞行过程即为该个体的搜索过程。粒子的飞行速度可根据粒子历史最优位置和种群历史最优位置进行动态调整。粒子仅有两个属性:速度和位置,速度代表移动的快慢,位置代表移动的方向。每个粒子单独搜寻的最优解叫做个体极值,粒子群中的最优个体极值作为当前全局的最优解。不断迭代,更新速度和位置。最终得到满足条件的最优解。流程如下:

PSO算法的步骤为:

(1)初始化所有粒子,即给它们的速度和位置赋值,并将个体的历史最优pBest设为当前位置,群体中的最优个体作为当前的gBest。

(2)在每一代的进化中,计算各个粒子的适应度函数值。

(3)如果当前适应度函数值优于历史最优值,则更新pBest。

(4)如果当前适应度函数值优于全局历史最优值,则更新gBest。

(5)对每个粒子i的第d维的速度和位置分别按照如下公式进行更新。其中w为惯量权重,一般初始化为0.9,随着进化过程线性递减到0.4;c1和c2是加速系数,传统上取固定值2.0;rand1和rand2是两个[0,1]区间上的随机数。

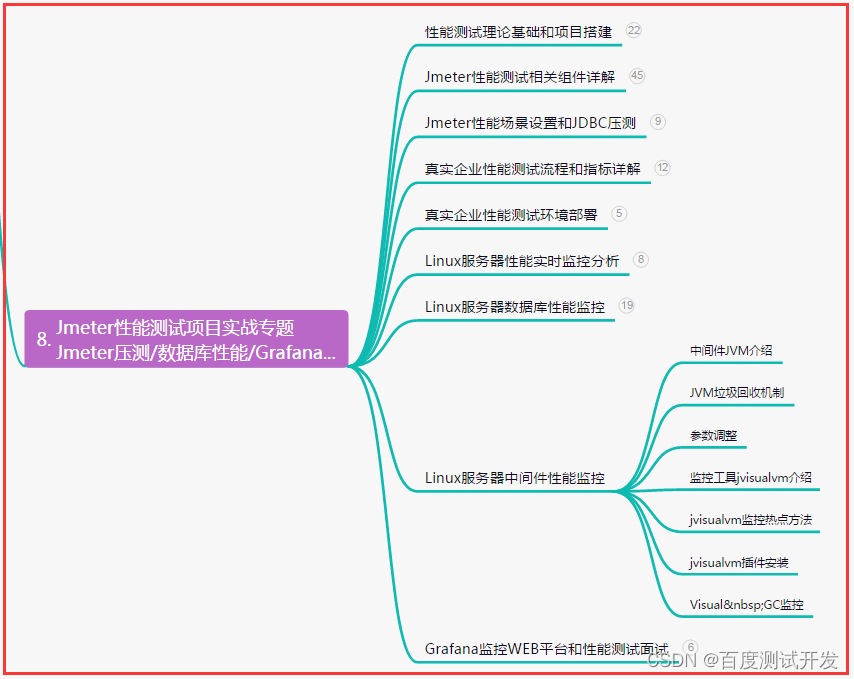

3.基于PSO-SVM对葡萄酒数据集进行分类

上面我们对粒子群算法PSO进行了原理介绍,接下来,我们将对SKlearn自带葡萄酒数据集进行分类,采用的分类算法为支持向量机(Support Vector Machine,SVM),通过PSO优化SVM的重要超参数c和g,寻找使模型效果最好的超参数c和g。从随机解出发,通过迭代寻找最优解,通过适应度来评价解的质量。PSO初始化为一群随机粒子,然后通过迭代找到最优解。所有的粒子具有位置(particle_position_vector)和速度(velocity_vector)两个属性。在每一次迭代中,粒子通过粒子本身所找到的最优解pbest和整个种群目前找到的最优解全局极值gbest来更新。接下来,我们直接上代码,查看整个过程。

第一步:导入相应的宝并查看葡萄酒数据集合

# 导入相应的包

import pandas as pd

import numpy as np

import random

from sklearn.svm import SVC

import matplotlib.pyplot as plt

from sklearn.model_selection import cross_val_predict

from sklearn.metrics import confusion_matrix

from sklearn.preprocessing import StandardScaler

from sklearn.model_selection import cross_val_score

from sklearn.datasets import load_iris,load_wine

# 读取训练数据

x,y = load_wine(return_X_y=True)

x,Y = pd.DataFrame(x),pd.DataFrame(y)

x.shape,Y.shape

第二步,标准化或者归一化数据集,加快收敛,提升分类精度。

# 标准化

scaler = StandardScaler()

X = scaler.fit_transform(x)

第三步,初始化模型参数。

W = 0.5 # 惯性因子

c1 = 0.2 # 学习因子

c2 = 0.5 # 学习因子

n_iterations = 10 # 迭代次数

n_particles = 80 # 种群规模

第四步,设置适应度值,输出分类精度,并返回混淆矩阵错误结果分类情况。

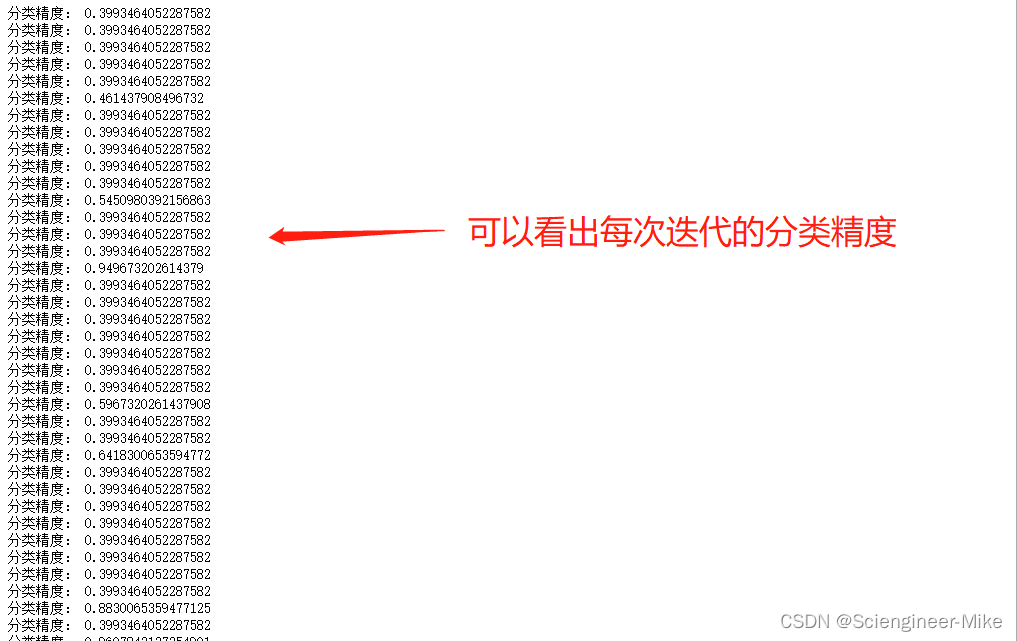

def fitness_function(position):

svclassifier = SVC(kernel='rbf',gamma=position[0],C=position[1])

# 参数gamma和惩罚参数C以实数向量的形式进行编码作为pso粒子的位置

svclassifier.fit(X,y)

score = cross_val_score(svclassifier,X,y,cv=10).mean()# 交叉验证的精度

print("分类精度:",score)

Y_pred = cross_val_predict(svclassifier,X,y,cv=10)

return confusion_matrix(Y, Y_pred)[0][1] + confusion_matrix(Y, Y_pred)[0][2] + confusion_matrix(Y, Y_pred)[1][0] + \

confusion_matrix(Y, Y_pred)[1][2] + confusion_matrix(Y, Y_pred)[2][0] + confusion_matrix(Y, Y_pred)[2][1]\

, confusion_matrix(Y, Y_pred)[0][1] + confusion_matrix(Y, Y_pred)[0][2] + confusion_matrix(Y, Y_pred)[1][0] + \

confusion_matrix(Y, Y_pred)[1][2] + confusion_matrix(Y, Y_pred)[2][0] + confusion_matrix(Y, Y_pred)[2][1]

第五步,初始化粒子位置(particle_position_vector)和粒子速度(velocity_vector)

# 粒子位置向量

particle_position_vector = np.array([np.array([random.random() * 10, random.random() * 10]) for _ in range(n_particles)])

pbest_position = particle_position_vector #个体极值等于最初位置

pbest_fitness_value = np.array([float('inf') for _ in range(n_particles)]) #个体极值的适应度值

gbest_fitness_value = np.array([float('inf'), float('inf')]) #全局极值的适应度值

gbest_position = np.array([float('inf'), float('inf')])

velocity_vector = ([np.array([0, 0]) for _ in range(n_particles)]) # 粒子速度

第六步,开始迭代

iteration = 0

while iteration < n_iterations:

# plot(particle_position_vector) # 粒子具体位置

for i in range(n_particles): # 对每个粒子进行循环

fitness_cadidate = fitness_function(particle_position_vector[i]) # 每个粒子的适应度值=适应度函数(每个粒子的具体位置)

# print("粒子误差", i, "is (training, test)", fitness_cadidate, " At (gamma, c): ",

# particle_position_vector[i])

if (pbest_fitness_value[i] > fitness_cadidate[1]): # 每个粒子的适应度值与其个体极值的适应度值(pbest_fitness_value)作比较,如果更优的话,则更新个体极值,

pbest_fitness_value[i] = fitness_cadidate[1]

pbest_position[i] = particle_position_vector[i]

if (gbest_fitness_value[1] > fitness_cadidate[1]): # 更新后的每个粒子的个体极值与全局极值(gbest_fitness_value)比较,如果更优的话,则更新全局极值

gbest_fitness_value = fitness_cadidate

gbest_position = particle_position_vector[i]

elif (gbest_fitness_value[1] == fitness_cadidate[1] and gbest_fitness_value[0] > fitness_cadidate[0]):

gbest_fitness_value = fitness_cadidate

gbest_position = particle_position_vector[i]

for i in range(n_particles): # 更新速度和位置,更新新的粒子的具体位置

new_velocity = (W * velocity_vector[i]) + (c1 * random.random()) * (

pbest_position[i] - particle_position_vector[i]) + (c2 * random.random()) * (

gbest_position - particle_position_vector[i])

new_position = new_velocity + particle_position_vector[i]

particle_position_vector[i] = new_position

iteration = iteration + 1

第七步,输出最终的分类结果

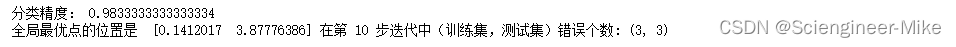

print("全局最优点的位置是 ", gbest_position, "在第", iteration, "步迭代中(训练集,测试集)错误个数:", fitness_function(gbest_position))

第八步,我们将PSO得到的最优参数组合带入SVM,进行验证,如下:

# 进行验证

svclassifier_ = SVC(kernel='rbf',gamma=0.1412017,C=3.87776386)

svclassifier_.fit(X,y)

score = cross_val_score(svclassifier_,X,y,cv=10).mean()

print("验证后的结果为:",score)

至此,我们完成了通过PSO优化SVM算法,提升其在葡萄酒数据集上的分类效果。

4.总结

本篇,介绍了PSO优化算法的原理与迭代步骤,并采用PSO粒子群优化算法寻找支持向量机SVM算法的最佳参数进行分类,并取得了很好的模型效果,供大家参考学习。

![[NRF52] mesh DFU](https://img-blog.csdnimg.cn/89b82b0fad3a4c948cb43c68737ac313.png)