1、概述

在前面已经提到,容器的生命周期可能很短,会被频繁地创建和销毁。那么容器在销毁时,保存在容器中的数据也会被清除。这种结果对用户来说,在某些情况下是不乐意看到的。为了持久化保存容器的数据,kubernetes引入了Volume的概念。

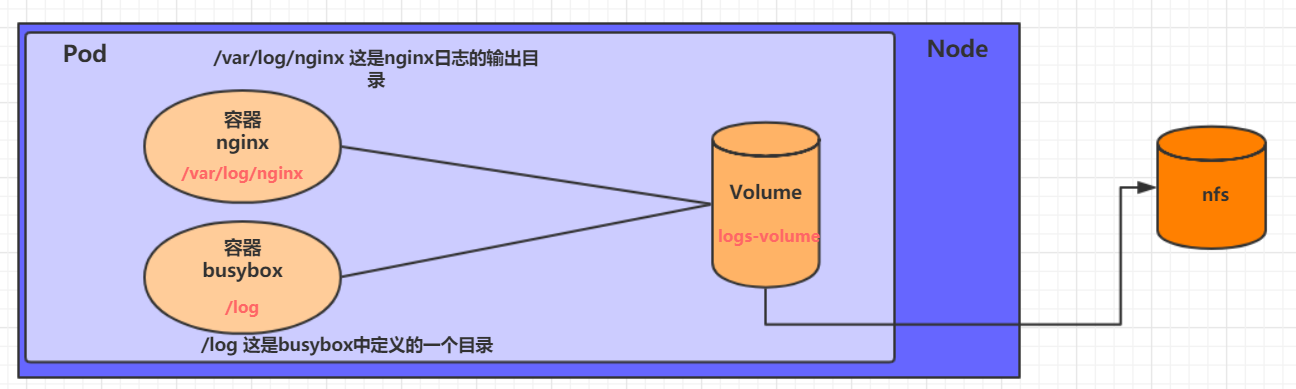

Volume是Pod中能够被多个容器访问的共享目录,它被定义在Pod上,然后被一个Pod里的多个容器挂载到具体的文件目录下,kubernetes通过Volume实现同一个Pod中不同容器之间的数据共享以及数据的持久化存储。Volume的生命容器不与Pod中单个容器的生命周期相关,当容器终止或者重启时,Volume中的数据也不会丢失。

kubernetes的Volume支持多种类型,比较常见的有下面几个:

基本存储:EmptyDir、HostPath、NFS

高级存储:PV、PVC

配置存储:ConfigMap、Secret

在上篇文章中,我们讲解了EmptyDir、HostPath是什么,怎么用,这篇文章我们继续讲解NFS

2、NFS

HostPath可以解决数据持久化的问题,但是一旦Node节点故障了,Pod如果转移到了别的节点,又会出现问题了,此时需要准备单独的网络存储系统,比较常用的用NFS、CIFS。

NFS是一个网络文件存储系统,可以搭建一台NFS服务器,然后将Pod中的存储直接连接到NFS系统上,这样的话,无论Pod在节点上怎么转移,只要Node跟NFS的对接没问题,数据就可以成功访问。

2.1、首先要准备nfs的服务器,这里为了简单,直接是master节点做nfs服务器

# 在master上安装nfs

[root@k8s-master ~]# yum install nfs-utils -y

#准备一个共享目录

[root@k8s-master ~]# mkdir /root/data/nfs -pv

mkdir: 已创建目录 "/root/data"

mkdir: 已创建目录 "/root/data/nfs"

# 查看所有节点IP

[root@k8s-master ~]# kubectl get nodes -owide

NAME STATUS ROLES AGE VERSION INTERNAL-IP EXTERNAL-IP OS-IMAGE KERNEL-VERSION CONTAINER-RUNTIME

k8s-master Ready control-plane 18d v1.25.0 192.168.8.120 <none> CentOS Linux 7 (Core) 3.10.0-1160.76.1.el7.x86_64 docker://20.10.22

k8s-node1 Ready <none> 18d v1.25.0 192.168.8.125 <none> AlmaLinux 8.6 (Sky Tiger) 4.18.0-372.9.1.el8.x86_64 docker://20.10.22

k8s-node2 Ready <none> 18d v1.25.0 192.168.13.63 <none> Oracle Linux Server 7.9 5.4.17-2102.201.3.el7uek.x86_64 docker://20.10.22

# 将共享目录以读写权限暴露给所有非master k8s节点

[root@nfs ~]# vim /etc/exports

# 我本地只有两个非master节点

[root@nfs ~]# more /etc/exports

/root/data/nfs 192.168.13.63(rw,no_root_squash)

/root/data/nfs 192.168.8.125(rw,no_root_squash)

# 启动nfs服务

[root@k8s-master ~]# systemctl restart nfs

# 注意如果此处报 Failed to start nfs.service: Unit nfs.service not found. 则更改以下下命令

[root@k8s-master ~]# systemctl start nfs-server

2.2、在的每个node节点上都安装下nfs,这样的目的是为了node节点可以驱动nfs设备

# 在node上安装nfs服务,注意不需要启动

[root@k8s-node2 ~]# yum install nfs-utils -y

[root@k8s-node1 ~]# yum install nfs-utils -y2.3、编写pod的配置文件了,创建volume-nfs.yaml

apiVersion: v1

kind: Pod

metadata:

name: volume-nfs

namespace: dev

spec:

containers:

- name: nginx

image: nginx

ports:

- containerPort: 80

volumeMounts:

- name: logs-volume

mountPath: /var/log/nginx

- name: busybox

image: busybox:1.30

command: ["/bin/sh","-c","tail -f /logs/access.log"]

volumeMounts:

- name: logs-volume

mountPath: /logs

volumes:

- name: logs-volume

nfs:

server: 192.168.8.120 #nfs服务器地址

path: /root/data/nfs #共享文件路径2.4、运行下pod,观察结果

# 创建

[root@k8s-master ~]# kubectl apply -f volume-nfs.yaml

pod/volume-nfs created

# 查看pod详情 发现pod运行在k8s-node2 节点上

[root@k8s-master ~]# kubectl get pod -n dev -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

volume-nfs 2/2 Running 0 45s 172.17.169.172 k8s-node2 <none> <none>

[root@k8s-master ~]#

# 访问nginx

[root@k8s-master ~]# curl 172.17.169.172

<!DOCTYPE html>

<html>

<head>

<title>Welcome to nginx!</title>

<style>

html { color-scheme: light dark; }

body { width: 35em; margin: 0 auto;

font-family: Tahoma, Verdana, Arial, sans-serif; }

</style>

</head>

<body>

<h1>Welcome to nginx!</h1>

<p>If you see this page, the nginx web server is successfully installed and

working. Further configuration is required.</p>

<p>For online documentation and support please refer to

<a href="http://nginx.org/">nginx.org</a>.<br/>

Commercial support is available at

<a href="http://nginx.com/">nginx.com</a>.</p>

<p><em>Thank you for using nginx.</em></p>

</body>

</html>

# 通过kubectl logs 查看日志

[root@k8s-master ~]# kubectl logs -f volume-nfs -n dev -c busybox

192.168.13.63 - - [07/Jan/2023:03:31:07 +0000] "GET / HTTP/1.1" 200 615 "-" "curl/7.29.0" "-"

# 查看日志已持久化在master节点的 nfs共享目录上, pod运行在k8s-node2 节点上 但是数据却存储在master节点上

[root@k8s-master ~]# cd /root/data/nfs/

[root@k8s-master nfs]# ls

access.log error.log

本篇文章先到此处,下一篇我们继续讲解高级存储