在人工智能的浩瀚星空中,大型语言模型(Large Language Model, LLM)无疑是近年来最为耀眼的星辰之一。它们以惊人的文本生成能力、上下文理解能力以及广泛的应用潜力,正逐步改变着我们的生活方式和工作模式。对于想要踏入这一领域的探索者来说,“手撕LLM”——即深入剖析并理解其基本原理与关键技术,无疑是通往大模型世界的一把钥匙。以下,我们将一起揭开LLM的神秘面纱,为你的大模型之旅奠定基础。

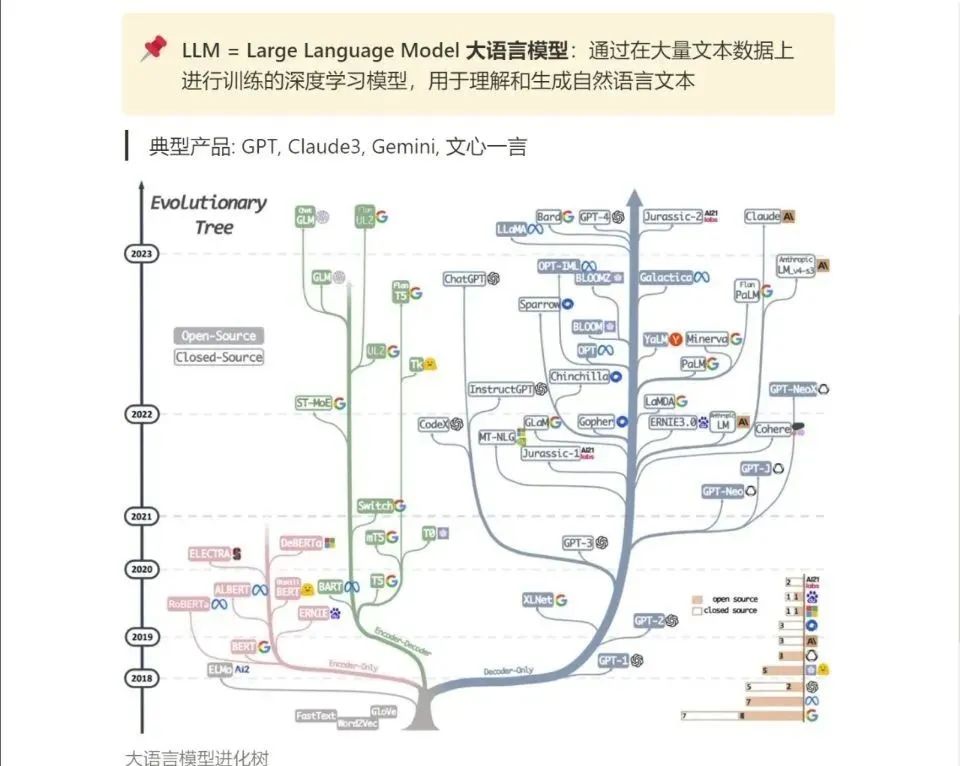

一、LLM的前世今生

要理解LLM,首先得从其发展历程说起。从早期的RNN(循环神经网络)到LSTM(长短期记忆网络),再到Transformer模型的横空出世,每一次技术革新都极大地推动了自然语言处理(NLP)的进步。而LLM,作为Transformer架构的集大成者,通过在海量的文本数据上进行预训练,学会了丰富的语言知识和世界知识,从而能够执行包括文本生成、问答、翻译在内的多种任务。

二、Transformer与LLM的核心

Transformer模型是LLM的基石。它摒弃了传统的循环或递归结构,采用自注意力(Self-Attention)机制,让模型能够同时处理序列中的每个元素,并捕捉它们之间的依赖关系。这种设计不仅提高了模型的并行处理能力,还显著增强了其在长距离依赖捕捉上的能力。

在LLM中,Transformer通常被用作编码器-解码器(Encoder-Decoder)架构。编码器负责将输入文本转换为一系列高维向量表示(即嵌入),而解码器则根据这些向量生成输出文本。通过在大规模语料库上进行预训练,LLM学会了丰富的语言模式和知识,为后续的任务迁移提供了坚实的基础。

三、预训练与微调的艺术

LLM的成功离不开两个关键步骤:预训练和微调。

- 预训练:在这一阶段,LLM会在一个或多个大规模文本数据集上进行无监督学习,目标是学习通用的语言表示。常见的预训练任务包括语言建模(Language Modeling)、遮蔽语言模型(Masked Language Modeling, MLM)和下一句预测(Next Sentence Prediction, NSP)等。这些任务帮助LLM掌握了丰富的语言知识和上下文理解能力。

- 微调:在预训练完成后,LLM会根据特定任务的需求进行微调。这通常涉及在一个较小的、标注过的数据集上重新训练模型,以优化其在该任务上的性能。微调使得LLM能够快速适应各种下游任务,如文本分类、情感分析、问答系统等。

四、LLM的应用与挑战

LLM的广泛应用是其备受瞩目的重要原因。从智能客服、内容创作到代码编写、科学发现,LLM正逐步渗透到我们生活的方方面面。然而,随着应用的深入,一系列挑战也随之而来:

- 可解释性:LLM的决策过程往往难以被人类理解,这限制了其在某些需要高度透明度的领域的应用。

- 偏见与误导:由于训练数据的不完整或偏见,LLM可能会生成不准确或带有偏见的输出。

- 计算与资源:LLM的训练和推理过程需要巨大的计算资源和时间成本,这使得其难以在资源受限的环境中广泛应用。

五、结语

手撕LLM,不仅是对其技术细节的深入剖析,更是对人工智能未来可能性的深刻思考。通过理解LLM的基本原理、关键技术、应用与挑战,我们不仅能够掌握这一领域的入门知识,还能为未来的创新与发展奠定坚实的基础。在这个过程中,让我们保持好奇心与探索精神,共同见证人工智能的无限可能。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

资源分享

大模型AGI学习包

资料目录

- 成长路线图&学习规划

- 配套视频教程

- 实战LLM

- 人工智能比赛资料

- AI人工智能必读书单

- 面试题合集

《人工智能\大模型入门学习大礼包》,可以扫描下方二维码免费领取!

1.成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图&学习规划。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

2.视频教程

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,其中一共有21个章节,每个章节都是当前板块的精华浓缩。

3.LLM

大家最喜欢也是最关心的LLM(大语言模型)

《人工智能\大模型入门学习大礼包》,可以扫描下方二维码免费领取!