Transformers 介绍和详细说明

一、引言

Transformers是一种基于注意力机制的深度学习模型架构,由谷歌团队在2017年的论文《Attention is All You Need》中首次提出。这一模型架构在自然语言处理(NLP)领域取得了显著成就,并迅速扩展到计算机视觉、语音处理等其他领域。Transformers以其独特的编码器-解码器结构、多头注意力机制以及位置编码等特性,解决了传统循环神经网络(RNN)和卷积神经网络(CNN)在处理长距离依赖和并行计算方面的不足。

二、Transformers模型架构

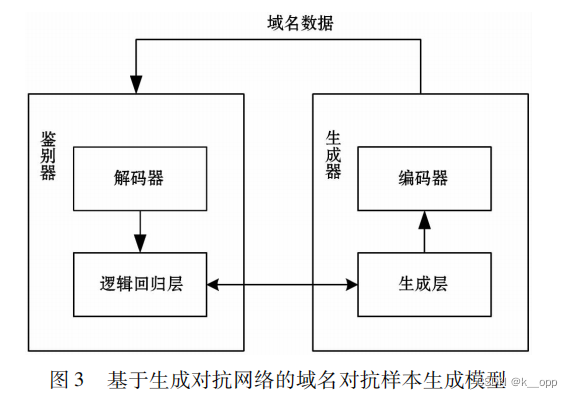

1. 编码器-解码器结构

Transformers模型主要由编码器(Encoder)和解码器(Decoder)两部分组成。这种结构最初来源于Seq2Seq模型,但Transformers摒弃了RNN或CNN等传统结构,完全依赖注意力机制来处理输入和输出序列。

-

编码器:负责将输入序列转换为一系列隐藏状态(或称为上下文表示)。编码器由多个编码器层堆叠而成,每个编码器层包含两个主要子层:多头自注意力机制(Multi-Head Self-Attention)和全连接前馈网络(Feed Forward Neural Network)。此外,每个子层周围都采用了残差连接(Residual Connection)和层归一化(Layer Normalization)以提高模型训练的稳定性和效率。

-

解码器:负责根据编码器的输出和已生成的序列部分来预测下一个输出序列的元素。解码器同样由多个解码器层堆叠而成,但除了包含与编码器相同的两个主要子层外,还额外引入了一个编码器-解码器注意力机制(Encoder-Decoder Attention),用于融合编码器的输出信息。

2. 多头自注意力机制

多头自注意力机制是Transformers模型的核心组件之一,它通过并行计算多个自注意力子层来捕捉输入序列中不同位置之间的依赖关系。自注意力机制允许模型在处理某个位置时,能够关注到序列中的其他所有位置,从而有效地建模长距离依赖。

-

自注意力机制:给定一个输入序列,首先通过线性变换得到查询(Query)、键(Key)和值(Value)三个矩阵。然后,计算查询与键的点积,经过缩放后应用softmax函数得到注意力权重,最后将这些权重与值矩阵相乘得到加权和作为输出。

-

多头机制:为了允许模型同时关注输入序列的不同子空间,多头自注意力机制将自注意力过程并行执行多次(通常为8次或更多),每次使用不同的线性变换矩阵来生成查询、键和值。然后将所有头的输出拼接起来,并通过另一个线性变换得到最终的输出。

3. 位置编码

由于自注意力机制本身无法获取序列中元素的位置信息,Transformers在输入时加入了位置编码(Positional Encoding)来弥补这一缺陷。位置编码可以是固定的(如正弦和余弦函数生成的),也可以是可学习的。这些位置编码与输入序列的嵌入表示相加,以提供位置信息给模型。

三、Transformers的应用与变体

1. BERT(Bidirectional Encoder Representations from Transformers)

BERT是Transformers的一个重要变体,它利用Transformers的编码器部分构建了一个深度双向表示模型。BERT通过两个预训练任务——掩码语言模型(Masked Language Model, MLM)和下一句预测(Next Sentence Prediction, NSP)——来学习语言的通用表示。在预训练阶段,BERT使用大量未标记的文本数据来学习这些表示,然后在下游任务(如文本分类、命名实体识别等)中通过微调来适应特定任务。

2. GPT(Generative Pre-trained Transformer)

GPT系列模型则是基于Transformers的解码器部分构建的生成式预训练模型。GPT-3是其中的代表性作品,它拥有惊人的1750亿个参数,能够生成高度连贯和流畅的文本。GPT模型通过自回归的方式进行预训练,即在给定前面文本的情况下预测下一个词。这种预训练方式使得GPT模型能够自然地应用到各种生成式任务中,如文本生成、对话系统等。

3. 其他变体

除了BERT和GPT系列外,还有许多基于Transformers的变体模型被提出和应用。例如,RoBERTa对BERT的预训练过程进行了优化;T5(Text-To-Text Transfer Transformer)将所有NLP任务视为文本到文本的转换问题;BART(Denoising Autoencoder for Sequential-to-Sequential Learning)则是一种用于序列到序列任务的去噪自编码器模型等。

四、Transformers的优势与挑战(续)

1. 优势(续)

-

灵活性高:Transformers模型架构的灵活性使得它可以轻松适应各种NLP任务,包括但不限于文本分类、命名实体识别、机器翻译、文本摘要、问答系统等。通过微调预训练的模型,可以快速地在新任务上取得良好的效果。

-

可解释性增强:虽然深度学习模型通常被视为“黑盒”,但Transformers中的注意力机制提供了一种可视化工具,可以观察到模型在处理输入序列时关注的重点区域。这有助于我们理解模型的行为和决策过程,从而增强模型的可解释性。

-

跨领域应用广泛:除了NLP领域外,Transformers模型还被成功应用于计算机视觉、语音处理、推荐系统等其他领域。这得益于其强大的表示学习能力和灵活的架构设计。

2. 挑战

-

计算资源要求高:Transformers模型,特别是像GPT-3这样的大型模型,需要巨大的计算资源和存储空间来进行训练和推理。这使得许多小型机构和个人难以负担得起。

-

过拟合风险:由于模型参数众多,Transformers在训练过程中容易发生过拟合现象。特别是在数据量有限的情况下,模型可能会过度拟合训练数据,导致在测试集上的性能下降。

-

可解释性有限:虽然注意力机制提供了一定程度的可解释性,但整个模型的行为仍然是一个复杂的黑盒系统。这限制了我们对模型决策过程的深入理解和优化。

-

训练稳定性问题:由于梯度消失或梯度爆炸等问题,Transformers在训练过程中可能会遇到稳定性问题。这要求我们在训练过程中采用适当的优化算法和正则化技术来确保模型的稳定性和泛化能力。

五、Transformers的未来发展方向

-

更高效的模型架构:为了降低计算资源要求和提高训练效率,研究人员正在探索更高效的Transformers模型架构。例如,通过减少模型参数数量、优化注意力机制或引入新的稀疏化技术等手段来减少计算量。

-

多模态学习:随着技术的不断发展,Transformers模型正在逐步向多模态学习领域扩展。通过将文本、图像、音频等多种模态的数据融合在一起进行训练和学习,可以构建出更加全面和智能的模型。这有助于解决更加复杂的跨模态任务,如图像描述生成、视频理解等。

-

可解释性和鲁棒性增强:为了提高Transformers模型的可解释性和鲁棒性,研究人员正在探索新的方法和工具来分析和理解模型的行为和决策过程。例如,通过引入注意力机制的变体、可视化工具或可解释性正则化技术来增强模型的可解释性;通过数据增强、对抗训练或鲁棒性优化等技术来提高模型的鲁棒性和泛化能力。

-

模型压缩和部署:为了将Transformers模型应用于实际场景中,模型压缩和部署技术变得尤为重要。研究人员正在探索各种压缩算法和量化技术来减小模型大小和降低推理延迟;同时也在研究如何将模型部署到不同的硬件平台上(如CPU、GPU、FPGA等)以实现高效的推理和部署。

六、结论

Transformers作为一种基于注意力机制的深度学习模型架构,在自然语言处理和其他领域取得了显著成就。其编码器-解码器结构、多头自注意力机制以及位置编码等特性使得模型能够有效地建模长距离依赖和并行计算。然而,Transformers也面临着计算资源要求高、过拟合风险大等挑战。未来,随着技术的不断发展,我们有理由相信Transformers模型将在更多领域发挥重要作用,并为我们带来更多创新和惊喜。

当然,我可以提供一些Python代码示例来演示Transformers模型的一些基本功能。由于直接实现完整的Transformers模型(如BERT或GPT)需要大量的代码和预训练数据,这里我将使用transformers库(由Hugging Face提供)来展示如何使用预训练的模型进行文本分类、文本生成和序列到序列的任务。

1. 文本分类(使用BERT)

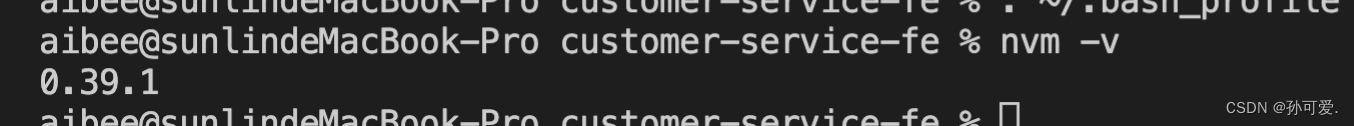

首先,确保安装了transformers和torch库。如果未安装,可以使用pip安装:

pip install transformers torch

以下是使用BERT模型进行情感分析(文本分类)的示例代码:

from transformers import BertTokenizer, BertForSequenceClassification, pipeline

# 加载预训练的模型和分词器

model_name = 'bert-base-uncased'

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertForSequenceClassification.from_pretrained(model_name, num_labels=2) # 假设是二分类问题

# 使用pipeline简化流程

classifier = pipeline("sentiment-analysis", model=model, tokenizer=tokenizer)

# 文本分类

text = "I love this movie!"

result = classifier(text)

print(result)

2. 文本生成(使用GPT-2)

同样,首先确保安装了必要的库。以下是使用GPT-2模型进行文本生成的示例代码:

from transformers import GPT2Tokenizer, GPT2LMHeadModel, pipeline

# 加载预训练的模型和分词器

model_name = 'gpt2'

tokenizer = GPT2Tokenizer.from_pretrained(model_name)

model = GPT2LMHeadModel.from_pretrained(model_name)

# 使用pipeline简化流程

generator = pipeline("text-generation", model=model, tokenizer=tokenizer)

# 文本生成

prompt = "In a world where"

generated_text = generator(prompt, max_length=50, num_beams=5)

print(generated_text[0]['generated_text'])

3. 序列到序列任务(使用T5)

T5是一个通用的文本到文本模型,可以用于多种NLP任务。以下是使用T5进行文本摘要的示例代码:

from transformers import T5Tokenizer, T5ForConditionalGeneration, pipeline

# 加载预训练的模型和分词器

model_name = 't5-small'

tokenizer = T5Tokenizer.from_pretrained(model_name)

model = T5ForConditionalGeneration.from_pretrained(model_name)

# 使用pipeline简化流程,注意T5的文本摘要任务需要特定的prefix

summarizer = pipeline("summarization", model=model, tokenizer=tokenizer)

# 文本摘要

long_text = "Here is a very long text that needs to be summarized..."

# 注意:T5的pipeline可能不需要显式指定prefix,但了解这一点对自定义任务很重要

# 如果需要,可以通过`prefix`参数设置,例如:summarizer(long_text, prefix="summarize: ")

summary = summarizer(long_text, max_length=130, min_length=30, do_sample=False)

print(summary[0]['summary_text'])

请注意,上述代码示例中的model_name可以根据需要替换为其他预训练模型的名称。此外,由于这些示例使用了预训练的模型,因此不需要额外的训练过程即可直接使用。不过,对于自定义任务或数据集,您可能需要进行微调(fine-tuning)以获得更好的性能。