环境准备

操作系统:Ubuntu 22.04.5 LTS

Anaconda3:Miniconda3-latest-Linux-x86_64

GPU: NVIDIA GeForce RTX 4090 24G

Step 1. 准备conda环境

创建一个新的conda环境:

conda create --name llama_factory python=3.11

激活刚刚创建的conda环境:

conda activate llama_factory

Step 2. 下载LLaMA-Factory的项目文件

下载LLama_Factory源码:

git clone https://github.com/hiyouga/LLaMA-Factory.git

Step 3. 升级pip版本

建议在执行项目的依赖安装之前升级 pip 的版本,如果使用的是旧版本的 pip,可能无法安装一些最新的包,或者可能无法正确解析依赖关系。升级 pip 很简单,只需要运行命令如下命令:

python -m pip install --upgrade pip

Step 4. 使用pip安装LLaMA-Factory项目代码运行的项目依赖

pip install -r requirements.txt --index-url https://mirrors.huaweicloud.com/repository/pypi/simple

Step 5. Llama3模型下载

在~/ai-test/创建如下目录:

mkdir model

存放模型文件

cd model

可以从下面地址中下载模型文件,这里我们从ModelScope来下载

huggingface Llama3模型主页:

https://huggingface.co/meta-llama/

Github主页:

https://github.com/meta-llama/llama3/tree/main

ModelScope Llama3-8b模型主页:

https://www.modelscope.cn/models/LLM-Research/Meta-Llama-3-8B-Instruct/summary

git clone https://www.modelscope.cn/LLM-Research/Meta-Llama-3-8B-Instruct.git

Step 6. 运行原始模型

切换到LLama_Factory目录下

cd ~/ai-test/LLaMA-Factory

CUDA_VISIBLE_DEVICES=0 python src/web_demo.py \

--model_name_or_path /home/oneview/ai-test/model/Meta-Llama-3-8B-Instruct \

--template llama3 \

--infer_backend vllm \

--vllm_enforce_eager

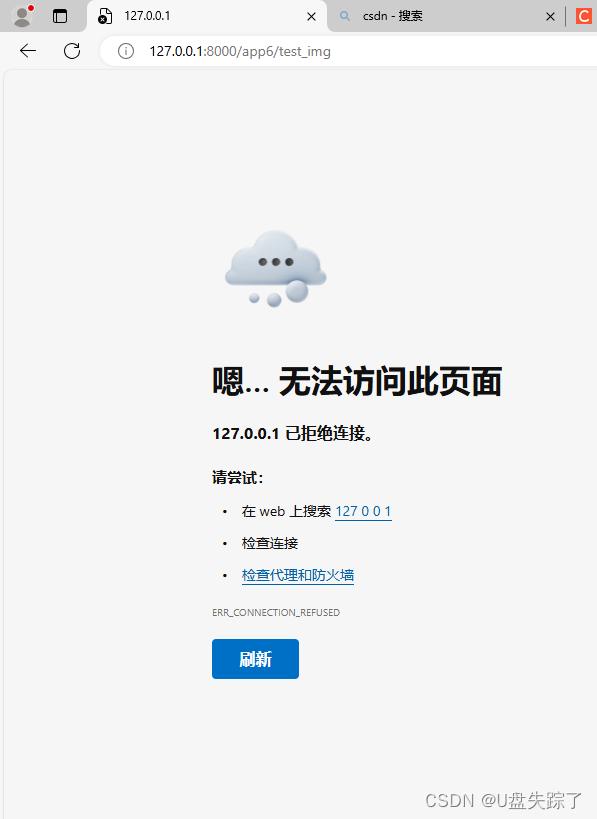

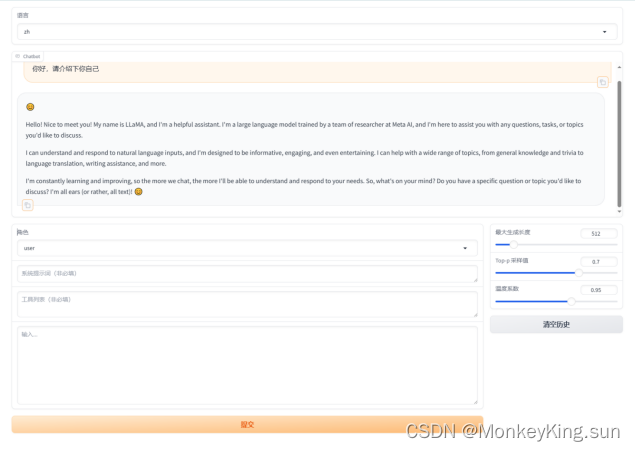

访问http://127.0.0.1:8000输入“你好,请介绍下你自己”,可以发现模型还不具备中文处理能力,后面我们将用中文数据集对模型进行微调。

通过上述步骤就已经完成了LLaMA-Factory模型的完整私有化部署过程。

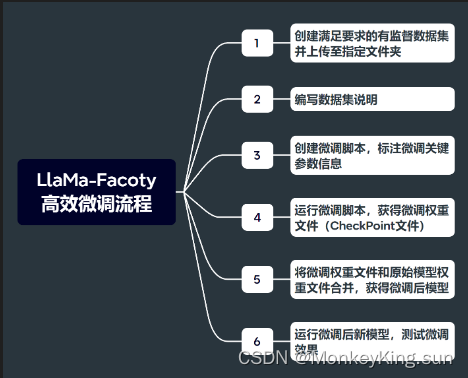

接下来是微调的步骤

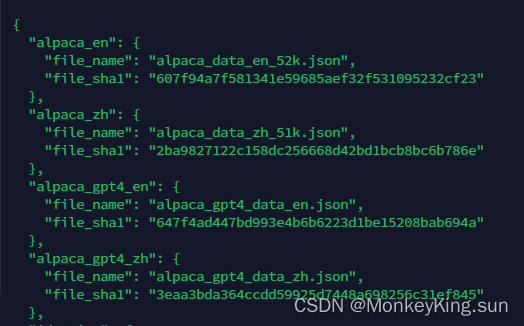

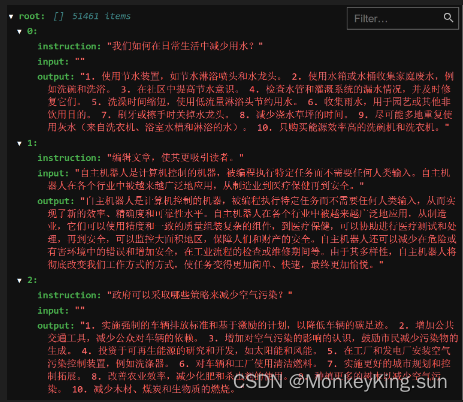

Step 1. 查看微调中文数据集数据字典

我们找到./LLaMA-Factory目录下的data文件夹:

查看dataset_info.json:

找到当前数据集名称:alpaca_zh。数据集情况如下:

Step 2. 创建微调脚本

切换到./LLaMA-Factory目录,创建一个名为single_lora_llama3.sh的脚本(脚本的名字可以自由命名)。

#!/bin/bash

export CUDA_DEVICE_MAX_CONNECTIONS=1

export NCCL_P2P_DISABLE="1"

export NCCL_IB_DISABLE="1"

# 如果是预训练,添加参数 --stage pt \

# 如果是指令监督微调,添加参数 --stage sft \

# 如果是奖励模型训练,添加参数 --stage rm \

# 添加 --quantization_bit 4 就是4bit量化的QLoRA微调,不添加此参数就是LoRA微调 \

CUDA_VISIBLE_DEVICES=0 python src/train_bash.py \ ## 单卡运行

--stage sft \ ## --stage pt (预训练模式) --stage sft(指令监督模式)

--do_train True \ ## 执行训练模型

--model_name_or_path /home/oneview/ai-test/model/Meta-Llama-3-8B-Instruct \ ## 模型的存储路径

--dataset alpaca_zh \ ## 训练数据的存储路径,存放在 LLaMA-Factory/data路径下

--template llama3 \ ## 选择Qwen模版

--lora_target q_proj,v_proj \ ## 默认模块应作为

--output_dir /home/oneview/ai-test/Llama3/output \ ## 微调后的模型保存路径

--overwrite_cache \ ## 是否忽略并覆盖已存在的缓存数据

--per_device_train_batch_size 2 \ ## 用于训练的批处理大小。可根据 GPU 显存大小自行设置。

--gradient_accumulation_steps 64 \ ## 梯度累加次数

--lr_scheduler_type cosine \ ## 指定学习率调度器的类型

--logging_steps 5 \ ## 指定了每隔多少训练步骤记录一次日志。这包括损失、学习率以及其他重要的训练指标,有助于监控训练过程。

--save_steps 100 \ ## 每隔多少训练步骤保存一次模型。这是模型保存和检查点创建的频率,允许你在训练过程中定期保存模型的状态

--learning_rate 5e-5 \ ## 学习率

--num_train_epochs 1.0 \ ## 指定了训练过程将遍历整个数据集的次数。一个epoch表示模型已经看过一次所有的训练数据。

--finetuning_type lora \ ## 参数指定了微调的类型,lora代表使用LoRA(Low-Rank Adaptation)技术进行微调。

--fp16 \ ## 开启半精度浮点数训练

--lora_rank 4 \ ## 在使用LoRA微调时设置LoRA适应层的秩。

注:实际脚本文件最好不要出现中文备注,否则容易出现编辑格式导致的问题。

然后为了保险起见,我们需要对齐格式内容进行调整,以满足Ubuntu操作系统运行需要(此前是从Windows系统上复制过去的文件,一般都需要进行如此操作):

sed -i 's/\r$//' ./single_lora_llama3.sh

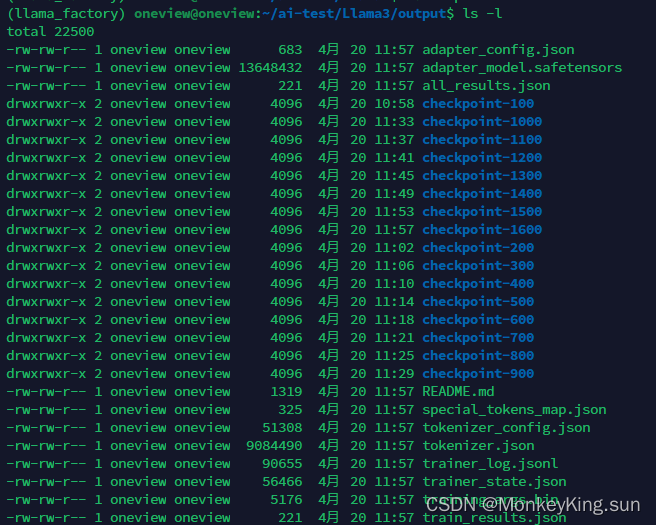

Step 3. 运行微调脚本,获取模型微调权重

当我们准备好微调脚本之后,接下来即可围绕当前模型进行微调了。这里我们直接在命令行中执行sh文件即可,注意运行前需要为该文件增加权限:

chmod +x ./single_lora_llama3.sh

./single_lora_llama3.sh

当微调结束之后,我们就可以在当前主目录下看到新的模型权重文件:

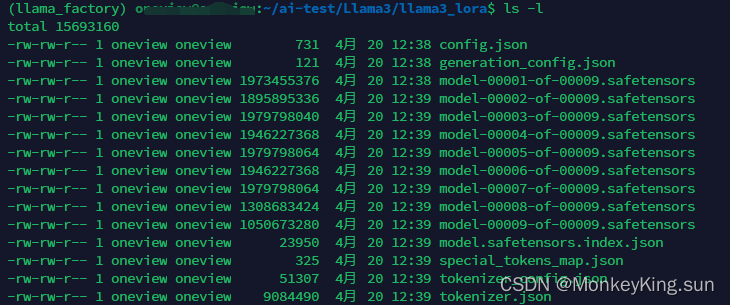

Step 4. 合并模型权重,获得微调模型

接下来我们需要将该模型权重文件和此前的原始模型权重文件进行合并,才能获得最终的微调模型。LlaMa-Factory中已经为我们提供了非常完整的模型合并方法,同样,我们只需要编写脚本文件来执行合并操作即可,即llama3_merge_model.sh。同样,该脚本文件也可以按照此前single_lora_llama3.sh脚本相类似的操作,就是将课件中提供的脚本直接上传到Jupyter主目录下,再复制到LlaMa-Factory主目录下进行运行。

首先简单查看llama3_merge_model.sh脚本文件内容:

#!/bin/bash

python src/export_model.py \ ## 用于执行合并功能的Python代码文件

--model_name_or_path /home/oneview/ai-test/model/Meta-Llama-3-8B-Instruct \ ## 原始模型文件

--adapter_name_or_path /home/oneview/ai-test/Llama3/output \ ## 微调模型权重文件

--template llama3 \ ## 模型模板名称

--finetuning_type lora \ ## 微调框架名称

--export_dir /home/oneview/ai-test/Llama3/output_lora \ ## 合并后新模型文件位置

--export_size 2 \

--export_legacy_format false

注:实际脚本文件最好不要出现中文备注,否则容易出现编辑格式导致的问题。

然后运行脚本,进行模型合并:

./llama3_merge_model.sh

接下来即可查看刚刚获得的新的微调模型:

Step 5. 测试微调效果

切换到LLama_Factory目录下

cd ~/ai-test/LLaMA-Factory

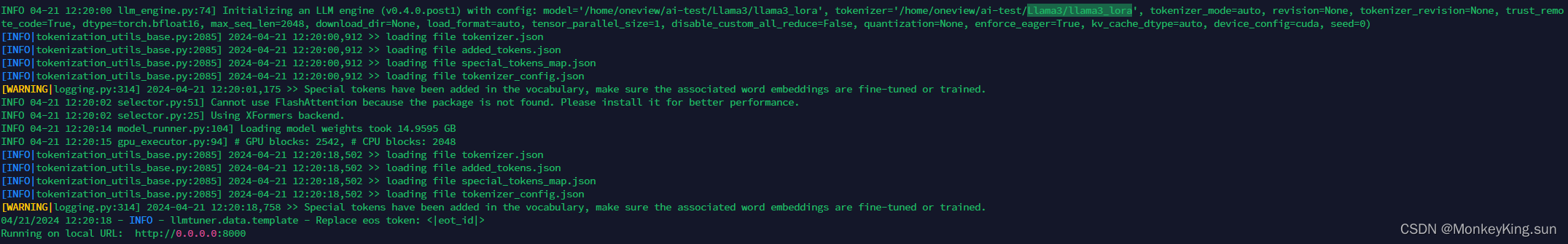

CUDA_VISIBLE_DEVICES=0 python src/web_demo.py \

--model_name_or_path /home/oneview/ai-test/Llama3/llama3_lora \

--template llama3 \

--infer_backend vllm \

--vllm_enforce_eager

运行如下:端口可能有所不同

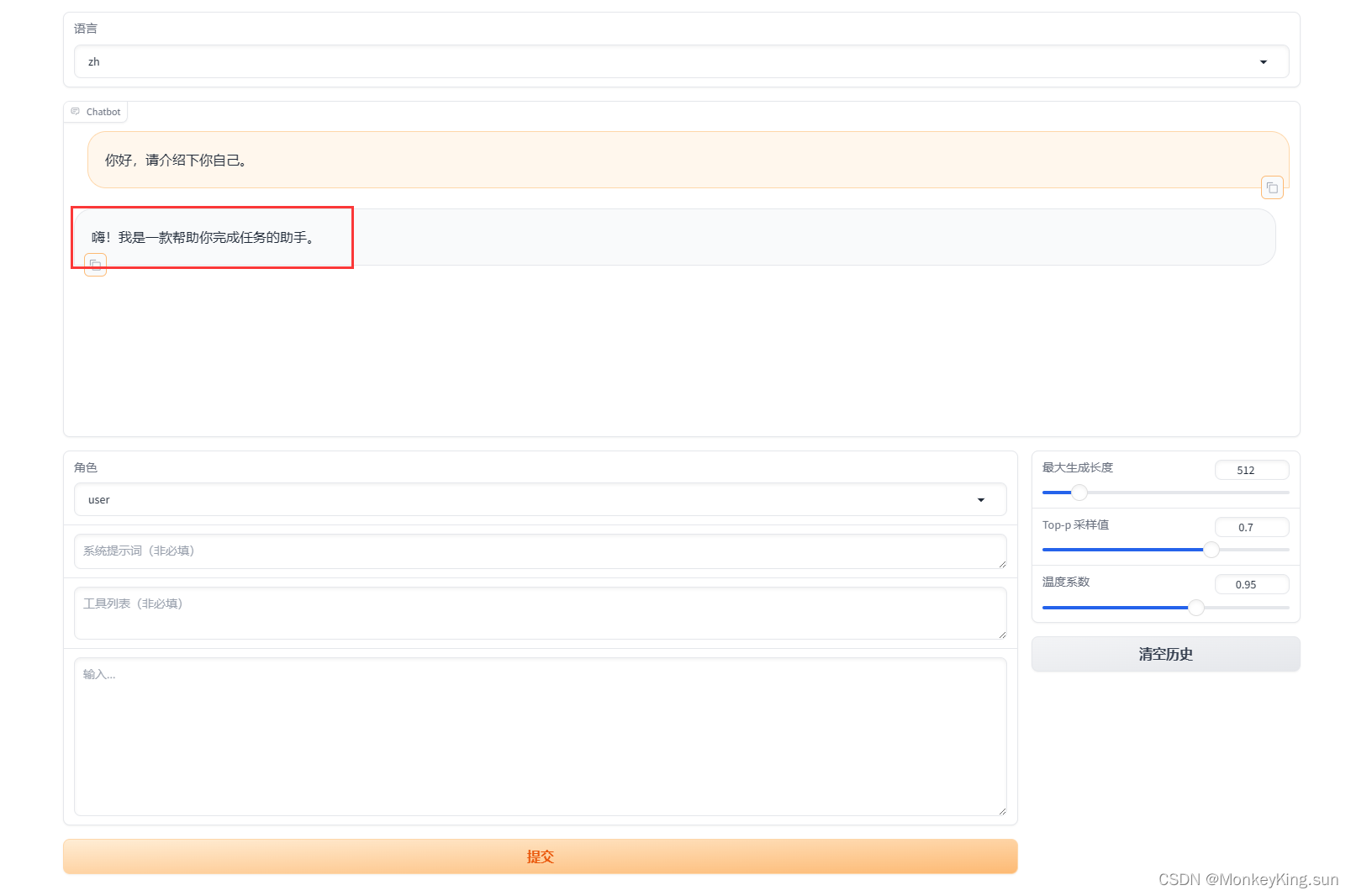

访问http://127.0.0.1:8000

可以看到,现在的回答已经是中文

原文博客地址:https://www.cnblogs.com/hlgnet/articles/18148788