大模型技术论文不断,每个月总会新增上千篇。本专栏精选论文重点解读,主题还是围绕着行业实践和工程量产。若在某个环节出现卡点,可以回到大模型必备腔调重新阅读。而最新科技(Mamba,xLSTM,KAN)则提供了大模型领域最新技术跟踪。若对于如果构建生成级别的AI架构则可以关注AI架构设计专栏。技术宅麻烦死磕LLM背后的基础模型。

Gemma 2与Gemma 1有许多相似之处。它的上下文长度为 8192个令牌,并使用旋转位置嵌入 (RoPE)。与原始 Gemma 相比,Gemma 2有四个主要进步:

-

滑动窗口注意力机制<链接温习>:交错滑动窗口和全二元注意机制。

-

Logit 软盖帽:通过将 logit缩放到固定范围来防止logit 过度增长,从而改进训练。

-

知识蒸馏:利用较大的教师模型来训练较小的模型(9B模型)。

-

模型合并:将两个或多个LLMs合并为一个新模型

滑动窗口注意力是一种减少transformer模型中注意力计算的内存和时间要求的方法,已用于 Mistral 等模型。Gemma 2的新颖之处在于,每隔一层(本地4096 个令牌)都会应用一个滑动窗口,而中间的层仍然使用传统的注意力机制(8192 个令牌)。

软盖帽是一种技术,可以防止logits变得过大而不会截断它们。它的工作原理是:logits ← soft_cap ∗ tanh(logits/soft_cap),其中tanh为激活函数。Gemma 2对最后一层和每个注意力层都采用这项技术。cap上限为50.0,最终logits上限为30.0。

模型合并是一种将两个或多个LLMs模型组合成一个新模型的技术,可以在没有加速器的情况下使用。Mergekit是一个流行的LLM开源合并工具包。它实现了线性、SLERP、TIES、DARE和其他合并技术。Gemma 2 使用了Warp,可在三个不同的阶段合并模型。

|

|

|

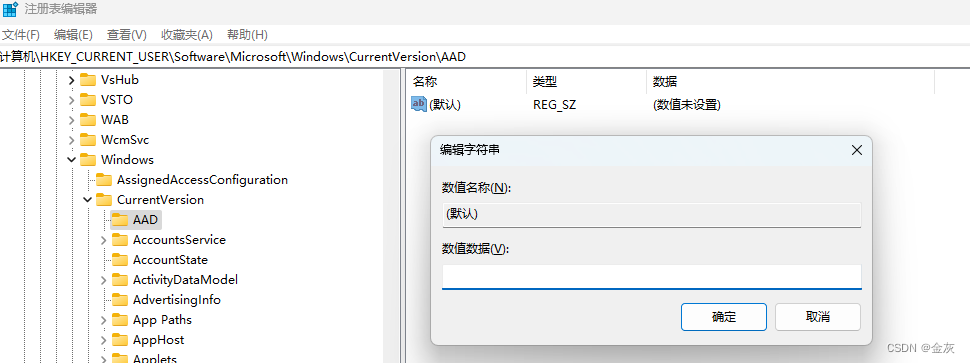

Gemma2的控制Token

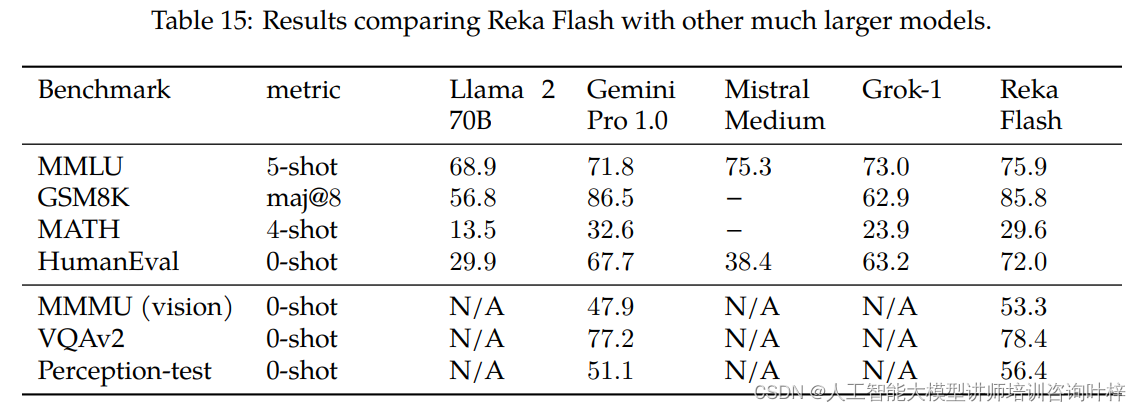

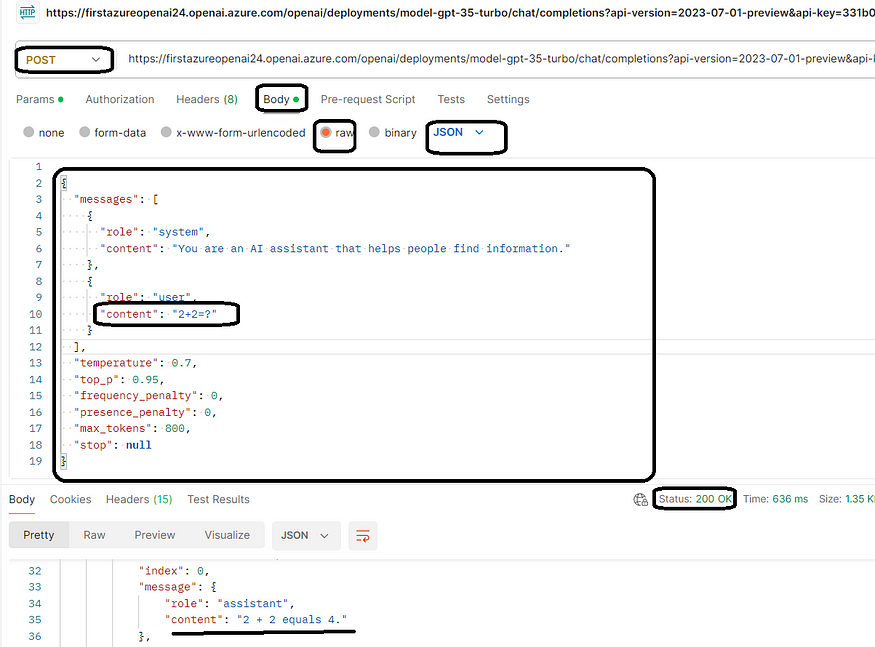

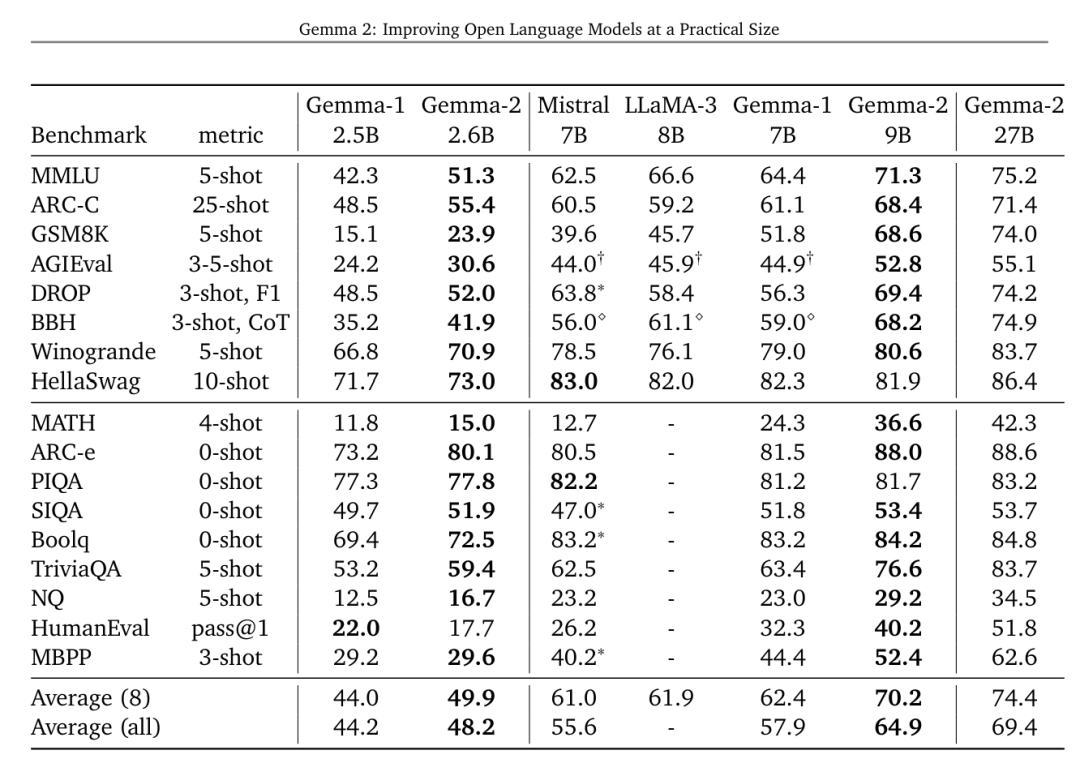

最终在各项基准的评测性能如下,还是具备一定的优势:

Gemma 2使用JAX和ML Pathways在 Google Cloud TPU(v5p 上为 27B,TPU v4 上为 9B)上进行训练。Gemma 2 Instruct已针对对话应用程序进行了优化,并使用监督微调 (SFT)、从更大模型中蒸馏、使用人类反馈强化学习 (RLHF) 以及使用 WARP进行模型合并以提高整体性能。