摘要

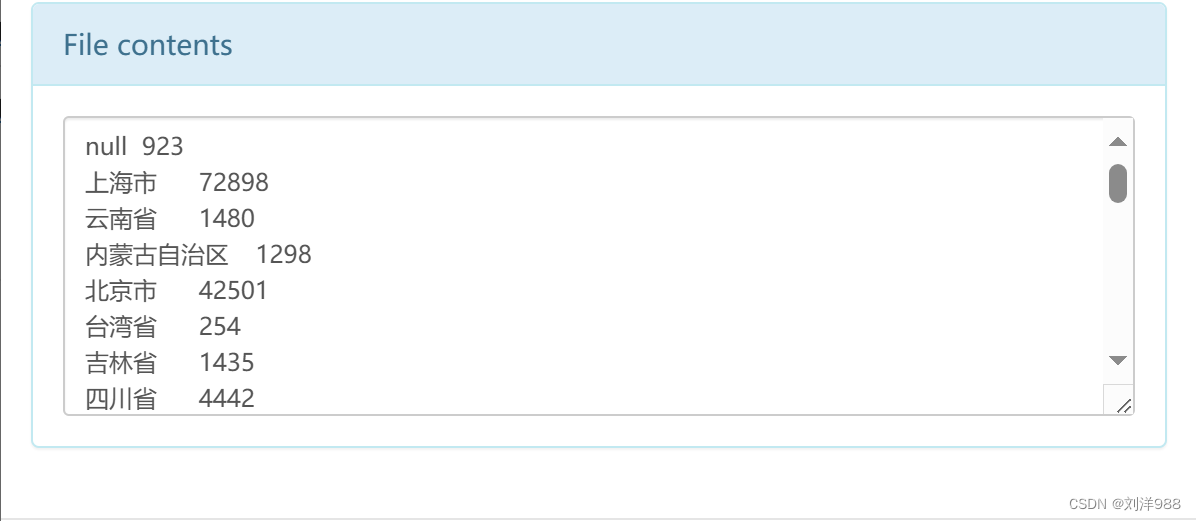

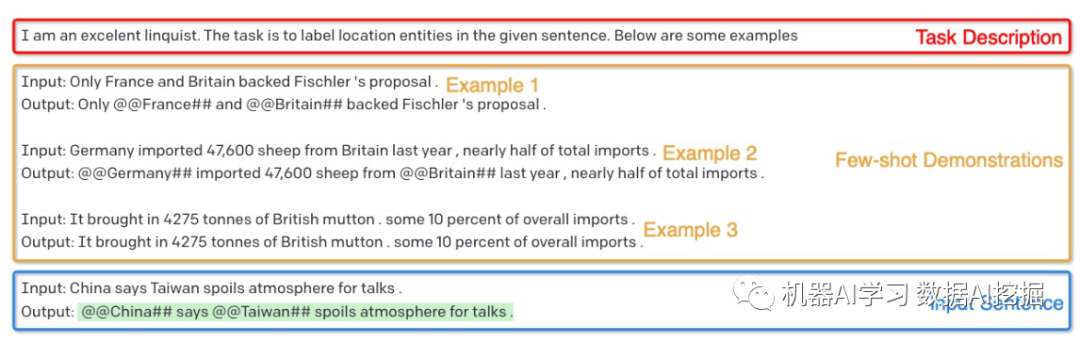

尽管大规模语言模型 (LLM) 在各种 NLP 任务上已经取得了 SOTA 性能,但它在 NER 上的性能仍然明显低于监督基线。这是由于 NER 和 LLMs 这两个任务之间的差距:前者本质上是序列标记任务,而后者是文本生成模型。在本文中,我们提出 GPT-NER 来解决这个问题。GPT-NER 通过将序列标记任务转换为 LLM 可以轻松适应的生成任务来弥合差距,例如,在输入文本“Columbus is a city”中查找位置实体的任务转换为生成文本序列“@” @Columbus## is a city",其中特殊标记@@## 标记要提取的实体。为了有效解决LLMs的“幻觉”问题,在 LLM 强烈倾向于过度自信地将 NULL 输入标记为实体的情况下,我们提出了一种自我验证策略,提示 LLM 问自己提取的实体是否属于标记的实体标签。我们在五个广泛采用的 NER 数据集上进行了实验,GPT-NER 实现了与完全监督的基线相当的性能,这对我们来说是第一次。更重要的是,我们发现 GPT-NER 在低资源和少样本设置中表现出更强的能力,当训练数据量极其稀缺时,GPT-NER 的表现明显优于监督模型。这展示了 GPT-NER 在标记示例数量有限的真实 NER 应用程序中的能力。我们通过提示 LLM 询问自己提取的实体是否属于标记的实体标签来提出自我验证策略。我们在五个广泛采用的 NER 数据集上进行了实验,GPT-NER 实现了与完全监督的基线相当的性能,这对我们来说是第一次。更重要的是,我们发现 GPT-NER 在低资源和少样本设置中表现出更强的能力,当训练数据量极其稀缺时,GPT-NER 的表现明显优于监督模型。这展示了 GPT-NER 在标记示例数量有限的真实 NER 应用程序中的能力。我们通过提示 LLM 询问自己提取的实体是否属于标记的实体标签来提出自我验证策略。我们在五个广泛采用的 NER 数据集上进行了实验,GPT-NER 实现了与完全监督的基线相当的性能,这对我们来说是第一次。更重要的是,我们发现 GPT-NER 在低资源和少样本设置中表现出更强的能力,当训练数据量极其稀缺时,GPT-NER 的表现明显优于监督模型。这展示了 GPT-NER 在标记示例数量有限的真实 NER 应用程序中的能力。GPT-NER 实现了与完全监督的基线相当的性能,这对我们来说是第一次。更重要的是,我们发现 GPT-NER 在低资源和少样本设置中表现出更强的能力,当训练数据量极其稀缺时,GPT-NER 的表现明显优于监督模型。这展示了 GPT-NER 在标记示例数量有限的真实 NER 应用程序中的能力。GPT-NER 实现了与完全监督的基线相当的性能,这对我们来说是第一次。更重要的是,我们发现 GPT-NER 在低资源和少样本设置中表现出更强的能力,当训练数据量极其稀缺时,GPT-NER 的表现明显优于监督模型。这展示了 GPT-NER 在标记示例数量有限的真实 NER 应用程序中的能力。

论文原文连接

https://arxiv.org/pdf/2304.10428.pdf

结论

本文提出GPT-NER以使LLM适应NER任务。作者设计一种prompt来提示LLM生成实体标记,此外在演示部分设计了KNN和token嵌入来帮助LLM更好生成输出,并且作者提出一种自我验证策略来缓解LLM的幻觉问题。最后模型性能和基线相当,并且在低资源场景有显著的优势。

阅读总结

一篇2023年4月26日才挂上arxiv的文章,是我看到的第一篇用LLM解决NER任务的文章,文中的方法很有创意,通过设计prompt激发大模型生成预期序列的能力着实让我感叹LLM的无限潜力,并且这只是在GPT-3就能达到baseline的效果,如果换成现在的GPT-4,那结果不敢想,在我看来,LLM才是NER任务的最优解,如此复杂的序列标注问题,果然还是需要魔法打败魔法,之前所看到的对比学习方法、元学习方法等,在LLM面前可能真的不堪一击,当然我还会继续调研的。