内容介绍:神经网络模型是由神经网络层和Tensor操作构成的,mindspore.nn提供了常见神经网络层的实现,在MindSpore中,Cell类是构建所有网络的基类,也是网络的基本单元。一个神经网络模型表示为一个`Cell`,它由不同的子`Cell`构成。使用这样的嵌套结构,可以简单地使用面向对象编程的思维,对神经网络结构进行构建和管理。

具体内容:

1. 导包

import mindspore

from mindspore import nn, ops2. 定义模型类

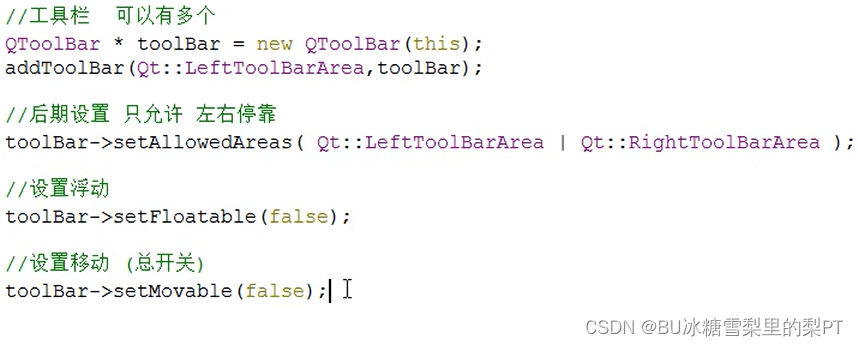

当我们定义神经网络时,可以继承`nn.Cell`类,在`__init__`方法中进行子Cell的实例化和状态管理,在`construct`方法中实现Tensor操作。

class Network(nn.Cell):

def __init__(self):

super().__init__()

self.flatten = nn.Flatten()

self.dense_relu_sequential = nn.SequentialCell(

nn.Dense(28*28, 512, weight_init="normal", bias_init="zeros"),

nn.ReLU(),

nn.Dense(512, 512, weight_init="normal", bias_init="zeros"),

nn.ReLU(),

nn.Dense(512, 10, weight_init="normal", bias_init="zeros")

)

def construct(self, x):

x = self.flatten(x)

logits = self.dense_relu_sequential(x)

return logitsmodel = Network()

print(model)X = ops.ones((1, 28, 28), mindspore.float32)

logits = model(X)

# print logits

logitspred_probab = nn.Softmax(axis=1)(logits)

y_pred = pred_probab.argmax(1)

print(f"Predicted class: {y_pred}")3. 模型层

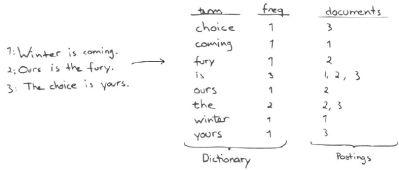

我们构造一个shape为(3, 28, 28)的随机数据(3个28x28的图像),依次通过每一个神经网络层来观察其效果。

input_image = ops.ones((3, 28, 28), mindspore.float32)

print(input_image.shape)4. nn.Flatten

将28x28的2D张量转换为784大小的连续数组。

flatten = nn.Flatten()

flat_image = flatten(input_image)

print(flat_image.shape)5. nn.Dense

全连接层,其使用权重和偏差对输入进行线性变换。

layer1 = nn.Dense(in_channels=28*28, out_channels=20)

hidden1 = layer1(flat_image)

print(hidden1.shape)6. nn.ReLU

给网络中加入非线性的激活函数,帮助神经网络学习各种复杂的特征。

print(f"Before ReLU: {hidden1}\n\n")

hidden1 = nn.ReLU()(hidden1)

print(f"After ReLU: {hidden1}")7. nn.SequentialCell

nn.SequentialCell一个有序的Cell容器。输入Tensor将按照定义的顺序通过所有Cell。我们可以使用`SequentialCell`来快速组合构造一个神经网络模型。

seq_modules = nn.SequentialCell(

flatten,

layer1,

nn.ReLU(),

nn.Dense(20, 10)

)

logits = seq_modules(input_image)

print(logits.shape)8. nn.Softmax

nn.Softmax将神经网络最后一个全连接层返回的logits的值缩放为[0, 1],表示每个类别的预测概率。`axis`指定的维度数值和为1。

softmax = nn.Softmax(axis=1)

pred_probab = softmax(logits)9. 模型参数

网络内部神经网络层具有权重参数和偏置参数(如`nn.Dense`),这些参数会在训练过程中不断进行优化,可通过 `model.parameters_and_names()` 来获取参数名及对应的参数详情。

print(f"Model structure: {model}\n\n")

for name, param in model.parameters_and_names():

print(f"Layer: {name}\nSize: {param.shape}\nValues : {param[:2]} \n")MindSpore作为华为推出的全场景深度学习框架,不仅为我提供了丰富的工具和库来构建复杂的神经网络模型,还以其高效的执行效率和灵活的扩展性,让我对深度学习有了更深的理解。

MindSpore还提供了丰富的预训练模型和算子库,这些资源不仅减少了我在开发过程中的重复工作,还为我提供了学习和借鉴的宝贵机会。通过分析和研究这些预训练模型,我能够更深入地理解神经网络的设计思想和优化策略,从而提升自己的模型设计能力。

![[数据概念]梅宏院士-数据要素化怎么办十问](https://img-blog.csdnimg.cn/img_convert/c8328940b0e10622baa4e51cc76de26f.jpeg)