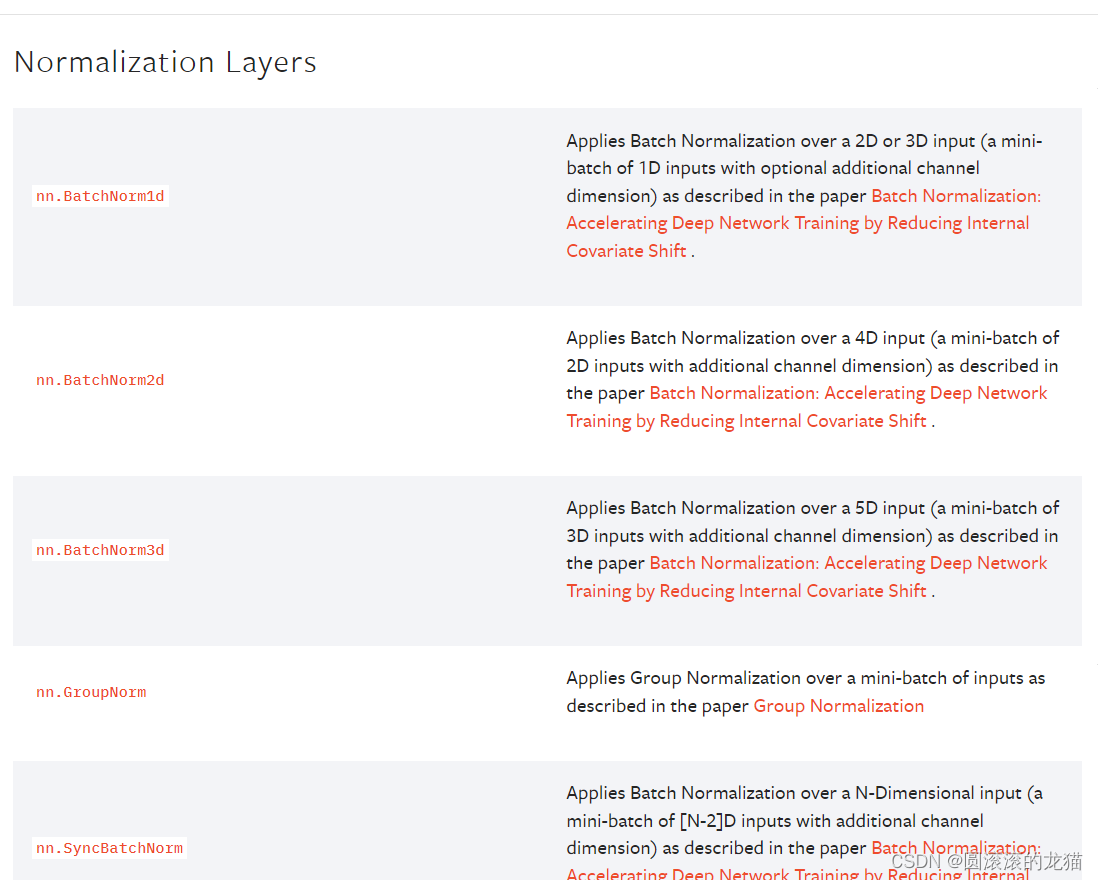

归一化用的较少

正则化用来解决过拟合,处理最优化问题,批量归一化加快速度

正则化(Regularization):

作用:正则化是一种用来防止过拟合的技术,通过向模型的损失函数中添加惩罚项,使得模型在学习过程中更加平滑,避免对训练数据过度拟合。

归一化(Normalization):

作用:归一化是一种数据预处理技术,用来缩放特征值的范围,使得不同特征之间具有可比性,加速模型的收敛过程,提高模型的性能。

线性层是神经网络中的基本构建模块,特别是在深度学习中。它们也被称为全连接层或密集层

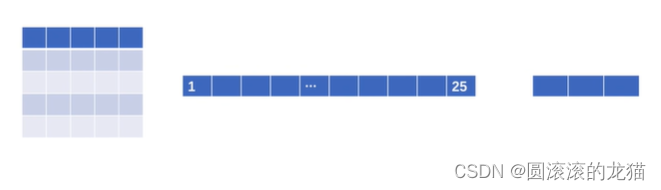

例题:将一个5*5的图片转变为25的,在转变为3的,特征提取

nn.Linear(in_features, out_features) 表示一个线性层,其中参数的含义如下:

in_features: 这是输入特征的数量,即线性层接收的每个输入样本的大小。

out_features: 这是输出特征的数量,即线性层生成的每个输出样本的大小。

import torch

import torchvision

from torch import nn

from torch.nn import ReLU, Sigmoid, Linear

from torch.utils.data import DataLoader

from torch.utils.tensorboard import SummaryWriter

data_transform=torchvision.transforms.Compose(

[torchvision.transforms.ToTensor()]

)

test_data=torchvision.datasets.CIFAR10('./dataset',train=False,transform=data_transform,download=True)

dataloader=DataLoader(dataset=test_data,batch_size=64,drop_last=True)

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.linear1=Linear(196608,10)

def forward(self,input):

output=self.linear1(input)

return output

tudui=Tudui()

for data in dataloader:

imgs,targets=data

print(imgs.shape)

#output=torch.reshape(imgs,(1,1,1,-1))#前面1,1,1是你想要的,后面我们不知道这个值是多少,取-1让Python自己计算

output=torch.flatten(imgs)

print(output.shape)

output=tudui(output)

print(output.shape)

注意一下dataloader最后drop_last不加会在处理最后一批图片时出现报错