💪 专业从事且热爱图像处理,图像处理专栏更新如下👇:

📝《图像去噪》

📝《超分辨率重建》

📝《语义分割》

📝《风格迁移》

📝《目标检测》

📝《暗光增强》

📝《模型优化》

📝《模型实战部署》

😊总结不易,多多支持呀🌹感谢您的点赞👍收藏⭐评论✍️,您的三连是我持续更新的动力💖

目录

- 一、学习率大小问题

- 1.1 学习率太大问题

- 1.2 学习率太小问题

- 二、设置合适的学习率

- 2.1 学习率预热和逐步衰减

- 2.2 使用学习率调度器

- 2.2.1 StepLR

- 2.2.2 MultiStepLR

- 2.2.3 ExponentialLR

- 2.2.4 CosineAnnealingLR

- 2.2.5 ReduceLROnPlateau

- 2.2.6 CyclicLR

- 2.2.7 OneCycleLR

- 2.2.8 CosineAnnealingWarmRestarts

- 2.2.9 LambdaLR

- 2.2.10 PolynomialLR

- 2.2.11 代码

- 2.3 使用自适应学习率优化器

- 2.4 学习率查找器

- 2.5 经验和试验

- 2.6 逐层调节学习率

- 三、梯度裁剪

- 四、总结

一、学习率大小问题

1.1 学习率太大问题

在深度学习训练过程中,如果设置的学习率过大,会导致以下几个问题:

训练过程不稳定

过大的学习率会导致权重更新幅度过大,使得损失函数的值在每次迭代中剧烈波动。模型的参数可能不断在损失函数的不同区域之间跳跃,导致训练过程不稳定,甚至可能出现发散的情况。

无法收敛

由于每次更新的步伐太大,模型可能永远无法到达或接近全局最优点或局部最优点。损失函数的值不会稳定在一个较低的范围内,模型的性能无法提高,训练也无法收敛。

梯度爆炸

在使用较大学习率时,可能会导致梯度爆炸的问题。梯度值会变得非常大,导致参数更新变得极其巨大。这不仅使得训练变得极其困难,还可能使参数达到极端值,进一步加剧训练的不稳定性。

性能不佳

即使模型勉强收敛,最终得到的模型性能也往往不佳。这是因为参数在损失函数表面上跳跃过大,无法精细调整到最优解附近,导致模型的泛化能力较差,表现不理想。

1.2 学习率太小问题

学习率衰减得太早,可能会导致以下几种情况:

训练过程变得缓慢

当学习率衰减得太早,模型参数更新的步伐变小,导致每次迭代的权重调整幅度减小。这可能会使得模型在全局最优解附近的搜索速度变得非常缓慢,导致训练时间大大增加。

模型可能会停留在局部最优

如果学习率衰减得太早,模型的参数更新步伐变小,可能会使得模型更容易陷入局部最优,而无法跳出这些局部最优去寻找全局最优解。这是因为较小的学习率降低了模型在损失函数表面进行大幅度搜索的能力。

未能充分利用初始高学习率阶段

在训练初期,较高的学习率有助于模型快速收敛,找到一个较优的解。如果学习率过早衰减,模型未能充分利用初始高学习率阶段的快速收敛特性,可能导致模型训练效率降低,甚至不能达到理想的初始收敛效果。

模型训练不充分

在训练的早期阶段,模型的参数还在快速调整过程中。如果此时学习率过早衰减,模型可能还没有充分训练到一个较好的状态,导致最终的模型性能不理想。早期的参数更新需要较大的步伐来适应复杂的损失表面结构,而过早衰减的学习率会限制这种能力。

二、设置合适的学习率

选择和调整合适的学习率是深度学习训练中至关重要的一部分。

2.1 学习率预热和逐步衰减

在训练开始时,使用较低的学习率,然后逐步增加到目标学习率(预热阶段),接着在训练过程中逐步衰减学习率。

具体实现代码见下:

import torch

import torch.nn as nn

import torch.optim as optim

# 假设我们有一个简单的神经网络

model = nn.Sequential(

nn.Linear(10, 50),

nn.ReLU(),

nn.Linear(50, 1)

)

optimizer = optim.SGD(model.parameters(), lr=0.1)

criterion = nn.MSELoss()

# 使用 StepLR 和学习率预热

scheduler = optim.lr_scheduler.StepLR(optimizer, step_size=10, gamma=0.1)

for epoch in range(100):

optimizer.zero_grad()

outputs = model(torch.randn(32, 10))

loss = criterion(outputs, torch.randn(32, 1))

loss.backward()

optimizer.step()

scheduler.step() # 更新学习率

print(f'Epoch {epoch+1}, Loss: {loss.item()}, LR: {scheduler.get_last_lr()[0]}')

2.2 使用学习率调度器

PyTorch 提供了多种学习率调度器,可以在训练过程中根据不同策略调整学习率。Pytorch提供的常用学习率调度器见下,这些调度器的具体使用代码见本小结最后。

2.2.1 StepLR

按照固定步长衰减学习率。

import torch.optim as optim

# StepLR: 每隔 step_size 个 epoch,学习率乘以 gamma

scheduler = optim.lr_scheduler.StepLR(optimizer, step_size=10, gamma=0.1)

2.2.2 MultiStepLR

在预定义的 epoch 列表中进行学习率衰减。

# MultiStepLR: 在 milestones 列表中指定的 epoch,学习率乘以 gamma

scheduler = optim.lr_scheduler.MultiStepLR(optimizer, milestones=[30, 80], gamma=0.1)

2.2.3 ExponentialLR

以指数衰减的方式调整学习率。

# ExponentialLR: 每个 epoch,学习率乘以 gamma

scheduler = optim.lr_scheduler.ExponentialLR(optimizer, gamma=0.9)

2.2.4 CosineAnnealingLR

使用余弦退火方法调整学习率。

# CosineAnnealingLR: 在 T_max 个 epoch 内从初始学习率衰减到 eta_min

scheduler = optim.lr_scheduler.CosineAnnealingLR(optimizer, T_max=50, eta_min=0)

2.2.5 ReduceLROnPlateau

当监控的指标停止改善时,降低学习率。也叫监控验证损失。

# ReduceLROnPlateau: 当指标(如验证损失)不再改善时降低学习率

scheduler = optim.lr_scheduler.ReduceLROnPlateau(optimizer, mode='min', factor=0.1, patience=10, verbose=True)

2.2.6 CyclicLR

在指定的范围内循环调整学习率。

# CyclicLR: 在 base_lr 和 max_lr 之间循环学习率

scheduler = optim.lr_scheduler.CyclicLR(optimizer, base_lr=0.001, max_lr=0.01, step_size_up=2000, mode='triangular')

2.2.7 OneCycleLR

在一个周期内调整学习率,适合于一种特定的学习率调整策略。

# OneCycleLR: 在一个周期内从初始学习率调整到 max_lr 再回到初始学习率

scheduler = optim.lr_scheduler.OneCycleLR(optimizer, max_lr=0.01, steps_per_epoch=len(dataloader), epochs=10)

2.2.8 CosineAnnealingWarmRestarts

使用余弦退火方法,并进行周期性重启。也叫热重启策略。

# CosineAnnealingWarmRestarts: 使用余弦退火并周期性重启

scheduler = optim.lr_scheduler.CosineAnnealingWarmRestarts(optimizer, T_0=10, T_mult=2)

2.2.9 LambdaLR

使用自定义的函数调整学习率。

# LambdaLR: 使用自定义函数调整学习率

lambda1 = lambda epoch: 0.65 ** epoch

scheduler = optim.lr_scheduler.LambdaLR(optimizer, lr_lambda=lambda1)

2.2.10 PolynomialLR

PolynomialLR调度器在 PyTorch 1.12 版本中引入,可以将学习率按多项式递减。

# PolynomialLR: 按多项式递减学习率

scheduler = optim.lr_scheduler.PolynomialLR(optimizer, total_iters=50, power=2.0)

2.2.11 代码

以下是一个使用这些调度器的示例:

import torch

import torch.nn as nn

import torch.optim as optim

# 定义一个简单的模型

model = nn.Sequential(

nn.Linear(10, 50),

nn.ReLU(),

nn.Linear(50, 1)

)

# 使用 SGD 优化器

optimizer = optim.SGD(model.parameters(), lr=0.1)

criterion = nn.MSELoss()

# 选择一个学习率调度器

scheduler = optim.lr_scheduler.StepLR(optimizer, step_size=10, gamma=0.1)

for epoch in range(100):

optimizer.zero_grad()

outputs = model(torch.randn(32, 10))

loss = criterion(outputs, torch.randn(32, 1))

loss.backward()

optimizer.step()

scheduler.step() # 更新学习率

print(f'Epoch {epoch+1}, Loss: {loss.item()}, LR: {scheduler.get_last_lr()[0]}')

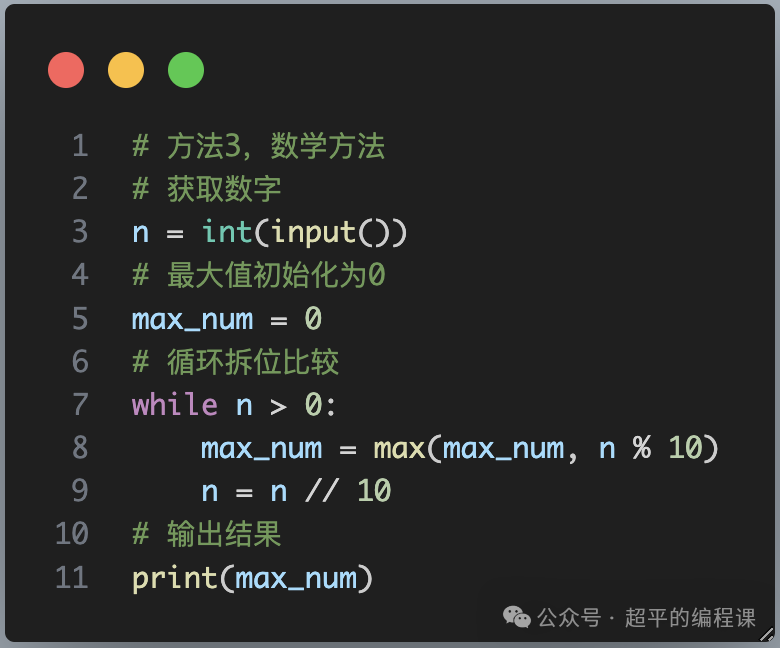

输出见下:

2.3 使用自适应学习率优化器

自适应学习率优化器(如 Adam、RMSprop、Adagrad)能够根据梯度自动调整学习率,避免手动调整的麻烦。

具体实现代码见下:

import torch

import torch.nn as nn

import torch.optim as optim

model = nn.Sequential(

nn.Linear(10, 50),

nn.ReLU(),

nn.Linear(50, 1)

)

# 使用 Adam 优化器

optimizer = optim.Adam(model.parameters(), lr=0.001)

criterion = nn.MSELoss()

for epoch in range(100):

optimizer.zero_grad()

outputs = model(torch.randn(32, 10))

loss = criterion(outputs, torch.randn(32, 1))

loss.backward()

optimizer.step()

print(f'Epoch {epoch+1}, Loss: {loss.item()}, LR: {optimizer.param_groups[0]["lr"]}')

2.4 学习率查找器

使用学习率查找器(如 fastai 提供的 LRFinder),可以通过线性增长学习率来找到一个合适的初始学习率。

from fastai.vision.all import *

# 假设我们有一个数据集和模型

dls = ImageDataLoaders.from_folder(path, valid_pct=0.2, item_tfms=Resize(224))

learn = cnn_learner(dls, resnet34, metrics=error_rate)

# 使用学习率查找器

learn.lr_find()

2.5 经验和试验

根据经验和实验选择合适的学习率,通常可以从一个较大的值(如 0.1)开始,观察损失和准确率的变化。如果模型发散(损失剧增),减小学习率;如果收敛很慢,增加学习率。

2.6 逐层调节学习率

在一些复杂的网络结构中,可以对不同层使用不同的学习率。例如,对较低层使用较低的学习率,对较高层使用较高的学习率。

实例代码见下:

import torch

import torch.nn as nn

import torch.optim as optim

class MyModel(nn.Module):

def __init__(self):

super(MyModel, self).__init__()

self.conv1 = nn.Conv2d(1, 32, 3, 1)

self.conv2 = nn.Conv2d(32, 64, 3, 1)

self.fc1 = nn.Linear(9216, 128)

self.fc2 = nn.Linear(128, 10)

def forward(self, x):

x = self.conv1(x)

x = self.conv2(x)

x = torch.flatten(x, 1)

x = self.fc1(x)

x = self.fc2(x)

return x

model = MyModel()

optimizer = optim.SGD([

{'params': model.conv1.parameters(), 'lr': 0.01},

{'params': model.conv2.parameters(), 'lr': 0.01},

{'params': model.fc1.parameters(), 'lr': 0.1},

{'params': model.fc2.parameters(), 'lr': 0.1}

], lr=0.1)

criterion = nn.CrossEntropyLoss()

for epoch in range(100):

optimizer.zero_grad()

outputs = model(torch.randn(32, 1, 28, 28))

loss = criterion(outputs, torch.randint(0, 10, (32,)))

loss.backward()

optimizer.step()

print(f'Epoch {epoch+1}, Loss: {loss.item()}')

三、梯度裁剪

梯度裁剪可以防止梯度爆炸。通过在每次反向传播后对梯度进行裁剪,确保其不会超过设定的阈值。

实例代码:

for epoch in range(100):

optimizer.zero_grad()

outputs = model(torch.randn(32, 10))

loss = criterion(outputs, torch.randn(32, 1))

loss.backward()

# 梯度裁剪

torch.nn.utils.clip_grad_norm_(model.parameters(), max_norm=1.0)

optimizer.step()

print(f'Epoch {epoch+1}, Loss: {loss.item()}')

四、总结

以上就是深度学习模型训练中学习率参数设置大小问题及设置合适值的分析过程,总结了一部分,欢迎留言补充!

感谢您阅读到最后!😊总结不易,多多支持呀🌹 点赞👍收藏⭐评论✍️,您的三连是我持续更新的动力💖

关注公众号「视觉研坊」,获取干货教程、实战案例、技术解答、行业资讯!